R语言数据分析高级教程:从新手到aov的深入应用指南

发布时间: 2024-11-05 17:21:27 阅读量: 38 订阅数: 23

java计算器源码.zip

# 1. R语言基础知识回顾

## 1.1 R语言简介

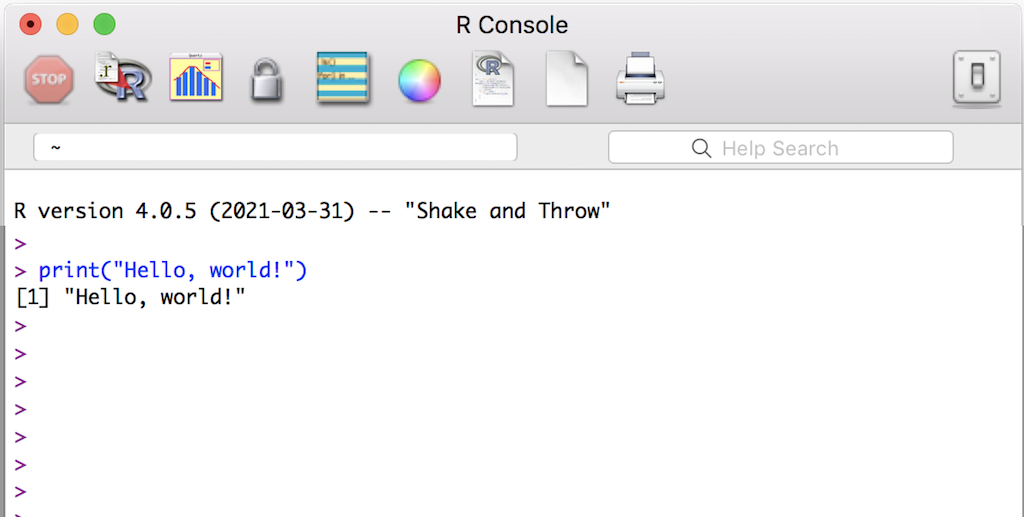

R语言是一种开源编程语言和软件环境,特别为统计计算和图形表示而设计。自1997年由Ross Ihaka和Robert Gentleman开发以来,R已经成为数据科学领域广受欢迎的工具。它支持各种统计技术,包括线性与非线性建模、经典统计测试、时间序列分析、分类、聚类等,并且提供了强大的图形能力。

## 1.2 安装与配置R环境

要开始使用R语言,首先需要在计算机上安装R环境。用户可以访问官方网站下载适用于Windows、Mac OS或Linux系统的R基础包。安装完成后,推荐安装RStudio,这是一个流行的集成开发环境(IDE),为R的使用提供更为便捷的界面和功能。

## 1.3 基本语法与数据类型

R语言的基本语法简单直观,适合初学者快速上手。R语言使用赋值操作符`<-`或`=`来创建对象并存储数据。数据类型主要包括向量、矩阵、数组、数据框(DataFrame)和列表。在处理数据时,常使用函数来完成各种操作,例如`print()`函数用于输出数据,`mean()`用于计算平均值等。理解这些基础知识对于后续深入学习R语言至关重要。

# 2. R语言数据处理进阶技巧

## 2.1 数据清洗与预处理

### 2.1.1 缺失值处理方法

处理缺失值是数据预处理的重要步骤。在R中,我们可以使用多种方法来识别和处理缺失值。首先,使用`is.na()`函数可以识别出数据集中的缺失值位置。然后,根据数据和研究目的选择合适的处理方法。

```r

# 创建一个含有缺失值的数据框

data <- data.frame(

A = c(1, 2, NA, 4),

B = c(5, NA, 7, 8)

)

# 识别缺失值

missing_values <- is.na(data)

print(missing_values)

```

对于缺失值的处理,有以下几种常用方法:

- 删除含有缺失值的行或列

- 用某个特定值(如列的平均值、中位数或众数)填充

- 使用预测模型填充缺失值(如使用`mice`包的多重插补方法)

### 2.1.2 异常值检测与处理

异常值是数据中的离群点,可能会对分析结果产生不良影响。异常值的检测可以通过统计检验(如标准差、四分位距)或者箱线图来实现。处理异常值的方法包括删除、变换或使用鲁棒统计方法。

```r

# 使用箱线图检测异常值

boxplot(data$A, main="Boxplot for Variable A")

```

处理异常值的示例代码如下:

```r

# 删除异常值

data_clean <- data[abs(scale(data)) < 3, ]

# 进行数据变换,例如对数变换减少异常值的影响

data_transformed <- log(data + 1)

```

### 2.1.3 数据类型转换和标准化

数据类型转换是指将数据从一种类型转换为另一种类型,以满足分析需求。例如,日期时间格式的转换、字符型向因子型或数值型的转换等。

```r

# 字符型转因子型

data$C <- as.factor(c("low", "high", "medium", "high"))

# 字符型转数值型

data$D <- as.numeric(as.character(data$C))

```

数据标准化是指将不同量纲的数据转换到同一量纲。常见的方法包括z分数标准化、最小-最大标准化。

```r

# Z分数标准化

data$E <- scale(data$E)

# 最小-最大标准化

data$F <- (data$F - min(data$F)) / (max(data$F) - min(data$F))

```

数据类型转换和标准化是数据预处理过程中的关键步骤,是后续分析和建模的基础。

## 2.2 数据探索性分析

### 2.2.1 描述性统计分析

描述性统计分析是数据探索的起点,用于快速了解数据的中心位置、分布和变异性。常用的描述性统计量包括均值、中位数、标准差等。

```r

# 计算描述性统计量

summary(data)

```

### 2.2.2 数据可视化技术

数据可视化是数据探索的一个重要方面,能够直观展示数据分布和模式。R语言提供了多种可视化工具,如基础图形系统和ggplot2包。

```r

# 使用ggplot2绘图

library(ggplot2)

ggplot(data, aes(x = A, y = B)) + geom_point() + theme_minimal()

```

### 2.2.3 相关性和回归分析

相关性分析用于探究两个或多个变量之间的关联程度。而回归分析则用于确定一个或多个自变量与因变量之间的关系。

```r

# 计算相关系数矩阵

correlation_matrix <- cor(data)

print(correlation_matrix)

# 简单线性回归

model <- lm(B ~ A, data = data)

summary(model)

```

数据探索性分析是理解数据结构和变量之间关系的重要手段,是深入数据分析的基石。

## 2.3 高级数据处理技术

### 2.3.1 使用dplyr包进行数据操作

`dplyr`是R语言中用于数据操作的流行包。它提供了一系列函数来简化数据操作,如`select()`, `filter()`, `mutate()`, `summarise()`等。

```r

# 加载dplyr包

library(dplyr)

# 使用dplyr进行数据操作

result <- data %>%

filter(A > 2) %>%

mutate(C = factor(C)) %>%

summarise(mean_B = mean(B))

print(result)

```

### 2.3.2 时间序列数据处理

时间序列数据的处理包括时间序列的创建、季节性调整、趋势分析等。

```r

# 创建时间序列对象

ts_data <- ts(data$A, frequency = 12, start = c(2020, 1))

# 季节性分解

decomposed_ts <- stl(ts_data, "periodic")

plot(decomposed_ts)

```

### 2.3.3 多变量分析技巧

多变量分析涉及多个变量之间的相互作用和影响。典型的方法包括主成分分析(PCA)、因子分析和多变量方差分析(MANOVA)。

```r

# 主成分分析

pca_result <- prcomp(data, scale. = TRUE)

summary(pca_result)

```

高级数据处理技术使数据分析师可以更深入地理解数据的结构和模式,是数据科学工作中的重要工具。

# 3. R语言统计建模方法

在数据科学的世界里,统计建模是理解和预测现象的重要工具。R语言凭借其强大的统计计算能力,被广泛应用于各种统计建模任务中。本章将详细介绍R语言中线性回归、分类与机器学习算法以及高级统计模型的应用与实现。理解这些内容,将帮助您更加深入地分析数据,并从数据中提取有价值的信息。

## 3.1 线性回归模型

线性回归模型是最基础的统计模型之一,它假设因变量与一个或多个自变量之间存在线性关系。通过线性回归模型,我们可以量化自变量对因变量的影响程度。

### 3.1.1 理解线性回归原理

线性回归模型的一般形式是:

Y = β0 + β1X1 + β2X2 + ... + βnXn + ε

其中,Y是因变量,X1到Xn是自变量,β0是截距项,β1到βn是回归系数,ε是误差项。

### 3.1.2 模型的建立与评估

在R中,我们可以使用`lm()`函数来建立线性回归模型。下面是一个简单的示例:

```R

# 加载数据

data(iris)

# 建立模型,以Sepal.Length为因变量,Sepal.Width为自变量

model <- lm(Sepal.Length ~ Sepal.Width, data=iris)

# 查看模型摘要

summary(model)

```

在模型建立后,我们通常需要对模型进行评估。模型的评估指标包括R平方值(解释的变异百分比)、F统计量、p值等。在上述代码中,`summary()`函数可以帮助我们获得这些评估指标。

### 3.1.3 模型的诊断与优化

模型的诊断是检查模型假设是否合理以及模型是否需要改进的过程。一些基本的诊断方法包括残差分析和影响点检测。

```R

# 残差分析

plot(model$residuals ~ model$fitted.values)

abline(h=0, col="red")

# 影响点检测

cook <- cooks.distance(model)

plot(cook, pch=".")

```

在模型诊断过程中,如果发现模型存在非线性、异方差性或者潜在的影响点等问题,可能需要对模型进行优化。优化手段包括转换变量、增加交互项或多项式项、剔除异常值等。

## 3.2 分类与机器学习算法

分类问题是将观测值分配到离散类别中的问题。在R中,我们可以使用不同的算法来进行分类任务,包括逻辑回归、决策树、随机森林和支持向量机等。

### 3.2.1 逻辑回归与决策树

逻辑回归适用于二分类问题。在R中,`glm()`函数可以用来建立逻辑回归模型。

```R

# 建立逻辑回归模型,以Species为因变量,Sepal.Width和Petal.Width为自变量

logit_model <- glm(Species ~ Sepal.Width + Petal.Width, data=iris, family=binomial)

# 查看模型摘要

summary(logit_model)

```

决策树是一种更为直观的分类方法。在R中,`rpart()`函数是构建决策树的常用工具。

```R

# 安装并加载rpart包

install.packages("rpart")

library(rpart)

# 建立决策树模型

tree_model <- rpart(Species ~ ., data=iris)

# 绘制决策树

plot(tree_model)

text(tree_model)

```

### 3.2.2 随机森林与支持向量机

随机森林是一种集成学习方法,它构建多个决策树并将它们的预测结果进行汇总。在R中,`randomForest()`函数是实现随机森林算法的标准工具。

```R

# 安装并加载randomForest包

install.packages("randomForest")

library(randomForest)

# 建立随机森林模型

rf_model <- randomForest(Species ~ ., data=iris, ntree=100)

# 查看模型评估

rf_model

```

支持向量机(SVM)是一种监督学习模型,适用于分类和回归分析。在R中,`e1071`包提供了支持向量机的实现。

```R

# 安装并加载e1071包

install.packages("e1071")

library(e1071)

# 建立SVM模型

svm_model <- svm(Species ~ ., data=iris)

# 查看模

```

0

0