【PyCharm新手必备】:掌握PyTorch库下载与配置的7个步骤

发布时间: 2024-11-29 08:20:58 阅读量: 7 订阅数: 9

参考资源链接:[Pycharm安装torch失败解决指南:处理WinError 126错误](https://wenku.csdn.net/doc/3g2nwwuq1m?spm=1055.2635.3001.10343)

# 1. PyCharm简介与设置

## PyCharm概述

PyCharm是JetBrains公司开发的一款专业Python集成开发环境(IDE),它提供了代码编辑、代码质量分析、单元测试、调试以及Git集成等众多功能。对于数据科学家、机器学习工程师以及专业Python开发者来说,PyCharm是提升开发效率、保持代码组织结构的利器。

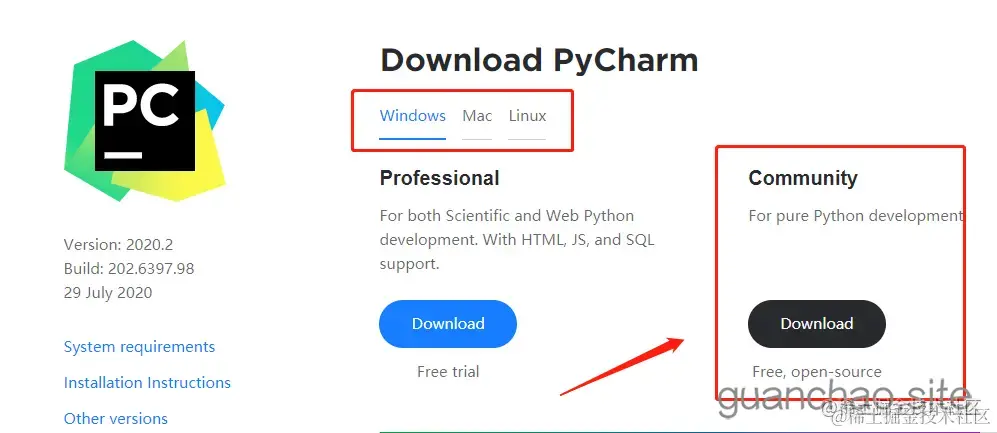

## PyCharm下载与安装

首先,访问JetBrains官方网站下载PyCharm的社区版或专业版。对于一般使用者而言,社区版已经足够使用,而对于企业用户或者需要更多高级功能的开发者来说,专业版提供了更多工具和服务。选择适合自己操作系统的版本下载安装,并遵循安装向导完成安装过程。

## PyCharm初始设置

安装完成后,首次运行PyCharm时,它会引导你完成初始设置。这包括选择主题、创建新项目或打开现有项目以及配置Python解释器。选择适合自己的主题可以增加开发时的舒适度。对于新项目,务必选择正确的Python解释器版本,确保与你的PyTorch库兼容。在设置中,PyCharm还允许用户设置项目解释器,这对后续进行PyTorch开发至关重要。

PyCharm的设置是一个对初学者友好的过程,但对于深度定制和优化,用户需要深入了解每个选项的功能。接下来,我们将介绍如何为深度学习项目,特别是PyTorch项目进行环境设置。

# 2. PyTorch库基础理论

## 2.1 PyTorch核心概念解读

PyTorch是一个开源的机器学习库,广泛应用于计算机视觉、自然语言处理、强化学习等多个领域。它的核心设计理念是动态计算图(Dynamic Computational Graph),与TensorFlow的静态计算图形成鲜明对比。动态图允许开发者更直观地构建模型,并在运行时即时修改图结构,极大提高了灵活性和开发效率。

### 2.1.1 张量与自动微分

在PyTorch中,最基础的数据结构是张量(Tensor),它是一个多维数组,与NumPy的ndarray类似,但是可以在GPU上运行。除了基本的数据存储和转换功能,张量的另一个核心功能是支持自动微分。

自动微分机制在深度学习中至关重要,因为模型训练过程中需要不断进行梯度计算和参数更新。PyTorch通过其autograd包提供了自动微分的功能,使得开发者可以专注于模型的设计,而将梯度计算的复杂性交给库来处理。

### 2.1.2 神经网络模块

神经网络是深度学习的核心。PyTorch提供了nn模块,其中包含构建神经网络所需的所有组件,如层、损失函数和优化器等。nn模块采用了面向对象的设计思想,所有的网络层和组件都是nn.Module的子类。这使得代码更加模块化,易于理解和复用。

### 2.1.3 数据加载与处理

在实际应用中,数据的加载和预处理往往是模型训练前的重要步骤。PyTorch提供了torch.utils.data包,其中包含了数据集(Dataset)和数据加载器(DataLoader)类,这使得批量加载和处理数据变得简单。特别是DataLoader,它支持自动的批处理、乱序、多线程数据加载等功能。

### 2.1.4 并行与分布式计算

随着深度学习模型的规模不断扩大,单机计算能力往往不足以满足需求。PyTorch提供了良好的并行和分布式计算支持。它可以通过torch.nn.DataParallel模块实现GPU并行计算,此外,还支持分布式训练,让模型训练可以跨多个GPU甚至多个机器进行。

## 2.2 PyTorch与深度学习框架比较

### 2.2.1 PyTorch与TensorFlow对比

TensorFlow是由Google开发的深度学习框架,它的静态计算图特性使得模型的构建与运行分离,有利于模型优化和部署。而PyTorch的动态计算图提供了更高的灵活性,让开发者在构建复杂模型时更加得心应手。

### 2.2.2 生态系统与社区支持

尽管TensorFlow在工业界拥有更广泛的应用,PyTorch的生态系统也不断壮大,社区支持活跃,新的研究和模型快速集成。此外,许多研究者更倾向于使用PyTorch,因为它更贴近学术研究的迭代需求。

### 2.2.3 应用场景

PyTorch和TensorFlow各自有其适用的场景。对于需要快速原型设计和研究的场景,PyTorch是非常合适的选择;而对于需要高度优化和部署的生产环境,TensorFlow可能更加合适。不过,随着两个框架都在不断进步,它们之间的界限正在变得模糊。

### 2.2.4 未来展望

随着深度学习技术的不断发展,PyTorch也在不断进化,以满足新的研究和工程需求。社区的快速响应和活跃贡献,使得PyTorch成为深度学习领域的一颗新星。在可预见的未来,PyTorch有望在更多领域得到应用,同时它也会继续保持其灵活性和易用性。

# 3. PyTorch环境搭建

## 3.1 下载PyTorch库

### 3.1.1 选择合适的PyTorch版本

在开始使用PyTorch之前,首先需要确定合适的版本。PyTorch提供了多个版本供选择,包括稳定版、预览版以及为特定硬件优化的版本。正确选择版本是搭建高效稳定环境的关键。

- **稳定版(Stable)**:这是推荐给大多数用户的版本,具有广泛的支持和文档。如果项目没有特定的加速需求,选择稳定版是一个不错的选择。

- **预览版(Preview)**:包含最新的功能和改进,但可能未经过完整测试,存在不稳定的风险。

- **硬件优化版(如CUDA, ROCm)**:针对特定GPU架构做了优化,可以在使用NVIDIA或AMD的GPU时获得最佳性能。

选择合适的版本通常取决于项目需求、系统环境以及是否需要最新的功能。可通过PyTorch官方网站或使用命令行工具来选择对应的版本。

### 3.1.2 下载PyTorch库的过程详解

下载PyTorch库可以通过官方提供的命令行工具`torchvision-cli`,也可以通过Python的包管理工具`pip`,亦或是conda进行安装。下面是详细的下载过程:

#### 使用torchvision-cli下载PyTorch库

1. **安装命令行工具**:

```bash

pip install torchvision-cli

```

2. **搜索可用的PyTorch版本**:

```bash

torch search torch

```

3. **下载指定版本**:

```bash

torch download torch==1.8.0+cu101 -f https://download.pytorch.org/whl/torch_stable.html

```

#### 使用pip下载PyTorch库

1. **搜索Python包**:

```bash

pip search torch

```

2. **安装特定版本**:

```bash

pip install torch==1.8.0+cu101

```

#### 使用conda下载PyTorch库

1. **搜索conda库**:

```bash

conda search pytorch

```

2. **创建并激活环境**(可选):

```bash

conda create -n myenv python=3.8

conda activate myenv

```

3. **安装PyTorch**:

```bash

conda install pytorch==1.8.0 torchvision==0.9.0 cudatoolkit=10.1 -c pytorch -c conda-forge

```

## 3.2 配置PyTorch环境

### 3.2.1 PyTorch的安装与验证

安装PyTorch后,需要验证安装是否成功。这可以通过运行一些基础的PyTorch代码来完成。

```python

import torch

def check_torch_install():

# 创建一个基础的张量

tensor = torch.rand(3, 3)

print(f"基础张量:\n{tensor}\n")

# 打印PyTorch版本

print(f"PyTorch版本: {torch.__version__}")

check_torch_install()

```

该代码段不仅创建了一个随机的3x3张量,还打印了PyTorch版本,用以确认安装成功。运行结果应显示一个张量的打印输出和当前安装的PyTorch版本。

### 3.2.2 环境变量的配置与检查

配置环境变量是为了确保系统能够正确识别PyTorch的安装路径和相关依赖。

1. **临时设置环境变量**(仅对当前终端有效):

```bash

export PATH=/path/to/pytorch/bin:$PATH

```

2. **永久设置环境变量**(对所有终端会话有效,以bash为例):

在`~/.bashrc`或`~/.profile`文件中添加:

```bash

export PATH=/path/to/pytorch/bin:$PATH

```

然后,执行以下命令使改动生效:

```bash

source ~/.bashrc

```

环境变量的配置可能根据操作系统和使用的Shell的不同而有所不同。验证环境变量是否设置成功可以使用如下命令:

```bash

echo $PATH

```

## 3.3 PyTorch与PyCharm的集成

### 3.3.1 PyCharm中PyTorch插件的安装

PyCharm是流行的Python IDE,为了更好地使用PyTorch,可以安装PyCharm插件来增强功能。

1. 打开PyCharm,进入`File` > `Settings`(或`PyCharm` > `Preferences`在Mac上)。

2. 选择`Plugins`,在搜索框中输入`PyTorch`,找到PyTorch插件并安装。

3. 安装完成后重启PyCharm,插件会自动配置。

### 3.3.2 集成PyTorch后的项目设置

安装插件后,可以开始一个新的项目或者配置现有的项目来集成PyTorch。

1. 创建新项目时,在`New Project`窗口中设置解释器,选择已安装的PyTorch解释器。

2. 对于现有的项目,进入`File` > `Settings` > `Project: YourProjectName` > `Project Interpreter`,点击齿轮图标选择`Show All`,然后添加或选择PyTorch解释器。

确保项目设置了正确的解释器后,就可以开始编写PyTorch代码了。在`Tools` > `Python Scientific`菜单下,还可以找到专门用于PyTorch开发的工具,例如:IPython控制台和科学模式。

表格展示不同设置方法对比:

| 设置方法 | 优点 | 缺点 |

|----------------|------------------------------------------------|------------------------------------------------|

| 命令行工具安装 | 灵活性高,可以精确控制安装过程 | 初学者可能觉得复杂 |

| pip 安装 | 使用广泛,支持多种操作系统 | 对于有特定硬件加速需求时可能不够灵活 |

| conda 安装 | 简单易用,自动处理依赖,对硬件优化好 | 可能不够灵活,版本选择依赖conda仓库 |

通过上述步骤,可以确保在PyCharm中成功集成PyTorch库,接下来就可以开始深入探索PyTorch的强大功能了。

# 4. PyTorch基础实践

## 4.1 PyTorch张量操作

### 4.1.1 张量的基本操作

张量是PyTorch中用于表示多维数组的主力数据结构,它在数据的表达和计算中扮演了核心角色。从本质上来说,张量可以看做是向量、矩阵以及其他高维数据的推广。张量不仅包括标量、向量、矩阵这样的低阶数据结构,还能扩展到任意维度。

```python

import torch

# 创建一个零向量张量

zero_vector = torch.zeros(5)

print(zero_vector)

# 创建一个单位矩阵张量

identity_matrix = torch.eye(3)

print(identity_matrix)

# 创建一个随机张量

random_tensor = torch.rand(2, 3)

print(random_tensor)

```

上述代码演示了如何创建几种不同类型的张量。`zeros`函数用于创建全零张量,`eye`函数创建单位矩阵张量,而`rand`函数则生成了一个在[0,1)区间内均匀分布的随机张量。

对张量的基本操作不仅仅限于创建,还包括改变其形状(reshape)、索引、拼接(concatenate)、切片(slice)、转置(transpose)等。熟悉这些基本操作是构建复杂神经网络的基础。

### 4.1.2 张量计算与变换

在深度学习中,张量的计算通常涉及基础的数学运算,如加法、乘法、指数运算等。此外,张量变换如广播(broadcasting)、归一化(normalization)、尺度变换等也是常见的操作。

```python

# 张量加法运算

tensor_addition = torch.rand(2, 3) + torch.rand(2, 3)

print("Addition:\n", tensor_addition)

# 张量乘法运算

tensor_multiplication = torch.rand(2, 3) * torch.rand(2, 3)

print("Multiplication:\n", tensor_multiplication)

# 张量归一化

tensor_normalized = tensor_multiplication / tensor_multiplication.norm()

print("Normalized:\n", tensor_normalized)

```

在上述代码段中,我们展示了张量的逐元素加法和乘法运算。此外,我们通过除以张量的范数来展示如何进行归一化操作。通过这样的基础计算,我们能够对数据进行初步的处理,为后续的神经网络训练和推理工作做准备。

接下来,我们来使用张量的索引和切片功能。索引允许我们获取张量中的特定元素,而切片则可以让我们获取张量的一个子集。

```python

# 张量索引和切片

tensor = torch.randint(0, 10, (4, 5))

print("Original Tensor:\n", tensor)

# 获取第三行的前三个元素

row_slice = tensor[2, :3]

print("Row slice:\n", row_slice)

# 获取第二列的元素

column_slice = tensor[:, 1]

print("Column slice:\n", column_slice)

```

通过上述示例,我们演示了如何使用索引和切片来获取张量中的子集。这些操作是张量处理中最基础也是最实用的功能之一。

## 4.2 神经网络构建与训练

### 4.2.1 神经网络基础组件介绍

构建一个神经网络,通常需要几个基本组件:层(Layers)、激活函数(Activation functions)、损失函数(Loss functions)、优化器(Optimizers)以及前向传播(Forward pass)和反向传播(Backward pass)的实现。

层(Layers):在PyTorch中,许多不同类型的层(例如全连接层、卷积层、循环层等)都是通过`torch.nn.Module`子类实现的。这些层可以堆叠起来形成复杂的网络结构。

```python

import torch.nn as nn

# 创建一个简单的全连接层

linear_layer = nn.Linear(in_features=10, out_features=5)

print(linear_layer)

```

激活函数(Activation functions):它们为神经网络引入非线性。常用的激活函数包括ReLU、Sigmoid和Tanh等。

```python

# 创建一个ReLU激活函数

relu_activation = nn.ReLU()

print(relu_activation)

```

损失函数(Loss functions):损失函数用于衡量模型的输出和目标值之间的差距。常见的损失函数包括MSE(均方误差)和CrossEntropyLoss等。

```python

# 创建一个交叉熵损失函数

cross_entropy_loss = nn.CrossEntropyLoss()

print(cross_entropy_loss)

```

优化器(Optimizers):优化器负责更新网络的权重,常用的优化器包括SGD和Adam等。

```python

# 创建一个SGD优化器实例

sgd_optimizer = torch.optim.SGD(params=linear_layer.parameters(), lr=0.01)

print(sgd_optimizer)

```

前向传播(Forward pass):前向传播是数据通过神经网络的流程,最后输出预测值。

```python

# 前向传播的简单实现

input_data = torch.randn(1, 10)

output = linear_layer(input_data)

print(output)

```

反向传播(Backward pass):反向传播利用链式法则计算损失函数关于网络权重的梯度。

```python

# 模拟计算损失

target = torch.randint(0, 5, (1,))

loss = cross_entropy_loss(output, target)

# 反向传播计算梯度

sgd_optimizer.zero_grad() # 清除之前的梯度

loss.backward() # 计算梯度

sgd_optimizer.step() # 更新权重

```

通过上述各组件的介绍与示例代码,我们可以看出PyTorch对神经网络的构建和训练提供了非常丰富且易用的工具和接口。

### 4.2.2 构建简单神经网络实例

我们已经了解了构建神经网络所需的基本组件,现在让我们来通过构建一个简单全连接神经网络的实例,来实际演示这些组件如何协同工作。

```python

class SimpleNN(nn.Module):

def __init__(self):

super(SimpleNN, self).__init__()

self.layers = nn.Sequential(

nn.Linear(in_features=784, out_features=128), # 输入层到隐藏层

nn.ReLU(), # 激活函数

nn.Linear(in_features=128, out_features=10), # 隐藏层到输出层

nn.Softmax(dim=1) # 输出层使用softmax

)

def forward(self, x):

return self.layers(x)

# 实例化网络

model = SimpleNN()

# 打印网络结构

print(model)

```

这个简单的全连接神经网络有784个输入特征、一个隐藏层和10个输出。该网络结构使用了ReLU激活函数和softmax输出。通过`nn.Sequential`容器,我们顺序地串联了各个层。

### 4.2.3 训练过程演示与分析

在训练神经网络时,我们需要一系列的步骤,包括前向传播、计算损失、执行反向传播以及更新权重。以下是使用PyTorch进行简单训练过程的步骤。

```python

# 假设已有训练数据和对应的标签

# train_data = ...

# train_labels = ...

# 设置超参数

epochs = 10

learning_rate = 0.01

# 创建优化器

optimizer = torch.optim.SGD(model.parameters(), lr=learning_rate)

# 训练循环

for epoch in range(epochs):

model.train()

# 前向传播

outputs = model(train_data)

loss = nn.CrossEntropyLoss()(outputs, train_labels)

# 反向传播和优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 打印统计信息

print(f"Epoch [{epoch+1}/{epochs}], Loss: {loss.item():.4f}")

```

在训练循环中,`model.train()`用于确保模块中的Dropout和Batch Normalization等模块处于训练模式。经过`epochs`次迭代后,模型的权重会根据损失函数不断调整,以期达到更好的预测效果。

## 4.3 PyTorch中的数据加载与预处理

### 4.3.1 数据集的加载与处理

深度学习模型的训练离不开大量的数据。PyTorch提供了方便的数据加载和处理工具,比如`torch.utils.data.Dataset`和`torch.utils.data.DataLoader`。

`Dataset`类抽象了数据集对象,使得自定义数据集变得简单。而`DataLoader`则能够为数据集提供随机的批处理(batch)、打乱(shuffle)和多进程加载(multiprocessing)功能。

```python

import torch

from torch.utils.data import Dataset, DataLoader

# 定义一个自定义数据集

class CustomDataset(Dataset):

def __init__(self):

# 初始化数据集内容

pass

def __len__(self):

# 返回数据集的大小

pass

def __getitem__(self, idx):

# 根据索引idx返回数据集中的元素

pass

# 实例化数据集

dataset = CustomDataset()

# 创建数据加载器

dataloader = DataLoader(dataset, batch_size=32, shuffle=True)

# 训练循环中使用数据加载器

for inputs, labels in dataloader:

# 前向传播和训练

pass

```

在实际应用中,我们需要根据自己的数据集来实现`__len__`和`__getitem__`方法,以适应不同的数据处理需求。

### 4.3.2 数据增强与批处理技术

数据增强(Data Augmentation)是提升模型泛化能力的重要技术,通过在数据上应用一系列随机变换(如旋转、裁剪、缩放等)来增加数据的多样性。

```python

# 数据增强示例

transform = transforms.Compose([

transforms.RandomHorizontalFlip(),

transforms.RandomRotation(10),

transforms.Resize((224, 224)),

transforms.ToTensor()

])

# 使用transform对数据集中的图像应用数据增强

augmented_dataset = CustomDataset()

augmented_dataset.transform = transform

```

此外,批处理(batch processing)技术在数据加载中也十分关键。通过`DataLoader`提供的批处理功能,可以让训练过程在多条数据上同时进行,这不仅提高了硬件利用率,还能通过批数据的平均梯度来稳定梯度下降过程。

```python

# 批处理参数设置

batch_size = 32

# 实例化DataLoader,设置batch_size

dataloader = DataLoader(augmented_dataset, batch_size=batch_size, shuffle=True)

```

将数据增强与批处理技术结合起来,可以有效地提高模型的训练效率和泛化能力。在实践中,这些技术是深度学习模型训练不可或缺的部分。

# 5. PyTorch项目实战

## 5.1 实际案例分析

### 5.1.1 选择一个具体的机器学习项目

在选择具体的机器学习项目时,我们需要考虑几个关键因素,比如项目的目标、数据的可获取性、预期的复杂度以及模型的实用性。一个实用的案例是图像分类问题,例如区分不同种类的花朵。此类问题有大量的开源数据集可供使用,如著名的Iris数据集或ImageNet。选用此类数据集的优点是,由于它们已被广泛研究,因此更容易获取到相关的文献、代码示例和对比结果。此外,通过实现这样的项目,我们可以深入理解卷积神经网络(CNNs)的工作原理,这是当前图像识别任务中最常用的网络结构。

在具体实施之前,我们需要进行项目规划,明确项目的各个阶段及其预期目标。我们将项目大致分为以下三个阶段:

1. 数据准备和预处理

2. 网络设计和训练

3. 模型评估和部署

### 5.1.2 分析项目需求与PyTorch的优势

对于图像分类问题,深度学习库PyTorch具有很多显著优势。首先,PyTorch是动态计算图,这让模型的设计变得非常灵活,适合快速实验和调试。其次,PyTorch社区活跃,有大量的预训练模型和开源资源可供参考和使用。此外,PyTorch支持多GPU训练和分布式训练,这对于处理大规模数据集尤其重要。最后,PyTorch与PyCharm集成良好,使得代码的调试和运行更加高效。

下面我们将探讨如何使用PyTorch来实现一个简单的图像分类模型。

## 5.2 项目代码实现

### 5.2.1 编写项目初始化代码

项目初始化是设置项目基础结构和配置环境的过程。首先,我们需要导入必要的库和模块。

```python

import torch

import torch.nn as nn

import torchvision

import torchvision.transforms as transforms

from torch.utils.data import DataLoader

```

### 5.2.2 实现数据加载、模型构建、训练与评估

#### 数据加载与预处理

为了处理图像数据,我们需要定义一个转换流水线,包括缩放图像大小、归一化以及将数据转换为PyTorch张量。

```python

transform = transforms.Compose([

transforms.Resize((224, 224)), # 将图像缩放到适合大多数CNN模型的大小

transforms.ToTensor(), # 转换为PyTorch张量

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]) # 标准化

])

# 下载并加载数据集

train_dataset = torchvision.datasets.ImageFolder(root='path/to/train', transform=transform)

test_dataset = torchvision.datasets.ImageFolder(root='path/to/test', transform=transform)

train_loader = DataLoader(dataset=train_dataset, batch_size=64, shuffle=True)

test_loader = DataLoader(dataset=test_dataset, batch_size=64, shuffle=False)

```

#### 模型构建

接下来,我们将构建一个基础的卷积神经网络模型。

```python

class BasicCNN(nn.Module):

def __init__(self):

super(BasicCNN, self).__init__()

self.conv1 = nn.Conv2d(3, 64, kernel_size=3, padding=1)

self.conv2 = nn.Conv2d(64, 128, kernel_size=3, padding=1)

self.pool = nn.MaxPool2d(kernel_size=2, stride=2)

self.fc1 = nn.Linear(128 * 28 * 28, 512)

self.fc2 = nn.Linear(512, 10) # 假设有10个类别

self.relu = nn.ReLU()

def forward(self, x):

x = self.pool(self.relu(self.conv1(x)))

x = self.pool(self.relu(self.conv2(x)))

x = x.view(-1, 128 * 28 * 28) # 展平特征图

x = self.relu(self.fc1(x))

x = self.fc2(x)

return x

model = BasicCNN()

```

#### 训练过程

训练过程包括定义损失函数、优化器以及训练循环。

```python

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

# 训练循环

num_epochs = 10

for epoch in range(num_epochs):

running_loss = 0.0

for i, data in enumerate(train_loader, 0):

inputs, labels = data

# 清零梯度缓存

optimizer.zero_grad()

# 前向传播、反向传播、优化

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss += loss.item()

if i % 200 == 199: # 每200个批次打印一次

print('[%d, %5d] loss: %.3f' %

(epoch + 1, i + 1, running_loss / 200))

running_loss = 0.0

print('Finished Training')

```

#### 模型评估

最后,我们需要在测试数据集上评估模型的性能。

```python

correct = 0

total = 0

with torch.no_grad():

for data in test_loader:

images, labels = data

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print('Accuracy of the model on the test images: %d %%' % (100 * correct / total))

```

通过以上的步骤,我们可以构建一个基本的图像分类模型,并在实际项目中评估其性能。

# 6. PyTorch高级应用与优化

在第五章中,我们通过一个实际案例分析了如何从零开始构建一个项目,并通过PyTorch进行模型的训练和评估。在这一章,我们将深入探讨PyTorch的高级应用,包括模型的优化、部署和持续学习等话题。

## 6.1 PyTorch模型优化技巧

### 6.1.1 性能优化的策略

性能优化是任何机器学习项目中不可或缺的一环,尤其是在处理大规模数据和复杂模型时。PyTorch提供了多种性能优化的策略,包括但不限于使用`torch.nn.Module`的子类化、模块参数预分配、减少GPU内存占用等。

例如,我们可以通过以下策略进行性能优化:

- **预分配参数**:当使用循环或条件语句来创建模块或张量时,应提前分配足够的空间。

- **并行计算**:利用`torch.nn.DataParallel`或`torch.nn.parallel.DistributedDataParallel`进行多GPU并行训练。

- **减少数据传输**:减少主机和设备之间的数据传输次数,例如通过批量加载数据和批量计算来实现。

下面是一个减少GPU内存占用的示例代码:

```python

import torch

def free_gpu_cache():

# 清空cache并释放未使用的缓存

with torch.no_grad():

torch.cuda.empty_cache()

# 调用函数

free_gpu_cache()

```

### 6.1.2 模型调优的实际案例分析

在实际项目中,模型调优常常涉及到超参数搜索和模型剪枝。一种常见的优化方法是使用学习率衰减策略,比如在训练过程中逐步减小学习率,以稳定模型的训练过程。

```python

import torch.optim as optim

# 假设 optimizer 是我们的优化器

# 学习率衰减的策略可以是每多少个 epoch 衰减一次

scheduler = optim.lr_scheduler.StepLR(optimizer, step_size=30, gamma=0.1)

for epoch in range(num_epochs):

# 训练模型

train(...)

# 验证模型

validate(...)

# 更新学习率

scheduler.step()

```

通过上述策略,我们可以在保持模型性能的同时减少训练时间。

## 6.2 部署PyTorch模型

### 6.2.1 模型转换与部署过程

模型部署是将训练好的模型应用到实际的生产环境中。在PyTorch中,模型的部署通常涉及模型的转换和导出,使其能够在不同的平台上运行。

- **模型转换**:使用`torch.save`和`torch.load`保存和加载模型。

- **导出模型**:使用`torch.jit.trace`或`torch.jit.script`将模型编译成可执行的格式,如TorchScript,支持多种后端平台。

```python

# 使用TorchScript导出模型

model.eval()

example_input = torch.rand(1, 3, 224, 224)

traced_model = torch.jit.trace(model, example_input)

# 保存模型

traced_model.save("model.pt")

```

### 6.2.2 部署到不同平台的技术要点

PyTorch模型可以部署到多种平台,包括移动设备、服务器和云端。部署时需要考虑以下技术要点:

- **平台兼容性**:模型需要被转换为对应的平台能够理解的格式。

- **资源优化**:根据部署的平台调整模型的大小和性能,以适应不同的计算和存储资源。

- **接口设计**:为了与平台的其他系统或应用集成,设计合适的API接口。

## 6.3 持续学习与资源推荐

### 6.3.1 进阶学习资源与社区

机器学习和深度学习是一个快速发展的领域。为了保持竞争力,持续学习和实践是非常重要的。

- **官方文档**:PyTorch官方文档是学习和深入理解PyTorch的宝贵资源。

- **在线课程**:如Coursera、Udacity等提供的深度学习课程。

- **社区参与**:参与Stack Overflow、GitHub等社区,与其他开发者交流。

### 6.3.2 如何跟进PyTorch的最新动态

为了保持对PyTorch最新动态的了解,可以采取以下措施:

- **订阅邮件列表**:如PyTorch官方邮件列表,以便于及时获得更新和公告。

- **查看官方GitHub仓库**:了解最近的提交和版本更新。

- **参加PyTorch会议和研讨会**:如PyTorch DevCon,与其他开发者交流和学习。

通过这些资源和方法,可以帮助你在IT行业保持领先。

0

0