LSTM时间序列预测的最佳实践:总结行业经验与教训,提升预测准确度

LSTM时间序列预测方法与实践

1. LSTM时间序列预测基础**

LSTM(长短期记忆网络)是一种循环神经网络(RNN),专门用于处理时间序列数据。它能够学习长期依赖关系,这是传统RNN无法做到的。

LSTM单元由三个门组成:输入门、遗忘门和输出门。输入门控制新信息的流入,遗忘门控制旧信息的保留,输出门控制单元输出的信息。通过这种机制,LSTM可以有效地捕捉时间序列中的长期依赖关系,并预测未来的值。

LSTM时间序列预测模型通常包括以下步骤:数据预处理、特征工程、模型训练和超参数优化。数据预处理涉及清理和归一化数据,特征工程涉及选择和提取相关特征。模型训练和超参数优化涉及调整模型架构、激活函数、学习率和正则化参数,以获得最佳预测性能。

2. LSTM时间序列预测实践技巧

2.1 数据预处理和特征工程

2.1.1 数据清理和归一化

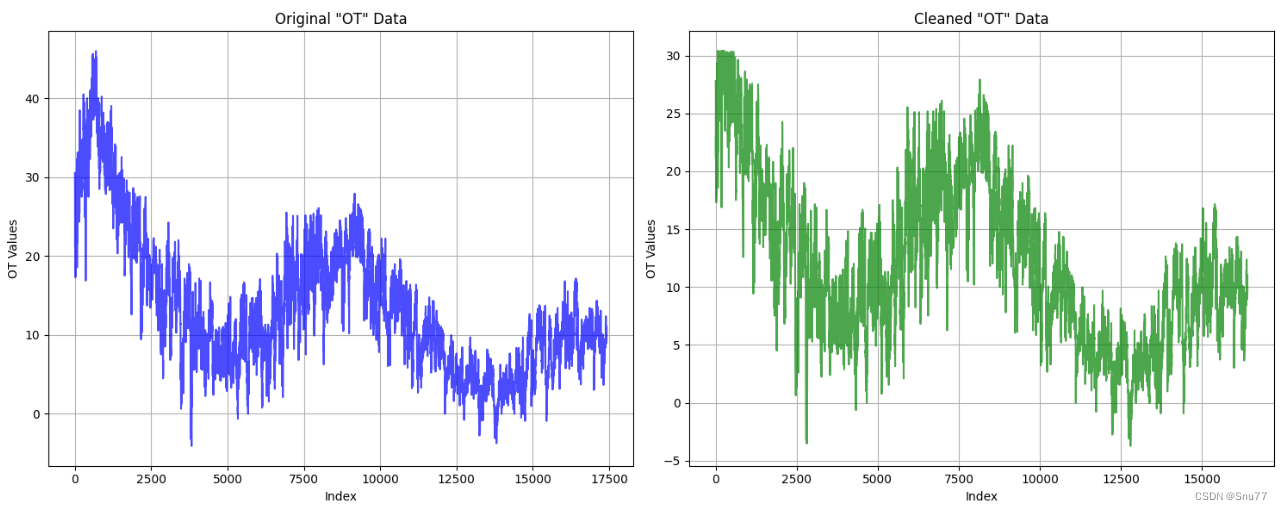

数据预处理是LSTM时间序列预测的关键步骤。它包括清理数据、处理缺失值和异常值,以及将数据归一化到一个共同的范围。

数据清理

数据清理涉及识别和删除无效或重复的数据点。这可以通过使用Pandas或NumPy等库中的数据清理函数来实现。

缺失值处理

缺失值处理是处理缺失数据点的一种技术。常用的方法包括:

- **删除缺失值:**如果缺失值的数量相对较少,则可以简单地删除它们。

- **插补缺失值:**使用平均值、中位数或其他统计方法来估计缺失值。

- **使用时间序列插补:**利用时间序列数据中的模式来预测缺失值。

归一化

归一化将数据范围缩放到一个共同的范围,如0到1或-1到1。这对于LSTM模型至关重要,因为它有助于模型学习数据的分布并防止特征值过大或过小。

2.1.2 特征选择和提取

特征选择和提取是识别和提取与预测目标相关的特征的过程。这对于提高模型性能和减少过拟合至关重要。

特征选择

特征选择涉及选择与预测目标最相关的特征。常用的技术包括:

- **Filter methods:**基于统计度量(如相关系数或信息增益)来选择特征。

- **Wrapper methods:**使用模型选择技术(如交叉验证)来评估特征子集的性能。

- **Embedded methods:**在模型训练过程中自动选择特征(如L1正则化)。

特征提取

特征提取涉及创建新的特征,这些特征由原始特征的组合或变换而来。常用的技术包括:

- **Principal component analysis (PCA):**将高维数据投影到低维空间。

- **Singular value decomposition (SVD):**类似于PCA,但适用于非方阵。

- **Autoencoders:**神经网络模型,用于学习数据的潜在表示。

2.2 模型训练和超参数优化

2.2.1 模型架构和激活函数

LSTM模型的架构由输入层、隐藏层和输出层组成。隐藏层通常由多个LSTM单元组成,每个单元处理一个时间步长的输入。

激活函数

激活函数决定了LSTM单元的输出。常用的激活函数包括:

- **tanh:**双曲正切函数,范围为[-1, 1]。

- **sigmoid:**逻辑函数,范围为[0, 1]。

- **ReLU:**修正线性单元,范围为[0, ∞]。

2.2.2 学习率和优化器

学习率控制模型权重的更新幅度。较高的学习率可能导致不稳定训练,而较低的学习率可能导致训练缓慢。

优化器是用于更新模型权重的算法。常用的优化器包括:

- **梯度下降:**一种简单的优化器,沿梯度负方向更新权重。

- **Momentum:**一种梯度下降的变体,它考虑了权重的历史梯度。

- **Adam:**一种自适应优化器,它使用动量和RMSprop来调整学习率。

2.2.3 正则化和Dropout

正则化是一种技术,用于防止模型过拟合。常用的正则化方法包括:

- **L1正则化:**向损失函数添加权重绝对值的惩罚项。

- **L2正则化:**向损失函数添加权重平方和的惩罚项。

Dropout是一种正则化技术,它在训练过程中随机丢弃一些神经元。这有助于防止模型过度依赖单个神经元。

3. LSTM时间序列预测应用

3.1 股票价格预测

3.1.1 数据获取和预处理

股票价格预测是LSTM时间序列预测的一