Python实现LSTM时间序列预测:从零基础到专家级

1. 时间序列预测简介**

1.1 时间序列的概念和特点

时间序列是一组按时间顺序排列的数据点,其中每个数据点都表示一个特定时间点的观测值。时间序列具有以下特点:

- **有序性:**数据点按时间顺序排列,即每个数据点都有一个明确的时间戳。

- **相关性:**时间序列中的数据点通常相互关联,即当前数据点受过去数据点的影响。

- **非平稳性:**时间序列的统计特性(如均值、方差)可能会随着时间而变化。

1.2 时间序列预测的意义和应用

时间序列预测旨在根据历史数据预测未来值,具有广泛的应用价值,包括:

- **预测需求:**预测未来对商品或服务的需求,以优化库存管理和生产计划。

- **异常检测:**识别时间序列中的异常值,以检测故障或欺诈行为。

- **趋势分析:**识别时间序列中的长期趋势,以制定战略决策和规划。

- **金融建模:**预测股票价格、汇率等金融指标,以做出投资决策。

2. LSTM神经网络基础

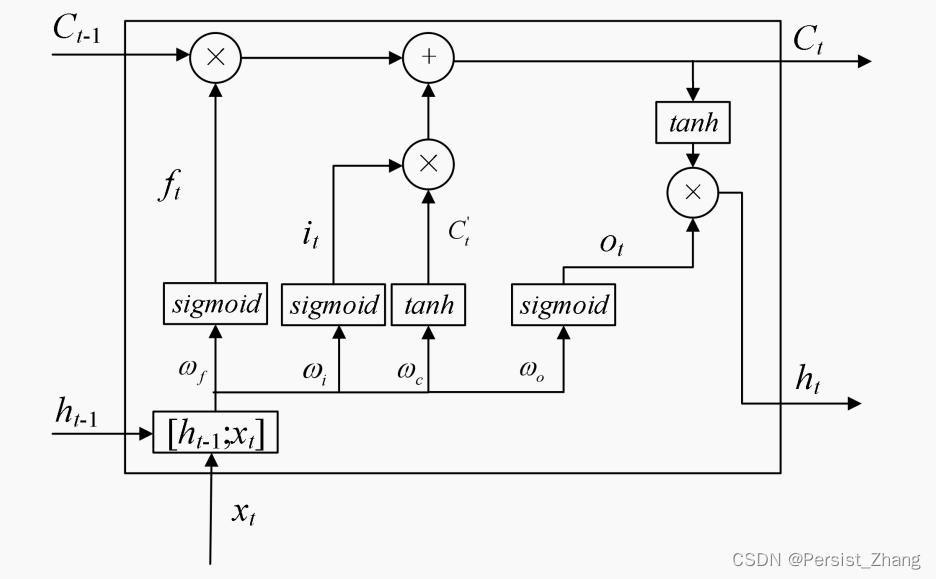

2.1 LSTM网络的结构和原理

**长短期记忆网络(LSTM)**是一种循环神经网络(RNN),专门设计用于处理时间序列数据。它具有记忆长期依赖关系的能力,使其非常适合于预测任务。

LSTM网络由以下组件组成:

- **记忆单元:**存储长期依赖关系。

- **输入门:**控制新信息的流入。

- **遗忘门:**控制旧信息的遗忘。

- **输出门:**控制输出信息的流出。

LSTM网络的工作原理如下:

- **输入门:**根据当前输入和前一时刻的隐藏状态,计算一个更新值。

- **遗忘门:**根据当前输入和前一时刻的隐藏状态,计算一个遗忘值。

- **记忆单元:**更新记忆单元,将新信息添加到旧信息中,并遗忘不相关的信息。

- **输出门:**根据当前输入和前一时刻的隐藏状态,计算一个输出值。

2.2 LSTM网络的训练和优化

LSTM网络的训练与其他神经网络类似,使用反向传播算法。然而,由于LSTM网络的复杂性,训练过程可能非常耗时。

为了优化训练过程,可以采用以下策略:

- **梯度截断:**防止梯度爆炸或消失。

- **学习率衰减:**随着训练的进行,降低学习率。

- **正则化:**防止过拟合,例如L1或L2正则化。

- **批归一化:**稳定训练过程,加快收敛速度。

代码示例:

- import tensorflow as tf

- # 创建LSTM层

- lstm_layer = tf.keras.layers.LSTM(units=100, return_sequences=True)

- # 编译模型

- model = tf.keras.Sequential([

- lstm_layer,

- tf.keras.layers.Dense(units=1)

- ])

- # 编译模型

- model.compile(optimizer='adam', loss='mean_squared_error')

- # 训练模型

- model.fit(X_train, y_train, epochs=100)

逻辑分析:

这段代码创建了一个LSTM层,并将其添加到一个顺序模型中。然后编译模型,使用Adam优化器和均方误差损失函数。最后,使用训练数据训练模型100个epoch。

参数说明:

units:LSTM单元的数量。return_sequences:是否返回序列输出(True)或仅返回最后一个输出(False)。optimizer:优化算法。loss:损失函数。epochs:训练的epoch数。

3. Python实现LSTM时间序列预测

3.1 数据预处理和特征工程

数据预处理

在进行时间序列预测之前,需要对原始数据进行预处理,包括数据清洗、缺失值处理和归一化。

数据清洗:删除异常值、重复值和不相关数据。

缺失值处理:使用插值法(如线性插值、均值插值)或删除缺失值。

归一化:将数据缩放到特定范围内(如0-1或-1到1),以消除不同特征之间的量纲差异。

特征工程

特征工程是通过提取和转换原始数据来创建更具预测力的特征的过程。对于时间序列预测,常用的特征工程技术包括:

滞后特征:使用过去的时间步作为特征,例如t时刻的特征包含t-1、t-2、…时刻的观测值。

滑动窗口:将时间序列划分为重叠的窗口,并使用每个窗口内的观测值创建特征。

差分:计算相邻时间步之间的差值,以消除趋势和季节性。

季节性分解:使用季节性分解技术(如STL分解)将时间序列分解为趋势、季节性和残差分量。

3.2 LSTM模型的构建和训练

LSTM模型构建

LSTM(长短期记忆)网络是一种循环神经网络,专门用于处理时间序列数据。LSTM模型由以下组件组成:

- 输入层:接收输入特征。

- 隐藏层:包含LSTM单元,用于存储长期依赖关系。

- 输出层:产生预测。

LSTM模型训练

LSTM模型的训练过程涉及以下步骤:

- 损失函数:定义模型预测与真实值之间的误差,如均方误差(MSE)或交叉熵损失。

- 优化器:使用优化算法(如梯度下降)最小化损失函数,更新模型权重。

- 训练数据:将预处理后的数据划分为训练集和验证集。

- 训练过程:在训练集上迭代训练模型,并使用验证集评估模型性能。

代码示例

- import tensorflow as tf

- # 创建LSTM模型

- model = tf.keras.models.Sequential()

- model.add(tf.keras.layers.LSTM(units=100, return_sequences=True, input_shape=(window_size, n_features)))

- model.add(tf.keras.layers.LSTM(units=100))

- model.add(tf.keras.layers.Dense(units=1))

- # 编译模型

- model.compile(optimizer='adam', loss='mse')

- # 训练模型

- model.fit(X_train, y_train, epochs=100, batch_size=32, validation_data=(X_val, y_val))

代码逻辑分析:

model.add(tf.keras.layers.LSTM(units=100, return_sequences=True, input_shape=(window_size, n_features))):添加一个LSTM层,具有100个隐藏单元,并返回序列输出。model.add(tf.keras.layers.LSTM(units=100)):添加另一个LSTM层,具有100个隐藏单元。model.add(tf.keras.layers.Dense(units=1)):添加一个密集层,用于产生预测。model.compile(optimizer='adam', loss='mse'):编译模型,使用Adam优化器和均方误差损失函数。model.fit(X_train, y_train, epochs=100, batch_size=32, validation_data=(X_val, y_val)):训练模型,使用训练数据和验证数据。

3.3 模型评估和预测

模型评估

训练后,使用以下指标评估模型性能:

- 均方根误差(RMSE):预测值与真实值之间的平方误差的平方根。

- 平均绝对误差(MAE):预测值与真实值之间的绝对误差的平均值。

- R平方(R2):模型预测值与真实值之间相关性的度量。

预测

训练并评估模型后,可以使用新数据进行预测。预测步骤如下:

- 数据预处理:对新数据进行与训练数据相同的预处理。

- 模型加载:加载训练好的模型。

- 预测:使用模型对新数据进行预测。

代码示例

- # 加载训练好的模型

- model = tf.keras.models.load_model('lstm_model.h5')

- # 对新数据进行预处理

- new_data = ...

- # 预测

- predictions = model.predict(new_data)

代码逻辑分析:

model = tf.keras.models.load_model('lstm_model.h5'):加载训练好的模型。predictions = model.predict(new_data):使用模型对新数据进行预测。

4. LSTM时间序列预测实战**

4.1 股票价格预测

4.1.1 数据获取和预处理

股票价格预测需要使用历史股票价格数据。我们可以从 Yahoo Finance 或 Google Finance 等数据源获取数据。数据通常包含日期、开盘价、最高价、最低价和收盘价。

- import pandas as pd

- # 从 Yahoo Finance 获取股票价格数据

- data = pd.read_csv('stock_prices.csv')

- # 预处理数据

- data['Date'] = pd.to_datetime(data['Date'])

- data = data.set_index('Date')

4.1.2 特征工程

特征工程是将原始数据转换为模型可以理解和使用的特征的过程。对于股票价格预测,我们可以使用以下特征:

- 开盘价

- 最高价

- 最低价

- 收盘价

- 成交量

4.1.3 LSTM模型构建

- import tensorflow as tf

- # 构建 LSTM 模型

- model = tf.keras.models.Sequential()

- model.add(tf.keras.layers.LSTM(units=100, return_sequences=True, input_shape=(data.shape[1],)))

- model.add(tf.keras.layers.LSTM(units=100))

- model.add(tf.keras.layers.Dense(units=1))

4.1.4 模型训练

- # 编译模型

- model.compile(optimizer='adam', loss='mean_squared_error')

- # 训练模型

- model.fit(data, data['Close'], epochs=100, batch_size=32)

4.1.5 模型评估和预测

- # 评估模型

- score = model.evaluate(data, data['Close'])

- print('MSE:', score)

- # 预测未来股票价格

- future_prices = model.predict(data[-10:])

4.2 温度预测

4.2.1 数据获取和预处理

温度预测需要使用历史温度数据。我们可以从气象局或其他数据源获取数据。数据通常包含日期和温度。

- import pandas as pd

- # 从气象局获取温度数据

- data = pd.read_csv('temperature.csv')

- # 预处理数据

- data['Date'] = pd.to_datetime(data['Date'])

- data = data.set_index('Date')

4.2.2 特征工程

对于温度预测,我们可以使用以下特征:

- 历史温度

- 季节性特征(例如,月份、星期几)

- 天气状况

4.2.3 LSTM模型构建

- import tensorflow as tf

- # 构建 LSTM 模型

- model = tf.keras.models.Sequential()

- model.add(tf.keras.layers.LSTM(units=100, return_sequences=True, input_shape=(data.shape[1],)))

- model.add(tf.keras.layers.LSTM(units=100))

- model.add(tf.keras.layers.Dense(units=1))

4.2.4 模型训练

- # 编译模型

- model.compile(optimizer='adam', loss='mean_squared_error')

- # 训练模型

- model.fit(data, data['Temperature'], epochs=100, batch_size=32)

4.2.5 模型评估和预测

- # 评估模型

- score = model.evaluate(data, data['Temperature'])

- print('MSE:', score)

- # 预测未来温度

- future_temperatures = model.predict(data[-10:])

4.3 销售额预测

4.3.1 数据获取和预处理

销售额预测需要使用历史销售额数据。我们可以从公司数据库或其他数据源获取数据。数据通常包含日期、产品、销售额和促销活动。

- import pandas as pd

- # 从公司数据库获取销售额数据

- data = pd.read_csv('sales.csv')

- # 预处理数据

- data['Date'] = pd.to_datetime(data['Date'])

- data = data.set_index('Date')

4.3.2 特征工程

对于销售额预测,我们可以使用以下特征:

- 历史销售额

- 季节性特征(例如,月份、星期几)

- 促销活动

- 经济指标

4.3.3 LSTM模型构建

- import tensorflow as tf

- # 构建 LSTM 模型

- model = tf.keras.models.Sequential()

- model.add(tf.keras.layers.LSTM(units=100, return_sequences=True, input_shape=(data.shape[1],)))

- model.add(tf.keras.layers.LSTM(units=100))

- model.add(tf.keras.layers.Dense(units=1))

4.3.4 模型训练

- # 编译模型

- model.compile(optimizer='adam', loss='mean_squared_error')

- # 训练模型

- model.fit(data, data['Sales'], epochs=100, batch_size=32)

4.3.5 模型评估和预测

- # 评估模型

- score = model.evaluate(data, data['Sales'])

- print('MSE:', score)

- # 预测未来销售额

- future_sales = model.predict(data[-10:])

5. LSTM时间序列预测的优化

5.1 模型超参数的调优

LSTM模型的性能很大程度上取决于其超参数的设置,这些超参数包括:

- **学习率:**控制模型权重更新的步长。学习率过高可能导致模型不稳定,而学习率过低则可能导致训练速度慢。

- **批次大小:**一次训练中使用的样本数量。批次大小过大可能导致内存不足,而批次大小过小则可能导致训练不稳定。

- **隐藏层单元数:**LSTM网络中隐藏层的单元数。单元数越多,模型的复杂度越高,但过多的单元数可能导致过拟合。

- **层数:**LSTM网络中隐藏层的层数。层数越多,模型的深度越深,但过多的层数可能导致梯度消失或爆炸。

调优超参数通常采用网格搜索或贝叶斯优化等方法。这些方法通过系统地遍历超参数空间,找到最佳的超参数组合。

5.2 数据增强和正则化技术

数据增强和正则化技术可以帮助防止过拟合,提高模型的泛化能力。

数据增强是指通过对原始数据进行变换(如翻转、旋转、缩放)来生成更多样化的训练数据。这可以帮助模型学习数据中更广泛的特征。

正则化是指通过向损失函数添加惩罚项来约束模型的复杂度。常用的正则化技术包括:

- **L1正则化(Lasso):**惩罚模型权重的绝对值,有助于稀疏化模型。

- **L2正则化(Ridge):**惩罚模型权重的平方值,有助于平滑模型。

- **Dropout:**在训练过程中随机丢弃一部分神经元,有助于防止过拟合。

5.3 迁移学习和集成学习

迁移学习和集成学习可以进一步提高LSTM时间序列预测模型的性能。

迁移学习是指将预先训练好的模型应用于新的任务。这可以利用预训练模型中已经学到的特征,从而加快新任务的训练速度并提高准确性。

集成学习是指将多个模型的预测结果进行组合,以获得更好的预测性能。常用的集成学习方法包括:

- **Bagging:**训练多个模型,每个模型使用不同的训练数据子集,然后对预测结果进行平均。

- **Boosting:**训练多个模型,每个模型基于前一个模型的预测结果进行训练,然后对预测结果进行加权平均。

- **Stacking:**将多个模型的预测结果作为输入,训练一个新的模型进行最终预测。

6. LSTM时间序列预测的应用**

LSTM时间序列预测在各个领域都有着广泛的应用,以下列举几个典型的应用场景:

6.1 异常检测和故障诊断

LSTM可以用于检测时间序列数据中的异常和故障。通过训练LSTM模型学习正常数据模式,当出现与正常模式显著不同的数据时,LSTM模型可以识别并发出警报。

- import numpy as np

- import pandas as pd

- import matplotlib.pyplot as plt

- from sklearn.preprocessing import StandardScaler

- from sklearn.model_selection import train_test_split

- from keras.models import Sequential

- from keras.layers import LSTM, Dense

- # 导入数据

- data = pd.read_csv('sensor_data.csv')

- # 数据预处理

- data['timestamp'] = pd.to_datetime(data['timestamp'])

- data.set_index('timestamp', inplace=True)

- data = data.resample('1H').mean()

- data = data.fillna(data.mean())

- data = StandardScaler().fit_transform(data)

- # 划分数据集

- X_train, X_test, y_train, y_test = train_test_split(data, data['value'], test_size=0.2)

- # 构建LSTM模型

- model = Sequential()

- model.add(LSTM(units=100, return_sequences=True, input_shape=(X_train.shape[1], 1)))

- model.add(LSTM(units=100))

- model.add(Dense(units=1))

- # 编译模型

- model.compile(optimizer='adam', loss='mse')

- # 训练模型

- model.fit(X_train, y_train, epochs=100, batch_size=32)

- # 评估模型

- score = model.evaluate(X_test, y_test, verbose=0)

- print('Test score:', score)

- # 预测异常

- y_pred = model.predict(X_test)

- plt.plot(y_test, label='Actual')

- plt.plot(y_pred, label='Predicted')

- plt.legend()

- plt.show()

- # 识别异常

- threshold = 0.1

- anomalies = np.where(np.abs(y_pred - y_test) > threshold)[0]

- print('Anomalies:', anomalies)

6.2 自然语言处理

LSTM在自然语言处理领域也有着广泛的应用,例如:

- 文本分类

- 情感分析

- 机器翻译

- 文本摘要

- import tensorflow as tf

- from tensorflow.keras.preprocessing.text import Tokenizer

- from tensorflow.keras.preprocessing.sequence import pad_sequences

- from tensorflow.keras.models import Sequential

- from tensorflow.keras.layers import LSTM, Dense, Embedding

- # 导入数据

- data = pd.read_csv('text_data.csv')

- # 分词和编码

- tokenizer = Tokenizer(num_words=10000)

- tokenizer.fit_on_texts(data['text'])

- sequences = tokenizer.texts_to_sequences(data['text'])

- padded = pad_sequences(sequences, maxlen=100)

- # 构建LSTM模型

- model = Sequential()

- model.add(Embedding(input_dim=10000, output_dim=128))

- model.add(LSTM(units=128, return_sequences=True))

- model.add(LSTM(units=128))

- model.add(Dense(units=1, activation='sigmoid'))

- # 编译模型

- model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

- # 训练模型

- model.fit(padded, data['label'], epochs=10, batch_size=32)

- # 评估模型

- score = model.evaluate(padded, data['label'], verbose=0)

- print('Test score:', score)

- # 文本分类

- new_text = 'This is a great movie!'

- new_sequence = tokenizer.texts_to_sequences([new_text])

- new_padded = pad_sequences(new_sequence, maxlen=100)

- prediction = model.predict(new_padded)

- print('Predicted class:', prediction)

6.3 图像和视频分析

LSTM还可以用于图像和视频分析,例如:

- 图像分类

- 目标检测

- 视频动作识别

- import tensorflow as tf

- from tensorflow.keras.preprocessing.image import ImageDataGenerator

- from tensorflow.keras.models import Sequential

- from tensorflow.keras.layers import LSTM, Conv2D, MaxPooling2D, Flatten, Dense

- # 导入数据

- train_datagen = ImageDataGenerator(rescale=1./255)

- train_generator = train_datagen.flow_from_directory(

- 'image_data/train',

- target_size=(224, 224),

- batch_size=32,

- class_mode='categorical'

- )

- # 构建LSTM模型

- model = Sequential()

- model.add(Conv2D(filters=32, kernel_size=(3, 3), activation='relu', input_shape=(224, 224, 3)))

- model.add(MaxPooling2D(pool_size=(2, 2)))

- model.add(LSTM(units=128, return_sequences=True))

- model.add(LSTM(units=128))

- model.add(Flatten())

- model.add(Dense(units=3, activation='softmax'))

- # 编译模型

- model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

- # 训练模型

- model.fit(train_generator, epochs=10, batch_size=32)

- # 评估模型

- score = model.evaluate(train_generator, verbose=0)

- print('Test score:', score)

- # 图像分类

- new_image = tf.keras.preprocessing.image.load_img('new_image.jpg', target_size=(224, 224))

- new_image = tf.keras.preprocessing.image.img_to_array(new_image)

- new_image = np.expand_dims(new_image, axis=0)

- prediction = model.predict(new_image)

- print('Predicted class:', prediction)