【数据挖掘探险】:深入NASA电池数据集的洞见挖掘之旅

发布时间: 2024-12-26 04:03:41 阅读量: 15 订阅数: 21

# 摘要

本文探讨了数据挖掘在航天领域的应用,从数据预处理到特征工程,再到具体的数据挖掘算法实践,以及高级主题探索和案例研究。在数据预处理部分,本文详细讨论了数据清洗、特征提取和数据转换的策略和技术细节。在实践环节,描述性统计分析、关联规则学习和预测模型构建的方法论和应用案例被深入探讨。高级主题部分涵盖了异常检测、预测维护、优化与决策支持等议题,并对它们在航天数据集中的应用进行了实例分析。最后,通过对NASA电池数据集的案例研究,本文展示了数据挖掘如何在航天器电池性能改进中发挥作用,并对未来技术趋势进行了展望。本研究旨在展示数据挖掘技术在航天领域中的潜力和实用价值。

# 关键字

数据挖掘;特征工程;关联规则;预测模型;异常检测;决策支持

参考资源链接:[NASA电池数据集详解:老化、工况与预测分析](https://wenku.csdn.net/doc/6401ab9dcce7214c316e8e01?spm=1055.2635.3001.10343)

# 1. 数据挖掘在航天领域的应用概述

在航天领域,数据挖掘技术已经成为关键的应用工具,用于从海量的飞行数据中提取有价值的信息,进而增强飞行器的安全性、可靠性和效率。与传统数据处理方法相比,数据挖掘提供了一种更为高效和智能的数据分析手段,使得工程师能够准确地进行故障预测、性能监控和健康管理。本章将探讨数据挖掘在航天领域的基本应用,包括数据的采集、存储、处理和分析,以期为读者呈现一个全面的概述。

# 2. 数据预处理与特征工程

在数据挖掘领域,数据预处理与特征工程是至关重要的步骤,它们直接关系到最终模型的性能与效果。本章将详细介绍数据预处理的策略和方法,包括数据清洗、特征提取、归一化与转换等关键技术。

### 2.1 数据清洗的策略和方法

数据清洗是数据预处理的第一步,其目的是识别并纠正(或删除)数据集中的不准确、不一致或不完整的数据。本小节将重点讨论在数据挖掘中,特别是在航天领域数据处理中常用的数据清洗策略和方法。

#### 2.1.1 缺失值处理

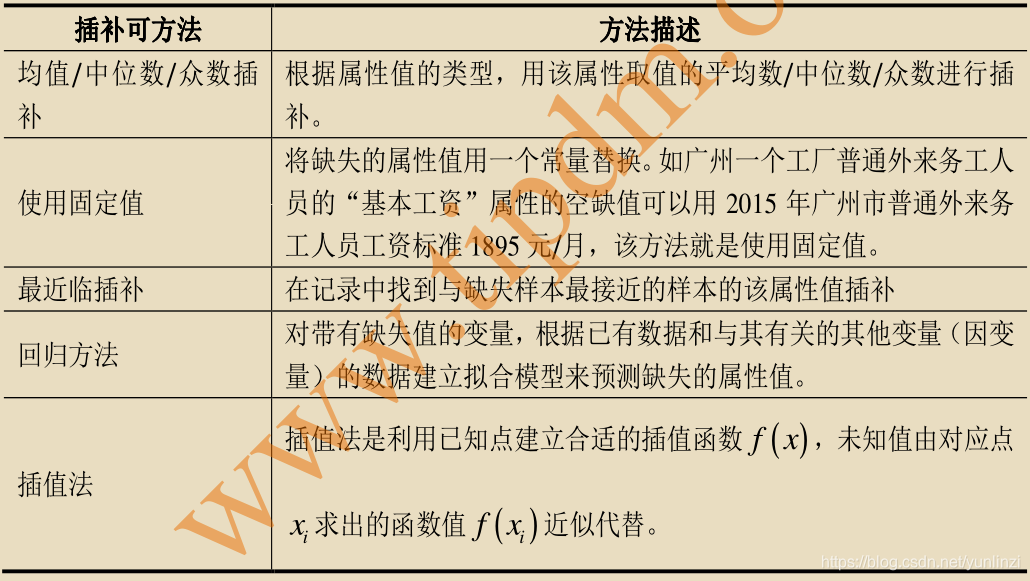

在实际的数据集中,缺失值是一个常见的问题。缺失值可能由于数据录入错误、通信故障、传感器失灵等多种原因产生。处理缺失值的方法主要包括删除含有缺失值的记录、填充缺失值、以及使用算法来预测缺失值。

- **删除记录**: 如果数据集中的缺失值较少,并且缺失值随机分布,那么删除含有缺失值的记录可能是简单有效的策略。

- **填充缺失值**: 对于缺失值,可以使用同一特征的中位数、平均数或者众数来填充。在某些情况下,也可以基于其他相关特征的值来预测缺失值。

以下是使用 Python 中 pandas 库处理缺失值的示例代码:

```python

import pandas as pd

# 创建一个含有缺失值的 DataFrame

data = pd.DataFrame({

'Feature1': [1, 2, None, 4],

'Feature2': [5, None, 7, 8]

})

# 删除含有缺失值的行

data_cleaned_drop = data.dropna()

# 使用列的平均值填充缺失值

data_filled_mean = data.fillna(data.mean())

```

在这段代码中,`dropna()` 函数用于删除含有缺失值的行,而 `fillna()` 函数则利用每个特征的平均值来填充缺失值。

#### 2.1.2 异常值检测与处理

异常值(或离群点)是那些显著偏离其他观测值的值。异常值可能是由错误导致的,也可能是真实现象的反映,因此,在处理异常值时应谨慎。

- **异常值检测**: 可以使用统计方法(如 Z-score、IQR)或者基于模型的方法(如聚类分析)来检测异常值。

- **异常值处理**: 对于检测到的异常值,可以选择忽略、修正或者删除。在进行决策前,需要仔细分析异常值的性质和成因。

以使用 Z-score 方法检测异常值为例,如果一个值的 Z-score 超过某个阈值(通常是3或-3),则可以认为该值是异常值。下面是使用 Z-score 方法检测异常值的代码示例:

```python

from scipy import stats

# 计算 Z-score

data['Z_score'] = abs(stats.zscore(data))

# 设定阈值

threshold = 3

# 检测异常值

outliers = data['Z_score'] > threshold

# 处理异常值,这里是选择删除

data_cleaned_outliers = data[~outliers]

```

在这个示例中,首先使用 `stats.zscore()` 函数计算了数据集的 Z-score 值,并将其添加为一个新列。然后,根据设定的阈值确定哪些值是异常值,并将其删除。

### 2.2 数据集的特征提取

特征提取是从原始数据中抽取信息、构造有意义的新特征的过程。这一步骤可以提高模型的预测性能并减少计算资源的消耗。特征提取的常见方法包括基于统计的方法、基于模型的方法等。

#### 2.2.1 特征选择的重要性

特征选择的目的在于从大量的特征中选出最有利于模型训练的特征子集。好的特征选择可以提升模型的性能,减少过拟合,提高模型的泛化能力。

特征选择的常见方法有:

- **过滤方法**: 根据特征与目标变量之间的统计测试来选择特征,如卡方检验、ANOVA。

- **包裹方法**: 利用学习器的预测性能来评估特征组合,如递归特征消除(RFE)。

- **嵌入方法**: 在模型训练过程中进行特征选择,如使用L1正则化。

例如,使用 L1 正则化在逻辑回归模型中进行特征选择的代码如下:

```python

from sklearn.linear_model import LogisticRegression

from sklearn.datasets import load_iris

# 加载数据集

data, target = load_iris(return_X_y=True)

# 创建逻辑回归模型,包含L1正则化

clf = LogisticRegression(penalty='l1', solver='liblinear')

# 训练模型

clf.fit(data, target)

# 获取特征权重

feature_weights = clf.coef_

# 选择绝对值最大的特征

selected_features = feature_weights.argsort()[0][-3:]

```

在这段代码中,使用了带有 L1 正则化的逻辑回归模型来训练数据,并选择了权重绝对值最大的三个特征。这种特征选择方法可以集成在模型训练过程中,提高模型效率。

#### 2.2.2 常见的特征选择方法

以下是表格形式总结了常见的几种特征选择方法:

| 方法 | 描述 | 优点 | 缺点 |

| --- | --- | --- | --- |

| 过滤方法 | 使用统计测试来选择特征,如卡方检验 | 计算简单,适用于预处理 | 不考虑特征之间的关系 |

| 包裹方法 | 基于模型的评估来选择特征组合 | 考虑特征之间的相互作用 | 计算复杂度高 |

| 嵌入方法 | 在模型训练过程中进行特征选择 | 与模型训练结合紧密 | 可能需要调整参数 |

特征选择方法的选择需要根据具体的业务场景和数据集特点来决定。

### 2.3 数据归一化与转换

数据归一化和转换是为了确保数据具有统一的量纲,以避免由于不同尺度导致的模型训练问题,从而提升模型的收敛速度和预测性能。

#### 2.3.1 归一化的目的与方法

归一化的目的是将特征值转换到统一的尺度内,常用的方法包括:

- **最小-最大归一化 (Min-Max Normalization)**: 将特征值缩放到一个固定范围,通常是 [0, 1]。

- **Z-score 标准化 (Z-Score Normalization)**: 使特征值的分布围绕均值为 0,标准差为 1。

下面展示的是使用最小-最大归一化的 Python 代码:

```python

from sklearn.preprocessing import MinMaxScaler

# 创建 MinMaxScaler 实例

scaler = MinMaxScaler()

# 进行归一化

data_scaled = scaler.fit_transform(data)

```

在这段代码中,`MinMaxScaler` 对象根据提供的数据集计算了最小和最大值,然后将数据归一化到 [0, 1] 范围。

#### 2.3.2 数据转换的技术细节

数据转换是对原始数据的数学或统计变换,目的是提高数据的表达能力,常用的技术包括:

- **对数转换 (Log Transformation)**: 对数据进行对数变换来减少数据的偏度。

- **平方根转换 (Square Root Transformation)**: 对数据进行平方根变换以降低数据的方差。

- **Box-Cox 转换**: 一种寻找接近正态分布转换的方法。

例如,对数转换的一个应用场景是处理具有指数分布特征的数据,代码示例如下:

```python

import numpy as np

# 创建一个具有指数分布的数据集

data = np.exp(np.random.rand(100) * 2)

# 进行对数转换

data_transformed = np.log(data)

```

在这段代码中,首先使用 `np.exp()` 函数生成了一个具有指数分布的数据集,随后利用 `np.log()` 函数对其进行了对数转换。

### 总结

数据预处理和特征工程是数据挖掘中的关键环节,通过合理的数据清洗策略和方法,我们可以显著提高数据质量;有效的特征提取和转换能够帮助模型更好地捕捉数据背后的模式;最终,这些步骤将为我们构建准确、高效的预测模型奠定坚实的基础。在航天领域,数据通常包含着丰富的信息,因此更需要精心地处理和分析,以确保在极端环境下的可靠性和准确性。

# 3. 数据挖掘算法实践

在数据挖掘领域,算法的运用是实现深入分析和知识提取的关键。本章将详细探讨描述性统计分析与可视化

0

0