【数据整合艺术】:NASA电池数据集与外部资源的无缝对接

发布时间: 2024-12-26 04:45:53 阅读量: 3 订阅数: 9

NASA的锂电池容量衰退数据集.zip

# 摘要

数据整合是确保信息准确性、完整性和可用性的重要过程,对于数据分析和决策支持至关重要。本文首先介绍了数据整合的概念及其重要性,然后深入探讨了NASA电池数据集的结构和内容,分析了数据质量预处理的策略和技巧。接着,本文探讨了外部资源整合技术,包括数据源接入、转换与融合的实践方法,以及如何构建自动化数据整合流程。在实践案例分析章节,本文通过NASA电池数据与工业数据整合的案例,阐释了数据整合策略,并讨论了整合过程中遇到的挑战及解决方法。本文还介绍了高级数据整合技术、最佳实践与规范,并预测了数据整合技术的未来趋势,特别是人工智能的应用。最后,本文探讨了构建数据整合生态系统的要素、设计原则与实施步骤,以及持续优化和维护策略,为数据整合提供了全面的技术和策略指导。

# 关键字

数据整合;数据质量;自动化流程;高级技术;生态系统;人工智能

参考资源链接:[NASA电池数据集详解:老化、工况与预测分析](https://wenku.csdn.net/doc/6401ab9dcce7214c316e8e01?spm=1055.2635.3001.10343)

# 1. 数据整合的概念与重要性

数据整合是数据管理的关键环节,它涉及将来自不同源的数据合并为一致的数据集,并确保数据的完整性、准确性和可用性。一个有效的数据整合流程可以确保企业拥有的数据资产能够为企业提供支持决策的有价值的洞察。

随着企业数据量的激增,数据整合变得越来越重要。它不仅有助于提高数据的整体质量,而且通过整合不同来源的数据,可以解锁更多潜在的业务价值,帮助企业做出更明智的决策。此外,数据整合也是实现数据驱动战略和采用更高级数据分析技术(如人工智能和机器学习)的基础。

在本章中,我们将深入了解数据整合的基本概念,探讨它对于企业成功的重要性,并分析良好的数据整合策略如何能为企业带来竞争优势。这为后续章节中的数据集详细解读和外部资源整合技术奠定了基础。

## 1.1 数据整合的定义

数据整合是将来自多个源的数据合并到一个单一、统一的视图中的过程。这个过程不仅包括了物理上的数据合并,还包括了数据清洗、转换、验证和同步等步骤,以确保整合后的数据的准确性和一致性。

## 1.2 数据整合的目的

数据整合的最终目的是提供一个可靠的、高质量的数据源,用于支持企业的运营和决策制定。整合的数据可以用于各种用途,包括数据分析、报告、预测和优化业务流程。

## 1.3 数据整合的必要性

在大数据时代,数据的多样性、复杂性和体量都呈指数级增长。企业为了在竞争激烈的市场中保持竞争力,必须能够有效地整合和管理这些数据。数据整合能够帮助企业打破数据孤岛,提升数据使用效率,减少数据冗余和不一致,从而更好地洞察市场动态和客户行为,优化资源配置,提高业务流程效率。

# 2. NASA电池数据集的详细解读

在当今数据密集型的时代,深入理解特定数据集对于机器学习、人工智能和统计学等多个领域的研究者和工程师至关重要。本章聚焦于NASA电池数据集的详细解读,提供数据集结构和内容的全面概览,深入分析数据质量与预处理的方法,并展开基于这些数据的探索性分析。通过细致的讲解,我们意在揭示如何通过理解和运用这些数据集中的信息,来推进能源管理、预测维护等领域的技术进步。

## 2.1 数据集结构与内容概述

### 2.1.1 数据集基本结构

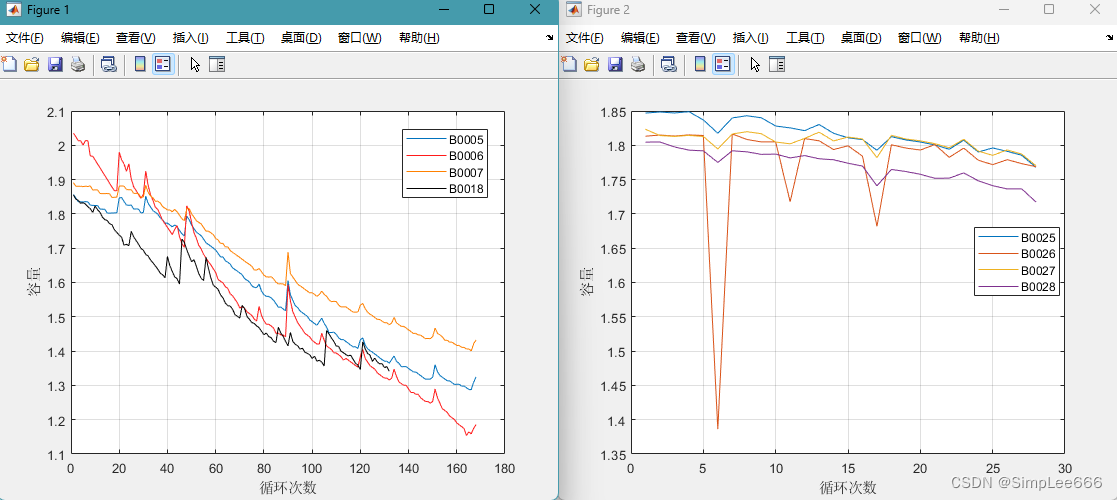

NASA电池数据集是一个开源数据集,由美国国家航空航天局提供,主要用于电池性能预测和健康管理的研究。数据集记录了电池的充电、放电、循环寿命等多维度的数据信息,覆盖了从材料特性、电化学反应到整个电池系统的性能表现。

数据集通常由多个CSV文件组成,每个文件包含了不同维度的数据。例如,`cell_temperature.csv`记录了电池在不同工作条件下的温度变化数据,而`charge_discharge_data.csv`则包含了电池在不同充放电周期下的电流、电压和容量等信息。

数据集基本结构的解析是理解数据集整体情况的第一步。以下是数据集部分文件的结构解析示例:

```csv

cycle_number,discharge_time_to_0v,voltage

1,273.89,4.09

2,272.35,4.08

```

每行代表一个数据点,列与列之间用逗号分隔。数据集中的每一列都表示一种测量值,如充电次数(`cycle_number`)、放电时间至0伏特(`discharge_time_to_0v`)和电池电压(`voltage`)。

### 2.1.2 关键数据字段解析

对于NASA电池数据集来说,关键数据字段的识别和理解对于后续的数据分析与建模至关重要。这里以几个关键字段为例,介绍其在电池性能分析中的作用和意义。

- `cycle_number`:标识电池经过的充放电循环次数。它是研究电池老化过程的一个基本指标。

- `charge_rate`:充电速率,表示单位时间内的充电电流与电池容量的比率。在电池管理系统中,充电速率对电池寿命和安全性有重大影响。

- `discharge_capacity`:放电容量,表示电池放电至某个截止电压时所能提供的电量。它是衡量电池性能的重要参数之一。

在数据集中,每个字段都承载着特定的信息。例如,在`charge_discharge_data.csv`中,`charge_rate`和`discharge_capacity`字段常被用来评估电池在不同充放电条件下的性能表现。这些数据是进一步进行数据挖掘和建立预测模型的基础。

## 2.2 数据质量与预处理

### 2.2.1 数据清洗策略

数据质量是数据科学项目成功的关键。在对NASA电池数据集进行分析之前,需要采用一定的数据清洗策略以确保数据质量。数据清洗通常包括以下几个步骤:

1. 去除重复记录:确保每个数据点的唯一性。

2. 处理缺失值:采取填充、删除或估算的方式处理缺失数据。

3. 异常值检测与处理:识别数据中的异常值,并采取相应的处理策略。

以下是一个简单的代码示例,展示如何使用Python进行数据清洗:

```python

import pandas as pd

# 读取数据

data = pd.read_csv('data/battery_data.csv')

# 去除重复记录

data = data.drop_duplicates()

# 处理缺失值:这里简单地删除含有缺失值的行

data = data.dropna()

# 异常值检测与处理

# 假设我们定义电压的合理范围在3.7V到4.2V之间

data = data[(data['voltage'] >= 3.7) & (data['voltage'] <= 4.2)]

```

### 2.2.2 数据预处理的实践技巧

数据预处理阶段除了基本的清洗策略外,还包括数据归一化、特征工程等技巧。这些技术的应用能够提升后续模型的性能和准确性。

- 数据归一化:对数据集中的数值特征进行归一化处理,使得不同量纲和数量级的数据能够在同一尺度上进行比较。

```python

from sklearn.preprocessing import MinMaxScaler

# 假设data为包含数值特征的DataFrame

scaler = MinMaxScaler()

data_normalized = scaler.fit_transform(data)

```

- 特征工程:通过创建、选择和转换变量来增强数据的表达能力。例如,可以基于时间序列数据创建滑动窗口特征,来捕捉数据中的趋势和周期性。

```python

from statsmodels.tsa.api import ExponentialSmoothing, Holt

# 假设time_series_data为时间序列数据

fit1 = ExponentialSmoothing(time_series_data, seasonal='add', seasonal_periods=12).fit()

fit2 = Holt(time_series_data, exponential=True).fit()

# 创建新的特征

time_series_data['Holt_trend'] = fit1.fittedvalues

time_series_data['ExpSmoothing'] = fit2.fittedvalues

```

## 2.3 数据探索与分析

### 2.3.1 描述性统计分析

描述性统计是数据科学中的基础工具,用于获取数据的中心趋势、分散程度和分布形态等信息。在NASA电池数据集中,我们可以利用描述性统计分析来初步了解电池性能的平均表现、变化范围和分布特征。

```python

# 使用pandas库进行描述性统计分析

data_description = data.describe()

# 打印出统计结果

print(data_description)

```

通过上述代码,我们可以得到每列数据的平均值、标准差、最小值、最大值等描述性统计数据。这些信息有助于我们初步判断数据的质量和分布特征。

### 2.3.2 基于统计的异常值检测

异常值检测是识别数据集中偏离正常范围的观测值的过程。在电池数据集分析中,异常值的检测尤其重要,因为异常数据点可能是电池故障或数据收集过程中的错误所致。基于统计的方法,如标准差法、IQR(四分位距)法等,是检测异常值的常用技术。

```python

import numpy as np

# 使用标准差法检测异常值

z_scores = np.abs((data - data.mean()) / data.std())

outliers = z_scores > 3 # 通常认为超过3个标准差的数据点为异常值

# 打印出异常值的位置

print("异常值的位置:", np.where(outliers))

```

通过上述代码,我们可以找出数据中超出3个标准差范围的异常值,并对这些异常值进行进一步的分析和处理。

# 3. 外部资源整合技术

## 3.1 数据源识别与接入

##

0

0