【批处理框架揭秘】Spring Batch:高效数据处理的秘诀与最佳实践

发布时间: 2024-09-22 02:12:39 阅读量: 64 订阅数: 40

Java中批处理框架spring batch详细介绍

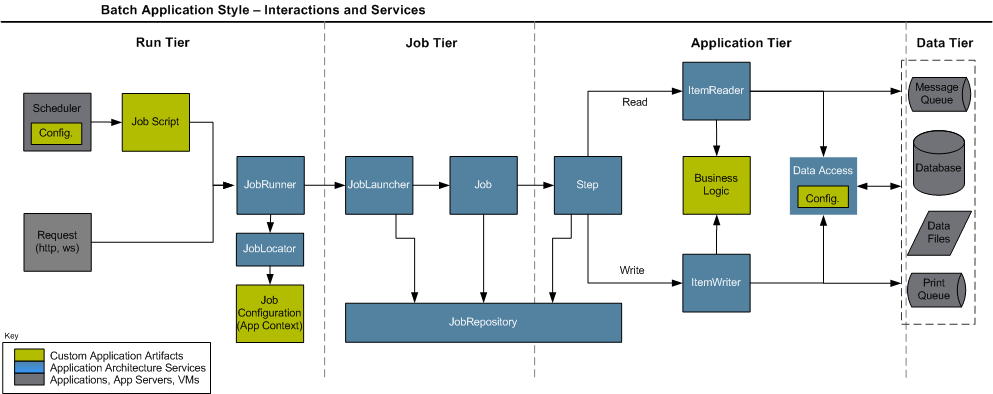

# 1. Spring Batch概述与核心概念

在现代企业IT系统中,批处理操作是必不可少的组件。Spring Batch是一个功能强大的批处理框架,其目的是在企业应用中提供高效、可重复使用的批处理操作。它支持多种类型的批处理作业,从简单到复杂的各种场景都能够应对自如。

## Spring Batch核心组件

Spring Batch主要由以下核心组件构成:

- **Job**:批处理作业的定义,由一系列的步骤(Step)组成。

- **Step**:作业中的一个独立的执行单元,通常包含数据读取、处理和写入的过程。

- **ItemReader**:用于读取数据的接口,可以是数据库查询结果集、文件读取等多种形式。

- **ItemProcessor**:对从ItemReader中读取的每一个数据项进行处理。

- **ItemWriter**:将处理后的数据写入到目的地,如数据库、文件等。

## 批处理的事务管理

事务管理是批处理作业的一个重要方面,确保数据的一致性和可靠性。Spring Batch通过事务管理来控制数据的准确性和完整性,支持对单个步骤或者整个作业的事务管理。

通过理解这些核心概念,我们可以进一步深入探讨如何配置和优化Spring Batch作业,以适应更复杂的业务需求。接下来的章节将详细解析这些组件以及它们如何协同工作来实现高效的批处理任务。

# 2. 批处理框架的基本配置

## 2.1 Spring Batch的依赖管理与环境搭建

### 2.1.1 构建Spring Batch项目结构

创建一个成功的Spring Batch批处理应用首先从建立一个合理的项目结构开始。一个典型的Spring Batch应用包含以下几个关键部分:

- **基础设施层(Infrastructure Layer)**:包含用于定义批处理作业的配置类和bean声明。

- **业务逻辑层(Job Layer)**:包含具体的批处理作业定义,如Job和Step的配置。

- **域模型层(Domain Model Layer)**:定义作业处理过程中用到的数据模型。

- **服务层(Service Layer)**:为批处理作业提供业务逻辑服务。

- **控制器层(Controller Layer)**:如果需要通过Web接口触发批处理作业,将包含相应的控制器。

项目结构通常以Maven或Gradle作为构建工具,Spring Initializr是开始创建Spring Boot和Spring Batch项目的一个很好的起点。

```xml

<!-- example pom.xml snippet -->

<dependencies>

<!-- Spring Boot Starter -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter</artifactId>

</dependency>

<!-- Spring Batch Core -->

<dependency>

<groupId>org.springframework.batch</groupId>

<artifactId>spring-batch-core</artifactId>

</dependency>

<!-- Spring Boot Starter Test for testing -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

</dependencies>

```

### 2.1.2 配置Spring Batch的依赖和启动类

为了设置Spring Batch环境,需要在Spring Boot启动类上添加`@EnableBatchProcessing`注解,这个注解将启用Spring Batch的自动配置。

```java

@SpringBootApplication

@EnableBatchProcessing

public class BatchApplication {

public static void main(String[] args) {

SpringApplication.run(BatchApplication.class, args);

}

}

```

在`application.properties`或`application.yml`文件中配置数据库和其他与Spring Batch相关的属性:

```yaml

spring:

batch:

job:

enabled: true

repositories:

enabled: true

table-prefix: BATCH_

datasource:

url: jdbc:mysql://localhost:3306/batchdb?useSSL=false

username: batchuser

password: batchuser123

```

## 2.2 Spring Batch作业组件解析

### 2.2.1 Job与Step的设计原理

在Spring Batch中,`Job`代表一个批处理作业,通常包含一个或多个`Step`,每一个`Step`代表批处理作业中的一个独立阶段。每个`Step`可以包含读取、处理和写入数据的过程。

设计一个`Job`时,通常遵循以下步骤:

1. 定义`Job`及其属性。

2. 添加`Step`到`Job`中。

3. 为每个`Step`定义`Tasklet`或`Chunk`,即具体的数据处理逻辑。

4. 配置`JobRepository`用于持久化作业执行的状态信息。

```java

@Configuration

public class BatchConfig {

@Autowired

private JobBuilderFactory jobBuilderFactory;

@Autowired

private StepBuilderFactory stepBuilderFactory;

@Bean

public Job job() {

return jobBuilderFactory.get("myJob")

.start(step1())

.next(step2())

.build();

}

@Bean

public Step step1() {

return stepBuilderFactory.get("step1")

.tasklet((contribution, chunkContext) -> {

// Step1的逻辑

return RepeatStatus.FINISHED;

})

.build();

}

@Bean

public Step step2() {

return stepBuilderFactory.get("step2")

.tasklet((contribution, chunkContext) -> {

// Step2的逻辑

return RepeatStatus.FINISHED;

})

.build();

}

}

```

### 2.2.2 任务执行策略与ItemReader

`ItemReader`是Spring Batch中的一个关键组件,它负责从数据源读取数据项,并将每个数据项传递给`ItemProcessor`进行处理。`ItemReader`的设计要能处理大量数据,且易于与数据源交互。

常见的`ItemReader`实现有:

- `JdbcCursorItemReader`:从JDBC查询结果中读取数据。

- `FlatFileItemReader`:读取平面文件(如CSV)的数据。

设计`ItemReader`时,考虑以下要素:

- 需要处理的数据量。

- 数据读取的性能。

- 是否需要断点续处理。

```java

@Bean

public FlatFileItemReader<Item> reader() {

FlatFileItemReader<Item> reader = new FlatFileItemReader<>();

reader.setLinesToSkip(1);

reader.setResource(new FileSystemResource("path/to/input.csv"));

reader.setLineMapper(lineMapper());

return reader;

}

private LineMapper<Item> lineMapper() {

DefaultLineMapper<Item> lineMapper = new DefaultLineMapper<>();

lineMapper.setLineTokenizer(lineTokenizer());

lineMapper.setFieldSetMapper(fieldSetMapper());

return lineMapper;

}

```

### 2.2.3 数据处理与ItemWriter

`ItemWriter`负责将处理过的数据项写入持久化存储,如数据库或文件系统。设计`ItemWriter`时,重点是确保数据的正确性和处理性能。

常用`ItemWriter`实现有:

- `JdbcBatchItemWriter`:批量将数据写入数据库。

- `FlatFileItemWriter`:将数据写入平面文件。

设计`ItemWriter`时要关注:

- 批量插入和事务管理。

- 数据完整性保障。

- 错误处理机制。

```java

@Bean

public JdbcBatchItemWriter<Item> writer() {

JdbcBatchItemWriter<Item> writer = new JdbcBatchItemWriter<>();

writer.setItemPreparedStatementSetter((item, ps) -> {

// 设置预编译语句参数

});

writer.setSql("INSERT INTO items (column1, column2) VALUES (?, ?)");

writer.setDataSource(dataSource);

return writer;

}

```

## 2.3

0

0