MATLAB曲线拟合实战指南:从数据预处理到模型评估,全面掌握曲线拟合

发布时间: 2024-05-25 23:04:19 阅读量: 266 订阅数: 25

MATLAB数据以及曲线拟合

# 1. 曲线拟合概述**

曲线拟合是一种数学技术,用于根据一组数据点找到一条最佳拟合曲线。它在各种领域都有应用,例如数据分析、预测和优化。

曲线拟合的过程涉及几个关键步骤:

1. **数据预处理:**准备数据进行拟合,包括清洗异常值、平滑数据和标准化。

2. **模型选择:**根据数据的特征选择合适的曲线拟合模型,例如线性回归、多项式回归或指数回归。

3. **参数估计:**使用优化算法估计模型参数,以最小化拟合误差。

4. **模型评估:**评估模型的拟合优度和预测能力,并根据需要进行调整。

# 2. 数据预处理

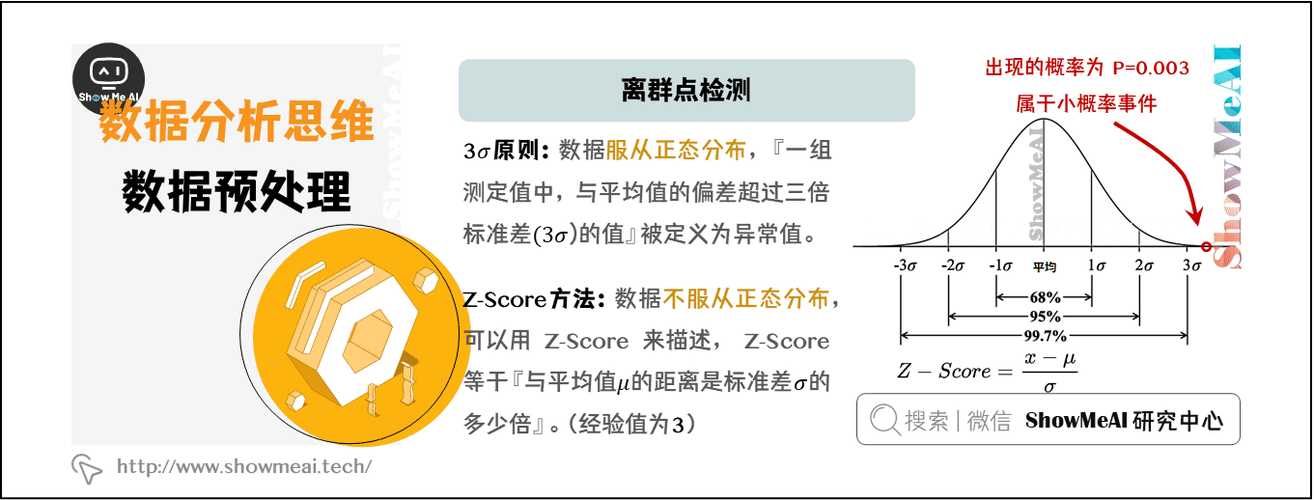

### 2.1 数据清洗和异常值处理

#### 2.1.1 识别和去除异常值

异常值是数据集中明显偏离其他数据点的点。它们可能是由测量错误、数据输入错误或其他异常情况引起的。识别和去除异常值对于准确的曲线拟合至关重要,因为它可以防止异常值对模型参数估计产生不必要的影响。

MATLAB 中识别异常值的一种方法是使用 `isoutlier` 函数。该函数使用基于统计分布的算法来识别异常值。

```matlab

% 导入数据

data = load('data.mat');

% 识别异常值

outliers = isoutlier(data.x);

% 移除异常值

data.x(outliers) = [];

data.y(outliers) = [];

```

#### 2.1.2 数据平滑和插值

数据平滑是去除数据中的噪声和波动的一种技术。这可以通过使用滤波器或插值技术来实现。

MATLAB 中用于数据平滑的常用滤波器是 `smooth` 函数。该函数使用移动平均滤波器来平滑数据。

```matlab

% 数据平滑

smoothed_data = smooth(data.x, 5);

```

插值是估计数据集中缺失值的另一种技术。MATLAB 中用于插值的常用函数是 `interp1` 函数。该函数使用线性插值来估计缺失值。

```matlab

% 数据插值

interpolated_data = interp1(data.x, data.y, new_x_values);

```

### 2.2 数据标准化和归一化

数据标准化和归一化是将数据转换为具有相同范围和分布的技术。这对于确保不同特征在曲线拟合过程中具有同等的重要性非常重要。

#### 2.2.1 标准化方法

标准化将数据转换为均值为 0、标准差为 1 的分布。这可以通过使用 `zscore` 函数来实现。

```matlab

% 数据标准化

standardized_data = zscore(data.x);

```

#### 2.2.2 归一化方法

归一化将数据转换为介于 0 和 1 之间的分布。这可以通过使用 `normalize` 函数来实现。

```matlab

% 数据归一化

normalized_data = normalize(data.x);

```

# 3.1 线性回归模型

#### 3.1.1 最小二乘法

最小二乘法是一种线性回归模型,其目标是找到一组系数,使模型预测值与实际值之间的平方误差最小。数学上,最小二乘法模型可以表示为:

```

y = β0 + β1x + ε

```

其中:

* y 是因变量

* x 是自变量

* β0 和 β1 是模型系数

* ε 是误差项

最小二乘法模型的系数可以通过求解正规方程组来获得:

```

[β0, β1] = (X^T X)^-1 X^T y

```

其中:

* X 是一个包含自变量值的矩阵

* y 是一个包含因变量值的向量

#### 3.1.2 岭回归和套索回归

岭回归和套索回归是两种正则化线性回归模型,它们通过在目标函数中添加正则化项来防止模型过拟合。

**岭回归**的正则化项为:

```

λ Σ(βi^2)

```

其中:

* λ 是正则化参数

* βi 是模型系数

**套索回归**的正则化项为:

```

λ Σ(|βi|)

```

其中:

* λ 是正则化参数

* βi 是模型系数

岭回归和套索回归的系数可以通过求解以下正则化方程组来获得:

```

[β0, β1] = ((X^T X) + λI)^-1 X^T y

```

其中:

* I 是一个单位矩阵

* λ 是正则化参数

岭回归和套索回归的正则化参数 λ 可以通过交叉验证或其他方法来选择。

# 4. 模型评估和验证

### 4.1 模型拟合优度评价

#### 4.1.1 残差分析

残差分析是评估模型拟合优度的重要方法。残差是指实际数据值与模型预测值之间的差值。通过分析残差,我们可以发现模型拟合的不足之处,并对模型进行改进。

残差分析常用的方法包括:

* **残差图:**将残差值绘制成散点图,观察残差是否随机分布。如果残差呈随机分布,则表明模型拟合较好。

* **正态分布检验:**检验残差是否服从正态分布。如果残差服从正态分布,则表明模型拟合较好。

* **自相关检验:**检验残差之间是否存在自相关。如果残差之间存在自相关,则表明模型拟合存在问题。

#### 4.1.2 相关系数和决定系数

相关系数和决定系数是衡量模型拟合优度的两个重要指标。

* **相关系数:**衡量实际数据值与模型预测值之间的相关性。相关系数取值范围为[-1, 1],其中1表示完全正相关,-1表示完全负相关,0表示无相关性。

* **决定系数:**衡量模型预测值对实际数据值解释的方差比例。决定系数取值范围为[0, 1],其中1表示模型可以完全解释数据方差,0表示模型无法解释任何数据方差。

### 4.2 模型预测能力评价

#### 4.2.1 交叉验证

交叉验证是一种评估模型预测能力的常用方法。交叉验证将数据集划分为多个子集,依次使用每个子集作为验证集,其余子集作为训练集。通过多次交叉验证,可以得到模型的平均预测误差。

交叉验证常用的方法包括:

* **k折交叉验证:**将数据集划分为k个子集,依次使用每个子集作为验证集,其余k-1个子集作为训练集。

* **留一法交叉验证:**将数据集划分为n个子集,依次使用每个子集作为验证集,其余n-1个子集作为训练集。

#### 4.2.2 独立数据集验证

独立数据集验证是评估模型预测能力的另一种方法。独立数据集验证使用一个与训练集完全不同的数据集来评估模型的预测能力。通过独立数据集验证,可以得到模型在实际应用中的预测误差。

独立数据集验证的步骤如下:

1. 将数据集划分为训练集和测试集。

2. 使用训练集训练模型。

3. 使用测试集评估模型的预测能力。

# 5. MATLAB实战应用

### 5.1 数据导入和预处理

#### 5.1.1 数据文件读取

```

% 导入数据文件

data = csvread('data.csv');

% 查看数据前五行

head(data)

```

**代码逻辑:**

- `csvread` 函数读取 CSV 文件并将其存储在 `data` 变量中。

- `head` 函数显示数据的前五行,以便查看数据结构。

#### 5.1.2 数据清洗和异常值处理

```

% 识别和去除异常值

outliers = isoutlier(data(:, 2));

data(outliers, :) = [];

% 数据平滑

data(:, 2) = smooth(data(:, 2));

```

**代码逻辑:**

- `isoutlier` 函数识别数据第二列中的异常值(outlier)。

- `data(outliers, :) = []` 删除包含异常值的行。

- `smooth` 函数平滑数据第二列,去除噪声。

### 5.2 模型拟合和评估

#### 5.2.1 线性回归模型拟合

```

% 线性回归模型拟合

model = fitlm(data(:, 1), data(:, 2));

% 查看模型摘要

summary(model)

```

**代码逻辑:**

- `fitlm` 函数拟合一个线性回归模型,其中数据第一列为自变量,第二列为因变量。

- `summary` 函数显示模型摘要,包括回归系数、R 平方和 p 值。

#### 5.2.2 非线性回归模型拟合

```

% 多项式回归模型拟合

poly_model = fitlm(data(:, 1), data(:, 2), 'poly2');

% 指数回归模型拟合

exp_model = fitlm(data(:, 1), data(:, 2), 'exp');

```

**代码逻辑:**

- `fitlm` 函数拟合一个多项式回归模型,其中 `'poly2'` 指定二次多项式。

- `fitlm` 函数拟合一个指数回归模型,其中 `'exp'` 指定指数模型。

# 6. 曲线拟合高级技巧

### 6.1 正则化和特征选择

**6.1.1 正则化方法**

正则化是一种技术,用于防止模型过拟合。它通过在目标函数中添加一个惩罚项来实现,该惩罚项与模型系数的大小成正比。常见的正则化方法包括:

- **L1 正则化(套索回归):**惩罚系数的绝对值。它倾向于产生稀疏解,其中许多系数为零。

- **L2 正则化(岭回归):**惩罚系数的平方。它倾向于产生更稳定的解,其中所有系数都不为零。

**6.1.2 特征选择算法**

特征选择是一种技术,用于选择与目标变量最相关的特征。它可以提高模型的性能并减少过拟合。常见的特征选择算法包括:

- **过滤式方法:**基于特征的统计属性(如方差、相关性)对特征进行评分和排名。

- **包装式方法:**迭代地添加或删除特征,以优化模型性能。

- **嵌入式方法:**将特征选择过程嵌入到模型训练过程中,例如 L1 正则化。

### 6.2 模型集成和交叉验证

**6.2.1 模型集成方法**

模型集成是一种技术,用于通过组合多个模型来提高预测性能。常见的模型集成方法包括:

- **Bagging(Bootstrap 聚合):**从训练数据集中抽取多个有放回的样本,并训练多个模型。预测时,将每个模型的预测进行平均。

- **Boosting(提升):**顺序训练多个模型,每个模型都专注于前一个模型的错误。预测时,将每个模型的预测加权求和。

- **Stacking(堆叠):**将多个模型的预测作为输入,训练一个元模型来进行最终预测。

**6.2.2 交叉验证策略**

交叉验证是一种评估模型性能和选择超参数的技术。它将训练数据集划分为多个子集(折),并使用不同的折进行模型训练和评估。常见的交叉验证策略包括:

- **k 折交叉验证:**将数据集划分为 k 个折,每次使用 k-1 个折进行训练,1 个折进行评估。

- **留一法交叉验证:**将数据集划分为 n 个折(n 为数据集大小),每次使用 n-1 个折进行训练,1 个折进行评估。

- **蒙特卡罗交叉验证:**随机抽取多个样本子集进行训练和评估。

0

0