Python爬虫实战:从基础到高级爬虫技巧,获取网络数据

发布时间: 2024-06-19 05:08:12 阅读量: 93 订阅数: 45

# 1. Python爬虫基础

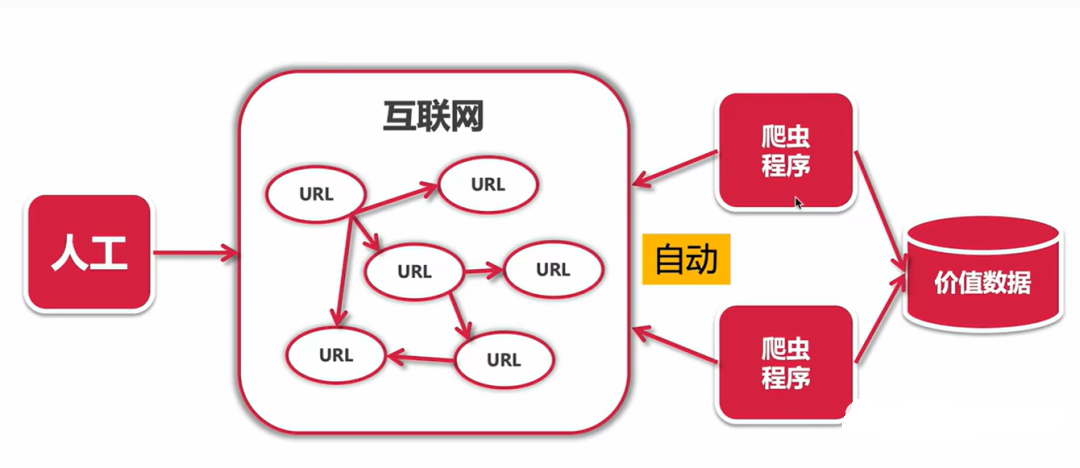

Python爬虫是一种使用Python语言编写的自动化工具,用于从网络上获取数据。它可以模拟人类浏览器的行为,访问网站并提取所需信息。

### 1.1 爬虫的分类和选择

根据爬虫的目标和实现方式,可以将其分为以下几类:

- **网络爬虫:**用于爬取网页内容,如文本、图片、链接等。

- **数据爬虫:**用于从数据库或API接口中提取数据。

- **特殊场景爬虫:**针对特定场景设计的爬虫,如图片爬虫、视频爬虫等。

选择合适的爬虫类型对于成功获取数据至关重要。

# 2. Python爬虫编程技巧

### 2.1 爬虫架构与设计

#### 2.1.1 爬虫的分类和选择

**爬虫分类**

爬虫可按以下标准分类:

| 分类 | 描述 |

|---|---|

| 广度优先爬虫 | 优先抓取当前网页的所有链接,再逐层深入 |

| 深度优先爬虫 | 优先抓取当前网页最深层的链接,再返回抓取较浅层的链接 |

| 增量爬虫 | 只抓取上次爬取后更新的网页 |

| 实时爬虫 | 实时抓取网页,适用于数据变化频繁的场景 |

**爬虫选择**

选择合适的爬虫类型取决于爬取目标和数据更新频率:

* **广度优先爬虫:**适用于需要全面抓取网站所有页面的场景,如网站地图生成。

* **深度优先爬虫:**适用于需要优先抓取特定内容的场景,如新闻爬取。

* **增量爬虫:**适用于需要定期更新数据的场景,如商品价格监控。

* **实时爬虫:**适用于需要实时获取数据的场景,如股票行情监控。

#### 2.1.2 爬虫架构设计原则

**解耦与模块化**

* 将爬虫功能拆分成独立模块,如数据抓取、数据清洗、数据存储等。

* 模块之间通过接口进行交互,提高代码可维护性和复用性。

**可扩展性**

* 设计爬虫时考虑未来扩展需求,如支持多线程、分布式等。

* 采用松耦合架构,方便添加或修改功能模块。

**容错性**

* 考虑爬虫在网络异常、数据格式变化等情况下的容错处理。

* 使用重试机制、错误处理机制等保证爬虫的稳定性。

**代码示例**

```python

import requests

from bs4 import BeautifulSoup

def crawl_page(url):

try:

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

return soup

except Exception as e:

print(f'Error crawling page: {e}')

return None

```

**代码逻辑分析**

* `crawl_page()` 函数用于抓取指定 URL 的网页内容。

* 使用 `requests` 库发送 HTTP 请求,获取网页响应。

* 使用 `BeautifulSoup` 库解析 HTML 内容,并返回解析后的对象。

* 如果抓取过程中出现异常,打印错误信息并返回 `None`。

### 2.2 爬虫数据处理

#### 2.2.1 数据清洗与预处理

**数据清洗**

* 去除 HTML 标签、特殊字符等无关数据。

* 转换数据类型,如将字符串转换为数字。

* 补全缺失值,如使用平均值或众数填充。

**数据预处理**

* 分词、词干化等文本处理技术。

* 特征提取、降维等数据挖掘技术。

**代码示例**

```python

import re

def clean_html(html):

cleaned = re.sub('<.*?>', '', html) # 去除 HTML 标签

cleaned = re.sub('[^\w\s]', '', cleaned) # 去除特殊字符

return cleaned

```

**代码逻辑分析**

* `clean_html()` 函数用于清洗 HTML 内容。

* 使用正则表达式去除 HTML 标签和特殊字符。

* 返回清洗后的文本内容。

#### 2.2.2 数据存储与管理

**数据存储**

* 关系型数据库:MySQL、PostgreSQL 等。

* 非关系型数据库:MongoDB、Redis 等

0

0