【信息化系统数据流分析】:数据流动的艺术与科学

发布时间: 2024-12-28 20:12:17 阅读量: 38 订阅数: 40

# 摘要

信息化系统中数据流的高效管理和优化对于系统的稳定性和性能至关重要。本文首先概述了数据流的基本概念及其在信息系统中的重要性,进而从理论和实证两个维度深入分析数据流的模型、流动特性、优化策略、监控技术和安全合规性问题。通过案例研究,本文揭示了数据流监控与异常处理的实践方法,并探讨了数据流管理系统的架构设计及其集成与重构策略。文章最后展望了数据流分析的未来趋势,重点关注人工智能技术的融入、跨学科应用的挑战以及相关的伦理法律问题。本文旨在为信息化系统的数据流管理提供理论支持和实践指导。

# 关键字

数据流模型;流量管理;瓶颈分析;数据安全性;自动化监控;人工智能;跨学科应用;伦理法律问题

参考资源链接:[信息化系统建设方案全攻略:模板、设计与实施要点](https://wenku.csdn.net/doc/72wdb0hu0q?spm=1055.2635.3001.10343)

# 1. 信息化系统中的数据流概述

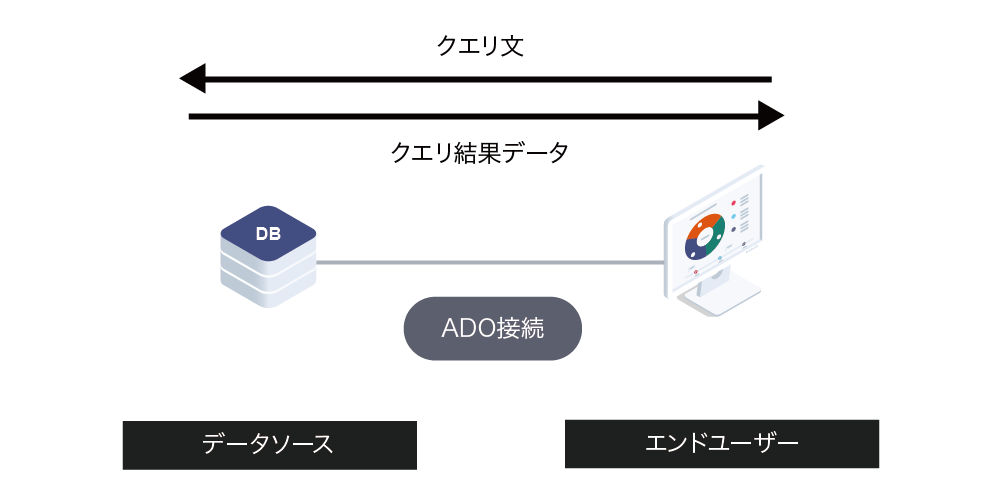

信息化系统是一个充满活力的组织体,其中数据流是其生命之血。数据流可以定义为在系统内部或系统间流动的数据,它携带信息,支持决策制定,驱动业务流程,以及实现组织目标。从简单的表单输入到复杂的云计算环境中的大数据分析,数据流在每一个环节都扮演着重要角色。

在这一章节中,我们将探讨数据流的定义,了解它如何在信息化系统中流通,并审视其在组织中的价值和作用。同时,我们会简要介绍数据流管理和优化的重要性,为接下来的章节内容打下坚实的基础。信息化系统的高效运转依赖于数据流的无缝整合与高效传递,因此掌握数据流的基本概念是构建强大IT基础设施的关键。接下来,我们将深入探讨数据流的理论基础和应用实践,带领读者进入数据流管理的精彩世界。

# 2. 数据流的理论基础

在信息化系统中,数据流是信息流动的脉络,对系统的运行效率和数据分析的深度有着深远的影响。为了深入理解数据流,我们必须首先掌握其理论基础。本章节将探讨数据流模型的解析、数据流动性的理论框架以及数据流优化理论三个主要方面。

### 2.1 数据流模型解析

数据流模型是理解和设计信息系统中数据流动路径的关键。本小节将专注于数据流图的理解与绘制以及数据流图在系统分析中的应用。

#### 2.1.1 数据流图的理解与绘制

数据流图(DFD)是一种图形化工具,用于表示系统中数据的流动、数据的输入与输出以及数据存储。DFD不仅有助于系统分析师与利益相关者之间的沟通,而且对于理解系统的动态行为至关重要。

绘制DFD的基本步骤如下:

1. **定义上下文**:首先确定系统的边界,并用一个高级的DFD(也称为0级DFD)来表示整个系统。

2. **分解过程**:在更详细的一级DFD中,将系统分解为多个子过程,并标明它们之间的数据流。

3. **细化数据流和存储**:确定数据流的来源和去向,以及系统中必要的数据存储。

4. **迭代细化**:递归地应用上述步骤,为每个子过程创建更详细的DFD,直到满足需求为止。

```mermaid

graph TD;

A[系统入口] -->|数据输入| B[处理过程]

B -->|中间数据流| C[进一步处理]

C -->|输出数据流| D[系统出口]

```

#### 2.1.2 数据流图在系统分析中的应用

数据流图能够清晰地表达系统内部工作逻辑,被广泛应用于需求分析、系统设计及文档编制等环节。在需求分析阶段,DFD帮助分析师理解用户需求和业务流程;在系统设计阶段,DFD则是构建系统架构和组件之间交互的基础;在文档编制阶段,DFD是向开发人员、测试人员及最终用户传达系统设计意图的有效工具。

### 2.2 数据流动性的理论框架

数据流动性涉及数据在系统中的传输和存储,主要关注流量、流向和速率,以及数据的生命周期管理。

#### 2.2.1 流量、流向与速率的概念

- **流量**:指单位时间内通过某一路径或系统的数据量。

- **流向**:数据在系统中传输的方向。

- **速率**:数据流传输的快慢,通常用流量来衡量。

理解这三个概念有助于掌握数据流动的动态特性,为性能调优和资源分配提供依据。

#### 2.2.2 数据生命周期与流动性分析

数据生命周期包括数据的创建、存储、使用、迁移和销毁。流动性的分析不仅关注数据流的即时状态,也需关注数据在整个生命周期内的运动变化。

### 2.3 数据流优化理论

数据流的优化旨在提升系统性能,减少延迟,提高数据处理和传输的效率。

#### 2.3.1 瓶颈分析与系统性能优化

瓶颈分析关注于查找系统中的性能短板,并针对性地进行优化。常见的优化策略包括:

- **负载均衡**:在多个资源间合理分配工作负载,避免单点过载。

- **资源升级**:提高系统中瓶颈资源的性能,如升级服务器硬件。

- **算法优化**:改进数据处理算法,减少不必要的数据流转。

```python

# 示例代码:Python中的简单负载均衡机制

def simple_load_balancer(workloads):

# 对工作负载进行排序

sorted_workloads = sorted(workloads, reverse=True)

# 分配工作负载到资源

for resource in range(len(sorted_workloads)):

print(f"Resource {resource} is allocated {sorted_workloads[resource]} workload.")

```

#### 2.3.2 数据流的并行处理与事务管理

并行处理和事务管理是提高数据流处理速度的关键技术。并行处理允许同一任务的多个实例同时运行,而事务管理则确保数据的一致性和完整性。

- **并行处理**:利用多核处理器或多节点计算资源,并行执行数据流中的任务。

- **事务管理**:通过ACID(原子性、一致性、隔离性、持久性)原则管理数据流中的事务,保证数据的正确性。

在本章中,我们深入探讨了数据流的理论基础,涵盖了数据流模型的解析、流动性框架的建立,以及如何通过优化提高数据流性能。理解这些概念为处理真实世界的数据流问题提供了坚实的基础。在下一章中,我们将进入数据流的实证分析与案例研究,看看这些理论是如何应用于实际问题解决的。

# 3. 数据流的实证分析与案例研究

## 3.1 数据流的监控与追踪技术

### 3.1.1 实时数据流追踪工具与技术

随着信息技术的快速发展,实时数据流追踪成为了系统监控中的一个核心需求。企业在开发、部署以及运维的过程中,对数据流进行实时监控和追踪,能够确保数据处理的透明度和及时性,进而提高整个系统的反应速度和安全性。为了实现这一目标,许多企业开始采用先进的追踪工具和技术。

实时数据流追踪工具通常包括日志管理、事件追踪和性能分析等功能。例如,使用如Apache Kafka这样的分布式流处理平台,可以为高吞吐量的数据提供实时处理能力。另外,ELK(Elasticsearch, Logstash, Kibana)技术栈也常用于日志聚合、搜索、可视化,实现数据流的实时监控。

在技术层面,实时数据流追踪往往依赖于消息队列和流处理框架,这些技术能够保证数据的实时流动,并在必要时进行消息的持久化处理。像Apache Pulsar、Apache Flink等,都是在数据流追踪方面有着广泛应用的技术。

### 3.1.2 数据流监控的可视化展现

可视化是数据流监控不可或缺的一环,因为数据的直观展示有助于快速识别和解决问题。在这一部分,我们主要介绍几种常见的数据流监控可视化工具和技术。

Kibana是Elastic Stack中的一个组件,它可以将存储在Elasticsearch中的数据进行可视化。Kibana提供各种图表和仪表板,帮助用户直观地了解数据流的状态和趋势。用户可以定制

0

0