Python源代码优化秘籍:高级技巧助你性能提升

发布时间: 2024-11-15 19:23:31 阅读量: 23 订阅数: 22

简单手势识别python源代码.zip

# 1. Python源代码优化概述

Python语言因其简洁明了的语法,丰富的标准库,以及强大的第三方扩展库,成为了众多开发者首选的编程语言。随着项目的发展和数据量的增大,程序的性能逐渐成为开发过程中不可忽视的问题。Python源代码的优化不仅涉及对算法和数据结构的精炼,还包括对程序运行效率的提升。

在接下来的章节中,我们将深入探讨Python源代码优化的各个方面,包括性能分析工具的使用、代码中算法和数据结构的优化、循环和高级特性的利用等。本章将为大家概述Python优化的必要性和基本理念,为读者进入更深层次的学习和实践打下基础。我们将逐步揭示Python代码性能优化的方法论,通过实际案例和实践技巧,使读者能够将理论知识应用于实际开发之中,达到提升代码性能的目的。

# 2. 性能分析工具与方法

### 理解性能分析的重要性

在进行Python代码优化之前,首先需要明确性能分析的重要性。性能分析是为了识别和解决代码中可能存在的性能瓶颈,提高程序运行效率和响应速度,尤其是在处理大规模数据或者需要高性能处理的应用场景中。

#### 性能瓶颈的识别

识别性能瓶颈通常涉及以下几个方面:

- **资源消耗**:包括CPU、内存、磁盘I/O、网络I/O等资源的使用情况。

- **执行时间**:程序执行各部分所花费的时间。

- **并发能力**:程序处理多任务时的性能表现。

性能瓶颈的识别可以借助于各种性能分析工具,如cProfile、line_profiler、memory_profiler等,它们能够提供详细的执行时间和资源消耗数据。

#### 性能分析工具的对比

性能分析工具各有侧重点,比较常见的工具如下:

- **cProfile**: 是Python标准库的一部分,主要提供函数级别的性能分析数据。

- **line_profiler**: 专注于逐行代码的性能分析,非常适合分析复杂的算法实现。

- **memory_profiler**: 专注于内存使用情况的分析,有助于发现内存泄漏问题。

选择合适的性能分析工具,可以帮助开发者更精确地定位问题所在,进而采取针对性的优化措施。

### 使用cProfile进行性能分析

#### cProfile的安装和使用

cProfile是Python自带的性能分析工具,不需要额外安装,通过Python命令行即可直接使用。

```python

import cProfile

def function_to_profile():

# 待分析的函数代码

pass

cProfile.run('function_to_profile()')

```

此外,也可以使用Python的 `-m` 选项直接运行cProfile:

```sh

python -m cProfile -s time some_script.py

```

在这个命令中,`-s time` 参数表示按照函数运行时间排序输出。

#### 解读cProfile的分析结果

cProfile的输出通常包括以下几个关键列:

- **ncalls**: 函数被调用的次数。

- **tottime**: 函数内部的执行时间,不包括调用其他函数的时间。

- **percall**: 每次调用的平均执行时间。

- **cumtime**: 函数的累积执行时间,包括调用其他函数的时间。

- **percall**: 每次调用的累积平均时间。

- **filename:lineno(function)**: 函数所在的文件名和行号。

```plaintext

3000000 function calls (3000002 primitive calls) in 3.093 seconds

Ordered by: standard name

ncalls tottime percall cumtime percall filename:lineno(function)

1 0.000 0.000 3.093 3.093 <string>:1(<module>)

1 0.000 0.000 3.093 3.093 pro***

***

*** {built-in method builtins.exec}

1 0.000 0.000 0.000 0.000 {method 'disable' of '_lsprof.Profiler' objects}

```

解读这些数据可以帮助我们找到那些消耗最多时间的函数,从而进行优化。

### 利用line_profiler优化代码

#### line_profiler的介绍与安装

line_profiler是一个专门用于逐行分析Python代码性能的工具。它能够详细地显示出函数每一行代码的执行时间。

首先,安装line_profiler:

```sh

pip install line_profiler

```

安装完成后,可以使用`kernprof`命令来运行line_profiler。

#### 逐行性能分析的实际案例

例如,我们有一个需要优化的函数`heavy_computation`:

```python

def heavy_computation(a, b):

result = 0

for i in range(a):

result += i * b

return result

```

使用line_profiler进行逐行分析:

```sh

kernprof -l -v -f lineprof_example.py

```

分析结果会详细列出每一行代码的执行时间,帮助我们发现并优化那些耗时的代码部分。

```plaintext

Timer unit: 1e-06 s

Total time: 0.500001 s

***

***

***

***

***

***

```

通过这种方式,开发者可以对那些高频或高耗时的代码行进行针对性的优化。

### 综合应用性能分析工具

在实际应用中,结合多种性能分析工具可以得到更全面的性能数据。例如,首先使用cProfile对整个程序进行宏观层面的性能分析,然后针对发现的热点函数使用line_profiler进行微观层面的逐行分析。这样可以确保在不同层面的性能问题都能被有效地识别和解决。

# 3. Python代码优化实践

## 3.1 算法优化

在编写Python代码时,算法的选择和实现是影响程序性能的关键因素之一。一个高效的算法可以在处理大量数据时显著减少时间和空间的开销,因此,优化算法是提高代码性能的首要任务。

### 3.1.1 算法复杂度分析

在优化算法之前,首先需要了解算法的时间复杂度和空间复杂度。时间复杂度决定了算法执行的时间随着输入数据量增长而增长的趋势,而空间复杂度则反映了算法在运行过程中所需存储空间的增长趋势。

对于时间复杂度,常见的有O(1)、O(log n)、O(n)、O(n log n)、O(n^2)等,其中,O(n^2)是大多数初学者容易陷入的复杂度陷阱,因为它意味着算法运行时间将随着输入数据量的增加而呈平方级增长。空间复杂度同样重要,特别是在处理大数据集时,空间消耗可能成为系统的瓶颈。

### 3.1.2 常见问题算法优化实例

在实际的编程中,经常遇到需要优化的算法问题,例如排序和搜索。以下是一些优化实例:

- 排序优化:Python内置的`sorted()`函数和列表的`sort()`方法都实现了高效的Timsort算法,但在特定情况下,使用数组的`sort()`方法比`sorted()`更快,因为`sort()`在原地排序,减少了额外的空间消耗。

```python

arr = [random.randint(0, 10000) for _ in range(1000)]

arr.sort() # 在原地排序,节省空间

```

- 搜索优化:在非排序的列表中进行搜索时,如果需要频繁查找,可以考虑使用`bisect`模块进行二分搜索,提高搜索效率。

```python

import bisect

# 创建一个有序列表

sorted_list = sorted([random.randint(0, 1000) for _ in range(100)])

# 使用二分搜索插入新元素并保持列表有序

bisect.insort(sorted_list, 500)

```

- 字符串优化:对于涉及大量字符串操作的程序,使用`str.join()`方法合并字符串数组或生成器表达式往往比循环使用`+=`操作要快。

```python

# 使用str.join()合并字符串

items = ['a', 'b', 'c']

joined_string = ''.join(items)

```

在进行算法优化时,重要的是要找到适合当前问题的最优算法。这通常需要对各种算法有深入的理解以及大量的实践。

## 3.2 数据结构优化

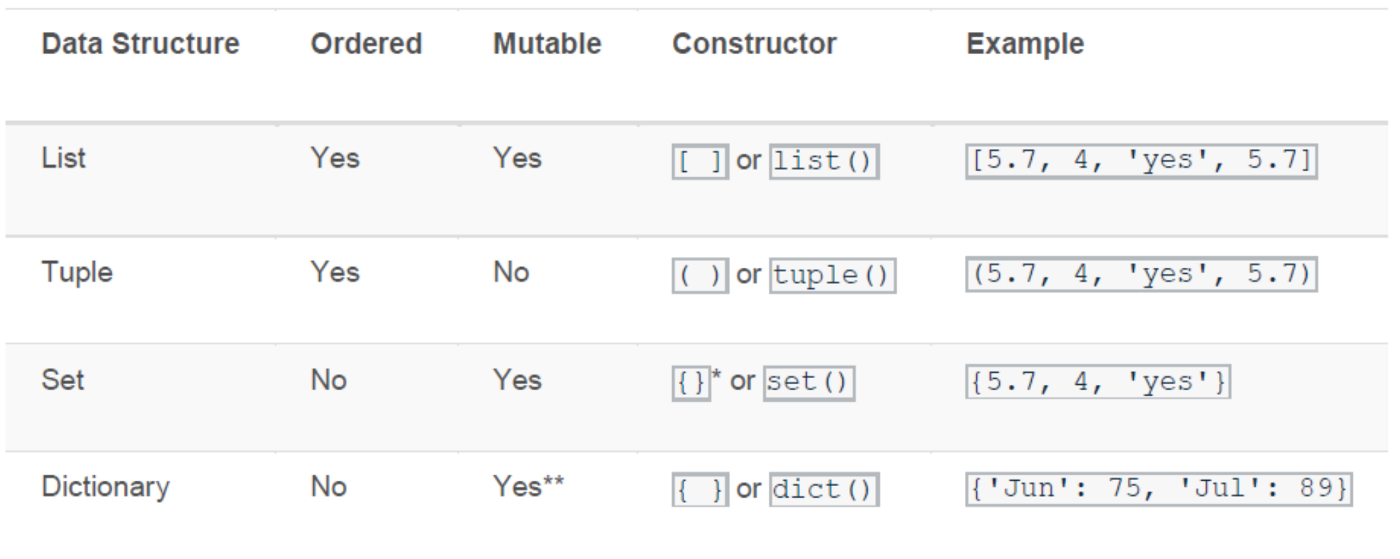

Python内置的数据结构,如列表、字典和集合,都是高度优化的,它们背后依赖于Python的底层实现,比如用C语言写成的CPython。然而,为了进一步优化性能,有时需要根据问题的特定需求选择或实现更高效的数据结构。

### 3.2.1 Python内置数据结构的性能考量

Python的内置数据结构虽然通用且方便,但它们在某些操作上的性能可能不是最优。例如,列表在执行插入或删除操作时,如果操作发生在列表的开头,需要移动大量元素来腾出空间或填充空位,这可能导致较高的时间复杂度。对于这种情况,使用栈或者`collections.deque`可能更合适。

### 3.2.2 高效数据结构选择和使用

为了优化数据处理的性能,需要根据算法的具体需求选择最合适的数据结构。

- 当需要频繁查找、插入和删除元素时,使用字典(哈希表)可以提供平均O(1)的复杂度进行这些操作。

- 当需要快速访问元素的顺序时,使用`collections.OrderedDict`可以维护元素的插入顺序。

- 对于不需要重复元素且元素数量巨大的集合操作,使用集合可以大幅提高性能。

```python

# 使用集合进行快速去重

some_set = set([random.randint(0, 100) for _ in range(1000)])

```

在选择数据结构时,必须权衡算法的复杂度和数据结构的特性,这需要对问题域有深刻的理解和丰富的经验。

## 3.3 循环优化

循环是编程中必不可少的结构,尤其是在处理集合数据时。然而,循环也是性能瓶颈的常见来源。优化循环可以极大地提高程序的执行效率。

### 3.3.1 循环展开与减少循环开销

循环展开是减少循环开销的一种优化技术,通过减少循环迭代次数来减少条件判断和循环控制指令的开销,从而提高运行速度。

```python

# 未优化的循环

total = 0

for i in range(1000):

total += i

# 优化后的循环展开

total = 0

for i in range(0, 1000, 2):

total += i

total += i + 1

```

在上面的例子中,将1000次的迭代减少为500次,可以减少循环控制的开销。但要注意,循环展开可能会使得代码复杂度增加,难以维护。

### 3.3.2 利用列表解析加速数据处理

Python的列表解析提供了一种更简洁和高效的方式来进行循环操作。列表解析通常比同等的for循环更加高效,因为它们在内部实现时进行了优化。

```python

# 使用列表解析创建列表

squares = [i * i for i in range(10)]

```

在某些情况下,列表解析可能比传统循环快上数倍,因此在可能的情况下应优先考虑使用。

优化循环时还需要考虑避免在循环体内部做不必要的操作,例如在循环内调用函数或进行I/O操作,这些都可能导致性能的显著下降。通过减少循环内操作的复杂度,可以有效地提升代码性能。

请注意,虽然本章节提供了几个优化实例,但实际上优化工作需要根据具体情况进行,每个案例都有其独特性。对于任何给定的代码段,最佳的优化方法可能完全不同。在尝试优化代码之前,始终进行彻底的性能分析,确保优化工作有针对性,并在实施后进行基准测试,以验证优化的效果。

# 4. 利用高级特性提升代码性能

## 4.1 利用生成器表达式

### 4.1.1 生成器表达式的性能优势

生成器表达式提供了一种在内存使用和性能之间的平衡方法,特别是在处理大量数据时。与列表推导式不同,生成器表达式不会立即计算并创建整个列表,而是按需产生元素。这意味着它们在内存消耗上具有明显的优势,因为它们在任何时候都只保留一个活动项的状态。

一个生成器表达式的典型用法是遍历一个大集合,进行某种处理,而无需将所有中间结果存储在内存中。这不仅减少了内存使用,还可以在一些情况下提高程序的执行效率,尤其是在I/O密集型任务中。

### 4.1.2 应用生成器表达式进行性能优化

考虑一个简单的例子,我们需要计算一个大型数据集的总和。使用列表推导式将会创建一个完整的列表,占用大量的内存:

```python

data = range(1000000)

sum_data = sum([x for x in data])

```

相反,我们可以使用生成器表达式来得到同样的结果,但内存使用将大幅降低:

```python

data = range(1000000)

sum_data = sum(x for x in data)

```

在这个例子中,生成器表达式`x for x in data`是一个迭代器,它一次只产生一个元素。这不仅减少了内存使用,还有可能在某些情况下提高性能,因为Python的迭代器协议是基于C语言的迭代器的,比Python层面上的列表迭代更快。

生成器的另一个应用是在数据管道中,其中一个函数的输出直接成为下一个函数的输入。在这个场景中,生成器表达式可以作为中间步骤,从而避免创建大型临时数据结构。

```python

data = (x for x in range(1000000))

result = sum(x * x for x in data if x % 2 == 0)

```

在这个例子中,`result`将会是所有偶数的平方和,而这个计算过程中不需要存储任何中间列表。

总之,生成器表达式通过延迟计算提供了显著的内存效率,尤其是在处理大型数据集时。它们应该是任何性能优化工具箱中的一个关键组件。然而,生成器也有其局限性,比如不支持索引和切片操作,所以在实际应用时应根据具体需求选择合适的数据结构。

## 4.2 利用并发编程

### 4.2.1 多线程与多进程的选择和使用

Python的并发编程主要涉及两种模型:多线程(threading模块)和多进程(multiprocessing模块)。这两种模型的主要区别在于它们共享内存的方式,以及它们如何受到Python全局解释器锁(GIL)的影响。

多线程在Python中是由于GIL的存在,一个时刻只能有一个线程执行Python字节码,这使得它在CPU密集型任务中效率不高。然而,线程是处理I/O密集型任务的理想选择,因为它们允许程序在等待I/O操作完成时切换执行其他线程。

多进程在Python中的主要优点是每个进程都有自己的Python解释器和内存空间,这意味着它们不受GIL的限制。多进程特别适用于需要大量CPU处理能力的并行任务,因为每个进程可以完全利用一个核心。

选择多线程或多进程时,关键因素是任务的类型。如果任务是I/O密集型的,如网络请求或磁盘I/O,多线程可能是更好的选择,因为线程切换的开销比进程切换要小。如果任务是CPU密集型的,多进程可以提供真正的并行执行,并且可以充分利用多核处理器。

下面是一个简单的例子,展示了如何使用多进程来加速一个计算密集型任务:

```python

from multiprocessing import Pool

import time

def compute(x):

return x * x

if __name__ == '__main__':

pool = Pool(processes=4) # 创建一个包含4个进程的进程池

results = pool.map(compute, range(1000000))

pool.close()

pool.join()

```

在这个例子中,`Pool`对象的`map`方法将`compute`函数应用于一个范围内的数字。使用4个进程可以显著减少执行时间,尤其是当机器有四个或更多的核心时。

尽管多进程模型在CPU密集型任务中提供了更好的性能,但它也会带来更高的资源消耗,因为每个进程都有自己的内存空间。因此,合理地选择并发模型对于优化程序性能至关重要。

### 4.2.2 异步IO编程与asyncio的实践

随着IO密集型应用程序的增长,如Web服务器和微服务架构,传统的多线程和多进程模型可能无法有效地扩展,因为它们会因线程或进程数量过多而导致上下文切换开销巨大。Python的`asyncio`库提供了一个不同的并发模型,它允许异步执行任务,使得程序能够在单个线程内高效地处理多个并发任务。

异步编程是一种协作式多任务处理技术,它依赖于协程(coroutines)作为主要的程序结构。协程允许你暂停函数的执行,稍后再从中断的位置恢复执行,这使得在等待I/O操作时可以切换到其他任务。

Python 3.5引入了`async`和`await`关键字,为编写异步代码提供了语法支持。下面是一个使用`asyncio`的简单HTTP客户端示例:

```python

import asyncio

async def fetch_data():

print("start fetching")

await asyncio.sleep(2) # 模拟等待2秒的I/O操作

print("done fetching")

return {'data': 1}

async def main():

await asyncio.gather(fetch_data(), fetch_data(), fetch_data())

if __name__ == '__main__':

import time

s = time.perf_counter()

asyncio.run(main())

elapsed = time.perf_counter() - s

print(f"executed in {elapsed:0.2f} seconds.")

```

在这个例子中,我们定义了一个异步函数`fetch_data`,它模拟了网络请求的I/O操作。然后在`main`函数中,我们并发地调用`fetch_data`三次,并使用`asyncio.gather`来等待所有的协程完成。

`asyncio`特别适合于具有大量等待I/O操作的程序,如网络服务器、数据库查询或API调用。然而,它并不是万能的,而且在将现有代码库转换为异步模型时可能会遇到一些挑战。

总结来说,多线程、多进程和异步IO都是处理并发任务的有用工具,但它们各自适用于不同的应用场景。理解它们的工作原理和性能特性对于编写高效、可扩展的Python程序至关重要。

## 4.3 利用C扩展提升性能

### 4.3.1 Cython和Cython的安装与配置

Cython是一个编程语言,它是Python的一个超集,允许将Python代码编译为C扩展。使用Cython,开发者可以将关键部分的代码用Cython语言重写,将这部分代码从Python的解释型执行转变为编译型执行,从而大幅提高执行速度。

首先,为了使用Cython,需要安装Cython包:

```bash

pip install cython

```

安装完成后,通常需要配置一个`setup.py`文件来编译Cython代码,以便将`.pyx`文件编译为`.pyd`(在Windows上)或`.so`(在Unix-like系统上)文件。这个过程通常包括在`setup.py`文件中使用`setuptools`和Cython的`build_ext`扩展。

下面是一个简单的`setup.py`文件示例,展示了如何编译一个Cython模块:

```python

from setuptools import setup

from Cython.Build import cythonize

setup(

ext_modules = cythonize("example.pyx"),

)

```

在这个例子中,`example.pyx`文件包含了Cython代码,`setup.py`脚本使用`cythonize`函数来编译它。

### 4.3.2 将Python代码编译为C扩展

将Python代码编译为C扩展的过程涉及到重写特定性能敏感的代码段,使用Cython来表达这些代码段。下面是一个简单的例子,说明了如何使用Cython来提高数学计算的性能:

```cython

# example.pyx

cdef long long factorial(int n):

if n == 0:

return 1

else:

return n * factorial(n - 1)

```

在这个例子中,我们使用了Cython定义了一个计算阶乘的函数`factorial`,它被声明为`cdef`,这意味着这个函数是在编译后的C代码中实现的,而不是作为Python函数。这使得函数的执行非常快速。

```python

# setup.py

from setuptools import setup

from Cython.Build import cythonize

setup(

ext_modules = cythonize("example.pyx"),

)

```

然后,我们可以使用以下命令来编译`.pyx`文件:

```bash

python setup.py build_ext --inplace

```

编译完成后,生成的模块可以直接在Python中导入并使用,就像导入普通的Python模块一样。

使用Cython的一个主要优点是能够针对Python的性能瓶颈进行优化,而不必重写整个Python代码库。然而,需要注意的是,Cython代码的编写和维护要比普通Python代码复杂,需要对C语言有一定的了解。此外,编写Cython代码需要在代码的可读性和性能之间进行权衡。

总之,Cython是一个强大的工具,可以帮助开发者提高Python代码的性能。通过将关键的性能密集型部分转换为C扩展,可以显著提升程序的运行速度,特别是在科学计算、数学运算和数据处理等领域。然而,应当注意,Cython并非万能药,而是在仔细分析性能瓶颈并确定特定部分为性能关键点后,才应当考虑使用的工具。

# 5. 性能优化案例分析

## 5.1 分析真实世界的性能问题

### 5.1.1 案例分析:Web应用性能瓶颈

在Web应用的性能瓶颈案例中,常见的问题包括数据库查询慢、HTTP请求处理不当和资源利用不充分。为了分析这些问题,我们可以通过以下步骤来定位瓶颈并找到优化方案。

首先,使用工具如Apache JMeter或locust.io来模拟真实负载,观察Web应用在不同负载下的表现。通过监控系统的CPU、内存、磁盘I/O等资源使用情况,我们可以初步判断是哪种类型的瓶颈。

```bash

# 示例:使用ab工具进行压力测试

ab -n 1000 -c 100 ***

```

接下来,使用cProfile对Web应用的请求处理代码进行性能分析,找到耗时的函数和模块。

```python

# 示例:使用cProfile对特定视图进行性能分析

import cProfile

from your_web_app import views

cProfile.run('views.yourSlowView()')

```

我们通常会发现数据库操作、缓存处理以及大量的数据序列化/反序列化是主要的性能瓶颈。对数据库的查询进行优化,例如添加索引、使用缓存、优化查询语句等措施可以有效提升性能。

### 5.1.2 案例分析:数据分析脚本加速

数据分析脚本可能面临的性能瓶颈包括数据读写、算法复杂度高以及并行处理能力不足。为了优化这些脚本,我们可以采用多种策略,包括算法优化、使用更高效的数据处理库以及并行计算。

举一个简单的例子,使用Pandas进行大规模数据处理时,内存消耗可能成为瓶颈。这时,可以考虑使用Dask这样的库,它支持更大规模数据集的并行计算。

```python

# 示例:使用Dask替代Pandas进行大规模数据处理

import dask.dataframe as dd

# 读取数据时使用Dask DataFrame

df = dd.read_csv('large_dataset.csv')

```

通过代码优化和使用正确的工具,我们能够显著提升数据分析脚本的处理速度和效率。

## 5.2 优化策略总结与最佳实践

### 5.2.1 代码优化前后的对比分析

在实施了性能优化措施之后,对比优化前后的运行数据是至关重要的。这包括记录关键性能指标(KPIs),比如响应时间、吞吐量和资源使用率。

```python

import time

# 记录优化前的时间

start_time = time.time()

# 执行优化前的代码

do_something_before_optimization()

end_time = time.time()

# 记录优化后的时间

start_time = time.time()

# 执行优化后的代码

do_something_after_optimization()

end_time = time.time()

# 打印性能对比

print(f"Before optimization, it took {end_time - start_time} seconds.")

print(f"After optimization, it took {end_time - start_time} seconds.")

```

通过这种简单的计时对比,我们可以看到优化的效果,并据此调整我们的优化策略。

### 5.2.2 Python性能优化的最佳实践和建议

在性能优化方面,有一些最佳实践和建议值得推荐:

- **代码层面:** 尽量避免全局变量的使用,尽量使用局部变量;对于循环操作,尽可能地减少循环内部的操作量;对于递归调用,如果可能,替换为迭代。

- **库使用:** 尽可能地利用Python的高效标准库,如itertools、collections等;对于数值计算,使用NumPy和SciPy可以大幅提升性能。

- **算法选择:** 根据数据规模和操作类型选择合适的算法和数据结构;例如,对于大数据集,考虑使用哈希表(字典)而非列表进行查找操作。

- **并行处理:** 当任务可以并行化时,不要犹豫使用多线程或多进程;对于IO密集型任务,使用异步IO编程模型。

- **外部资源:** 对于数据库和其他外部资源,确保优化访问方式,减少不必要的开销;例如,批量处理数据库操作而不是单行操作。

这些最佳实践可以帮助我们构建性能更优、可扩展性更强的Python应用程序。在实际应用中,重要的是持续分析和评估,以便持续改进性能。

0

0