Python数据结构优化秘籍:如何提升代码效率与性能(数据结构应用深度剖析)

发布时间: 2024-09-12 10:53:40 阅读量: 210 订阅数: 52

DeepSORT性能解码:计算效率的深度剖析

# 1. Python数据结构基础

Python是一种高级编程语言,以其简洁的语法和强大的库支持而闻名。在数据科学、机器学习、网络开发等多个领域都有广泛应用。而数据结构作为组织和存储数据的一种方式,在Python程序设计中扮演着至关重要的角色。

## 1.1 常用数据结构概述

在Python中,有几种内置的数据结构,它们各自有独特的优势和用途。核心的数据结构包括:

- 列表(List):有序的集合,可以随时添加和删除其中的元素。

- 元组(Tuple):和列表类似,但是不可变的。

- 字典(Dictionary):无序的键值对集合,通过键快速检索值。

- 集合(Set):一个无序且唯一元素的集。

这些数据结构的使用几乎贯穿于Python程序的方方面面。

## 1.2 Python内置数据结构详解

Python的内置数据结构是高效的,它们在底层使用C语言编写,这意味着开发者可以享受到接近系统级语言的性能。

- **列表**:使用数组实现,支持快速的元素插入和删除操作。

- **元组**:在底层是通过对象数组来实现的,一旦创建,元组内对象的引用是无法改变的。

- **字典**:底层通常是哈希表的实现,使得查找、插入和删除操作能够以平均常数时间复杂度完成。

- **集合**:类似于字典,但是只存储键,不存储值。

每种数据结构都适应于不同类型的用例。例如,当你需要一个有序集合并且可能修改其内容时,列表会是一个好的选择。而当你需要一个不变的序列,或希望以键值对方式存储数据时,元组和字典则更加合适。

## 1.3 数据结构在实际问题中的角色

理解数据结构的重要性不仅在于它们的内部实现,更在于如何将它们应用于实际问题。数据结构的选择直接影响了程序的效率和可维护性。例如,使用列表和字典可以简单高效地实现一个待办事项列表,而集合可以帮助我们快速找到两个列表的共同元素。这些内置数据结构是解决日常编程问题的基石。

在后续章节中,我们将深入探讨数据结构的选择、性能比较、内存管理、递归与迭代的应用、算法优化技巧以及如何构建一个高效的系统。我们将通过实际案例来理解每种数据结构在解决问题中的实际作用,并学习如何有效地使用它们来提升我们的编程能力。

# 2. 数据结构的选择与性能比较

在处理复杂的数据问题时,选择合适的数据结构至关重要。它直接影响到程序的效率和可维护性。本章节深入探讨了不同数据结构的适用场景,比较了它们的时间和空间复杂度,并通过实际案例展示了如何选择合适的数据结构。

## 2.1 理解不同数据结构的适用场景

数据结构是组织和存储数据的一种方式,使得数据的访问和操作可以更加高效。根据应用场景的不同,某些数据结构可能比其他的更适合。本节将详细介绍列表(List)、元组(Tuple)、字典(Dictionary)、集合(Set)、栈(Stack)、队列(Queue)和树(Tree)等常见数据结构的适用场景。

### 列表(List)

**适用场景**:列表是Python中最基本的数据结构,适用于随机访问和修改数据的场景。列表的动态性使其适用于需要动态调整大小的数据集合。

```python

# 示例:使用列表存储和访问数据

fruits = ["apple", "banana", "cherry"]

print(fruits[1]) # 输出 "banana"

fruits.append("orange")

print(fruits) # 输出 ["apple", "banana", "cherry", "orange"]

```

### 元组(Tuple)

**适用场景**:元组具有不可变性,适合用作只读数据集合。由于不可变性,元组的存储和访问通常比列表更快。

```python

# 示例:使用元组存储数据

coordinates = (10.0, 20.0)

print(coordinates[0]) # 输出 10.0

```

### 字典(Dictionary)

**适用场景**:字典是一种通过键(key)来存储和访问值(value)的数据结构,适用于查找、更新和删除操作频繁的场景。

```python

# 示例:使用字典存储和访问数据

person = {"name": "Alice", "age": 25}

print(person["name"]) # 输出 "Alice"

person["age"] = 26

```

### 集合(Set)

**适用场景**:集合是无序的、不重复的元素集,适合用于去重和集合运算。

```python

# 示例:使用集合去重

numbers = [1, 2, 2, 3, 4, 4, 5]

unique_numbers = set(numbers)

print(unique_numbers) # 输出 {1, 2, 3, 4, 5}

```

### 栈(Stack)

**适用场景**:栈是一种后进先出(LIFO)的数据结构,适用于需要进行逆序操作的场景,如函数调用栈、撤销操作等。

```python

# 示例:使用栈进行操作

stack = []

stack.append(1)

stack.append(2)

stack.append(3)

print(stack.pop()) # 输出 3

```

### 队列(Queue)

**适用场景**:队列是一种先进先出(FIFO)的数据结构,适用于需要按顺序处理数据的场景,如任务调度、缓冲处理等。

```python

from collections import deque

# 示例:使用队列进行操作

queue = deque()

queue.append(1)

queue.append(2)

print(queue.popleft()) # 输出 1

```

### 树(Tree)

**适用场景**:树是一种层级结构数据,适用于需要快速检索、插入和删除的场景,如文件系统、数据库索引等。

```python

class TreeNode:

def __init__(self, value):

self.value = value

self.children = []

# 示例:使用树进行操作

root = TreeNode(1)

child = TreeNode(2)

root.children.append(child)

```

## 2.2 各种数据结构的时间和空间复杂度分析

时间复杂度和空间复杂度是衡量算法性能的两个重要指标,它们分别描述了算法运行时间和使用的存储空间随输入规模的增长趋势。

### 时间复杂度

时间复杂度是指执行算法所需的运算次数。它通常用大O符号来表示,如O(n)、O(log n)、O(n^2)等。表2-1展示了常见数据结构操作的时间复杂度。

表2-1:常见数据结构操作的时间复杂度

| 数据结构 | 访问 | 搜索 | 插入 | 删除 |

|-----------|------|------|------|------|

| 列表 | O(1) | O(n) | O(n) | O(n) |

| 元组 | O(1) | O(n) | N/A | N/A |

| 字典 | N/A | O(n) | O(n) | O(n) |

| 集合 | N/A | O(n) | O(n) | O(n) |

| 栈 | O(1) | O(n) | O(1) | O(1) |

| 队列 | O(1) | O(n) | O(1) | O(1) |

| 二叉树 | O(n) | O(n) | O(n) | O(n) |

| B树 | O(log n) | O(log n) | O(log n) | O(log n) |

### 空间复杂度

空间复杂度指的是算法运行过程中临时占用存储空间的大小。表2-2展示了常见数据结构的空间复杂度。

表2-2:常见数据结构的空间复杂度

| 数据结构 | 空间复杂度 |

|-----------|------------|

| 列表 | O(n) |

| 元组 | O(n) |

| 字典 | O(n) |

| 集合 | O(n) |

| 栈 | O(n) |

| 队列 | O(n) |

| 二叉树 | O(n) |

| B树 | O(n) |

## 2.3 实际案例:选择合适数据结构的决策过程

在实际应用中,选择合适的数据结构需要根据具体问题的需求来决定。以下是一个简单的案例,说明如何基于问题的需求选择数据结构。

**案例**:实现一个简单的命令行计算器,需要支持用户输入历史记录和快速检索最近使用过的命令。

**分析**:

- **需求1**:存储历史记录以便检索。这里可以使用栈或队列来存储用户输入的命令历史。

- **需求2**:支持快速检索。字典结构适合实现快速检索,我们可以用命令和其出现次数作为键值对存储。

- **需求3**:命令历史需要记住最近使用的命令。队列适用于FIFO,但要快速检索,我们可以将命令历史存入字典和列表中,列表用于保持插入顺序,字典用于快速访问。

**实现**:

```python

from collections import deque

class CalculatorHistory:

def __init__(self):

***mands = deque()

***mand_dict = {}

def add_command(self, command):

***mands.append(command) # 在队列末尾添加命令

***mand_dict[command] = ***mand_dict.get(command, 0) + 1 # 更新字典中的命令计数

def get_commands(self):

return list(***mands) # 返回命令列表

def search_command(self, command):

***mand_dict.get(command, None) # 搜索命令出现的次数

# 示例使用

history = CalculatorHistory()

history.add_command("add")

history.add_command("subtract")

history.add_command("add")

print(history.search_command("add")) # 输出 2

print(history.get_commands()) # 输出 ['add', 'subtract', 'add']

```

在本案例中,使用了队列来维护命令的输入顺序,同时利用字典来快速检索命令的使用频率。这种结构的选择使得该计算器程序能够有效地满足用户的需求。

通过以上分析和案例,我们可以理解数据结构的选择对程序性能的影响,并在实际开发中作出更明智的决策。在后续章节中,我们将进一步探讨内存管理、递归与迭代的使用场景,以及数据结构在算法优化中的关键作用。

# 3. 内存管理与数据结构优化

内存管理是编程中一个极其重要的方面,特别是在使用像Python这样的高级语言时,良好的内存管理能极大提高程序的效率和性能。数据结构是内存管理的核心组成部分,它们的优化直接影响到程序的运行效率。

## 3.1 Python中的内存分配机制

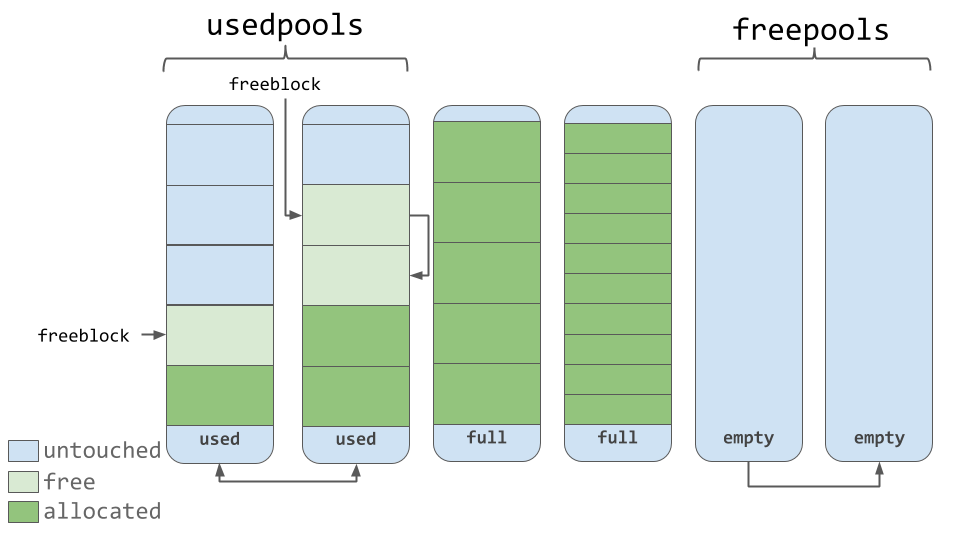

Python虚拟机通过自己的内存管理器自动分配和管理内存,这使得程序员不需要手动进行复杂的内存管理操作。Python使用一个称为“内存池”的机制来分配小块内存,这种方式可以减少频繁的系统调用,从而提高内存分配效率。

### Python内存管理的基本原理

Python对象的内存分配分为小对象分配和大对象分配。小对象会被分配到内存池中,而大对象则会被直接分配到堆上。在内存池中,有一个固定大小的内存块列表,这些内存块称为arena。当需要分配小对象时,内存管理器会从相应的arena中获取一个内存块,如果该内存块还剩余空间,则会继续使用该块,否则,会去其它arena中寻找空闲的内存块。

### Python垃圾回收机制

Python的垃圾回收机制主要是引用计数和循环垃圾回收。引用计数是跟踪对象被引用次数的方法,每当一个变量被赋值为一个对象,该对象的引用计数增加,反之则减少。当一个对象的引用计数减少到零时,该对象占用的内存会被立即释放。

## 3.2 数据结构内存使用优化策略

数据结构的内存使用优化策略包括减少内存使用量和提高内存使用效率两个方面。这通常涉及减少数据结构占用的内存空间、降低对象创建和销毁的频率,以及优化数据存取方式。

### 3.2.1 减少内存占用

在Python中,字符串和列表是两种内存占用较大的数据结构。可以使用`str.join()`方法合并字符串,避免多次使用`+`操作符来拼接字符串,因为后者每次操作都会产生新的字符串对象。对于列表,使用生成器表达式代替列表推导式可以减少内存占用,因为生成器表达式不会一次性生成所有元素,而是按需生成。

### 3.2.2 提高内存使用效率

在处理大数据时,需要特别注意内存的使用效率。例如,使用`itertools`模块中的函数可以创建内存效率更高的迭代器。对于那些需要重复使用的数据结构,可以通过将数据序列化为二进制格式,存储在磁盘上,当需要时再反序列化回来,这样可以节省大量内存空间。

```python

import itertools

# 创建一个生成器表达式

numbers = range(10000)

squared = (x * x for x in numbers)

# 使用itertools链式操作,提高内存使用效率

squared_chain = itertools.chain([0], (x * x for x in numbers))

for val in squared_chain:

print(val)

```

在上述代码中,`itertools.chain()`创建了一个迭代器,它首先返回0,然后返回`numbers`中每个数字的平方。这种方式避免了创建一个大的列表来存储这些值,从而节约了内存。

## 3.3 垃圾回收与数据结构性能的影响

垃圾回收是内存管理的关键部分,它影响着程序的性能。Python中的垃圾回收主要是自动进行的,但开发者也可以通过一些策略来优化垃圾回收的效果。

### 3.3.1 引用计数优化

开发者应该尽量减少循环引用和不必要的引用,因为这会导致垃圾回收器难以回收相关对象。例如,在处理大型数据结构时,可以使用局部变量来引用数据,当数据不再需要时,局部变量的作用域结束,引用会自动消失。

### 3.3.2 循环垃圾回收调整

Python的循环垃圾回收器可以通过调整参数来优化,比如修改`gc`模块中的一些阈值设置。调整这些阈值可以帮助垃圾回收器更有效地回收那些循环引用的对象。

```python

import gc

# 设置垃圾回收器的阈值

gc.set_threshold(threshold0[, threshold1[, threshold2]])

```

在上述代码中,`gc.set_threshold()`函数设置了触发垃圾回收的阈值,`threshold0`, `threshold1`, 和 `threshold2`分别表示三代对象分配和回收的阈值。通过适当调整这些值,可以减少垃圾回收的频率,或者使其在内存使用较低时就进行,从而避免内存使用过高。

### 总结

在本章节中,我们深入探讨了Python内存管理机制和数据结构优化策略。我们了解了内存分配的基本原理,包括内存池和arena的概念,以及引用计数和循环垃圾回收的工作方式。此外,我们还学习了具体的数据结构内存使用优化策略,包括减少内存占用和提高内存使用效率的方法,并且讨论了垃圾回收对数据结构性能的影响。这些知识对于编写高效且性能优越的Python程序至关重要。在下一章节中,我们将转向数据结构在递归与迭代中的应用,探索这两种基本算法原理在数据结构中的具体实现。

# 4. 递归与迭代在数据结构中的应用

## 4.1 递归与迭代的基本原理和区别

### 递归的基本原理

递归是一种编程技术,它允许函数调用自身来解决问题。递归函数通常有一个基本情况(base case),这是函数停止调用自身的条件,以及一个或多个递归步骤,这是函数调用自身来解决更小或更简单问题的点。

递归的关键在于将大问题分解为小问题,直到达到一个足够简单的状态,可以直接解决。递归可以自然地表达树形结构和图遍历,以及各种数学问题。

### 迭代的基本原理

迭代则是一个重复执行一系列操作的过程,直到达到预定的条件。迭代方法通常使用循环结构来实现,比如for循环或while循环。迭代避免了递归可能引入的额外开销,因为它不需要多次函数调用和返回。

### 递归与迭代的区别

递归和迭代之间的主要区别在于解决问题的方式和内存使用。递归可能会在调用栈上创建额外的层,如果递归深度过大,可能会导致栈溢出错误。而迭代则是基于循环的,不会创建新的栈帧,因此对内存的使用更为稳定。

递归在逻辑上通常更简洁,更易于理解,尤其适用于自然表示为递归过程的算法(例如树的遍历)。然而,递归算法可能不如迭代算法高效,因为每次递归调用都会增加额外的开销。

### 代码示例与逻辑分析

下面是一个使用Python实现的阶乘计算,展示了递归和迭代两种方法:

```python

# 递归方法计算阶乘

def factorial_recursive(n):

# 基本情况

if n == 0 or n == 1:

return 1

# 递归步骤

else:

return n * factorial_recursive(n - 1)

# 迭代方法计算阶乘

def factorial_iterative(n):

result = 1

for i in range(1, n+1):

result *= i

return result

```

在这段代码中,`factorial_recursive` 函数通过递归调用自身来计算阶乘,而 `factorial_iterative` 则使用了一个简单的for循环。

#### 参数说明

- `n`:这里是一个整数,代表要计算阶乘的数。

- `result`:用于累乘计算阶乘结果的变量,在迭代方法中使用。

#### 执行逻辑说明

- 在递归方法中,函数通过自身调用逐渐接近基本情况(n=0或n=1),然后在返回过程中逐层计算结果。

- 在迭代方法中,for循环从1到n循环累乘,直到计算出最终的阶乘值。

## 4.2 递归在树形和图数据结构中的应用

### 递归在树中的应用

树形数据结构非常适于递归遍历。以下是如何使用递归方法进行二叉树的深度优先遍历(前序、中序、后序)的概述。

- **前序遍历**:访问根节点,然后递归遍历左子树,最后递归遍历右子树。

- **中序遍历**:递归遍历左子树,然后访问根节点,最后递归遍历右子树。

- **后序遍历**:递归遍历左子树,递归遍历右子树,然后访问根节点。

### 递归在图中的应用

图数据结构的遍历也可以使用递归实现,例如深度优先搜索(DFS)。以下是一个递归实现的DFS算法概述:

1. 访问一个节点。

2. 递归地遍历所有未访问的邻居节点。

3. 对每个邻居节点重复此过程。

### 代码示例与逻辑分析

以下是递归实现的二叉树前序遍历的一个示例:

```python

class TreeNode:

def __init__(self, val=0, left=None, right=None):

self.val = val

self.left = left

self.right = right

def preorder_traversal(root):

if root is None:

return []

# 访问当前节点

result = [root.val]

# 递归遍历左子树

result += preorder_traversal(root.left)

# 递归遍历右子树

result += preorder_traversal(root.right)

return result

```

#### 参数说明

- `root`:二叉树的根节点。

- `result`:用于存储遍历结果的列表。

#### 执行逻辑说明

- 首先检查当前节点是否存在。

- 如果存在,访问该节点,并将其值添加到结果列表中。

- 然后递归地对左子树和右子树执行相同的操作。

- 返回最终的遍历结果列表。

## 4.3 迭代器模式及其在Python中的实现

### 迭代器模式概念

迭代器模式是一种设计模式,允许对象提供一种顺序访问其元素,而不需要暴露其内部表示。迭代器通常有一个或多个方法,如`next()`,用于获取序列中的下一个元素。

### Python中迭代器的实现

在Python中,迭代器是实现了`__iter__()`和`__next__()`方法的对象。它们可以是列表、字典、文件等可迭代对象,也可以是使用`yield`关键字定义的生成器。

### 代码示例与逻辑分析

下面是一个生成器函数,用于产生斐波那契数列的前n个数字:

```python

def fibonacci(n):

a, b = 0, 1

for _ in range(n):

yield a

a, b = b, a + b

# 使用迭代器

fib_sequence = fibonacci(10)

for number in fib_sequence:

print(number, end=' ')

```

#### 参数说明

- `n`:斐波那契数列的长度。

- `a`、`b`:分别用来存储数列的当前和下一个数字。

#### 执行逻辑说明

- 这个生成器函数`fibonacci`使用了`yield`语句来返回数列中的一个值,并记住当前的状态。

- 每次调用`next(fib_sequence)`时,函数就会从上次暂停的地方继续执行,直到产生下一个斐波那契数,或者达到指定的`n`个数字。

通过本章节的介绍,我们了解了递归与迭代的基本原理和区别,它们在树形和图数据结构中的应用,以及迭代器模式的概念和Python中的实现。在实际应用中,选择适当的实现方法,可以优化数据处理的效率和可读性。在下一章节中,我们将探讨数据结构的算法优化技巧。

# 5. 数据结构的算法优化技巧

## 5.1 算法优化的基本原则

在探讨算法优化之前,我们必须理解算法优化的几个基本原则。首先,算法优化应以问题的实际需求为基础,明确优化的目标。其次,要对现有算法进行性能分析,找到瓶颈所在。最后,通过重构或采用新策略来提高效率。性能分析通常包括时间复杂度和空间复杂度的评估,它们决定了算法在处理大数据量时的效率和资源占用情况。

### 5.1.1 问题的实际需求

在实际应用中,算法优化往往是为了提高系统的响应速度或处理能力,满足用户体验和业务需求。举例来说,一个电商系统可能需要优化搜索算法,以提供更快的查询速度。而一个图形处理系统可能更关注算法的内存使用效率,以便在有限的资源下处理更大的图像。

### 5.1.2 性能分析的重要性

性能分析是优化过程的第一步。它涉及到对算法的运行时间、内存占用等性能指标的测量。通常使用诸如大O符号来描述算法的最坏情况时间复杂度,这有助于评估算法在数据量增大的情况下的表现。

### 5.1.3 优化策略的选择

在明确了优化的目标和瓶颈后,选择合适的优化策略是关键。优化策略可能包括但不限于:

- 选择更好的数据结构来改善算法效率

- 利用缓存机制减少重复计算

- 利用并行处理提高计算速度

- 通过算法改写降低时间复杂度

### 示例代码块分析

```python

import time

def naive_search(data, target):

for index, value in enumerate(data):

if value == target:

return index

return -1

data = [i for i in range(10000)]

target = 9999

start_time = time.time()

naive_search(data, target)

print(f"Naive Search took {time.time() - start_time} seconds.")

```

在上述代码中,我们定义了一个简单的线性搜索函数`naive_search`,它的时间复杂度为O(n)。通过记录搜索开始和结束的时间,我们可以测量这个函数的执行时间。

## 5.2 常用算法在数据结构中的优化方法

算法优化是一个涉及面广的领域,但有一些常见的方法可以应用于多种数据结构和算法中。

### 5.2.1 缓存机制

缓存是一种存储临时数据的技术,可以减少对慢速数据源的访问次数。在算法中,如果存在大量的重复计算,使用缓存可以显著提高效率。

### 5.2.2 分治策略

分治策略通过将大问题分解为小问题来简化问题的求解。许多算法,如快速排序和归并排序,都使用了分治思想来优化性能。

### 5.2.3 并行计算

在现代多核处理器中,通过并行计算可以同时处理多个任务。数据结构算法可以被设计为支持并行执行,以充分利用硬件资源。

### 示例代码块分析

```python

from concurrent.futures import ThreadPoolExecutor

def parallel_search(data, target):

with ThreadPoolExecutor(max_workers=10) as executor:

result = list(executor.map(lambda x: x if x == target else None, data))

return result.index(target) if target in result else -1

data = [i for i in range(10000)]

target = 9999

start_time = time.time()

parallel_search(data, target)

print(f"Parallel Search took {time.time() - start_time} seconds.")

```

在这个示例中,我们使用了Python的`concurrent.futures`模块中的`ThreadPoolExecutor`来并行化搜索任务。理论上,这可以将搜索速度提升多倍,但实际效果取决于多线程执行的开销和数据的大小。

## 5.3 算法时间复杂度的降低技术

降低算法的时间复杂度是优化算法性能的直接方法。这通常涉及对算法步骤的重新设计,以减少执行的步骤数。

### 5.3.1 二分查找算法

二分查找算法就是一个典型的降低时间复杂度的例子。它将线性查找的时间复杂度O(n)降低到对数时间复杂度O(log n),极大地提升了查找效率。

### 5.3.2 散列技术

散列技术通过散列函数快速定位数据。对于查找、插入和删除操作,如果散列函数设计得当,可以将它们的时间复杂度降低到接近O(1)。

### 5.3.3 贪心算法与动态规划

贪心算法和动态规划是解决优化问题的两种重要方法。它们可以将复杂问题分解成更简单的子问题,并通过局部最优或全局最优解来降低整体的时间复杂度。

### 示例代码块分析

```python

def binary_search(data, target):

left, right = 0, len(data) - 1

while left <= right:

mid = (left + right) // 2

if data[mid] == target:

return mid

elif data[mid] < target:

left = mid + 1

else:

right = mid - 1

return -1

data = [i for i in range(10000)]

target = 9999

start_time = time.time()

binary_search(data, target)

print(f"Binary Search took {time.time() - start_time} seconds.")

```

上述代码展示了二分查找算法的实现。通过递归或迭代的方式将搜索范围减半,直到找到目标或搜索范围为空。这大幅减少了查找所需的步骤数,从而提升了效率。

通过本章节的介绍,我们深入了解了算法优化的基本原则、常用的优化方法以及降低时间复杂度的技术。这些知识为构建高效的数据处理系统奠定了坚实的理论基础。接下来的章节将通过实战案例,展示如何将这些理论应用于实际问题中,构建出高效的系统解决方案。

# 6. 实战案例:构建高效数据处理系统

在数据处理领域,构建一个高效的系统是每个数据工程师和数据科学家的梦想。一个高效的系统不仅可以快速处理大量数据,而且能够在处理数据时保持良好的性能和稳定性。在本章中,我们将通过一个实战案例来讨论如何构建一个高效的数据处理系统。

## 6.1 高效数据处理系统的需求分析

构建高效数据处理系统的第一步是进行需求分析。需求分析是理解系统需要满足哪些业务目标以及在技术层面上需要达到何种性能的关键步骤。在这个阶段,我们需要确定数据的来源、类型、数据量,以及数据处理的具体需求,比如数据清洗、转换、聚合和可视化等。

在实际操作中,需求分析包括以下几个方面:

- 确定数据处理的频率(实时处理或批处理)

- 评估数据处理的延迟容忍度(毫秒级响应或小时级处理)

- 估算数据存储的需求(是否需要历史数据备份)

- 考虑系统的可扩展性(是否需要支持横向扩展或纵向扩展)

- 设计容错和灾难恢复策略(如何备份数据、如何恢复系统)

## 6.2 系统设计:数据结构与算法的选型

在明确了系统需求之后,我们需要着手系统设计,这其中包括数据结构和算法的选择。在选择数据结构时,我们需要考虑数据量的大小、访问模式和操作类型等因素。

- **数据结构选型**:例如,对于频繁查询和更新操作的数据集,可能需要使用哈希表或平衡二叉树;对于大数据量的批处理操作,则可以考虑使用B树或LSM树等。

- **算法选型**:对于数据排序操作,快速排序和归并排序通常是较好的选择。而对于大数据量的并行处理,则可能需要依赖于分布式计算框架中的算法,如MapReduce。

在设计系统时,不仅要关注单个组件的性能,还要考虑它们之间的协同工作和系统的整体架构设计。比如使用微服务架构来提高系统的可维护性和可扩展性。

## 6.3 性能测试与调优实例

在完成了数据处理系统的设计和初步实现后,进行性能测试是必不可少的。性能测试有助于发现系统的瓶颈,并为进一步的系统优化提供依据。常见的性能测试方法包括压力测试、负载测试和稳定性测试。

以一个简单的日志分析系统为例,假设我们需要对日志进行实时分析,提取有价值的信息。我们可能会采用Kafka作为数据队列,Storm或Flink作为实时处理引擎,并使用Redis进行临时数据存储。

在性能测试阶段,我们可能会发现某些组件在高负载下性能下降。这时,我们可以采取以下措施进行优化:

- **优化代码逻辑**:精简不必要的计算,使用高效的数据结构。

- **调整系统参数**:如增加数据库连接池大小,调整批处理任务的批量大小。

- **并行处理**:利用多核处理器的优势,通过并行化处理来提高效率。

- **资源扩展**:在云环境中,可以通过增加实例数量或升级硬件配置来提高系统的处理能力。

通过不断的测试与调优,我们能够逐步逼近系统性能的极限,构建出能够高效处理数据的系统。

## 示例代码块:一个简单的并行处理框架

```python

import concurrent.futures

import time

def process_data(data):

# 模拟数据处理过程

time.sleep(1) # 模拟处理延时

return data ** 2 # 简单的计算操作

def parallel_processing(data_list):

with concurrent.futures.ThreadPoolExecutor() as executor:

results = list(executor.map(process_data, data_list))

return results

if __name__ == "__main__":

data = list(range(10)) # 创建数据列表

start_time = time.time()

results = parallel_processing(data)

end_time = time.time()

print(f"Processed results: {results}")

print(f"Time taken: {end_time - start_time} seconds")

```

以上是一个使用Python `concurrent.futures`模块实现的简单并行处理框架示例。通过此示例代码,我们可以看到并行处理如何减少处理时间,提高效率。

本章通过对构建高效数据处理系统的分析,展示了从需求分析到系统设计,再到性能测试与优化的整个过程。在实现高效系统的过程中,我们不仅需要注意单个组件的性能,还要考虑整个系统的架构和协作。通过实际案例,我们验证了合理的数据结构选择和算法应用对于构建高效数据处理系统的重要性。

0

0