【Spark性能优化】:揭秘Map分片大小调整的幕后影响

发布时间: 2024-10-31 11:14:55 阅读量: 21 订阅数: 23

# 1. Spark性能优化概述

## Spark在大数据处理中的重要性

Apache Spark自其发布以来,已经成为大数据处理领域内的关键技术之一。作为一个开源的大数据处理框架,Spark不仅支持快速的计算,还提供了易于使用的API,支持SQL查询、流处理、机器学习和图处理等多种功能。然而,由于其分布式处理的复杂性,系统性能的优化成为了一个重要且挑战性的任务。

## 性能优化的关键所在

性能优化的首要步骤是理解数据处理过程中的瓶颈,诸如数据倾斜、内存不足、任务调度不当等问题都可能导致性能问题。在Spark中,合理地管理资源,如CPU、内存和网络带宽,是提升作业效率的关键。此外,优化应用的执行计划,减少不必要的数据移动和处理,也能够显著地提升性能。

## 章节内容简介

本章将对Spark性能优化进行总体概述,揭示性能优化的目标和意义,并为后续章节的深入讨论做好铺垫。从第二章开始,我们将逐一探讨影响Spark性能的各个要素,特别是Map分片的作用和调整分片大小的理论与实践。

# 2. Map分片的基础知识

## 2.1 Map分片的定义与作用

### 2.1.1 分片的定义

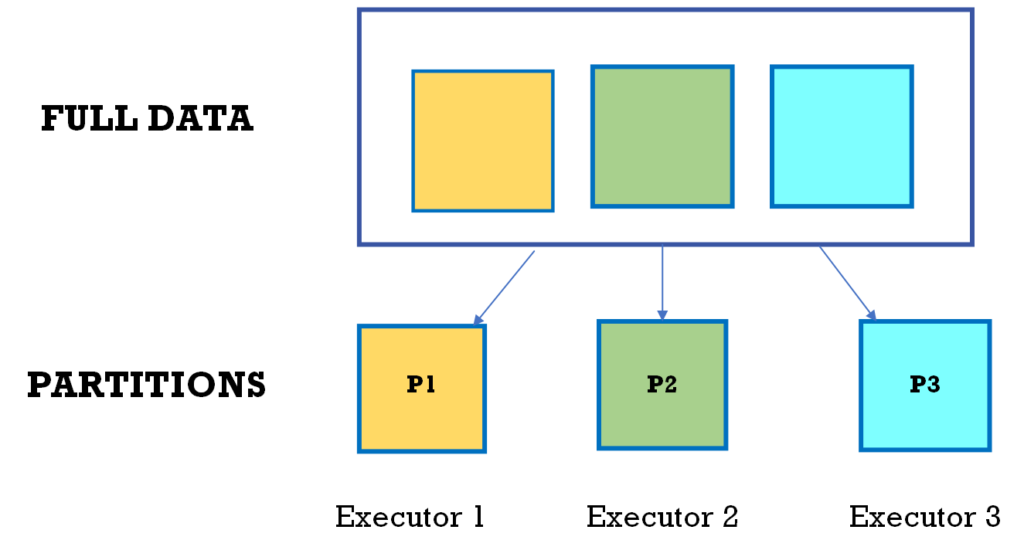

在Spark中,数据通常存储在分布式文件系统(如HDFS)上,为了处理这些数据,Spark需要将数据分布到集群中的多个节点上,这就是所谓的分片(Shuffle)。Shuffle是一个分布式数据交换的过程,是将不同节点上的数据进行重新分配。在Map阶段,Spark将输入数据读取为一系列的键值对(key-value pairs),然后根据key值对这些键值对进行排序,并将它们分配到不同的分区(partitions)。每个分区中的数据会被传递给Map任务去处理。

### 2.1.2 分片在Spark中的作用

分片是Spark处理大数据的核心过程之一。分片过程会决定任务的粒度和并行度,这对性能影响极大。优秀的分片策略可以让数据均匀地分布在各个分区中,从而实现负载均衡,避免某些节点成为瓶颈。此外,分片还关联着内存管理,因为数据在分片后会缓存在内存中,这对于内存的使用效率和GC压力都有着直接的影响。

## 2.2 Spark中数据处理的基本原理

### 2.2.1 Spark的数据流模型

Spark的数据流模型是基于RDD(弹性分布式数据集)的操作,这些操作可以分为两类:转换操作(transformations)和行动操作(actions)。转换操作是延迟计算的,它们创建了新的RDD,但不会立即触发计算。行动操作触发计算,并返回结果。在数据流的处理过程中,每一个转换操作都可能伴随着数据的Shuffle,尤其是涉及到按键聚合的操作,如reduceByKey和groupByKey。Spark的设计目标是在保证容错性的前提下,尽可能地在内存中处理数据,以提高处理速度。

### 2.2.2 Spark任务调度机制

Spark的调度机制是基于DAG(有向无环图)调度器,它会将Spark作业转换成DAG图,然后根据这个图来调度任务。每个节点可以看作是图中的一个顶点,表示一个计算任务;边则表示依赖关系。任务调度的目标是尽量并行执行任务,减少任务等待时间,并合理利用集群资源。Shuffle阶段往往是性能瓶颈所在,因此Spark提供了一系列的优化策略,比如Shuffle持久化和Shuffle服务,来缓解这一问题。

## 2.3 Spark中的分区与并行度

在Spark中,分区数量在很大程度上决定了任务的并行度,进而影响到数据处理的效率。分区数量的选择取决于多个因素,比如集群的CPU核心数量、内存大小、网络带宽以及数据量的大小等。在实践中,过多的分区可能会因为每个分区处理的数据量太小而造成资源浪费和效率下降,而分区太少则可能导致某些节点上任务过载。合理地选择分区数量是优化Spark性能的一个重要方面。

## 2.4 Spark中的分区策略

Spark提供了多种分区策略,如哈希分区、范围分区和自定义分区等。选择合适的分区策略可以有效地将数据分布到各个节点,从而实现负载均衡。哈希分区是根据键值的哈希码来进行分区,它能够较好地随机均匀地分布数据;范围分区则是根据键值的范围来进行分区,适用于键值具有有序性的情况。在实际应用中,需要根据数据特性和作业需求来选择合适的分区策略。

## 2.5 分片与性能优化

分区和Shuffle是Spark中密切相关的概念,它们对性能有显著影响。为了优化性能,需要对Shuffle过程进行监控和调整。Spark提供了多种机制来优化Shuffle,例如Shuffle Write时的文件压缩和Shuffle Read时的内存缓存。在进行性能优化时,通常需要分析作业的执行计划,监控Shuffle过程中数据的读写情况,并根据观察到的性能瓶颈来调

0

0