Spark性能优化:深度解析数据倾斜调优

199 浏览量

更新于2024-08-28

收藏 1.36MB PDF 举报

"Spark性能优化:数据倾斜调优"

在Spark大数据处理中,数据倾斜是一个常见的性能瓶颈,它会导致部分task执行时间过长,严重影响整体作业的效率。数据倾斜调优是解决这个问题的关键,旨在通过各种策略提升Spark作业的性能。

调优概述

数据倾斜的表现特征通常体现在两个方面:一是大部分task执行迅速,但少数task耗时过长,这种不均衡可能导致整个作业的延迟;二是原本稳定运行的作业突然出现内存溢出(OOM)错误,这可能由单个task处理过多数据引起。数据倾斜的根本原因在于shuffle操作时,相同key的数据被集中分配给特定的task,若某些key的数据量远超平均值,就会造成数据分布不均。

数据倾斜的原因

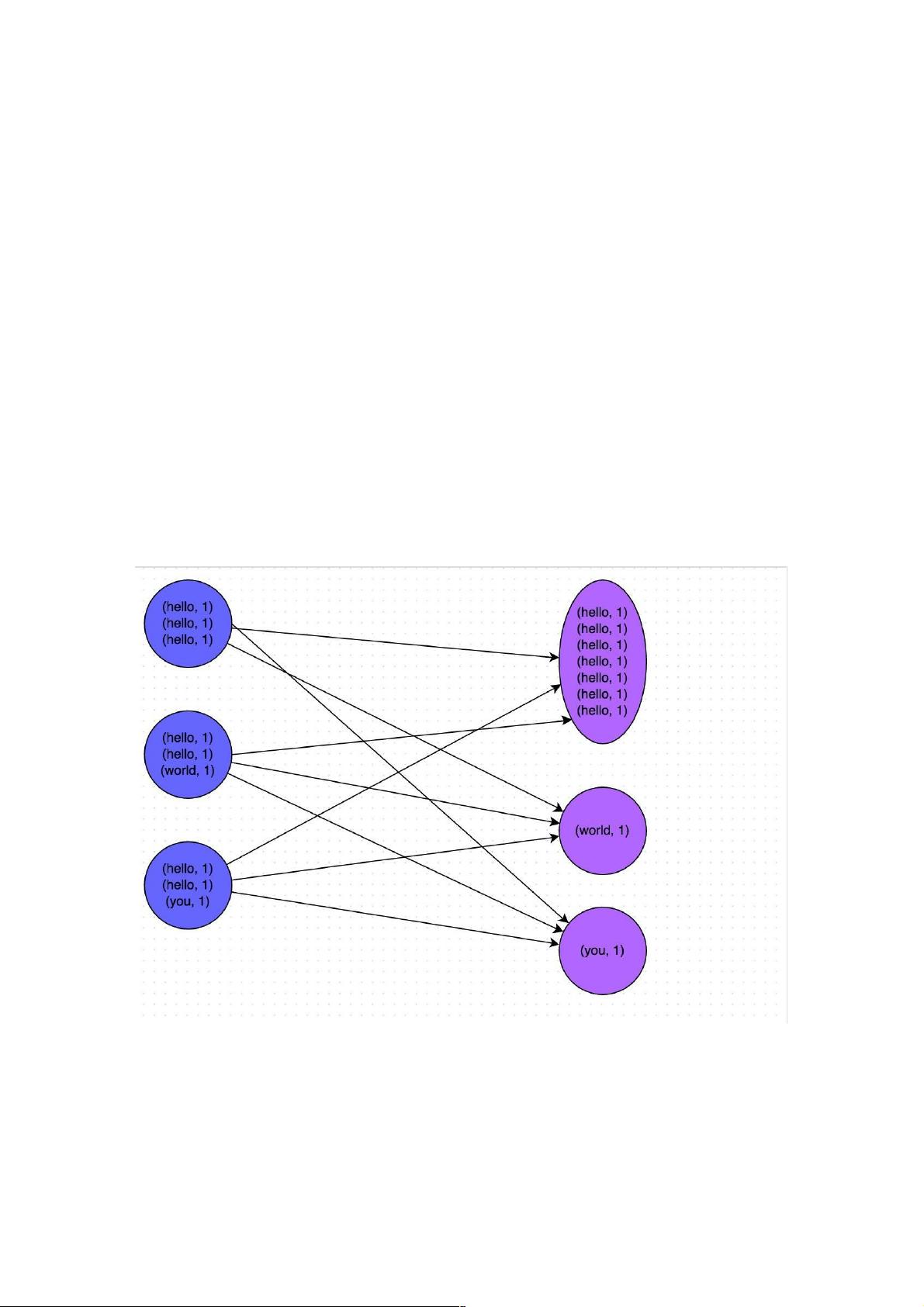

数据倾斜主要源于shuffle阶段,例如在reduceByKey、groupByKey、join等操作中,大量数据被聚集到少数key对应的task上。当部分key的数据量远大于其他key时,负责处理这些key的task将承受过大的数据负载,从而导致性能下降或内存溢出。

定位数据倾斜的代码

要解决数据倾斜,首先需要找到引发shuffle操作的代码片段。常见的shuffle操作包括:reduceByKey、groupByKey、aggregateByKey、join、cogroup、sortByKey等。通过日志分析和性能监控,可以找出运行时间过长的task,并进一步追踪到对应的代码行。一旦找到问题源头,就可以采取相应的调优策略。

解决数据倾斜的方法

1. **重新分区**:通过增加分区数,使数据更均匀地分布在各个task上。这可以通过`repartition()`或`coalesce()`函数实现,但需注意过多的分区会影响shuffle开销。

2. **哈希分桶**:针对特定key进行哈希分桶,确保相同key的数据落在相同节点上,减少跨节点的数据传输。

3. **数据预处理**:对数据进行预处理,如对大key进行拆分或合并,以平衡数据分布。

4. **自定义分区器**:创建自定义的分区器,根据业务逻辑使数据更均匀地分布。

5. **采样和估算**:通过采样数据估算key的分布,提前发现可能的数据倾斜并调整策略。

6. **避免不必要的shuffle**:优化代码逻辑,尽可能减少shuffle操作,例如利用map-side join替代部分shuffle join。

数据倾斜调优是一个复杂的过程,需要结合业务场景和数据特性,通过多种手段综合优化。有效的数据倾斜调优不仅能提高Spark作业的执行速度,还能避免内存溢出等严重问题,确保大数据处理的稳定性和效率。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-01-29 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_38677046

- 粉丝: 6

- 资源: 911

最新资源

- 正整数数组验证库:确保值符合正整数规则

- 系统移植工具集:镜像、工具链及其他必备软件包

- 掌握JavaScript加密技术:客户端加密核心要点

- AWS环境下Java应用的构建与优化指南

- Grav插件动态调整上传图像大小提高性能

- InversifyJS示例应用:演示OOP与依赖注入

- Laravel与Workerman构建PHP WebSocket即时通讯解决方案

- 前端开发利器:SPRjs快速粘合JavaScript文件脚本

- Windows平台RNNoise演示及编译方法说明

- GitHub Action实现站点自动化部署到网格环境

- Delphi实现磁盘容量检测与柱状图展示

- 亲测可用的简易微信抽奖小程序源码分享

- 如何利用JD抢单助手提升秒杀成功率

- 快速部署WordPress:使用Docker和generator-docker-wordpress

- 探索多功能计算器:日志记录与数据转换能力

- WearableSensing: 使用Java连接Zephyr Bioharness数据到服务器