Spark性能优化:深度解析数据倾斜调优

"Spark性能优化:数据倾斜调优"

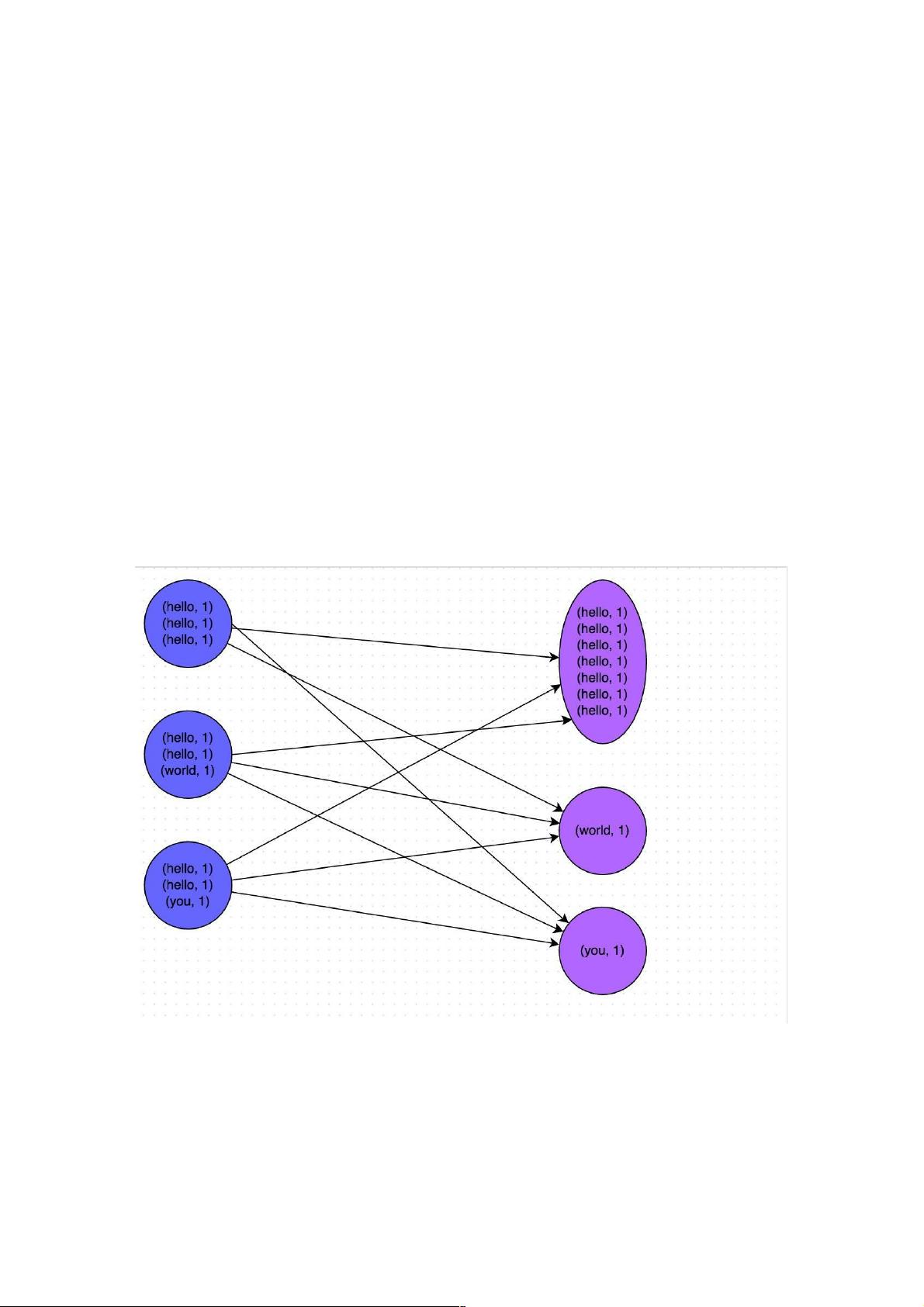

在Spark的大数据处理中,性能优化是一项至关重要的任务。本文聚焦于数据倾斜调优,这是解决高级性能问题的关键环节。数据倾斜通常表现为部分task执行时间过长,严重影响整体作业的效率,甚至可能导致内存溢出(OOM)错误。数据倾斜的根本原因在于shuffle过程中,某些key对应的数据分布不均,导致部分task负载过重。

调优策略主要包括识别和处理数据倾斜。当发现task执行速度差距悬殊或者作业突然出现OOM异常时,应考虑是否存在数据倾斜问题。例如,997个task能在短时间内完成,但有三两个task耗时极长,这通常是数据倾斜的典型表现。

要定位导致数据倾斜的代码,可以关注那些涉及shuffle操作的Spark算子,如`groupByKey`、`reduceByKey`、`join`、`sortByKey`等。这些操作会导致数据根据key进行重新分布,如果key的分布不均匀,就会产生数据倾斜。例如,一个key对应大量数据,而其他key仅对应少量数据,那么处理大量数据的task就会成为性能瓶颈。

解决数据倾斜的方法多样,包括但不限于以下几种:

1. 数据预处理:对数据进行预处理,比如哈希分桶、范围分区,以减少倾斜key的出现概率。

2. 增加并行度:增大partition数量,使数据更均匀地分配到task中,但要注意这可能会增加内存压力。

3. 倾斜key处理:对于已知的倾斜key,可以使用`bucketBy`或`coalesce`等方法,手动控制其分布。

4. 随机扰动key:在shuffle前对key进行轻微的随机化,避免特定key的数据过于集中。

5. 动态分区裁剪:在join操作中,通过设置` spark.sql.shuffle.partitions`和`spark.sql.autoBroadcastJoinThreshold`,限制分区数量和广播join的大小,减轻倾斜。

在实践中,通常需要结合具体场景,综合运用以上策略来解决数据倾斜问题。同时,监控和日志分析也是定位和解决数据倾斜的重要手段,通过分析task的执行时间和内存使用情况,可以找出问题所在,并针对性地优化。

Spark的数据倾斜调优是一项复杂但必要的工作,它涉及到对shuffle操作的理解,以及对数据分布特性的深入洞察。只有通过细致的分析和合理的优化,才能确保Spark作业的高效稳定运行。

1026 浏览量

392 浏览量

516 浏览量

195 浏览量

146 浏览量

202 浏览量

135 浏览量

1366 浏览量

411 浏览量

weixin_38722052

- 粉丝: 4

最新资源

- 多技术领域源码集锦:园林绿化官网企业项目

- 定制特色井字游戏Tic Tac Toe开源发布

- TechNowHorse:Python 3编写的跨平台RAT生成器

- VB.NET实现程序自动更新的模块设计与应用

- ImportREC:强大输入表修复工具的介绍

- 高效处理文件名后缀:脚本批量添加与移除教程

- 乐phone 3GW100体验版ROM深度解析与优化

- Rust打造的cursive_table_view终端UI组件

- 安装Oracle必备组件libaio-devel-0.3.105-2下载

- 探索认知语言连接AI的开源实践

- 微软SAPI5.4实现的TTSApp语音合成软件教程

- 双侧布局日历与时间显示技术解析

- Vue与Echarts结合实现H5数据可视化

- KataSuperHeroesKotlin:提升Android开发者的Kotlin UI测试技能

- 正方安卓成绩查询系统:轻松获取课程与成绩

- 微信小程序在保险行业的应用设计与开发资源包