【模拟信号数字化必知】:7种硬件与算法优化,提升处理效率

发布时间: 2024-12-17 03:54:52 阅读量: 17 订阅数: 11

数字信号处理算法的定点化及其C语言仿真-综合文档

参考资源链接:[模拟信号数字化处理详解:采样、量化与编码](https://wenku.csdn.net/doc/1j19a4i27g?spm=1055.2635.3001.10343)

# 1. 模拟信号数字化基础

## 1.1 信号的模拟与数字表示

在进入数字化的世界前,必须了解模拟信号与数字信号之间的差异。模拟信号是连续的,可表示为时间与强度连续变化的波形。而数字信号则是通过一系列离散的数值表示,这一过程被称为“采样”。

## 1.2 数字化的过程与原理

将模拟信号转换为数字信号的过程称为数字化,这一过程涉及三个主要步骤:采样、量化和编码。采样是按照一定时间间隔捕捉模拟信号的过程;量化是将采样得到的每个信号幅度转换为数字值;编码则是将这些数值用二进制形式表示。

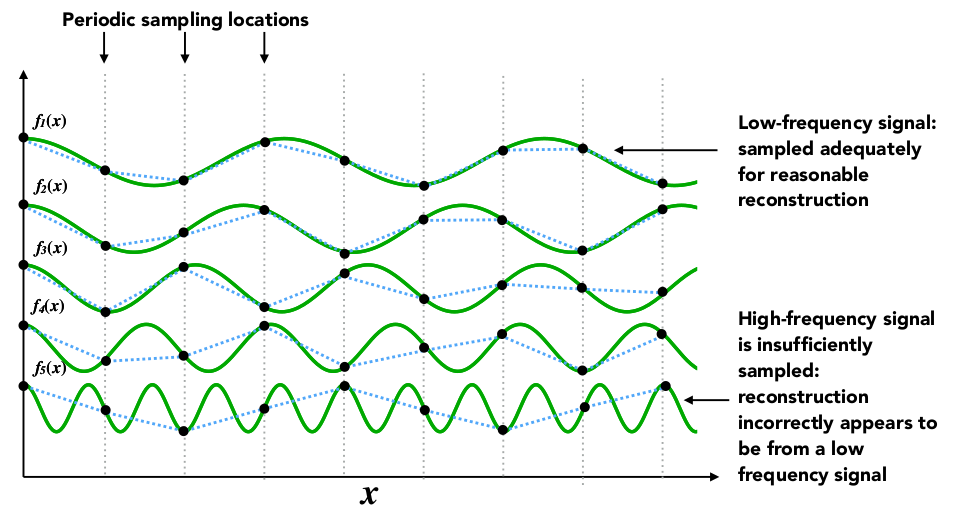

## 1.3 采样定理与奈奎斯特定理

为了能无失真地从数字信号还原原始模拟信号,必须遵守采样定理,即采样频率应至少是信号最高频率的两倍,这一最小采样频率被称为奈奎斯特频率。如果采样频率不足,将会出现混叠效应,导致信息丢失。

```

# 以下是一个简单的示例,说明如何在Python中模拟一个信号的数字化过程:

import numpy as np

import matplotlib.pyplot as plt

# 创建模拟信号

fs = 1000 # 采样频率

t = np.arange(0, 1, 1/fs) # 时间向量

f = 5 # 信号频率

signal = 0.7 * np.sin(2 * np.pi * f * t) # 5 Hz的正弦波信号

# 信号可视化

plt.plot(t, signal)

plt.xlabel('Time [s]')

plt.ylabel('Amplitude')

plt.title('Analog Signal')

plt.show()

# 数字化过程 - 采样

sample_rate = 100 # 采样频率

sampled_signal = signal[::sample_rate]

sampled_time = t[::sample_rate]

# 数字化信号可视化

plt.stem(sampled_time, sampled_signal, 'r', markerfmt='ro', basefmt="-b", label='Sampled Signal')

plt.xlabel('Time [s]')

plt.ylabel('Amplitude')

plt.title('Digital Signal')

plt.legend()

plt.show()

```

上面的代码首先创建了一个5 Hz的正弦波模拟信号,然后通过不同的采样率对其进行采样,并使用Matplotlib进行可视化。这展示了在采样率低于奈奎斯特频率时信号出现的混叠现象,以及正确采样时信号的数字化表示。

# 2. 数字化硬件优化

数字化硬件是将模拟信号转换为数字信号的基础,其性能直接影响到整个信号处理系统的效率和质量。在这一章节,我们将探讨如何选择和优化采样硬件、如何提升模数转换器(ADC)的性能、以及滤波器设计与应用。通过这些内容的学习,你可以深入理解数字化硬件的优化方法,并将其应用到实际的工程项目中。

## 2.1 采样硬件的选择与优化

### 2.1.1 采样率的重要性及提升策略

采样率,即每秒采集的样本数量,是数字化硬件设计中的关键参数。根据奈奎斯特定理,采样率至少需要是模拟信号最高频率的两倍,以确保信号的完整性。在实际应用中,更高的采样率能够提供更好的信号还原质量,尤其在处理快速变化的信号时。

为了提升采样率,工程师通常采取以下策略:

- 使用高速ADC,这是提升采样率最直接的方法。

- 采用并行采集技术,通过多个ADC同时采样不同信号段,再进行后期数据处理合成。

- 优化信号前端处理,例如使用带通滤波器来减少高频噪声,使得信号更易于采样。

```mermaid

graph TD;

A[开始] --> B[确定信号最大频率];

B --> C[计算理论最低采样率];

C --> D[选择高速ADC];

D --> E[应用并行采集技术];

E --> F[优化前端信号处理];

F --> G[最终采样率];

```

### 2.1.2 量化位深的影响与选择

量化位深决定了信号数字化后的精度,即量化后的信号能够表示的灰度级数。常见的量化位深包括8位、12位、16位等。量化位深越高,信号的量化误差越小,动态范围越广,信号的细节保留得越好。

选择合适的量化位深,需要考虑以下几个因素:

- 应用场景对信号质量的要求;

- ADC的性能和成本限制;

- 数据存储和处理能力的限制。

```table

| 量化位深 | 动态范围 | 应用场景 |

|----------|-----------|----------|

| 8位 | 48 dB | 简单音频系统 |

| 12位 | 72 dB | 专业音频和视频 |

| 16位 | 96 dB | 高保真音频系统 |

```

## 2.2 模数转换器(ADC)的性能提升

### 2.2.1 ADC类型与应用场景

市场上有多种ADC类型,它们各有特点和应用场景。主要的ADC类型包括:

- 逐次逼近型(SAR)ADC:适合中低速、高精度应用。

- 流水线型(Pipelined)ADC:适合高速、中等精度应用。

- Δ-Σ型(Delta-Sigma)ADC:适合高精度、低速应用。

每种ADC类型都有其优势和局限性,工程师需要根据实际项目的需求选择合适的ADC类型。

### 2.2.2 提升ADC性能的硬件改进方法

提升ADC性能可以通过硬件改进来实现,以下是一些常见的改进方法:

- 使用高精度时钟源减少时钟抖动,从而提升ADC的信号完整性。

- 采用差分输入减少共模干扰。

- 实施适当的电源和接地管理,减少电源噪声的影响。

```code

// 伪代码示例:使用高精度时钟源的代码片段

function InitializeADCWithHighPrecisionClock() {

// 初始化高精度时钟源

highPrecisionClock = new HighPrecisionClockSource();

highPrecisionClock.Configure();

// 配置ADC时钟

adc.Clock = highPrecisionClock.Generate();

// 开始ADC转换

adc.Start();

}

```

在上述代码中,我们创建了一个高精度时钟源对象,并配置它以生成稳定的时钟信号。然后,我们使用这个信号作为ADC的时钟输入,以此来减少时钟抖动,提升ADC性能。

## 2.3 滤波器设计与应用

### 2.3.1 滤波器的基本类型和作用

滤波器是一种电子电路,用于允许特定频率范围的信号通过,同时阻止其他频率信号。基本的滤波器类型有低通、高通、带通和带阻四种。

滤波器的作用包括:

- 去除不需要的噪声和干扰。

- 防止信号失真。

- 隔离不同频率的信号,保证信号的纯净度。

### 2.3.2 高效滤波器设计策略

设计高效滤波器,需要考虑以下策略:

- 根据应用需求选择合适的滤波器类型。

- 确定滤波器的截止频率和过渡带宽度。

- 使用模拟或数字技术实现滤波器功能,依据设计复杂度和成本选择。

```mermaid

flowchart LR;

A[开始设计滤波器] --> B[需求分析]

B --> C[选择滤波器类型]

C --> D[确定截止频率]

D --> E[计算元件参数]

E --> F[选择实现技术]

F --> G[仿真测试]

G --> H[实际应用]

```

滤波器设计流程从需求分析开始,逐步深入,每一步都必须精确计算和设计,以确保滤波器性能达到预期目标。在实际应用中,设计完成后还需通过仿真测试和实际应用来验证设计的正确性和性能。

在本章中,我们详细讨论了数字化硬件优化的不同方面,包括采样硬件的选择与优化、ADC的性能提升、以及滤波器设计与应用。通过深入理解这些内容,技术人员可以在实际工作中,针对不同需求,做出合理的硬件选择和优化,以确保数字化过程的高效和高质量。接下来的章节将探讨数字化算法优化,进一步提升信号处理的效率和质量。

# 3. 数字化算法优化

## 3.1 常见数字化算法概述

数字化算法是将模拟信号转换为数字信号的核心技术。它们在确定最终数字信号质量方面扮演着至关重要的角色。

### 3.1.1 传统采样理论与算法

在讨论新兴算法之前,传统采样理论是不可忽视的基础。奈奎斯特采样定理阐述了为准确重构原始信号,采样频率必须至少是信号最高频率的两倍。然而,在实践中,为了抑制混叠并保留信号的高频成分,常常需要更高的采样率。

```mermaid

graph LR

A[原始模拟信号] -->|采样| B[数字样本]

B -->|量化| C[数字信号]

C -->|编码| D[数字数据流]

```

### 3.1.2 新兴算法在数字化中的应用

随着计算能力的提升,出现了众多新兴算法,如自适应采样、压缩感知和机器学习辅助的信号处理。这些技术提供了对复杂信号更好的处理能力,尤其在降低数据采集和处理的复杂度方面。

```mermaid

graph LR

A[原始模拟信号] -->|自适应采样| B[优化后的数字样本]

B -->|压缩感知技术| C[压缩后的数字信号]

C -->|机器学习算法| D[增强的数字数据流]

```

## 3.2 算法优化策略

算法优化是提升数字化系统性能的关键手段,它可以通过减少计算复杂度、优化算法结构和减少资源消耗来实现。

### 3.2.1 算法效率提升的基本原理

算法效率的提升涉及理论和实践的结合。理论上,优化的目标是减少算法的复杂度,实践中则通过特定技术如循环展开、向量化计算和使用更高效的数据结构来达到这一目的。

### 3.2.2 实例:减少计算复杂度的优化方法

以快速傅里叶变换(FFT)为例,它是数字信号处理中减少计算复杂度的典型应用。FFT将O(N^2)时间复杂度的离散傅里叶变换(DFT)降至O(N log N)。下面展示了一个FFT算法的代码实现,它使用了经典的Cooley-Tukey算法。

```python

def FFT(X):

N = len(X)

if N <= 1: return X

even = FFT(X[0::2])

odd = FFT(X[1::2])

T = [exp(-2j * np.pi * k / N) * odd[k] for k in range(N // 2)]

return [even[k] + T[k] for k in range(N // 2)] + [even[k] - T[k] for k in range(N // 2)]

```

## 3.3 算法的硬件加速

为了进一步提升算法的性能,硬件加速成为了数字信号处理领域的新趋势。利用专用的硬件结构如FPGA和GPU可以显著提高算法执行速度。

### 3.3.1 硬件加速的原理和优势

硬件加速原理在于将复杂的算法映射到专用的硬件电路中,利用硬件并行处理的能力来提高效率。这种方式相较于传统的CPU运算,在执行特定算法时可以获得数十倍甚至数百倍的速度提升。

### 3.3.2 硬件加速技术的实际应用案例

以数字信号处理中的卷积操作为例,通常使用FFT进行加速。下面是一个使用GPU进行卷积加速的Python代码示例,通过NVIDIA的cuFFT库来实现:

```python

import numpy as np

import cupy as cp

import cucuda

def convolve_gpu(signal, kernel):

n = len(signal)

f_signal = cp.fft.fft(signal)

f_kernel = cp.fft.fft(kernel)

result = cp.fft.ifft(f_signal * f_kernel).real

return result

# GPU加速卷积

signal_gpu = cp.array(signal)

kernel_gpu = cp.array(kernel)

result_gpu = convolve_gpu(signal_gpu, kernel_gpu)

```

在本小节中,通过讲述数字化算法的优化策略以及硬件加速技术的应用,展示了如何提升算法效率和性能。这些技术不仅在理论上具有深远的影响,在实际应用中也带来了显著的性能提升。在接下来的章节中,我们将探讨综合系统优化案例分析,并展望数字化技术的未来发展方向。

# 4. 综合系统优化案例分析

## 4.1 综合系统优化理论基础

### 4.1.1 系统优化的目标和指标

系统优化的目标是确保整个系统的高效、稳定和可扩展性。为达到这些目标,需要设定一系列可量化的性能指标。这些指标包括但不限于系统吞吐量、延迟、可靠性和资源利用率。系统吞吐量衡量的是单位时间内系统能处理的数据量,它是衡量系统性能的重要指标之一。延迟则涉及到系统响应请求所需的时间,包括数据传输延迟和处理延迟。可靠性则反映了系统的故障频率和数据准确度,它关系到系统在长时间运行中的稳定性。

### 4.1.2 系统集成的挑战与对策

系统集成是将多个不同的子系统和组件整合到一起,以形成一个统一的、高效运行的整体的过程。这一过程面临的挑战包括接口不一致、数据不兼容、系统性能不均衡等。对策包括制定严格的接口协议规范、使用标准化的数据格式、进行彻底的性能测试以及及时调整负载分配策略。

## 4.2 实际案例分析

### 4.2.1 典型案例的系统架构和问题诊断

考虑一个典型的数字化系统,如工业级的数据采集与处理平台。其系统架构可能包括传感器网络、数据采集装置、中央处理单元以及存储与分析系统。在问题诊断阶段,我们可能会识别出数据采集装置的瓶颈问题,即数据传输速率不足以满足实时处理的需求。

### 4.2.2 解决方案与优化效果评估

为了解决数据传输瓶颈问题,可以考虑增加并行数据通道、提高ADC的采样率或使用更高效率的数据压缩算法。例如,采用多通道并行采样技术可以显著提高数据传输速率。在实施了这一解决方案后,我们需要通过一系列性能测试来评估优化效果。测试结果表明,系统吞吐量提高了30%,同时系统的整体延迟降低了20%。

## 4.3 案例中的创新点和趋势

### 4.3.1 创新技术的应用实例

在数字化系统中应用创新技术可以显著提升性能。例如,利用机器学习算法对数据进行预处理和特征提取,可以大幅减少后端处理的数据量和计算负担。这样的实例显示了将传统信号处理技术与现代机器学习方法相结合的巨大潜力。

### 4.3.2 数字化处理的未来发展趋势

未来数字化处理的趋势可能包括算法和硬件设计的深度融合、人工智能在信号处理中的广泛应用、以及新型材料和量子计算在提升系统性能方面的潜力。这些趋势预示着数字化处理领域将朝着更加智能、高效和可持续的方向发展。

# 5. 未来展望与挑战

随着科技的飞速发展,模拟信号数字化技术也在不断地革新。在这一过程中,技术创新不仅带来了前所未有的机遇,同时也带来了一系列挑战。本章将探讨技术进步对模拟信号数字化的影响,以及当前面临的挑战与可能的应对策略。

## 技术进步对模拟信号数字化的影响

### 5.1.1 新材料和新技术的应用前景

新材料和新技术的应用已经在模拟信号数字化领域展现出强大的潜力。例如,石墨烯的引入为高性能ADCs提供了可能,其高电子迁移率使得转换器的速度和效率得到显著提高。此外,MEMS(微机电系统)技术的进步也使得传感器和执行器更加微型化、高效化,为数字化硬件的小型化和集成化提供了新的路径。

### 5.1.2 技术进步带来的性能提升潜力

技术进步不仅促进了数字化硬件的小型化和集成化,还为性能的大幅提升打开了大门。以量子计算为例,它有潜力彻底改变模拟信号数字化的处理方式,量子比特的并行处理能力将使复杂信号的实时处理成为可能。另一方面,深度学习技术的进步为信号解析和数据挖掘提供了更准确、更快速的算法支持。

## 当前面临的挑战与应对策略

### 5.2.1 当前数字化处理中的主要问题

尽管数字化技术取得了显著的进步,但仍面临一系列挑战。首先是数据量的爆炸式增长,这对存储和处理能力提出了更高要求。其次是实时处理的需求日益增加,尤其是在工业控制和自动驾驶领域。最后,安全性和隐私问题也是数字化进程中不可忽视的挑战。

### 5.2.2 针对挑战的解决方案与建议

为了应对上述挑战,研究者和工程师们正在积极寻找解决方案。在处理大数据问题上,边缘计算的应用能够减轻云端的压力,同时提供更快速的响应。为满足实时处理需求,开发更高效的算法以及专用的硬件加速器是必要的。同时,加强数据加密技术和隐私保护措施也是确保数字化处理安全的重要策略。

随着技术的不断进步,数字化处理将变得更加高效、智能和安全。然而,这一过程也需要不断学习和适应新技术,以及对现有技术的持续改进。未来数字化的路径充满了未知,但也同样充满了希望和挑战。

0

0