GRU 的长依赖问题:如何解决序列长时距离依赖性

发布时间: 2024-04-14 16:55:36 阅读量: 229 订阅数: 85

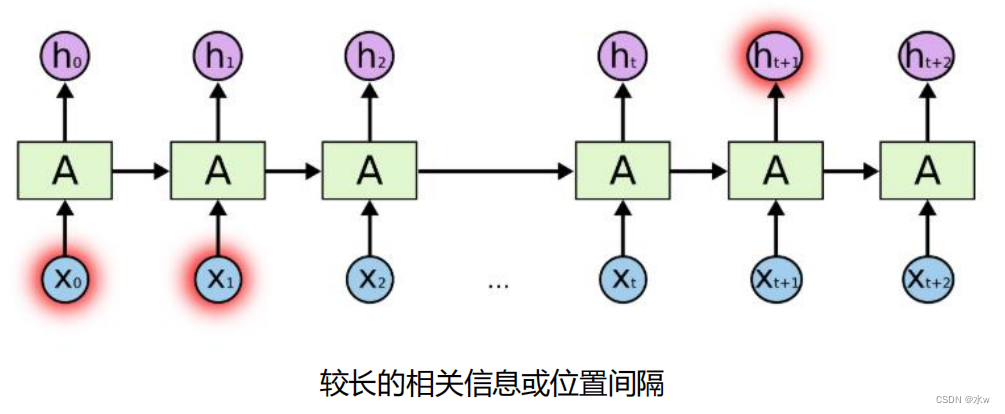

# 1. 深度学习中的长时依赖性问题

深度学习中的长时依赖性问题一直是一个备受关注的话题。在处理序列数据时,长时依赖性指的是隔着多个时间步之后的信息对当前预测结果产生影响。相比之下,短时依赖性只涉及相邻时间步的信息传递。长时依赖性对于序列数据的处理至关重要,然而梯度消失和梯度爆炸问题却给深度学习模型的训练带来了挑战。这两个问题主要是由于深层网络中的反向传播过程中梯度不稳定导致的,影响了信息在网络中的传播。因此,为了解决这一问题,研究人员提出了许多改进方法,其中包括门控循环单元(GRU)和长短时记忆网络(LSTM)。接下来我们将深入了解GRU网络的结构与作用机制。

# 2. GRU网络的结构与作用机制

### 2.1 GRU的基本结构

**2.1.1 门控单元的设计原理**

在GRU网络中,门控单元的设计原理是关键所在。GRU内部包含了更新门和重置门两种类型的门控单元,通过这两个门控单元的控制,可以有效地处理输入序列中的长依赖性。更新门决定了进入记忆单元的信息量,而重置门则决定了如何利用历史信息来更新当前的记忆状态。

门控单元的设计使得GRU网络可以在不引入额外的cell状态的情况下,兼具了LSTM中遗忘门和输入门的功能,简化了模型结构,提高了训练效率。

**2.1.2 记忆单元的更新机制**

除了门控单元,GRU中的记忆单元也起着重要的作用。记忆单元通过记忆当前状态并更新为新状态的方式,帮助网络捕捉到序列中的重要信息。通过巧妙的设计,GRU能够在不同时间步间有效地传递信息,解决长依赖性问题。

记忆单元的更新机制保留了时间序列中的相关信息,同时通过门控单元的调控,实现了信息的筛选和更新,进一步加强了GRU网络处理长依赖性的能力。

### 2.2 GRU网络的参数与训练方法

**2.2.1 参数初始化和学习率调整**

在构建GRU网络时,参数的初始化和学习率的调整是非常重要的步骤。良好的参数初始化能够帮助网络更快地收敛,减少训练时间。而合适的学习率则能够平衡模型的训练速度和精度,避免过拟合或欠拟合的情况发生。

在实际操作中,一般采用Xavier或He等初始化方法,结合学习率衰减策略,动态地调整学习率的大小,使得模型在训练过程中能够收敛到最优解。

**2.2.2 训练数据的预处理和特征工程**

除了参数初始化和学习率调整外,对训练数据的预处理和特征工程也是至关重要的。在进行训练之前,需要对数据进行标准化、归一化等处理,以便网络更好地学习到数据的分布规律。

同时,在特征工程中,可以利用领域知识提取更加有效的特征信息,帮助模型更好地理解输入数据。在GRU网络中,合理的数据预处理和特征工程能够有效地提升模型的泛化能力,提高长依赖性问题的解决效果。

```python

# 示例代码:GRU网络的参数初始化

import torch

import torch.nn as nn

class GRUModel(nn.Module):

def __init__(self, input_size, hidden_size, num_layers, output_size):

super(GRUModel, self).__init__()

self.hidden_size = hidden_size

self.num_layers = num_layers

self.gru = nn.GRU(input_size, hidden_size, num_layers, batch_first=True)

self.fc = nn.Linear(hidden_size, output_size)

def init_hidden(self, batch_size):

```

0

0