GRU 与 LSTM:比较两种常见的循环神经网络结构

发布时间: 2024-04-14 16:50:38 阅读量: 332 订阅数: 71

# 1.1 什么是神经网络

神经网络是一种模仿人类神经系统构建的计算模型,由大量相互连接的神经元构成。每个神经元接收输入,经过加权和激活函数处理后输出。神经网络的结构包括输入层、隐藏层和输出层,信息通过前馈传播在层与层之间传递。通过训练调整神经元之间的连接权重,使网络学习数据的模式和特征,实现分类、回归等任务。神经网络在图像识别、语音识别、自然语言处理等领域有广泛应用。

前馈神经网络是最简单的神经网络结构,信息单向传递,没有循环连接,适用于一些简单的任务。激活函数常用的有Sigmoid、ReLU等,用来引入非线性,增加模型的表达能力。

神经网络的深度学习应用近年来得到快速发展,提升了图像识别、自然语言处理等任务的性能。

# 2.1 LSTM网络架构

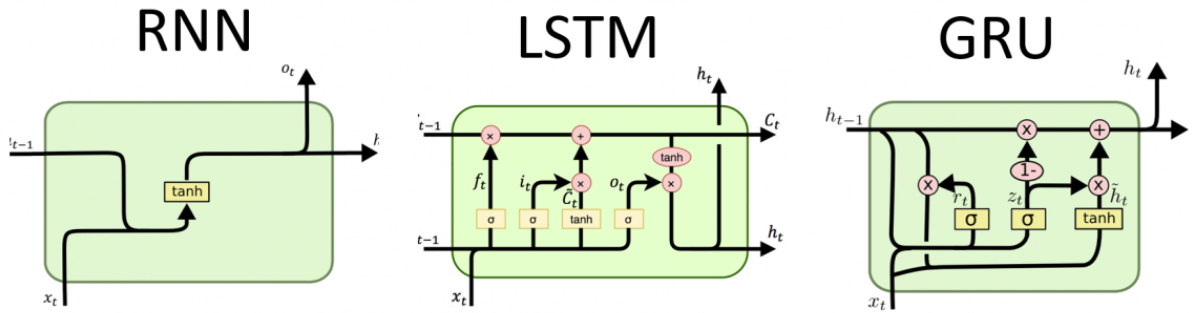

长短期记忆网络(LSTM)是一种特殊的循环神经网络,其设计初衷是能够更好地处理长序列数据,并解决传统 RNN 在长依赖建模中的困难。在 LSTM 中,每个单元内部包含记忆细胞,以及三个控制门:遗忘门、输入门和输出门。

#### 2.1.1 LSTM中的单元结构

LSTM 单元包含记忆细胞 $C$,遗忘门 $f$、输入门 $i$、输出门 $o$,以及激活函数。记忆细胞 $C$ 用于存储信息,遗忘门 $f$ 控制是否保留之前的信息,输入门 $i$ 控制新信息的输入,输出门 $o$ 控制输出的信息。这些门的运作机制使得 LSTM 能够长时间记住之前的信息,同时筛选新的信息。

#### 2.1.2 LSTM中的三个门:遗忘门、输入门、输出门

- 遗忘门 $f$:通过对应的激活函数,遗忘门决定丢弃前一时刻的记忆细胞中的哪些信息,并保留哪些信息。

- 输入门 $i$:控制当前时刻新的信息输入到记忆细胞中的程度,决定了哪些信息会被写入记忆细胞。

- 输出门 $o$:决定输出记忆细胞的哪些信息到当前时刻的隐藏状态。

#### 2.1.3 LSTM的记忆细胞

在 LSTM 中,记忆细胞 $C$ 负责传递信息,通过各个门的控制来调整细胞状态的更新。门的激活函数可以决定保留多少信息,从而解决了长序列数据处理中的梯度消失或梯度爆炸问题。

### 2.2 LSTM网络的训练

LSTM 网络的训练通常使用梯度下降算法来最小化损失函数,以更新网络参数。在训练过程中,需要注意梯度消失和梯度爆炸问题,以及如何解决这些问题。

#### 2.2.1 损失函数与梯度下降算法

在 LSTM 网络中,常用的损失函数包括均方误差(MSE)和交叉熵损失。梯度下降算法的目标是找到使损失函数最小化的参数值。通过计算损失函数对参数的梯度,可以更新参数值。

```python

# 伪代码示例:梯度下降算法

for epoch in range(num_epochs):

# 前向传播

# 计算损失函数

# 反向传播

# 更新参数

```

#### 2.2.2 反向传播过程

反向传播是训练神经网络的关键步骤,通过链式法则计算各层参数的梯度,并利用梯度下降算法更新参数。在 LSTM 中,反向传播过程包括计算输出层和隐藏层的梯度,再将梯度传播至每个时间步。

```python

# 伪代码示例:LSTM反向传播过程

def backward_pass(inputs, targets):

# 计算输出层梯度

# 反向传播至隐藏层

# 反向传播至每个时间步

# 更新参数

```

#### 2.2.3 梯度消失与梯度爆炸问题

在训练深层神经网络时,长序列数据容易导致梯度消失或梯度爆炸问题,影响模型的训练效果。LSTM 的门结构有效地解决了梯度消失或梯度爆炸问题,通过门控机制来调整梯度的传播,从而更好地训练长序列数据。

```mermaid

graph LR

A[输入数据]

B[前向传播]

C[计算损失]

D[反向传播]

E[更新参数]

A --> B --> C --> D --> E

```

在训练 LSTM 网络时,需要综合考虑损失函数、梯度下降算法以及梯度稳定性等因素,以获得更好的训练效果。

# 3. 门控循环单元(GRU)网络

### 3.1 GRU网络架构

门控循环单元(Gated Recurrent Unit,简称GRU)是一种类似于LSTM的循环神经网络结构,具有更新门和重置门。GRU内部计算简洁高效,参数量少,容易训练。与LSTM相比,GRU没有显式的记忆单元状态,更容易并行化运算。

#### 3.1.1 GRU中的更新门和重置门

GRU包含更新门(Update Gate)和重置门(Reset Gate)两个关键门控机制。更新门控制信息的更新程度,重置门控制历史信息的遗忘程度。这两个门共同决定了当前时刻的隐藏状态。

#### 3.1.2 GRU内部计算

GRU通过简单的门控机制更新隐藏状态,避免了LSTM中的记忆单元,由更新门和重置门共同调控输入、遗忘和输出的功能。GRU采用更少的参数实现了类似的效果。

#### 3.1.3 GRU与LSTM的异同点

相比LSTM,GRU更简化,减少了记忆单元,同时具有更少的参数量。GRU内部计算简单,训练速度更快,但在处理长期依赖性问题上略逊于LSTM。

### 3.2 GRU网络的训练

门控循环单元网络的训练过程涉及反向传播算法、梯度裁剪等技术。这些技术帮助网络更好地学习序列数据的长期依赖关系,并避免梯度消失或梯度爆炸问题。

#### 3.2.1 反向传播算法

GRU网络通过反向传播算法更新参数,优化损失函数。反向传播通过梯度下降不断调整模型参数,提升网络预测准确性。

#### 3.2.2 梯度裁剪

梯度裁剪是一种常用的控制梯度过大问题的技术,它可以避免梯度爆炸,保证训练过程的稳定性,提高模型的泛化能力。

#### 3.2.3 GRU的收敛性分析

GRU网络的收敛性是指在训练过程中损失函数能够逐渐减小并收敛到局部最优解。梯度裁剪等技术有助于提高网络的收敛性,加速模型的学习过程。

### 3.3 GRU的优势与劣势

门控循环单元相较于LSTM在一些方面具有明显的优势,但也存在一定的劣势。了解这些优势劣势有助于选用适合具体任务的循环神经网络结构。

#### 3.3.1 训练速度比较

GRU拥有更简洁的结构和更少的参数,因此在训练速度上通常优于LSTM。对于大规模数据集和长序列的训练任务,GRU可能更高效。

#### 3.3.2 参数数量比较

由于减少了记忆单元,GRU的参数量较少,更适合资源受限的情况。在一定程度上降低了过拟合的风险。

#### 3.3.3 过拟合问题比较

GRU相对于LSTM在建模长期依赖性上略显不足,可能存在一定程度的过拟合问题。在处理需要长期记忆的复杂序列任务时,需谨慎选择合适的模型结构。

通过以上内容的详细分析,我们可清晰地了解门控循环单元(GRU)网络的架构、训练方法,以及与LSTM的比较优势与劣势。

# 4. 结语

### LSTM与GRU的优缺点比较

LSTM和GRU是两种常见的循环神经网络结构,它们在处理时间序列数据时表现出色。下面我们将比较它们在记忆能力和训练效率方面的异同点。

#### LSTM与GRU的记忆能力比较

LSTM网络通过更复杂的记忆细胞和门控结构,能够更好地捕捉长期依赖关系。它的遗忘门、输入门和输出门能够有效地控制信息的流动,同时记忆细胞可以在长时间内保持信息。相比之下,GRU网络简化了门控结构,只有更新门和重置门,使得网络的记忆能力相对较弱。

#### LSTM与GRU的训练效率比较

在训练效率方面,由于LSTM网络的复杂结构和参数较多,导致其在训练过程中消耗更多的时间和计算资源。相比之下,GRU网络的结构相对简单,参数量更少,因此在训练过程中速度较快,且相对容易收敛。

### 循环神经网络未来的发展趋势

循环神经网络在处理序列数据上具有独特优势,但仍存在一些问题和挑战。未来的发展方向将主要集中在以下几个方面:

1. **长期依赖建模问题**

长时间的依赖关系对于传统的循环神经网络来说是一个挑战,容易导致梯度消失或爆炸。未来的研究将更加关注如何更好地处理长期依赖,提高模型的记忆能力。

2. **深度循环神经网络的发展**

随着深度学习的发展,深度循环神经网络作为深度模型的重要组成部分,未来将更加注重模型的深度和复杂度,以提高对序列数据的建模能力。

3. **循环神经网络与注意力机制结合的研究**

注意力机制能够有效提取输入序列中的关键信息,结合循环神经网络可以进一步提升模型的表现。未来研究将更多地探索这两者结合的方式,以提高模型的性能和泛化能力。

以上是关于LSTM与GRU的比较以及未来循环神经网络发展趋势的相关内容,希望对读者更好地理解和应用循环神经网络提供参考。

# 5. 实例分析:利用LSTM与GRU进行文本情感分类

在本章中,我们将使用长短期记忆(LSTM)和门控循环单元(GRU)这两种不同类型的循环神经网络,来进行文本情感分类的实例分析。文本情感分类是自然语言处理中常见的任务,旨在判断一段文本所表达的情感是正向、负向还是中性,是情感分析和文本分类领域的重要研究方向之一。我们将通过一个情感分类的数据集,利用LSTM和GRU模型进行训练和评估,并比较它们在情感分类任务上的表现。

### 数据集介绍

我们选取了一个包含大量电影评论的数据集,每条评论都标注了情感极性,包括积极、消极和中性三类。数据集共包含了10000条评论,我们将其分为训练集和测试集,用于模型训练和评估。

### 文本预处理

在进行模型训练前,我们需要对文本数据进行处理,包括分词、文本向量化等操作。这里我们使用了Tokenizer对文本进行分词处理,并将文本转换为定长序列,以便输入到循环神经网络中进行处理。

```python

# 文本预处理示例代码

from keras.preprocessing.text import Tokenizer

from keras.preprocessing.sequence import pad_sequences

max_words = 10000

max_len = 100

tokenizer = Tokenizer(num_words=max_words)

tokenizer.fit_on_texts(texts)

sequences = tokenizer.texts_to_sequences(texts)

X = pad_sequences(sequences, maxlen=max_len)

```

### 模型构建与训练

我们分别构建了基于LSTM和GRU的文本情感分类模型。模型结构包括Embedding层、循环神经网络层和全连接层。我们使用交叉熵损失函数和Adam优化器进行模型训练。

LSTM模型结构示例:

```python

# LSTM模型构建示例代码

from keras.models import Sequential

from keras.layers import Embedding, LSTM, Dense

model_lstm = Sequential()

model_lstm.add(Embedding(max_words, 64, input_length=max_len))

model_lstm.add(LSTM(64, dropout=0.2, recurrent_dropout=0.2))

model_lstm.add(Dense(3, activation='softmax'))

model_lstm.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

model_lstm.fit(X_train, y_train, epochs=5, batch_size=32, validation_data=(X_test, y_test))

```

GRU模型结构示例:

```python

# GRU模型构建示例代码

from keras.models import Sequential

from keras.layers import Embedding, GRU, Dense

model_gru = Sequential()

model_gru.add(Embedding(max_words, 64, input_length=max_len))

model_gru.add(GRU(64, dropout=0.2, recurrent_dropout=0.2))

model_gru.add(Dense(3, activation='softmax'))

model_gru.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

model_gru.fit(X_train, y_train, epochs=5, batch_size=32, validation_data=(X_test, y_test))

```

### 模型评估与比较

我们将训练好的LSTM和GRU模型分别在测试集上进行评估,比较它们在准确率、召回率等指标上的表现。通过实验结果分析,我们能够得出不同类型循环神经网络在文本情感分类任务上的优缺点,并结合实验数据给出相应建议。

Mermaid 流程图示例:

```mermaid

graph LR

A[数据集] --> B(文本预处理)

B --> C{LSTM or GRU}

C --> D[模型训练]

D --> E[模型评估与比较]

E --> F[结果分析]

```

通过本章的实例分析,我们可以更加深入地理解LSTM和GRU在文本情感分类任务中的应用,以及它们之间的优劣势比较。同时,也可以为我们在实际项目中选择合适的循环神经网络模型提供一定的参考。

以上是关于利用LSTM与GRU进行文本情感分类的实例分析章节内容。

0

0