递归任务的高性能解决方案:ForkJoinPool构建指南与最佳实践

发布时间: 2024-10-22 07:29:32 阅读量: 24 订阅数: 34

C语言中的递归与迭代:深入理解与实践

# 1. ForkJoinPool简介与基本原理

ForkJoinPool是Java并发框架中的一个核心组件,它在处理可以递归拆分成小任务的计算密集型应用中表现优异。其基本原理是通过任务的分治策略,将大任务分割成小任务,然后使用多线程并发执行,最终合并结果。这种模式特别适合那些需要将任务分解并重新组合的场景,如快速排序、树的遍历等。ForkJoinPool的实现基于一种特殊的工作窃取算法,这使得线程池中的线程可以尽可能地保持忙碌,从而提高CPU利用率,缩短任务处理时间。接下来,我们将深入探讨ForkJoinPool的架构细节、核心组件以及如何有效地利用这些特性来提升应用性能。

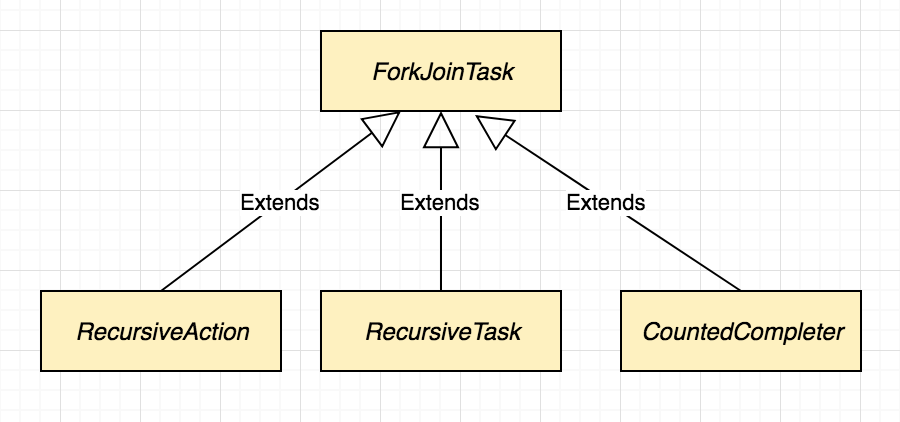

# 2. ForkJoinPool核心组件与架构解析

## 2.1 ForkJoinPool工作原理

### 2.1.1 工作窃取算法的实现机制

工作窃取算法允许空闲线程从繁忙线程的任务队列尾部窃取任务,以确保每个线程都尽可能地忙碌。ForkJoinPool内部维护了一个双端队列数组,每个线程拥有一个私有的任务队列,用于存放提交给该线程的任务。当一个线程执行完自己的任务队列中的任务时,如果其他线程的任务队列不为空,它会尝试窃取工作以保持忙碌状态。

工作窃取机制的实现基于几个关键步骤:

1. 当线程尝试获取新任务时,首先检查自己的任务队列,如果队列为空,则尝试窃取其他线程的队列尾部任务。

2. 窃取过程是原子操作,确保线程安全。ForkJoinPool通过CAS(Compare-And-Swap)操作实现队列的原子性操作。

3. 线程会在一个无限循环中不断尝试获取新任务,直到其任务队列非空或没有可窃取的任务。

代码块展示工作窃取的简化逻辑:

```java

while (true) {

WorkQueue q; // 任务队列

int s = indexFor(id, qarray.length); // 计算线程在队列数组中的索引

ForkJoinTask<?>[] a; ForkJoinTask<?> t; int m;

if ((a = qarray[s]).length != 0) {

if ((t = q.pop()) != null) {

q.exec(t); // 执行任务

continue;

}

}

else if ((m = qarray.length) > 1) {

int r = 0;

for (int origin = s, k = 1; k < m; k++) {

int j = (s + (k << 1) - 1) & (m - 1);

WorkQueue qj; ForkJoinTask<?>[] aj; ForkJoinTask<?> tj;

if ((j >= 0 && (qj = qarray[j]) != null && (tj = qj.peek()) != null) ||

(j != origin && (aj = qarray[(j = (j + m - 1) & (m - 1))]) != null && (tj = aj.peek()) != null)) {

if (qarray[j].claimAndPop(tj)) {

q.exec(tj);

break;

}

}

}

}

else if (steal(q, s)) {

continue;

}

else if (activeCount < 0) {

break;

}

}

```

在上述代码中,线程首先尝试在自己的队列中获取任务,如果没有则尝试窃取其他队列的任务。该逻辑保证了ForkJoinPool的高效运行,尤其是在面对大量小任务的场景下。

### 2.1.2 ForkJoinPool的任务管理策略

ForkJoinPool使用一个分层任务队列(数组)来管理所有任务,通过工作窃取算法使得任务得到高效分配和执行。任务管理策略涉及任务的提交、执行、窃取以及完成后的任务处理。

ForkJoinPool的核心任务管理策略如下:

1. **任务提交**:向ForkJoinPool提交的任务首先被封装成ForkJoinTask对象,然后加入到队列中等待处理。

2. **任务执行**:线程从自己的队列中获取任务执行。如果队列为空,线程会尝试从其他线程的队列尾部窃取任务。

3. **任务窃取**:当线程的队列为空时,它会随机选择另一个线程的任务队列并尝试从中窃取一个或多个任务。

4. **任务完成处理**:任务执行完成后,如果任务有返回值,则返回给调用者。任务执行结果也会被标记为“已完成”,以便于其他依赖该任务结果的任务获取结果。

### 2.1.2 ForkJoinPool的任务管理策略分析

ForkJoinPool设计了一套灵活的任务管理策略来高效地处理并发任务。了解这些策略有助于更好地使用ForkJoinPool来提升应用程序的性能。

任务提交是通过将任务添加到ForkJoinPool的全局任务队列开始的,然后由池中工作线程自行获取并执行。ForkJoinPool会尽量保持工作线程的忙碌状态,实现任务的快速处理和高效的资源利用。

任务执行阶段,线程从自己的双端队列中获取任务进行处理。在执行中,线程会根据自己的工作状态决定是否需要从其他线程的队列中窃取任务,确保资源的有效利用。线程窃取任务时,会从另一个线程队列的末尾窃取,以减少对其他线程工作的影响。

任务完成处理阶段,当一个任务执行完毕后,ForkJoinPool会将其状态更新为完成,并将结果返回给任务的调用者。如果一个任务返回了结果,这个结果可以被其他正在等待该结果的任务所使用。此外,完成的任务会被标记为“可用”,并放入线程的任务队列中,以便之后可能的任务重用。

### 2.2 ForkJoinPool的线程管理

#### 2.2.1 线程的创建与池化

ForkJoinPool的线程管理策略是其性能优化的关键。它采用了懒加载和缓存策略,意味着线程不是在初始化ForkJoinPool时立即创建,而是根据任务需求动态地创建线程,并在一段时间不活跃后终止线程。

线程的创建过程如下:

1. **懒加载**:ForkJoinPool中的线程通常在首次提交任务时创建,这些线程会被添加到一个共享的空闲线程列表中。

2. **工作窃取**:当线程池中的线程执行完自己的任务队列后,会从其他线程的队列尾部窃取任务继续工作。

3. **线程缓存**:长时间不活跃的线程会被标记为可回收,之后会被池回收,以便未来使用。

在Java中,线程的创建和管理是由ForkJoinPool内部的内部类ForkJoinWorkerThread负责。ForkJoinPool通过在内部维护一个 ForkJoinWorkerThread 实例池来实现线程的快速重用。

#### 2.2.2 线程池的动态调整机制

ForkJoinPool的线程池会根据实际工作负载动态调整线程数量。这个机制确保了在任务负载高时能够增加线程数量,而任务负载低时能够减少线程数量,从而节省资源。

线程池动态调整的工作原理如下:

1. **线程数量的变化**:ForkJoinPool会在内部监控任务的执行情况,并根据需要动态地增加或减少线程数量。

2. **闲置线程的处理**:当线程长时间闲置时,ForkJoinPool会将这些线程标记为可回收,并最终回收这些线程资源。

3. **线程的维护**:ForkJoinPool使用一个线程维护机制,以保持线程池的活性。它会保留一定数量的线程在空闲状态,以便快速响应新任务的到来。

### 2.3 ForkJoinPool的异常处理

#### 2.3.1 任务执行中的异常捕获

在ForkJoinPool中,任务执行过程中抛出的异常会被封装在ForkJoinTask的异常容器中。这些异常通常不会立即暴露给提交任务的线程,而是通过ForkJoinTask的get方法或者相关的方法间接处理。

异常处理的详细流程如下:

1. **异常封装**:当任务中的代码抛出异常时,ForkJoinTask会捕获这些异常,并将它们封装在自己的异常字段中。

2. **异常获取**:当任务调用get方法获取执行结果时,如果任务执行中出现了异常,该异常会被重新抛出,调用者可以通过try-catch结构捕获并处理这些异常。

为了理解异常捕获的代码示例,请看以下代码段:

```java

class MyTask extends ForkJoinTask<Void> {

@Override

public Void getRawResult() {

// 此方法可能抛出异常

throw new RuntimeException("Task failed");

}

@Override

protected boolean exec() {

getRawResult(); // 此调用会抛出异常

return true;

}

}

ForkJoinPool pool = new ForkJoinPool();

Future<Void> future = pool.submit(new MyTask());

try {

future.get(); // 将重新抛出异常

} catch (ExecutionException e) {

Throwable cause = e.getCause(); // 获取实际的异常

cause.printStackTrace();

}

```

#### 2.3.2 异常处理的最佳实践

处理ForkJoinPool中的异常需要程序员遵守一些最佳实践,以确保程序的健壮性。以下是一些推荐的做法:

1. **异常封装**:将业务逻辑中的异常封装在ForkJoinTask的getRawResult方法中,确保异常能够被外部正确捕获并处理。

2. **异常捕获**:在调用ForkJoinTask的get方法时,使用try-catch来捕获ExecutionException,然后获取并处理实际的业务异常。

3. **异常传递**:如果异常不需要在ForkJoinTask中处理,可以将异常直接抛出,由调用者负责捕获和处理。

针对异常处理的最佳实践,下面是一个更具体的代码示例:

```java

try {

ForkJoinTask<?> task = new MyTask();

pool.submit(task);

task.join(); // join方法会等待任务执行完成,如果任务执行过程中出现异常,则会抛出ExecutionException

} catch (ExecutionException e) {

Throwable cause = e.getCause();

// 此处处理实际业务异常

if (cause instanceof MyBusinessException) {

// 处理MyBusinessException

}

}

```

在上述代码中,我们首先创建并提交一个ForkJoinTask任务,并使用join方法等待任务执行完成。当任务执行中出现异常时,通过catch捕获ExecutionException,并处理实际业务异常。

# 3. ForkJoinPool的高级特性

在多线程编程中,ForkJoinPool是一种强大的并发框架,它不仅提供了基础的线程池功能,还拥有许多高级特性,使其在处理可以分割的计算密集型任务时表现出色。本章节将深入探讨ForkJoinPool的三个核心高级特性:并行度调节、任务分割策略以及内存管理。

## 3.1 ForkJoinPool的并行度调节

ForkJoinPool的一个重要特性是其可调节的并行度,它允许开发者针对不同的工作负载和硬件环境定制并发执行的程度。

### 3.1.1 如何合理设置并行度

并行度决定了ForkJoinPool能够同时运行的任务数量上限。合理的并行度设置对于提升并发性能至关重要。过高的并行度可能导致线程切换开销增大,而过低则可能无法充分利用多核处理器的计算资源。

在设置并行度时,应考虑以下因素:

- **可用核心数**:处理器的核心数是决定并行度的基础。例如,一个四核CPU最多能同时运行四个线程。

- **任务特性**:如果任务是计算密集型的,可能需要较少的并行度;如果任务是I/O密集型的,可能需要较高的并行度。

- **资源竞争**:考虑其他正在运行的应用对CPU资源的需求,避免过度竞争导致的性能问题。

通常情况下,ForkJoinPool允许并行度在1到处理器核心数之间动态调整。可以通过`Runtime.availab

0

0