Spark Streaming实时数据挖掘:原理、应用与优化策略

发布时间: 2024-09-08 11:22:09 阅读量: 109 订阅数: 54

# 1. Spark Streaming概述

在当今数据驱动的时代,实时数据处理成为了现代IT架构中不可或缺的一部分。Apache Spark Streaming应运而生,作为Spark核心组件之一,它将实时数据流处理带入了一个新的高度。本章将简要介绍Spark Streaming的基本概念、起源以及它如何成为大规模数据处理的首选工具。

## 1.1 实时数据处理的必要性

在互联网应用、物联网(IoT)设备和各种在线服务中,数据以极快的速度生成并需要立即处理。实时数据处理可以提供即时的分析,从而帮助企业快速做出数据驱动的决策。Spark Streaming正是针对这种需求而设计,它能够从多种数据源实时地接收数据,并进行处理以得到洞察。

## 1.2 Spark Streaming的起源与发展

最初由加州大学伯克利分校的AMPLab开发,Spark Streaming借鉴了Spark强大的处理能力和容错机制,逐步发展成为实时数据流处理的行业标准。Spark Streaming提供了一个高吞吐量、可扩展、容错的实时数据流处理框架。它的设计目标是将批处理和实时数据处理的界限模糊化,让开发者可以使用统一的API进行两种类型的处理。

## 1.3 Spark Streaming的特点

Spark Streaming的主要特点包括:

- 高吞吐量:通过并行处理和批处理模型,它能够处理大规模数据流。

- 易于使用:基于Spark的编程模型,用户可以轻松地将批处理逻辑转换为流处理逻辑。

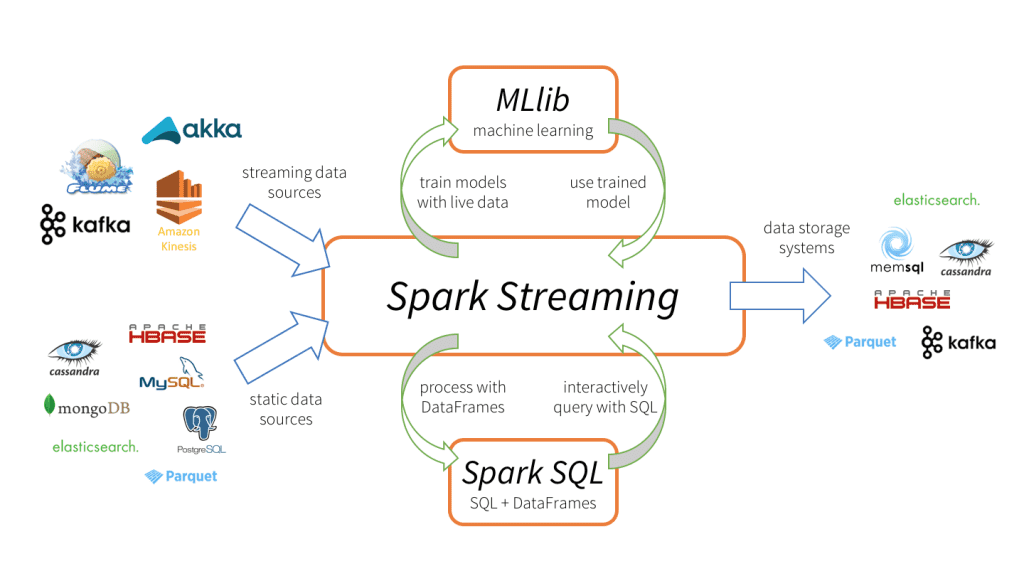

- 灵活性:支持多种数据源和输出系统,使得数据整合变得容易。

- 可扩展性:它充分利用了Spark的分布式计算能力,可以在多个集群上水平扩展。

- 容错性:由于其基于RDD(弹性分布式数据集)的操作,保证了数据即使在节点故障时也不会丢失。

在接下来的章节中,我们将深入探讨Spark Streaming的理论基础、架构组件、以及如何在实际场景中应用和优化这一强大的工具。

# 2. Spark Streaming的理论基础

## 2.1 数据流处理原理

### 2.1.1 微批处理模型

在传统批处理系统中,处理数据需要等待整个数据集完成后再进行。这种方式虽然可靠,但对实时性的要求并不满足。Spark Streaming 为了解决这个问题,引入了微批处理模型。微批处理模型是一种在批处理和流处理之间取得平衡的方案,通过将流数据切分成小批处理块,并在每个时间窗口上运行批处理作业来实现。

在微批处理模型中,Spark Streaming 将实时数据流分成一系列小的批次,每个批次都由一个 Spark 作业处理。Spark 作业的执行使用了 Spark 的弹性分布式数据集(RDDs)模型,这确保了在处理大规模数据时的可靠性和容错性。为了提升处理速度,数据流以时间序列的形式到达,每个批次的处理时间通常很短,一般为几秒钟,从而实现近似实时的处理效果。

**代码逻辑分析:**

在微批处理模型中,一个典型的 Spark Streaming 程序会定期创建输入数据流的RDDs,然后将这些RDDs发送到一个任务调度器,该调度器执行定义在这些RDDs上的转换操作。

```scala

// Java代码示例

JavaDStream<String> lines = jssc.textFileStream(dataDirectory);

JavaDStream<String> words = lines.flatMap(x -> Arrays.asList(x.split(" ")).iterator());

words.saveAsTextFiles(outputDirectory);

```

在这个例子中,我们创建了一个文本文件的数据流`lines`,然后使用`flatMap`操作将其分解成单词流`words`。之后,我们使用`saveAsTextFiles`将结果保存到指定目录。

**参数说明:**

- `textFileStream`是读取文本文件的DStream操作,它会定期检查并读取新数据。

- `flatMap`是一个转换操作,它将每个输入项映射到0或多个输出项。

- `saveAsTextFiles`是输出操作,用于将DStream内容写入到文件系统。

### 2.1.2 时间序列和窗口操作

时间序列和窗口操作是流处理的基石。在Spark Streaming中,时间序列用于追踪每个数据点所属的时间戳。窗口操作则是在特定时间范围内对流数据进行聚合操作。窗口的大小通常由窗口持续时间和滑动间隔来定义,这样可以对过去一段时间内的数据进行分析。

Spark Streaming 提供了窗口操作支持,使得开发者能够进行更复杂的实时分析。例如,可以使用窗口函数来计算过去1分钟内的点击率峰值,或者在过去1小时的数据中寻找异常值。

**代码逻辑分析:**

窗口操作可以使用`window`函数来实现。以下代码展示了如何使用窗口来计算过去10分钟内单词出现的频率。

```scala

// Scala代码示例

val windowDuration = Seconds(600) // 10分钟

val slidingDuration = Seconds(30) // 每30秒滑动一次

val windowedWordCounts = words.window(windowDuration, slidingDuration)

.map(x => (x, 1))

.reduceByKey(_ + _)

```

在这个例子中,`window`函数创建了一个新的DStream,其中包含了在过去10分钟内每个30秒间隔收集到的单词,并对它们进行了计数。

**参数说明:**

- `windowDuration` 是窗口的长度。

- `slidingDuration` 是窗口的滑动间隔。

## 2.2 核心架构与组件

### 2.2.1 架构组件概览

Spark Streaming 架构主要包含以下几个核心组件:

- **Driver Program**: 包含流计算的main()函数,并在其中创建StreamingContext。

- **StreamingContext**: 是所有流计算操作的入口点,负责创建输入数据流,并定义数据处理逻辑。

- **JobGenerator**: 定期生成Spark作业,送往Cluster Manager。

- **JobScheduler**: 调度生成的作业到JobExecutor执行。

- **JobExecutor**: 实际执行由JobScheduler调度的作业。

- **Block Generator**: 接收数据流并将数据分块。

- **Receiver**: 数据源与Stream的连接组件,负责从数据源拉取数据。

当运行一个Spark Streaming应用时,Driver程序会创建一个StreamingContext,该StreamingContext会创建输入数据流,并定义数据处理逻辑。JobGenerator定时向JobScheduler提交Spark作业(即批次处理任务),JobScheduler则负责将这些作业调度给JobExecutor执行。

### 2.2.2 DStream和RDD的转换关系

在Spark Streaming中,DStream(Discretized Stream)是数据流的抽象,是连续的RDD序列。每一个DStream都是一个时间序列,每个时间间隔内包含一个RDD,代表了那个时间窗口内的数据。

DStream提供了丰富的API来进行数据处理和转换,这些操作最终会映射到底层的RDD上,然后由Spark引擎执行。用户可以对DStream应用各种转换操作,比如映射(map)、过滤(filter)、归约(reduce)等。由于DStream是建立在RDD之上的,因此它继承了RDD的容错性。

**代码逻辑分析:**

以下是一个简单的例子,展示了如何将输入数据流转换为DStream,并应用一个转换操作。

```scala

// Scala代码示例

val lines = ssc.socketTextStream("localhost", 9999)

val words = lines.flatMap(_.split(" "))

val wordCounts = words.map(x => (x, 1)).reduceByKey(_ + _)

```

在这个例子中,我们首先创建了一个基于TCP套接字的数据流`lines`。然后,我们对这个数据流进行`flatMap`操作,接着`map`操作映射到单词和计数对,最后使用`reduceByKey`操作对所有具有相同键的值进行累加。

### 2.2.3 任务调度与容错机制

Spark Streaming 任务调度和容错机制是其核心功能之一。Spark Streaming 通过运行周期性的任务来处理实时数据流,并且使用RDDs作为其底层的数据抽象模型,这为处理失败提供了强大的容错能力。

任务调度方面,JobGenerator会根据时间间隔生成一个批次的作业。这些作业被提交给JobScheduler,后者根据策略将作业分配给合适的JobExecutor。由于每个作业都是由一系列的RDDs组成的,Spark的任务调度器会基于RDD的依赖关系来决定作

0

0