实时数据分析工具大比拼:Apache Flink vs. Apache Storm

发布时间: 2024-09-08 11:14:56 阅读量: 151 订阅数: 63

实时计算:Apache Flink.zip

# 1. 实时数据分析工具概览

在数字化时代,数据是推动决策的关键力量。实时数据分析工具能够帮助企业及时获取洞察,迅速做出响应。本章将为读者提供一个对当前流行实时数据分析工具的概览,涵盖工具的定义、应用场景和市场需求。

## 1.1 实时数据分析工具的定义

实时数据分析工具是指能够迅速对数据流进行处理、分析,并提取有价值信息的技术或平台。与传统批处理方法相比,它们以极低的延迟对数据进行处理,确保决策者能够基于最新信息作出决策。

## 1.2 实时数据分析的应用场景

实时数据分析广泛应用于金融交易、物联网、供应链管理、社交媒体分析和在线广告等领域。这些场景要求系统能够快速响应,并提供即时的数据洞察。

## 1.3 市场需求与发展趋势

随着大数据的发展,实时数据分析工具的需求不断增长。技术的持续进步,如边缘计算和5G通信的引入,正在推动实时分析向更高效率、更低延迟的方向发展。

通过本章的介绍,读者将建立起对实时数据分析工具基本的认识框架,并为深入学习后续章节内容奠定基础。

# 2. Apache Flink的理论基础与实践案例

## 2.1 Apache Flink的核心概念解析

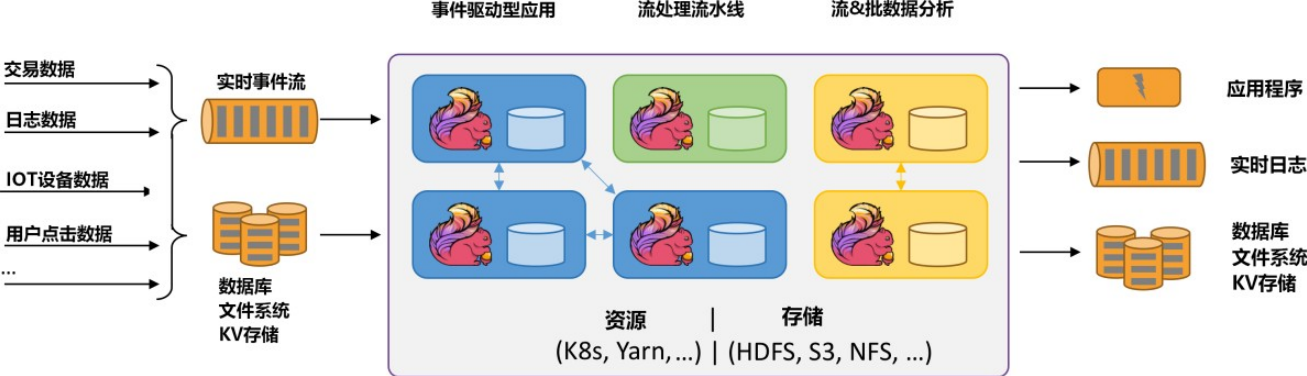

### 2.1.1 数据流处理模型

Apache Flink采用基于事件的时间模型来处理数据流。它能够在不断变化的数据集上运行复杂的分析算法,比如机器学习算法,从而实现近实时的数据处理。Flink支持两种类型的数据流处理:有界流(Bounded Stream)和无界流(Unbounded Stream)。

在Flink中,有界流处理主要针对的是有限大小的数据集,通常用于批处理;无界流处理则是针对实时数据流,比如传感器数据或者日志流。Flink将无界流处理视为一种连续执行的过程,它可以根据数据流的特点,动态地调整资源使用并提供低延迟的结果。

### 2.1.2 时间特性和事件时间窗口

在流处理模型中,时间特性对窗口操作至关重要。Flink提供了三种时间类型:

- **事件时间(Event Time)**:这是事件创建的时间,通常记录在数据中。对于事件时间窗口,Flink需要从事件中提取时间戳,并以此来处理时间相关的操作。

- **处理时间(Processing Time)**:这是事件被处理时系统机器的当前时间,它简单易用,但可能会因为任务调度的延迟而引入不确定性。

- **摄入时间(Ingestion Time)**:这是事件进入Flink数据流处理程序的时间。它介于事件时间和处理时间之间,提供了比处理时间更一致的结果,但又不像事件时间那样能处理乱序数据。

在Flink中,窗口操作是基于时间的抽象,用于将无限的数据流切割成有限的块,以便于处理。Flink支持滚动窗口、滑动窗口和会话窗口三种类型,用户可以针对自己的业务需求选择合适的窗口类型进行操作。

## 2.2 Apache Flink的系统架构与组件

### 2.2.1 JobManager和TaskManager

Flink的运行时架构由JobManager和TaskManager组成。JobManager是Flink集群中的主节点,负责协调任务执行,作业调度,以及故障恢复。它通过一个称为调度器(Scheduler)的组件来管理整个数据处理流程,包括任务的提交、分配资源和监控任务执行状态。

TaskManager是Flink集群中的工作节点,它执行由JobManager分配的任务。每个TaskManager可以并行地运行多个任务,这些任务通过线程实现。TaskManager之间通过网络交换数据,并通过预先定义好的通道通信协议互相协作,以实现容错和状态管理。

### 2.2.2 状态管理和容错机制

Flink提供了一套内建的容错机制来保证计算结果的准确性和稳定性,即通过状态管理和检查点(Checkpoint)机制来实现。状态管理是Flink的核心特性之一,它支持不同类型的状态后端,比如内存、文件系统和远程存储等。

检查点机制是一种轻量级的快照技术,它周期性地保存应用的状态,从而在发生故障时可以恢复到最近的一个检查点,而不需要从头开始重新处理所有数据。这样既保证了容错性,也大大提升了系统恢复的速度。

## 2.3 Apache Flink的编程模型和API

### 2.3.1 DataStream API使用

DataStream API是Flink用于处理无界流的主要API,它允许用户定义事件时间和处理时间窗口的逻辑。通过DataStream API,用户可以处理不同类型的输入源,如消息队列(Kafka、RabbitMQ等),并能够输出到各种存储系统(如HDFS、Kafka等)。

以下是一个简单的使用DataStream API处理事件时间窗口的例子:

```java

DataStream<String> input = ... // 初始化数据流

DataStream<WindowedEvent> result = input

.assignTimestampsAndWatermarks(

WatermarkStrategy

.<Event>forBoundedOutOfOrderness(Duration.ofSeconds(20)) // 定义20秒的乱序容忍度

.withTimestampAssigner((event, timestamp) -> event.getTimestamp())) // 事件时间戳的提取方法

.keyBy(event -> event.getKey()) // 基于某个键值进行分组

.window(TumblingEventTimeWindows.of(Time.minutes(5))) // 使用5分钟的滚动事件时间窗口

.reduce(new MyReducer()); // 聚合逻辑

```

### 2.3.2 DataSet API使用

DataSet API主要用于批处理任务,与DataStream API相比,它更适合处理有界数据集。DataSet API提供了一系列转换操作(如映射、过滤、聚合等),能够实现复杂的数据处理逻辑。

以下是使用DataSet API的一个基本例子:

```java

DataSet<String> input = ... // 初始化数据集

DataSet<Integer> result = input

.map(new MapFunction<String, Integer>() {

public Integer map(String value) {

return value.length();

}

})

.filter(new FilterFunction<Integer>() {

public boolean filter(Integer value) {

return value > 0;

}

});

```

### 2.3.3 Table API与SQL集成

Flink的Table API和SQL模块为流式和批处理提供了声明式的查询接口。它允许用户以类似SQL的方式表达转换和查询,然后Flink会将其编译为底层的优化执行计划。

Table API的优势在于它的类型安全,编译时检查和良好的集成性。用户可以无缝地在Java和Scala代码中嵌入Table API和SQL查询,实现高度可定制化的数据处理流程。

## 2.4 Apache Flink的实际应用案例分析

### 2.4.1 实时数据处理场景

在许多实时数据处理场景中,Flink都显示出了它的强大能力和灵活性。例如,在金融领域,Flink可以帮助实现高频交易策略、实时风险监控和欺诈检测;在工业物联网(IIoT)中,Flink可以实时分析来自机器的传感器数据,以优化设备的维护和运营效率;在网络监控中,Flink可以用于流量分析和异常检测,从而提供实时的网络安全保护。

### 2.4.2 Flink在企业中的部署和运维经验

企业在部署和运维Flink时,通常需要考虑性能优化、资源分配、故障恢复和监控等多方面的因素。例如,使用Kubernetes进行资源管理,能够提供更

0

0