深度分析:如何用MAN-G-CR.pdf进行高级数据分析(案例实践)

发布时间: 2025-01-03 12:56:49 阅读量: 7 订阅数: 8

# 摘要

本文全面概述了高级数据分析的基础知识、数据获取与预处理技术、统计分析方法和机器学习在数据分析中的应用,最后通过具体案例分析展示了理论与实践相结合的实操过程。首先,介绍了数据分析的基础概念和数据获取的常用方法,包括网络爬虫技术和API数据采集。随后,重点讨论了数据清洗、预处理以及转换和特征工程的重要步骤。在统计分析章节,涵盖了描述性统计、假设检验、相关性分析以及回归分析。机器学习章节则探讨了监督与无监督学习算法、模型评估和优化策略。最后,结合案例实操分析,讨论了如何从数据集准备到模型建立,再到结果解释及商业决策支持的全过程。本文旨在为数据分析领域的研究者和实践者提供一个系统的知识框架和实践指南。

# 关键字

高级数据分析;数据获取;特征工程;统计分析;机器学习;模型评估

参考资源链接:[Elmo Gold系列驱动器详细命令参考与编程指南](https://wenku.csdn.net/doc/6u0rxuzap7?spm=1055.2635.3001.10343)

# 1. MAN-G-CR.pdf概述与高级数据分析基础

在数据分析和机器学习领域,理解数据的本质与特点至关重要。本章旨在为您提供一个高级数据分析的概览,并建立起必要的基础概念。我们将从基础出发,逐步深入至数据处理的高级技术,为后续章节中数据获取、处理、分析及机器学习应用打下坚实的基础。

数据分析不仅仅是数字游戏,它是对信息的洞察和理解,是通过数字揭示背后的模式和趋势。数据可以被分类为定量数据(如数值)和定性数据(如文本或分类变量),而高级数据分析则涉及到如何将这些数据转化为有意义的见解和预测。

在进行高级数据分析前,我们需要一个清晰的目标,确定我们希望从数据中得到什么。同时,选择合适的数据处理和分析工具也至关重要。本章将简要介绍分析工具的选择标准,以及如何使用它们来优化数据分析流程。此外,我们将探讨数据集中常见的挑战,例如维度诅咒、过拟合问题,以及如何通过合适的特征选择和数据降维来克服它们。

```markdown

## 1.1 数据分析的目标与工具选择

### 目标设定

- 明确分析目的

- 确定关键问题

- 预期成果和应用范围

### 工具选择标准

- 功能与灵活性

- 稳定性与社区支持

- 学习曲线与扩展性

```

通过本章的学习,您将准备好进入更深入的数据获取与处理阶段。

# 2. MAN-G-CR.pdf的数据获取与预处理

数据获取与预处理是数据分析工作中的重要环节,它们直接决定了后续分析的质量和准确性。本章节将详细介绍数据获取的不同方法、数据清洗与预处理的技巧,以及数据转换与特征工程的实践应用。

### 2.1 数据获取方法

在开始数据分析之前,首先需要获取到数据。数据可以来源于多种渠道,但最常见的是网络爬虫技术和API数据采集。

#### 2.1.1 网络爬虫技术基础

网络爬虫是一种自动获取网页内容的程序,它能够按照既定的规则,遍历互联网,抓取所需数据。构建一个网络爬虫通常涉及以下几个步骤:

1. **确定爬虫目标**:明确要抓取的数据内容和目标网站。

2. **分析网站结构**:使用开发者工具查看网页结构,分析数据加载方式。

3. **编写爬取规则**:根据网站结构调整合适的爬取策略,可能是Xpath、CSS选择器等。

4. **数据解析**:从爬取到的HTML文档中提取所需数据。

5. **数据存储**:将提取的数据保存到文件或数据库中。

以下是一个简单的Python爬虫代码示例,使用了`requests`库进行网页访问,以及`BeautifulSoup`库进行数据解析:

```python

import requests

from bs4 import BeautifulSoup

# 目标URL

url = 'https://example.com'

# 请求网页

response = requests.get(url)

response.encoding = response.apparent_encoding # 处理编码

# 解析网页

soup = BeautifulSoup(response.text, 'html.parser')

# 提取数据

data_list = []

for element in soup.find_all('div', class_='target-class'):

data_list.append(element.get_text())

# 存储数据

with open('data.txt', 'w', encoding='utf-8') as file:

for data in data_list:

file.write(data + '\n')

```

在这个例子中,我们抓取了一个网页中所有具有`target-class`类的`div`元素的文本内容,并将结果保存在文本文件中。

#### 2.1.2 API数据采集技巧

API(应用程序接口)是许多现代Web服务提供数据访问的一种方式。使用API采集数据通常比爬虫更高效、更稳定。通常的步骤如下:

1. **查阅API文档**:了解API的请求方法、请求参数、响应格式等信息。

2. **获取访问权限**:注册API服务,获取API密钥(Key)。

3. **构建请求**:根据API文档要求构建HTTP请求。

4. **处理响应数据**:解析返回的数据(通常是JSON或XML格式)。

5. **异常处理**:处理网络异常、数据格式错误等问题。

以下是通过HTTP GET请求API获取数据的Python代码示例:

```python

import requests

# API的URL和Key

api_url = 'https://api.example.com/data'

api_key = 'your_api_key'

# 构建请求头

headers = {

'Authorization': f'Bearer {api_key}'

}

# 发送请求

response = requests.get(api_url, headers=headers)

# 检查响应状态码

if response.status_code == 200:

# 解析JSON数据

data = response.json()

print(data)

else:

print('Failed to retrieve data:', response.status_code)

```

在这个例子中,我们使用了`requests`库向API发起GET请求,并处理了响应结果。

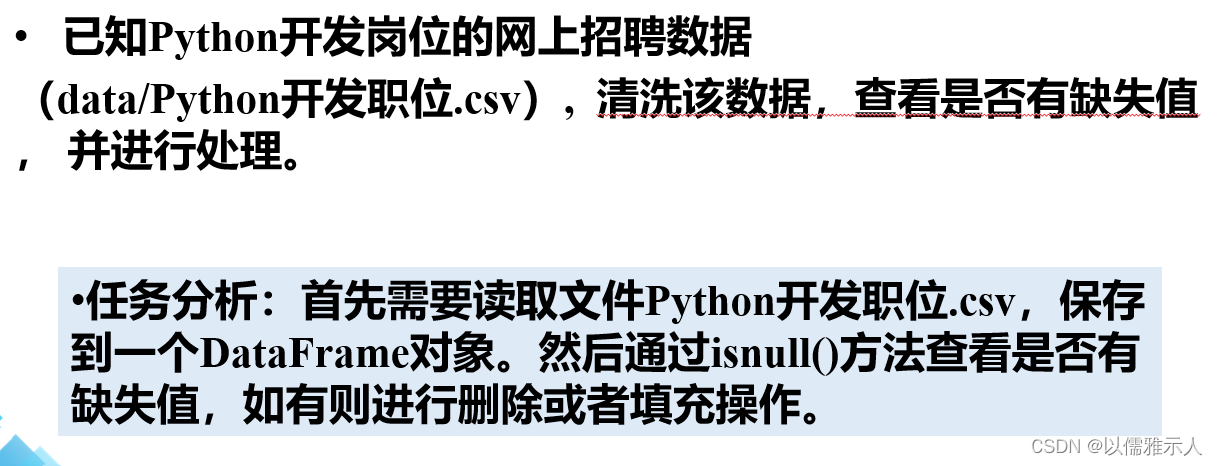

### 2.2 数据清洗与预处理

在获取原始数据后,需要进行一系列的预处理步骤来清洗数据,以便于后续分析。数据清洗涉及处理缺失值、异常值检测与处理、数据标准化与归一化等方面。

#### 2.2.1 缺失值处理

在实际数据集中,缺失值是很常见的问题。处理缺失值的方法包括:

1. **删除**:如果数据量足够大,可以删除包含缺失值的记录。

2. **填充**:用统计量(如均值、中位数、众数)或模型预测的结果填充缺失值。

以下是一个用均值填充缺失值的Python代码示例:

```python

import pandas as pd

# 加载数据集

df = pd.read_csv('data.csv')

# 计算每列的均值并填充缺失值

df.fillna(df.mean(), inplace=True)

```

在这个例子中,我们使用了`pandas`库中的`fillna`方法,它允许我们用指定的值或方法填充数据集中的缺失值。

#### 2.2.2 异常值检测与处理

异常值可能会影响分析的准确性。异常值检测和处理方法包括:

1. **可视化检测**:绘制箱线图等,通过图形识别异常值。

2. **统计方法检测**:例如,使用Z分数来识别异常值。

一个简单的使用Z分数方法检测异常值的Python代码示例如下:

```python

from scipy import stats

# 计算Z分数

z_scores = stats.zscore(df['column_name'])

# 定义阈值

threshold = 3

# 检测异常值

outliers = df[(z_scores > threshold) | (z_scores < -threshold)]

```

#### 2.2.3 数据标准化与归一化

为了消除不同量纲的影响,常用的数据标准化和归一化方法包括:

1. **标准化**:将数据按比例缩放,使之落入一个小的特定区间。

2. **归一化**:使每个特征的数值缩放到0到1之间。

以下是使用`sklearn.preprocessing`模块中的`StandardScaler`和`MinMaxScaler`进行数据标准化和归一化的Python代码示例:

```python

from sklearn.preprocessing import StandardScaler, MinMaxScaler

# 数据标准化

scaler_standard = StandardScaler()

df_scaled_standard = pd.DataFrame(scaler_standard.fit_transform(df), columns=df.columns)

# 数据归一化

scaler_minmax = MinMaxScaler()

df_scaled_minma

```

0

0