Hadoop块管理专家指南:掌握存储与计算的平衡艺术

发布时间: 2024-10-26 23:50:56 阅读量: 21 订阅数: 36

Hadoop集群构建全指南:基于CentOS与VMware环境搭建

# 1. Hadoop块管理概述

Hadoop作为大数据处理的骨干技术,其块管理是确保数据可靠性和高效处理的关键组成部分。Hadoop通过其分布式文件系统HDFS(Hadoop Distributed File System),将大数据分成小块,并将这些块分布存储在集群的不同节点上。块管理不仅仅是数据的存储问题,还关系到数据的可靠性和计算效率。

HDFS的块大小是Hadoop设计中的一个重要参数,它直接影响到系统的存储效率和I/O性能。选择合适的块大小需要在存储空间、网络带宽和内存使用之间进行权衡。块的优化配置和管理策略对于提升整个Hadoop集群的性能至关重要。

在深入探讨块管理的细节之前,我们需要了解块在Hadoop中的角色,以及如何配置和优化这些块以满足不同场景的需求。接下来的章节将展开深入讨论Hadoop块的存储机制、放置策略、故障处理以及性能优化等关键话题。让我们一起揭开Hadoop块管理的神秘面纱,探索其在大数据世界中的重要作用。

# 2. 理解Hadoop的块存储机制

## 2.1 HDFS块的概念和作用

### 2.1.1 块的定义及其在HDFS中的角色

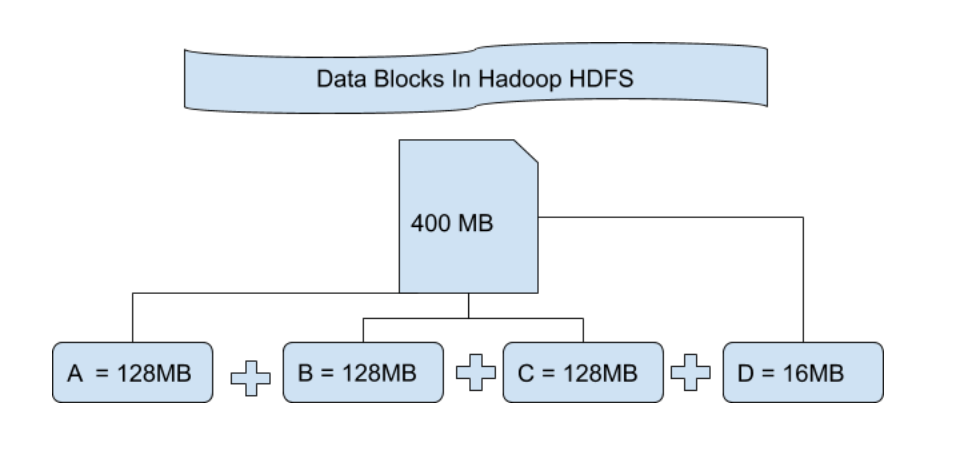

在Hadoop分布式文件系统(HDFS)中,数据被分割成固定大小的块(block),并且这些块被存储在多个数据节点上。块的概念对于HDFS来说至关重要,因为它是实现数据高可用性和容错性的基础。

一个块的大小通常在64MB到256MB之间,这个大小是可以配置的。选择合适的块大小非常关键,因为它直接影响到文件的读取效率、存储空间的使用和网络带宽的占用。如果块太大,小文件可能会占用过多的存储空间并且难以有效利用数据节点的分布式处理能力。如果块太小,那么文件将会有更多的块,导致元数据的数量增多,这可能会增加NameNode的压力。因此,在配置块大小时需要在存储效率和读写性能之间寻找一个平衡点。

### 2.1.2 块大小的选择与配置

选择块大小时需要考虑多个因素,包括数据的类型、处理的作业特性以及集群的硬件配置。例如,对于需要高效并行处理的大文件,较大的块可以提高读写性能。而对于需要频繁读取和更新的小文件,较小的块可以减少读写延迟。

在HDFS上配置块大小的方法很简单,通过修改`hdfs-site.xml`配置文件来实现。下面是一个示例配置:

```xml

<configuration>

<property>

<name>dfs.block.size</name>

<value>***</value> <!-- 这里设置的块大小是128MB -->

</property>

</configuration>

```

在集群部署之后,需要重启NameNode和DataNode以使新的块大小设置生效。值得注意的是,在HDFS文件系统已经创建之后,不能更改现有的块大小,因为HDFS不支持改变已经存在的文件的块大小。

## 2.2 HDFS块的放置策略

### 2.2.1 副本放置原则

HDFS通过数据的多副本机制来确保数据的高可用性和容错性。默认情况下,HDFS的每个块会有三个副本,分别存储在不同的数据节点上,一个作为主副本,其余两个作为次副本。

副本的放置策略遵循“机架感知”原则,Hadoop集群通常被划分为多个机架,每个机架有多个数据节点。主副本会优先放置在写入操作所在的节点上。对于次副本,Hadoop会尽量将它们放置在不同机架的不同数据节点上。这样做有两方面的好处:首先,它可以平衡机架间的负载;其次,当某一个机架发生故障时,其他机架上的副本可以保证数据的完整性。

### 2.2.2 块放置策略的优化

尽管默认的副本放置策略在大多数情况下可以很好地工作,但在特定的场景下,可能需要进行优化以适应不同的需求。例如,在高延迟网络环境中,可以减少跨机架的副本数量,以减少数据的读写延迟。在需要提高数据的可用性时,可以增加副本数量或修改副本的放置策略,让副本尽量分散在不同的故障域中。

可以通过调整HDFS配置参数来优化副本放置策略。`dfs.replication.min`参数可以设置最小副本数量,`dfs.namenode.replication备选策略`属性可以定义副本放置的策略。例如,以下配置将最小副本数量设置为2,并定义了一个新的副本放置策略:

```xml

<configuration>

<property>

<name>dfs.replication.min</name>

<value>2</value>

</property>

<property>

<name>dfs.namenode.replication备用策略</name>

<value>MY_STRATEGY</value>

</property>

</configuration>

```

具体的策略实现需要通过扩展Hadoop的配置接口来编写Java代码实现。这块的细节在Hadoop的官方文档中有详细说明。

## 2.3 HDFS块的恢复与复制

### 2.3.1 块损坏的检测和恢复机制

HDFS通过心跳机制和校验和来检测数据块的损坏。每个数据节点都会周期性地向NameNode发送心跳信号,告知其状态,并且在读写数据块时,数据节点会验证数据块的校验和来检查数据的完整性。如果发现校验和不匹配,数据节点会认为该块已损坏,并将此信息报告给NameNode。

NameNode在得知有块损坏后,会启动恢复流程。首先,它会在另一个数据节点上启动一个新的副本来替换损坏的副本。随后,系统会对数据进行重新复制,直到达到预期的副本数。如果主副本损坏,系统会自动从现有的副本身份中提升一个新的主副本。

### 2.3.2 自动复制过程及其影响

自动复制过程保证了HDFS的数据可用性和容错性。然而,这个过程并不是没有代价的,它会消耗额外的网络带宽和计算资源,尤其是当大量块同时损坏时。为了避免这种情况,可以对HDFS进行配置,以控制复制速率,避免在集群负载高的时候进行大量复制操作。

HDFS提供了`dfs.replication`参数来控制副本数量,默认值是3。该参数的配置可以在`hdfs-site.xml`中修改:

```xml

<configuration>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

</configuration>

```

此外,`dfs副本调度器`(dfs副本调度器)控制了副本的放置策略,通过它可以实现更为复杂的调度逻辑。

## 2.4 HDFS块存储机制小结

HDFS块存储机制的设计是Hadoop大数据处理能力的核心。块的概念与HDFS的容错性和扩展性紧密相关,块大小的选择对于优化性能至关重要。块的放置策略旨在保证数据的高可用性和平衡系统负载,而块的自动恢复功能确保了数据的可靠性。理解并熟练地操作这些机制对于管理和优化Hadoop集群至关重要。

0

0