【Python物联网数据分析全攻略】:精通数据收集、处理与可视化

发布时间: 2024-12-07 02:58:41 阅读量: 19 订阅数: 19

Python数据分析与应用:从数据获取到可视化

# 1. Python物联网数据分析概述

## 1.1 物联网与数据分析的融合

在现代信息技术飞速发展的背景下,物联网(IoT)正逐渐渗透到工业、家居、医疗等众多领域。随着物联网设备数量的激增,产生了海量的数据,这些数据蕴含着巨大的价值,而Python作为一种多用途的编程语言,在物联网数据分析中扮演了重要角色。Python以其简洁、易用和强大的数据处理能力,成为物联网数据分析领域的首选工具。

## 1.2 数据分析在物联网中的重要性

数据分析对于物联网来说至关重要,它帮助我们从原始数据中提取有用信息,转化为可操作的见解。数据分析可优化资源分配、提高效率、增强用户体验,并为决策提供科学依据。掌握Python在物联网数据分析中的应用,对于开发智能解决方案和构建可持续的物联网生态系统至关重要。

## 1.3 Python的优势及应用

Python作为一种高级编程语言,具有丰富的库和框架来支持数据处理、分析和可视化。例如,Pandas库用于数据操作和处理,NumPy和SciPy用于数值计算,而Matplotlib和Seaborn则用于数据可视化。这些工具的灵活组合为物联网数据分析提供了强大的支持。此外,Python的简洁语法使得开发者能够快速编写和测试代码,缩短开发周期,提高物联网项目的生产效率。在后续章节中,我们将详细介绍如何使用Python进行数据收集、处理、分析和可视化,以及如何解决实际物联网数据分析中的问题。

# 2. 数据收集技术与实践

## 2.1 物联网数据收集基础

### 2.1.1 物联网数据类型与来源

在物联网(IoT)的背景下,数据可以来自各种设备和传感器。这些数据类型大致可以分为结构化数据、半结构化数据和非结构化数据。结构化数据通常是数据库中可以以行和列形式存储的数据,例如,温度传感器的数值读数。半结构化数据可能包含标签或者特定格式,如XML或JSON格式的数据。非结构化数据则是没有固定格式的数据,例如视频或音频数据。

数据来源涵盖了广泛的技术和设备。例如,RFID标签、智能仪表、健康监测设备和汽车传感器都是数据的源头。这些设备和传感器将数据传输到中央处理单元,供进一步的分析和决策使用。

### 2.1.2 数据收集方法与工具选择

数据收集方法根据应用场景和数据源的不同而有所差异。常见方法包括:

- **周期性轮询**:定期向传感器发送请求来获取数据。

- **事件驱动**:当设备检测到特定事件时自动发送数据。

- **远程配置**:通过网络远程配置设备,动态地改变数据采集参数。

在选择数据收集工具时,需要考虑如下因素:

- **实时性**:数据收集系统应该能够满足实时数据处理的需求。

- **可靠性**:数据传输过程需要稳定,并且有错误恢复机制。

- **扩展性**:随着设备数量的增加,系统应能够轻松扩展。

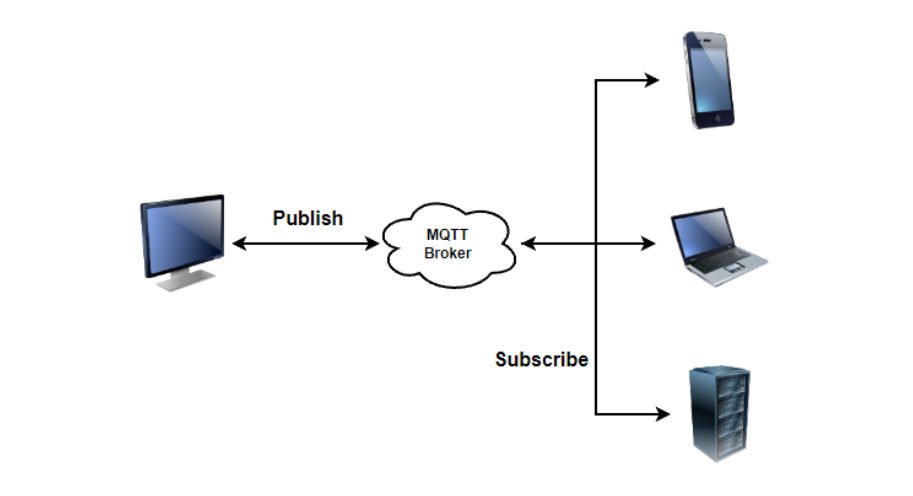

一些常用的物联网数据收集工具有MQTT、CoAP、XMPP等轻量级协议。此外,使用像Apache Kafka这样的消息队列系统,可以实现高效、可扩展的数据收集。

## 2.2 使用Python进行数据收集

### 2.2.1 Python网络请求处理

Python提供了多个库用于处理网络请求,如`requests`和`urllib`。以下是使用`requests`库进行HTTP GET请求的一个示例:

```python

import requests

# 发送HTTP GET请求

response = requests.get('https://api.example.com/data')

# 检查请求是否成功

if response.status_code == 200:

# 输出响应内容

print(response.text)

else:

print('Request failed with status code:', response.status_code)

```

在上述代码中,我们向指定的API发起一个HTTP GET请求,并检查返回状态码以确保请求成功。如果请求成功,我们可以进一步处理响应内容。

### 2.2.2 设备端数据提取与传输

在物联网应用中,Python也可以被用来直接从设备提取数据。例如,使用`pySerial`库,可以从串行端口读取传感器数据。

```python

import serial

import json

# 打开串行端口

ser = serial.Serial('COM3', 9600, timeout=1)

# 读取一行数据

line = ser.readline().decode('ascii').rstrip()

# 将数据转换为JSON格式

data = json.loads(line)

# 关闭串行端口

ser.close()

# 输出提取的数据

print(data)

```

在此代码段中,我们首先打开与传感器连接的串行端口,并读取一行数据。然后,我们假设数据以字符串形式存储,将其解析为JSON对象。

### 2.2.3 数据收集实战案例分析

假设我们正在构建一个智能家居环境监控系统,需要实时收集温度、湿度、光照强度等数据。我们将使用Python的`paho-mqtt`库实现一个简单的数据收集模块,该模块订阅了传感器消息,并将数据保存到本地数据库中。

```python

import paho.mqtt.client as mqtt

# 数据库连接设置

db_connection = 'sqlite:///home/user/sensor_data.db'

# 连接处理函数

def on_connect(client, userdata, flags, rc):

print("Connected with result code "+str(rc))

# 订阅主题

client.subscribe("home/sensor/#")

# 消息处理函数

def on_message(client, userdata, msg):

print(msg.topic+" "+str(msg.payload))

# 将数据保存到数据库

# 省略了数据库连接和插入操作的细节

# 创建MQTT客户端实例

client = mqtt.Client()

# 绑定连接和消息处理函数

client.on_connect = on_connect

client.on_message = on_message

# 连接到MQTT服务器

client.connect("mqtt_broker", 1883, 60)

# 开始循环,等待回调函数执行

client.loop_forever()

```

在此示例中,我们创建了一个MQTT客户端并连接到了MQTT代理服务器。我们订阅了所有与传感器相关的主题,这样当新消息发布时,我们的`on_message`函数将被调用,并处理消息。

## 2.3 数据收集中的异常处理与优化

### 2.3.1 常见数据收集错误与预防

在数据收集过程中可能会遇到多种错误,包括网络中断、设备故障、数据格式不一致等。预防这些错误的方法包括:

- **健壮的错误处理机制**:在代码中实现异常捕获逻辑,确保程序在遇到异常时不会崩溃,而是进行适当的错误处理。

- **设备健康监测**:定期检查设备状态,确保设备正常运行。

- **数据校验**:在接收数据时进行校验,确保数据格式正确无误。

### 2.3.2 数据收集效率的提升策略

为了提升数据收集效率,可以采取以下策略:

- **优化网络协议**:选择适合特定场景的高效协议,减少数据包大小,使用压缩和数据缓存技术。

- **并行数据处理**:在可能的情况下,并行化数据收集和处理流程,提高整体吞吐量。

- **智能数据传输**:根据网络条件和数据重要性智能调整数据传输频率和批量大小。

在数据收集过程中,开发者可以利用Python的多线程或异步IO特性来实现这些优化策略。例如,使用`asyncio`库进行异步网络请求,可以显著提高数据收集的效率。

```python

import asyncio

import aiohttp

async def fetch_data(session, url):

async with session.get(url) as response:

return await response.text()

async def main():

async with aiohttp.ClientSession() as session:

html = await fetch_data(session, 'http://example.com')

print(html)

# 运行事件循环

asyncio.run(main())

```

在此异步代码示例中,我们使用`aiohttp`库发起异步HTTP GET请求。这种方式可以同时进行多个请求,充分利用带宽资源。

在下一章节中,我们将深入探讨数据处理与分析技巧,学习如何使用Python进行数据清洗、转换、分析和可视化。

# 3. 数据处理与分析技巧

## 3.1 Python数据处理工具概述

### 3.1.1 数据处理库的选择

在Python中,数据处理是一个涉及多个库和框架的过程。最常用的是Pandas库,它提供了高效和灵活的数据结构以及函数,用于操作表格数据。对于数据清洗和预处理,NumPy库也不可缺少,它提供了对大型多维数组和矩阵的支持。另外,SciPy是处理科学计算任务的一个重要工具,它包含了算法库和数学工具函数库。在进行数据分析时,一个合适的数据处理工具组合可以极大地提高效率和准确性。

### 3.1.2 数据预处理的基本流程

数据预处理通常包括以下步骤:

- 数据清洗:去除重复项、纠正错误、处理异常值。

- 数据转换:数据归一化、标准化或调整数据格式。

- 数据离散化:将连续特征数据转换为离散数据。

- 特征工程:创建、选择和转换特征以改善模型性能。

- 数据集成:将来自不同数据源的数据结合起来。

- 数据归约:降低数据量但尽可能保持数据完整性。

为了实现这些流程,Python提供了一系列的函数和方法。例如,Pandas库中的`drop_duplicates()`函数用于去除重复数据,`fillna()`函数用于处理缺失值,`replace()`函数可以替换数据中的特定值。

## 3.2 数据清洗与转换技术

### 3.2.1 缺失数据处理

缺失数据是数据预处理过程中常见的问题。Pandas库提供了多种处理缺失数据的方法,如:

- `dropna()`: 删除包含缺失值的行或列。

- `fillna()`: 填充缺失值。

- `interpolate()`: 使用插值法填充缺失值。

选择合适的方法取决于缺失数据的性质和分析的需求。在某些情况下,保留缺失值而不是简单地填充或删除可能是更好的选择,因为它可以保持数据集的完整性。

### 3.2.2 数据标准化与归一化

数据标准化和归一化是为了消除量纲影响和标准化数据范围,常见的方法有:

- 最小-最大标准化:将数据缩放到[0,1]区间。

- Z得分标准化:将数据缩放到具有0均值和1标准差的分布。

Pandas通过`StandardScaler`和`MinM

0

0