实时数据处理的艺术:使用Kafka和Flume在Python物联网中

发布时间: 2024-12-07 03:39:29 阅读量: 9 订阅数: 12

# 1. 物联网中实时数据处理的重要性

## 1.1 数据量与处理需求的爆炸性增长

随着物联网(IoT)设备的普及和网络技术的进步,我们见证了数据量的空前增长。这些设备不断生成大量实时数据,包括传感器读数、状态更新以及用户交互信息。为了从这些数据中提取有意义的见解,实时数据处理变得至关重要。

## 1.2 实时数据处理的业务价值

实时数据处理在物联网中不仅仅是技术上的要求,更是一种商业上的必需。它能够帮助企业快速响应市场变化,优化资源分配,并提供即时的用户体验。例如,智能城市的交通管理系统,就需要实时处理交通流量数据,以减少拥堵和改善公共安全。

## 1.3 对技术基础设施的挑战

从技术的角度来看,实时数据处理要求高度的可靠性、扩展性和低延迟。这使得企业需要部署先进的数据处理架构,并使用诸如Kafka和Flume这样的流处理和数据采集工具,确保数据从源头到终端的无缝流动。因此,对于IT专业人员来说,掌握这些技能成为了职业发展的重要一环。

# 2. Kafka与Flume的基础与架构解析

## 2.1 Kafka基础理论与实践

### 2.1.1 Kafka的核心概念

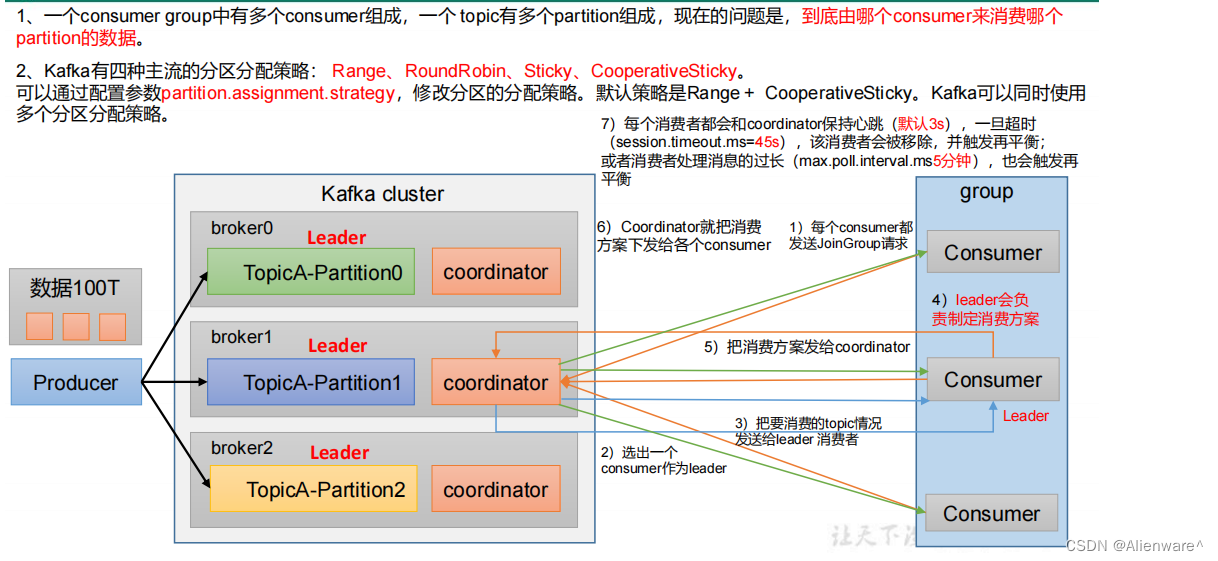

Apache Kafka是一个分布式流处理平台,主要用于构建实时数据管道和流应用程序。它能够高效地处理大量数据,并具备强大的容错能力。Kafka的核心概念包括生产者(Producer)、消费者(Consumer)、主题(Topic)、分区(Partition)和副本(Replica)等。

#### 生产者和消费者

- **生产者(Producer)** 是发送消息到Kafka的主题中的服务。生产者将数据推送到一个或多个主题中,并将消息分配到各个分区中。

- **消费者(Consumer)** 从主题中订阅消息,消费这些数据。消费者可以以分组的方式组织,从而实现负载均衡和高容错。

#### 主题和分区

- **主题(Topic)** 是Kafka中的数据分类单位,类似于数据库中的表或者消息队列中的队列。生产者发送数据到特定主题,消费者订阅主题以获取数据。

- **分区(Partition)** 是主题的并行单位。每个分区可以分布存储在不同的服务器上,确保了Kafka的扩展性和并行处理能力。

#### 副本

- **副本(Replica)** 保证了数据的高可用性和容错性。Kafka允许为主题配置多个副本,并在其中一个副本故障时,自动进行故障转移,从而继续提供服务。

### 2.1.2 Kafka在物联网中的应用实践

在物联网环境中,Kafka可以被用作数据收集和处理中心。传感器和设备产生的数据可以作为消息发送到Kafka,然后Kafka将这些数据提供给实时处理系统或者历史数据存储系统。

例如,智能家居系统可以使用Kafka作为中心节点,收集来自各种设备的数据,然后通过Kafka的分区和复制机制来保证数据的实时性和可靠性。这使得家居系统能够快速响应用户的指令,并通过数据分析优化家居环境。

## 2.2 Flume基础理论与实践

### 2.2.1 Flume的工作原理

Apache Flume是一个分布式的、可靠的数据收集和聚合系统,能够有效地处理大量数据流。它的核心组件包括源(Source)、通道(Channel)和汇(Sink)。

#### 源(Source)

- **源(Source)** 是数据进入Flume的入口点。源负责接收数据,可以是网络服务、文件系统或者自定义源等。

#### 通道(Channel)

- **通道(Channel)** 类似于缓冲区,用于暂存源接收到的数据。通道保证了数据在传输到汇之前的安全性,即使在出现故障时数据也不会丢失。

#### 汇(Sink)

- **汇(Sink)** 从通道中取出数据,发送到目的地。目的地可以是另一个Flume代理、Kafka、HDFS等。

### 2.2.2 Flume在物联网中的应用实践

在物联网应用中,Flume可以用来收集和聚合传感器数据。例如,城市交通监控系统可能使用Flume来收集来自交通摄像头、传感器和GPS设备的数据。Flume的高吞吐量和可靠性使其成为此类应用的理想选择。

在处理数据时,Flume可以配置多个源来收集不同类型的数据,并将这些数据写入到一个共同的通道。然后,通过配置多个汇将数据发送到不同的分析系统,例如实时分析和长期存储系统。

## 2.3 Kafka与Flume的集成机制

### 2.3.1 集成的必要性和优势

Kafka和Flume各有所长,集成这两者可以带来很多优势。Flume擅长高效地收集和聚合数据,而Kafka擅长数据的持久化、扩展性和容错性。集成它们可以构建一个强大的实时数据处理平台,对数据进行快速收集、持久化存储和高效处理。

例如,在大规模的物联网项目中,可以使用Flume快速收集海量的设备数据,然后将这些数据可靠地传输到Kafka,由Kafka进行进一步的处理和分析。

### 2.3.2 集成的策略与步骤

集成Kafka和Flume可以使用Flume的Kafka Sink,这是Flume的一个扩展组件,可以将数据直接写入到Kafka的主题中。集成的步骤通常包括:

1. **环境准备**:确保已经安装好Kafka和Flume,并且运行稳定。

2. **配置Flume**:在Flume的配置文件中定义一个agent,配置源(Source)来接收数据,配置通道(Channel),并指定Kafka作为汇(Sink)。

3. **定义Kafka主题**:在Kafka集群中创建对应的主题。

4. **启动Flume**:加载配置并启动Flume agent,开始数据的收集和传输。

下面是一个简单的配置示例:

```properties

# Flume配置文件示例

agent.sources = r1

agent.sinks = k1

agent.channels = c1

# Source配置

agent.sources.r1.type = avro

agent.sources.r1.bind = localhost

agent.sources.r1.port = 10000

# Channel配置

agent.channels.c1.type = memory

agent.channels.c1.capacity = 1000

agent.channels.c1.transactionCapacity = 100

# Sink配置,使用Kafka作为数据传输的目的地

agent.sinks.k1.type = org.apache.flume.sink.kafka.KafkaSink

agent.sinks.k1.topic = test

agent.sinks.k1.brokerList = kafka-broker:9092

agent.sinks.k1.requiredAcks = 1

agent.sinks.k1.batchSize = 20

# 绑定source、sink和channel

agent.sources.r1.channels = c1

agent.sinks.k1.channel = c1

```

通过这种集成,物联网的实时数据处理变得更加高效和可靠。接下来,将探讨Python在物联网实时数据处理中的作用。

# 3. Python在物联网实时数据处理的角色

Python作为一门功能强大的编程语言,在数据处理领域有着举足轻重的地位。尤其是在物联网(IoT)的实时数据处理中,Python简洁的语法和丰富的数据处理库使得它成为处理复杂数据流的理想选择。本章将深入探讨Python在物联网实时数据处理中的角色,包括数据处理能力、与Kafka和Flume的整合以及实际应用实例。

## 3.1

0

0