YOLOv2目标检测算法在教育领域的应用:辅助教学与互动学习,赋能教育创新

发布时间: 2024-07-08 04:12:57 阅读量: 59 订阅数: 31

# 1. YOLOv2目标检测算法概述**

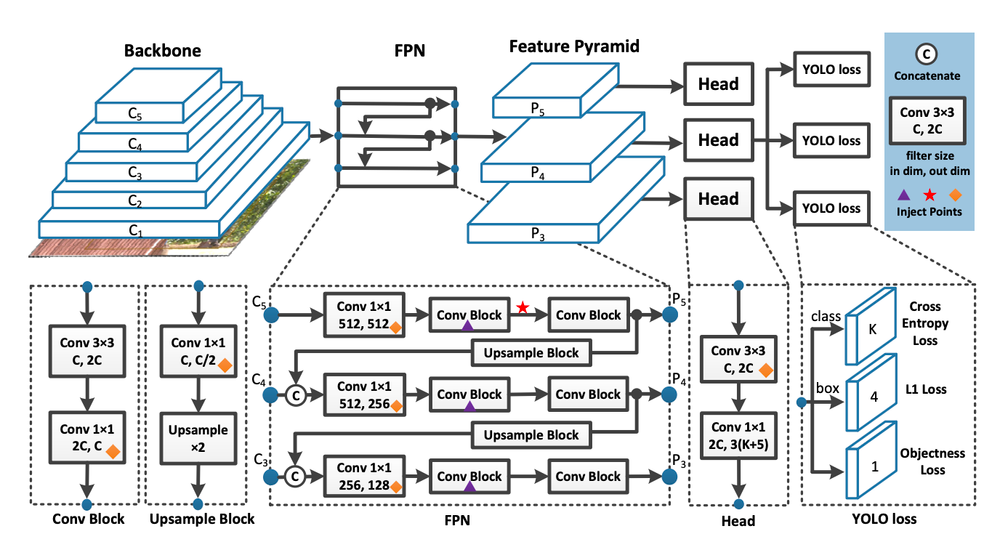

YOLOv2(You Only Look Once version 2)是一种实时目标检测算法,它通过将图像划分为网格并预测每个网格单元中的目标来实现快速而准确的目标检测。与原始YOLO算法相比,YOLOv2引入了Batch Normalization和Anchor Box机制,显著提高了算法的精度和速度。

YOLOv2的架构包括一个卷积神经网络(CNN),它将图像作为输入,并输出一个特征图。特征图中的每个单元对应于输入图像中的一个网格单元,并且每个单元预测该网格单元中是否存在目标、目标的类别以及目标的边界框。通过使用Anchor Box,YOLOv2可以预测不同大小和形状的目标,从而提高了检测精度。

# 2. YOLOv2算法在教育领域的应用

### 2.1 辅助教学

#### 2.1.1 实时目标识别和跟踪

YOLOv2算法可以实时识别和跟踪教室中的物体,例如学生、黑板和投影仪。这使得教师能够专注于教学,而不是花时间在点名或管理课堂纪律上。

**代码块:**

```python

import cv2

import numpy as np

# 加载 YOLOv2 模型

net = cv2.dnn.readNet("yolov2.weights", "yolov2.cfg")

# 打开摄像头

cap = cv2.VideoCapture(0)

# 循环读取视频帧

while True:

# 读取帧

ret, frame = cap.read()

# 预处理帧

blob = cv2.dnn.blobFromImage(frame, 1 / 255.0, (416, 416), (0, 0, 0), swapRB=True, crop=False)

# 输入模型

net.setInput(blob)

# 执行前向传播

detections = net.forward()

# 后处理检测结果

for detection in detections:

# 获取检测框和置信度

x, y, w, h, confidence = detection[0:5]

# 过滤低置信度检测

if confidence > 0.5:

# 绘制检测框

cv2.rectangle(frame, (int(x - w / 2), int(y - h / 2)), (int(x + w / 2), int(y + h / 2)), (0, 255, 0), 2)

# 显示帧

cv2.imshow("Frame", frame)

# 按下 q 退出

if cv2.waitKey(1) & 0xFF == ord("q"):

break

# 释放摄像头

cap.release()

# 销毁所有窗口

cv2.destroyAllWindows()

```

**逻辑分析:**

* `cv2.dnn.readNet()`函数加载YOLOv2模型。

* `cv2.VideoCapture()`函数打开摄像头。

* `cv2.dnn.blobFromImage()`函数对帧进行预处理,将其转换为模型输入所需的格式。

* `net.setInput()`函数将预处理后的帧输入模型。

* `net.forward()`函数执行前向传播,生成检测结果。

* 后处理检测结果,过滤低置信度检测并绘制检测框。

* `cv2.imshow()`函数显示帧。

* `cv2.waitKey()`函数等待用户输入,按q退出。

* `cap.release()`函数释放摄像头。

* `cv2.destroyAllWindows()`函数销毁所有窗口。

#### 2.1.2 互动式学习体验

YOLOv2算法还可以用于创建互动式学习体验。例如,教师可以在教室中放置QR码,学生可以使用智能手机扫描这些QR码来获取更多信息或完成作业。

**代码块:**

```python

import cv2

import numpy as np

import pyzbar

# 加载 YOLOv2 模型

net = cv2.dnn.readNet("yolov2.weights", "yolov2.cfg")

# 打开摄像头

cap = cv2.VideoCapture(0)

# 循环读取视频帧

while True:

# 读取帧

ret, frame = cap.read()

# 预处理帧

blob = cv2.dnn.blobFromImage(frame, 1 / 255.0, (416, 416), (0, 0, 0), swapRB=True, crop=False)

# 输入模型

net.setInput(blob)

# 执行前向传播

detections = net.forward()

# 后处理检测结果

for detection in detections:

# 获取检测框和置信度

x, y, w, h, confidence = detection[0:5]

# 过滤低置信度检测

if confidence > 0.5:

# 绘制检测框

cv2.rectangle(frame, (int(x - w / 2), int(y - h / 2)), (int(x + w / 2), int(y + h / 2)), (0, 255, 0), 2)

# 解码 QR 码

decoded = pyzbar.decode(frame[int(y - h / 2):int(y + h / 2), int(x - w / 2):int(x + w / 2)])

if len(decoded) > 0:

# 获取 QR 码数据

data = decoded[0].da

```

0

0