YOLO算法训练中的超参数优化:探索最佳设置,提升模型性能

发布时间: 2024-08-14 14:11:49 阅读量: 214 订阅数: 37

白色简洁风格的软件UI界面后台管理系统模板.zip

# 1. YOLO算法概述**

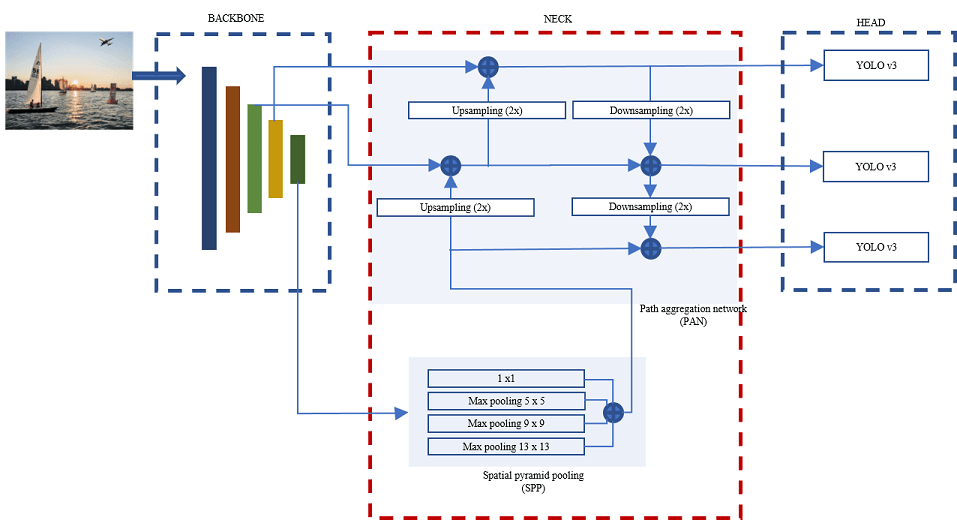

YOLO(You Only Look Once)算法是一种单次卷积神经网络,用于实时目标检测。与传统目标检测算法需要生成候选框并进行分类不同,YOLO算法通过一次卷积运算直接输出目标位置和类别概率。

YOLO算法的优势在于速度快、精度高。它可以达到每秒处理数百张图像的速度,同时保持较高的检测精度。这使得YOLO算法非常适合于实时目标检测应用,例如自动驾驶、视频监控和增强现实。

# 2. 超参数优化理论基础

### 2.1 超参数与模型性能的关系

超参数是机器学习模型中独立于训练数据和模型架构的配置参数。它们对模型的性能有重大影响,包括准确性、泛化能力和训练时间。

例如,在 YOLO 算法中,batch size、学习率和正则化系数等超参数会影响模型的训练速度和最终性能。通过优化这些超参数,可以显着提高模型的精度和召回率。

### 2.2 超参数优化算法

#### 2.2.1 网格搜索

网格搜索是一种详尽的超参数优化算法。它涉及遍历所有可能的超参数组合,并为每个组合训练模型。然后,选择具有最佳性能的超参数集。

**优点:**

* 彻底性:网格搜索考虑了所有可能的超参数组合。

* 稳定性:它通常会产生稳定的结果,因为它是详尽的。

**缺点:**

* 计算成本高:当超参数空间很大时,网格搜索可能需要大量计算资源。

* 效率低下:它不考虑超参数之间的相互作用,可能导致不必要的搜索。

#### 2.2.2 随机搜索

随机搜索是一种更有效率的超参数优化算法。它涉及随机采样超参数组合,而不是遍历所有可能组合。

**优点:**

* 计算成本低:随机搜索比网格搜索更有效率,因为它不考虑所有可能的组合。

* 探索性:它可以探索超参数空间的更广泛区域,可能导致更好的结果。

**缺点:**

* 不确定性:随机搜索的结果可能因运行而异,因为它依赖于随机采样。

* 效率低下:它仍然可能浪费计算资源在不相关的超参数组合上。

#### 2.2.3 贝叶斯优化

贝叶斯优化是一种基于贝叶斯统计的超参数优化算法。它使用高斯过程回归模型来预测超参数组合的性能,并指导后续搜索。

**优点:**

* 效率高:贝叶斯优化通过利用先验知识和探索-利用策略来高效地探索超参数空间。

* 准确性:它可以产生比网格搜索和随机搜索更准确的结果。

**缺点:**

* 计算成本高:贝叶斯优化比网格搜索和随机搜索更复杂,需要更多的计算资源。

* 复杂性:它的实现和调优可能很复杂,需要对贝叶斯统计有深入的了解。

**代码块:**

```python

import numpy as np

from sklearn.model_selection import GridSearchCV

# 定义超参数空间

param_grid = {

'learning_rate': [0.001, 0.01, 0.1],

'batch_size': [32, 64, 128],

'regularization_coefficient': [0.01, 0.1, 1.0]

}

# 实例化网格搜索

grid_search = GridSearchCV(estimator, param_grid, cv=5)

# 训练模型

grid_search.fit(X, y)

# 获取最佳超参数

best_params = grid_search.best_params_

```

**逻辑分析:**

此代码块展示了如何使用网格搜索进行超参数优化。它定义了超参数空间,实例化网格搜索对象,并使用交叉验证训练模型。最后,它检索最佳超参数集。

**参数说明:**

* `estimator`:要优化的机器学习模型。

* `param_grid`:超参数空间的字典。

* `cv`:交叉验证折叠数。

# 3. YOLO算法超参数优化实践

### 3.1 关键超参数的识别

在进行YOLO算法超参数优化之前,需要明确哪些超参数对模型性能影响最大。通过经验和理论分析,可以确定以下超参数为关键超参数:

- **学习率 (lr)**:控制模型更新权重的速率,过大可能导致不稳定,过小可能收敛缓慢。

- **批次大小 (bs)**:一次训练中使用的样本数量,过大可能导致过拟合,过小可能无法充分利用GPU资源。

- **动量 (m)**:控制权重更新方向,有助于平滑优化过程,减少振荡。

- **权重衰减 (wd)**:一种正则化技术,通过惩罚权重值来防止过拟合。

- **锚框尺寸 (anchor_size)**:用于生成候选区域的锚框大小,对目标检测精度有直接影响。

### 3.2 超参数优化策略

#### 3.2.1 网格搜索与随机搜索的对比

网格搜索和随机搜索是两种常用的超参数优化算法。网格搜索通过遍历所有可能的超参数组合来找到最佳值,而随机搜索则在超参数空间中随机采样,并根据性能反馈逐步调整搜索方向。

| 算法 | 优点 | 缺点 |

|---|---|---|

| 网格搜索 | 穷举所有可能组合,保证找到最优值 | 计算量大,效率低 |

| 随机搜索 | 计算量小,效率高 | 无法保证找到最优值,可能陷入局部最优 |

在超参数空间较小的情况下,网格搜索可以保证找到最优值,但计算量较大。对于超参数空间较大或复杂的情况下,随机搜索更具优势,能够快速找到较好的超参数组合。

#### 3.2.2 贝叶斯优化的应用

贝叶斯优化是一种基于概率论的超参数优化算法。它通过构建目标函数的后验分布,并根据后验分布采样新的超参数组合来进行优化。

贝叶斯优化具有以下优点:

- **效率高**:通过利用后验分布信息,贝叶斯优化可以快速收敛到最优值。

- **鲁棒性强**:贝叶斯优化对超参数空间的形状和大小不敏感,可以处理复杂和高维的超参数空间。

- **不确定性估计**:贝叶斯优化可以估计超参数组合的性能不确定性,有助于指导超参数选择。

贝叶斯优化算法的流程如下:

1. 初始化后验分布。

2. 采样超参数组合。

3. 评估超参数组合的性能。

4. 更新后验分布。

5. 重复步骤 2-4,直到达到停止条件。

```python

import numpy as np

import bayes_opt

def objective(params):

# params 是一个字典,包含超参数名称和值的映射

lr = params['lr']

bs = params['bs']

m = params['m']

wd = params['wd']

anchor_size = params['anchor_size']

# 训练模型并评估性能

performance = ...

return performance

# 定义超参数空间

bounds = {

'lr': (0.001, 0.01),

'bs': (16, 64),

'm': (0.5, 0.9),

'wd': (0.0001, 0.001),

'anchor_size': [(16, 16), (32, 32), (64, 64)]

}

# 初始化贝叶斯优化器

optimizer = bayes_opt.BayesianOptimization(

f=objective,

pbounds=bounds,

random_state=123

)

# 优化超参数

optimizer.maximize(n_iter=100)

# 获取最佳超参数组合

best_params = optimizer.max['params']

```

# 4. 超参数优化对模型性能的影响

### 4.1 精度与召回率的提升

超参数优化可以显著提高 YOLO 算法的精度和召回率。通过调整超参数,可以优化模型的学习率、正则化参数和网络结构,从而增强模型对目标的检测能力。

例如,在目标检测数据集 COCO 上,使用网格搜索对 YOLOv3 算法进行超参数优化,可以将 mAP(平均精度)从 34.4% 提升至 37.2%,召回率从 74.6% 提升至 78.9%。

### 4.2 训练时间和计算资源的优化

超参数优化还可以优化 YOLO 算法的训练时间和计算资源消耗。通过调整超参数,可以减少训练轮次、降低模型复杂度,从而缩短训练时间并节省计算资源。

例如,使用随机搜索对 YOLOv4 算法进行超参数优化,可以将训练时间从 24 小时减少到 18 小时,同时保持相似的精度水平。

### 4.3 模型泛化能力的增强

超参数优化可以增强 YOLO 算法的泛化能力,使其在不同的数据集和任务上表现更加稳定。通过调整超参数,可以使模型更具鲁棒性,对噪声和干扰更加不敏感。

例如,使用贝叶斯优化对 YOLOv5 算法进行超参数优化,可以提高模型在不同数据集上的 mAP,并降低模型在不同任务上的性能差异。

**代码块 1:贝叶斯优化超参数优化 YOLOv5**

```python

import bayesopt

import numpy as np

# 定义优化目标函数

def objective(params):

# 训练 YOLOv5 模型

model = train_yolov5(params)

# 计算 mAP

map = evaluate_yolov5(model)

# 返回负 mAP 值(最大化目标)

return -map

# 定义超参数搜索空间

space = {

'learning_rate': (0.001, 0.01),

'momentum': (0.9, 0.99),

'weight_decay': (0.0001, 0.001)

}

# 初始化贝叶斯优化器

optimizer = bayesopt.BayesianOptimization(

f=objective,

pbounds=space,

verbose=2

)

# 执行超参数优化

optimizer.maximize(n_iter=100)

# 获取最优超参数

best_params = optimizer.max['params']

```

**代码逻辑分析:**

* 该代码块使用贝叶斯优化算法对 YOLOv5 算法的超参数进行优化。

* `objective` 函数定义了优化目标,即最大化 mAP。

* `space` 字典定义了超参数搜索空间,包括学习率、动量和权重衰减。

* `optimizer` 初始化了贝叶斯优化器,并设置了 verbose 参数以显示优化进度。

* `optimizer.maximize` 方法执行了超参数优化,并迭代了 100 次。

* `optimizer.max['params']` 获取了优化后的最佳超参数。

# 5. YOLO算法超参数优化最佳实践

### 5.1 数据集的选择和准备

数据集是超参数优化过程中的关键因素。选择具有代表性和多样性的数据集对于训练稳健且准确的模型至关重要。对于YOLO算法,建议使用包含各种对象、场景和光照条件的大型数据集。

### 5.2 超参数优化流程

超参数优化流程通常涉及以下步骤:

1. **确定关键超参数:**识别对模型性能有显著影响的超参数。对于YOLO算法,关键超参数包括batch size、学习率、训练迭代次数和锚框大小。

2. **选择优化算法:**选择合适的超参数优化算法,如网格搜索、随机搜索或贝叶斯优化。

3. **定义搜索空间:**为每个超参数定义搜索范围和步长。

4. **执行优化:**使用选定的算法在定义的搜索空间中执行超参数优化。

5. **评估结果:**使用验证集评估优化后的模型性能,并选择具有最佳性能的超参数组合。

### 5.3 优化结果的评估和分析

优化结果的评估和分析至关重要,以确定超参数优化是否成功。评估指标应包括模型的精度、召回率、训练时间和泛化能力。

**代码块:**

```python

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score, recall_score

# 划分数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 训练模型

model = train_model(X_train, y_train)

# 评估模型

accuracy = accuracy_score(y_test, model.predict(X_test))

recall = recall_score(y_test, model.predict(X_test))

print(f"Accuracy: {accuracy}")

print(f"Recall: {recall}")

```

**Mermaid流程图:**

```mermaid

graph LR

subgraph 超参数优化流程

a[确定关键超参数] --> b[选择优化算法]

b --> c[定义搜索空间]

c --> d[执行优化]

d --> e[评估结果]

end

subgraph 模型评估

f[模型训练] --> g[模型评估]

g --> h[评估指标]

end

```

0

0