YOLO算法训练中的性能分析:深入理解模型行为,提升模型性能

发布时间: 2024-08-14 15:00:24 阅读量: 32 订阅数: 37

YOLOv5算法吸烟行为检测模型,包含1000多张左右YOLO算法吸烟行为检测数据集

# 1. YOLO算法概述**

YOLO(You Only Look Once)是一种单次镜头目标检测算法,它将目标检测任务表述为一个回归问题。与传统的基于区域提议的算法不同,YOLO直接从图像中预测目标的边界框和类别概率。

YOLO算法的核心思想是将输入图像划分为一个网格,每个网格负责检测落在其中的目标。对于每个网格,YOLO预测一组边界框和相应的类别概率。最终,通过非极大值抑制(NMS)算法,选择每个目标最具信心的预测作为检测结果。

# 2. YOLO算法训练基础

### 2.1 数据集准备

#### 2.1.1 数据集的选择和预处理

选择合适的训练数据集对于YOLO算法的性能至关重要。数据集应包含大量高质量的图像,这些图像具有多样化的对象、背景和光照条件。

数据预处理是将原始图像转换为模型可接受格式的过程。预处理步骤包括:

* **调整大小:**将图像调整为统一大小,以满足模型输入要求。

* **归一化:**将像素值归一化到[0, 1]范围内,以减少不同图像之间的亮度差异。

* **数据增强:**使用数据增强技术,如翻转、旋转和裁剪,增加训练数据集的样本多样性。

#### 2.1.2 数据增强技术

数据增强是提高模型鲁棒性和泛化能力的有效方法。常用的数据增强技术包括:

* **随机翻转:**水平或垂直翻转图像,增加模型对不同对象方向的适应性。

* **随机旋转:**旋转图像一定角度,增强模型对不同角度的识别能力。

* **随机裁剪:**从图像中随机裁剪不同大小和形状的区域,增加模型对部分遮挡对象的鲁棒性。

### 2.2 训练参数设置

#### 2.2.1 学习率、批大小和迭代次数

* **学习率:**学习率控制模型权重更新的步长。较高的学习率可能导致模型不稳定,而较低的学习率可能导致训练缓慢。

* **批大小:**批大小是指每次训练迭代中使用的图像数量。较大的批大小可以提高训练效率,但可能导致模型过拟合。

* **迭代次数:**迭代次数是指模型训练的总次数。较多的迭代次数可以提高模型精度,但可能导致训练时间过长。

#### 2.2.2 正则化和优化器选择

* **正则化:**正则化技术,如L1正则化和L2正则化,可以防止模型过拟合。

* **优化器:**优化器,如梯度下降和Adam,用于更新模型权重。不同的优化器具有不同的更新规则,可能会影响训练速度和模型性能。

**代码块:**

```python

import torch

from torch.optim import Adam

# 设置训练参数

learning_rate = 0.001

batch_size = 32

num_epochs = 100

# 初始化优化器

optimizer = Adam(model.parameters(), lr=learning_rate)

```

**代码逻辑分析:**

该代码块设置了训练参数,包括学习率、批大小和迭代次数。它还初始化了Adam优化器,该优化器将用于更新模型权重。

**参数说明:**

* `model`:要训练的YOLO模型。

* `learning_rate`:学习率,控制权重更新的步长。

* `batch_size`:批大小,每次迭代中使用的图像数量。

* `num_epochs`:迭代次数,训练的总次数。

# 3. YOLO算法训练过程

### 3.1 模型架构分析

#### 3.1.1 网络结构和层数

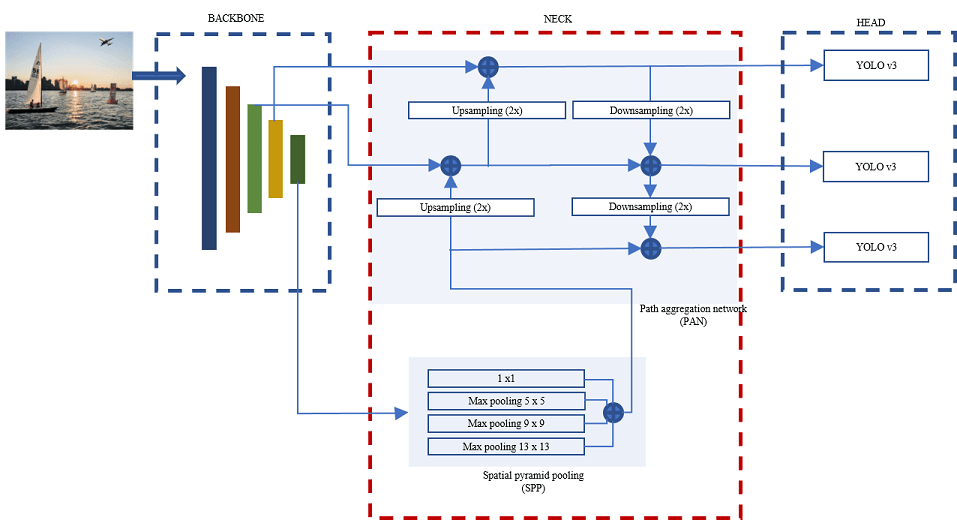

YOLO算法的网络结构通常包括卷积层、池化层、激活函数和全连接层。卷积层用于提取图像特征,池化层用于降低特征图尺寸,激活函数用于引入非线性,全连接层用于分类和回归。

YOLOv5的网络结构如下:

```

Input -> Conv -> BatchNorm -> LeakyReLU -> MaxPool -> Conv -> BatchNorm -> LeakyReLU -> MaxPool -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> MaxPool -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU -> Conv -> BatchNorm -> LeakyReLU

```

0

0