【网络数据价值提炼】:从抓包数据中提取价值,掌握数据挖掘与分析技巧

G6-JavaScript资源

摘要

随着信息技术的飞速发展,网络数据的价值提炼成为了企业和研究者关注的焦点。本文首先概述了网络数据价值提炼的重要性,并对数据挖掘的基础理论进行了探讨,包括数据挖掘的目的、应用领域、基本流程及方法论。接着,文章详细分析了数据预处理技术如数据清洗、整合、变换及降维,并对分类、回归、聚类和关联规则等数据挖掘算法进行了深入解析。在网络数据抓包与分析技术章节中,本文介绍了网络数据抓包工具和技巧、数据包分析方法论以及网络异常行为的识别技术。随后,本文通过实战演练的方式,探讨了数据挖掘在用户行为分析、网络安全监控及市场趋势预测等实际应用案例。最后,文章讨论了大数据背景下数据挖掘的进阶应用,隐私保护和数据安全问题,并展望了数据挖掘未来的发展趋势和所面临的挑战。

关键字

网络数据价值;数据挖掘;预处理技术;抓包分析;异常行为识别;大数据应用

参考资源链接:使用jpcap在Java中实现网络抓包

1. 网络数据价值提炼概述

在当今的数字时代,数据已成为最有价值的资源之一,尤其在网络技术飞速发展的背景下,网络数据的价值提炼变得至关重要。网络数据不仅仅指的是日常互联网上产生的文本、图片、视频等内容,更包括了用户行为、设备信息、交易记录等多维度信息。了解网络数据价值提炼的过程和方法,对于IT行业从业者来说,是提升个人和企业竞争力的关键。

网络数据价值提炼的核心,在于能够准确地从海量信息中提取有用信息,并将其转化为可操作的见解和策略。这种提炼不仅需要对网络数据的结构和性质有深入的理解,还要求掌握一系列的数据处理和分析技能。接下来的章节,我们将深入探讨数据挖掘的基础理论、网络数据抓包分析技术,以及数据挖掘与分析的实战演练,最终提出数据挖掘在大数据环境下的应用与面临的挑战。

1.1 网络数据的特性与价值

网络数据具有多样性、实时性和海量性的特点。多样性意味着数据类型包括结构化数据和非结构化数据;实时性体现在数据更新速度极快,能够反映最新的网络状态;海量性则是指数据量庞大,往往达到TB级别。因此,提炼网络数据的价值,必须采用相应的技术手段来处理和分析这些数据。

1.2 数据提炼的方法论

数据价值提炼的方法论涉及数据的采集、处理、分析和应用等步骤。在采集阶段,需要确定数据来源和采集方法;在处理阶段,包括数据清洗、整合、变换等预处理工作;分析阶段涉及到算法的选择和模型的建立;应用阶段,则是对分析结果的解释和利用,转化为决策支持或服务提供。

1.3 数据提炼的技术挑战

提炼网络数据价值的过程中会面临多种技术挑战。例如,数据的质量和完整性直接影响分析结果的准确性。此外,数据隐私保护和合规性问题也是当前业界关注的重点。如何在不侵犯用户隐私的前提下,高效地利用数据,是每个企业必须考虑的问题。

以上是第一章的内容概要,通过对网络数据价值提炼的概述,为读者构建一个整体的认识框架,以便在后续章节中深入探讨具体的数据挖掘技术和应用案例。

2. 数据挖掘基础理论

2.1 数据挖掘的定义与重要性

数据挖掘是指从大量数据中通过算法搜索隐藏信息的过程。这个过程通常被用来发现数据中的模式和建立预测模型。数据挖掘的目的通常是为了决策支持,但其应用广泛,涉及商业智能、市场分析、健康医疗、科学研究等诸多领域。

2.1.1 数据挖掘的目的与应用领域

在商业领域,数据挖掘可以帮助企业发现消费者购买习惯、优化营销策略、减少欺诈行为等。在医疗领域,它可以用于疾病的预测和诊断辅助,提高治疗效果。在科学研究中,数据挖掘技术可以帮助研究人员在浩如烟海的数据中寻找到有价值的信息。

为了实现这些目的,数据挖掘通常会与各种应用领域结合,包括但不限于:

- 客户关系管理(CRM)

- 供应链管理

- 生物信息学

- 网络安全

- 社交网络分析

数据挖掘的这些应用领域彰显了它在现代数据驱动的决策支持系统中的核心作用。

2.1.2 数据挖掘的基本流程与方法论

数据挖掘的基本流程通常包括以下几个步骤:

- 商业理解(Business Understanding):明确业务问题,确定数据挖掘目标。

- 数据理解(Data Understanding):收集初步数据,了解数据质量,探索数据。

- 数据准备(Data Preparation):数据清洗、数据集成、数据变换、数据归约。

- 建模(Modeling):选择合适的算法,构建模型。

- 评估(Evaluation):评估模型的有效性,确保它满足业务需求。

- 部署(Deployment):将模型集成到生产环境,定期监控与更新。

方法论上,数据挖掘采用多种技术,包括统计分析、机器学习、神经网络、遗传算法等。每种技术都有其特定的应用场景和优缺点。选择合适的方法论是实现数据挖掘目标的关键。

2.2 数据预处理技术

2.2.1 数据清洗与数据整合

数据清洗是数据预处理的首要步骤,它的目的是识别并修正数据中的错误和不一致性,减少噪音,确保数据质量。常见的数据清洗方法包括:

- 缺失值处理

- 异常值检测与处理

- 重复数据的识别与删除

- 不一致数据的校正

数据整合则涉及到从不同来源合并数据,以便进行统一分析。在整合过程中,数据的结构、格式、命名规则等都需要进行标准化处理。

2.2.2 数据变换与降维

数据变换的目的是将数据转换为更适合挖掘的形式。常见的变换方法有:

- 规范化和标准化

- 数据离散化

- 特征构造

降维技术用于减少数据集中变量的数目,主要方法包括:

- 主成分分析(PCA)

- 线性判别分析(LDA)

降维有助于简化数据集的结构,同时尽可能保留原始数据的特征信息。

2.3 数据挖掘算法解析

2.3.1 分类与回归算法

分类算法用于预测或分类数据的类别标签,常见的分类算法包括:

- 决策树(Decision Tree)

- 随机森林(Random Forest)

- 支持向量机(SVM)

- 逻辑回归(Logistic Regression)

而回归算法则用于预测数值型数据,常见的回归算法有:

- 线性回归(Linear Regression)

- 多项式回归(Polynomial Regression)

2.3.2 聚类与关联规则算法

聚类算法用于将数据集中的对象分组成多个簇,以便于发现数据的内部结构。常见的聚类算法包括:

- K-均值聚类(K-Means)

- 层次聚类(Hierarchical Clustering)

关联规则算法用于发现数据集中的频繁项集,挖掘项之间的有趣关系。典型的关联规则算法有:

- Apriori算法

- FP-Growth算法

这些算法的有效选择和应用是数据挖掘成功的关键。在实际应用中,算法的选择取决于数据的特性及挖掘任务的需求。

3. 网络数据抓包与分析技术

3.1 网络数据抓包工具与技巧

3.1.1 常用的网络抓包工具介绍

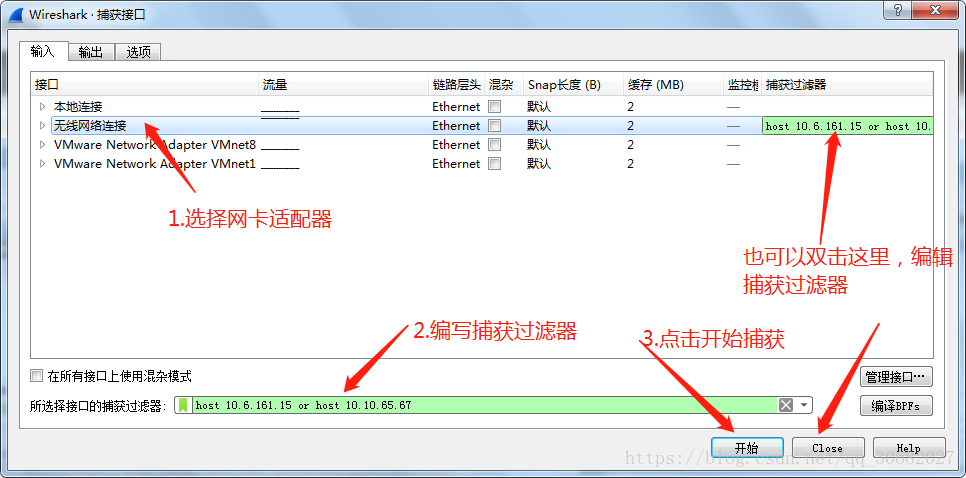

在网络数据分析的过程中,抓包是不可或缺的一步。掌握各种抓包工具的特点和使用场景对于分析工作至关重要。常用的网络抓包工具有Wireshark、tcpdump、TShark等,它们分别在不同的操作环境和使用需求中发挥着各自的优势。

Wireshark是一款图形界面抓包工具,以其强大的数据包分析功能和直观的界面著称,适用于复杂的网络协议分析和问题诊断。它支持多种操作系统,是教育、研究及企业环境中网络工程师和安全专家的首选。

tcpdump则是一款命令行界面的抓包工具,以其轻量级和高性能而受到青睐。它常用于Linux和Unix系统中,对于需要在后台运行和集成到脚本中的自动化任务非常适合。

TShark是Wireshark的命令行版本,拥有和Wireshark几乎相同的包分析能力,但更适合用于脚本操作和自动化处理。