【日志过滤艺术】:记录关键信息,避免信息过载

发布时间: 2024-10-22 21:12:21 阅读量: 27 订阅数: 34

Web2.0:信息过载的原因和解决方法

# 1. 日志文件的重要性与挑战

## 1.1 日志文件的作用

日志文件是信息系统中的重要组成部分,它记录了系统运行过程中的各种事件和状态变化。通过对日志文件的分析,运维人员可以监控系统状态、追踪故障原因、优化系统性能,甚至进行安全审计。日志文件的重要性不可小觑,它可以帮助我们构建一个更可靠、更安全、更高效的信息环境。

## 1.2 日志数据的挑战

尽管日志文件的功能强大,但在处理它们时我们面临着不少挑战。首先,日志量通常非常庞大,且增长速度快,手工处理几乎不可能。其次,日志数据是非结构化的,需要借助特定工具和技术进行解析和过滤。此外,如何从海量的日志数据中提取有价值的信息,也是一个亟需解决的问题。这些挑战推动着日志管理技术不断发展,特别是在自动化和智能化方面。

# 2. 日志过滤的基础理论

## 2.1 日志数据的特点与结构

### 2.1.1 日志格式的种类与解析

日志数据的格式多种多样,常见的格式包括但不限于纯文本、CSV、JSON、XML等。每种格式有其特定的解析方式,而且在存储和查询性能上也存在差异。纯文本格式简单直接,但解析效率较低;而JSON、XML等结构化格式则便于快速提取信息,但数据量较大时可能会增加存储成本。下面是一个JSON格式日志的示例及其解析方法:

```json

{

"timestamp": "2023-04-01T12:00:00Z",

"level": "INFO",

"message": "Application started successfully",

"component": "AppServer"

}

```

为了解析上述日志,通常会使用如下的脚本进行处理:

```python

import json

# 日志数据

log_data = '''

{"timestamp": "2023-04-01T12:00:00Z", "level": "INFO",

"message": "Application started successfully", "component": "AppServer"}

# 解析JSON格式的日志

log_entry = json.loads(log_data)

# 提取特定字段

timestamp = log_entry['timestamp']

level = log_entry['level']

message = log_entry['message']

component = log_entry['component']

print(f"Timestamp: {timestamp}")

print(f"Level: {level}")

print(f"Message: {message}")

print(f"Component: {component}")

```

在解析JSON日志时,每个键值对都可能包含有用的信息,我们可以根据需求提取相关数据。理解日志格式对于过滤和查询日志内容至关重要。

### 2.1.2 日志数据的结构化方法

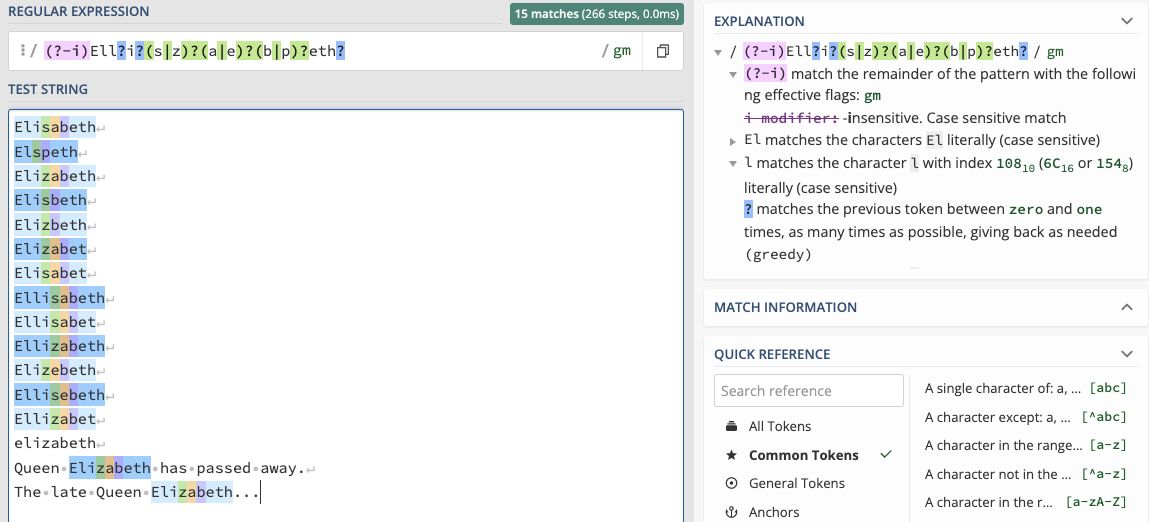

结构化日志意味着将日志数据组织成表格形式,便于查询和分析。结构化过程通常涉及到日志字段的提取、分类和存储。结构化可以通过正则表达式、专用解析工具或编程语言中的库来实现。

下面是一个使用正则表达式将非结构化日志转换为结构化数据的Python示例:

```python

import re

# 非结构化日志字符串

raw_log = "2023-04-01 12:00:00 INFO Application started successfully"

# 正则表达式用于匹配日志格式

pattern = ***pile(r'(?P<timestamp>\d{4}-\d{2}-\d{2} \d{2}:\d{2}:\d{2}) '

r'(?P<level>\w+) '

r'(?P<msg>.*)')

# 搜索匹配项

match = pattern.search(raw_log)

if match:

structured_log = match.groupdict()

print(structured_log)

```

执行上述代码后,将得到如下结构化的数据:

```json

{

"timestamp": "2023-04-01 12:00:00",

"level": "INFO",

"msg": "Application started successfully"

}

```

通过这种方式,可以将复杂的日志文本转换为结构化数据,进而应用数据库查询、数据挖掘等高级技术。结构化处理是日志管理中不可或缺的一环,它为日志的高效利用奠定了基础。

## 2.2 日志过滤的原则与策略

### 2.2.1 过滤的标准与重要性

在处理日志数据时,过滤是必不可少的过程,因为无节制地存储所有日志信息将导致数据膨胀,从而增加存储成本,并使得关键信息的检索变得困难。日志过滤的标准通常基于日志级别、来源、内容、时间戳等属性。选择合适的过滤标准能够帮助我们关注于那些最为重要的日志事件。

过滤的重要性在于它能:

- 减少噪音,突出重点。

- 保护存储资源,减少不必要的开销。

- 提高检索效率,快速定位问题。

- 增强系统的安全性,如防止敏感信息泄露。

例如,安全相关的日志事件对于遵守合规性和快速响应潜在威胁至关重要。通常,这些事件会被设置为高优先级,以便在出现异常活动时立即通知管理员。

### 2.2.2 设计有效的日志过滤策略

设计有效的日志过滤策略需要权衡多个因素:

1. **业务需求:** 根据业务流程和用户行为模式确定关键日志事件。

2. **风险评估:** 评估过滤掉某些日志可能带来的风险。

3. **系统性能:** 确保过滤策略不会对系统性能产生负面影响。

4. **成本效益:** 在满足需求的同时,最小化资源消耗和成本。

过滤策略的一个关键组成部分是确定规则,这些规则定义了哪些日志应该被保留、归档或丢弃。一个典型的过滤规则可能如下:

- 只保留严重错误和警告级别的日志。

- 记录所有用户的登录失败尝试。

- 过滤掉特定健康检查服务的日志。

这些策略必须定期审查和更新,以适应系统变化和新的业务需求。此外,策略设计应考虑未来的扩展性,以便容易地适应新的日志来源和格式。

## 2.3 日志过滤工具与技术

### 2.3.1 常用日志过滤工具介绍

市场上存在多种日志过滤工具,它们提供了不同的功能和优势,适用于不同的使用场景。以下是一些流行工具的简要介绍:

- **ELK Stack**(Elasticsearch, Logstash, Kibana): ELK是一种常用于日志聚合的解决方案,其中Logstash可以用于日志的输入、过滤和输出。

- **Fluentd**:Fluentd是一个开源数据收集器,用于统一日志层。它拥有1000多个插件用于过滤和输出数据。

- **LogReduce**:LogReduce是一个日志分析工具,能够自动化地识别和过滤出日志中的模式和异常。

- **Graylog**:Graylog是一个集中式日志管理平台,提供了强大的数据过滤和分析能力。

每个工具都有其特点,例如,Elasticsearch擅长于全文搜索和实时分析,而Fluentd则在数据收集和转换方面表现突出。选择哪个工具取决于特定的业务需求和现有技术栈。

### 2.3.2 过滤技术的比较与选择

比较和选择日志过滤技术时,需要考虑以下因素:

- **性能**:过滤工具的处理能力和资源消耗。

- **灵活性**:过滤规则的定制和修改是否简单。

- **可靠性**:数据处理的一致性和容错能力。

- **兼容性**:支持的日志格式和与其他系统的集成能力。

- **成本**:工具的采购、运行和维护成本。

以ELK Stack和Fluentd为例进行比较:

| 特性/工具 | ELK Stack | Fluentd |

|--------------|----------------------------------------------|----------------------------------------------|

| 性能 | 高,适合大数据量日志分析

0

0