【日志分析与性能优化】:掌握日志记录高级技巧

发布时间: 2024-10-22 20:47:55 阅读量: 50 订阅数: 34

php性能分析之php-fpm慢执行日志slow log用法浅析

# 1. 日志分析与性能优化概述

在信息技术迅猛发展的今天,日志分析与性能优化已成为系统维护和故障排查不可或缺的环节。通过分析日志,工程师可以理解系统运行的行为模式,而性能优化则是确保系统稳定和高效运行的关键。

本章旨在为读者概述日志分析与性能优化的基本概念和重要性,同时揭示它们在IT运维中的核心作用。我们将探索日志管理的基础知识,包括日志记录的目的和类型,以及如何利用日志数据进行故障排查。此外,我们还将探讨性能优化的基础原则,以及性能监控的关键指标和性能瓶颈的识别方法。

随着后续章节的深入,我们将具体介绍日志系统的结构化和分类,以及性能优化的方法和实践技巧。让我们开始这段技术探索之旅,逐步揭开日志分析和性能优化的神秘面纱。

# 2. 日志管理的理论基础

### 2.1 日志系统的重要性与作用

日志系统是IT基础设施的血液,它们记录了系统行为的历史轨迹。理解日志的类型和记录目的,对于后续的日志管理和分析至关重要。

#### 2.1.1 日志记录的目的和类型

日志记录的目的是为了在发生问题时提供诊断信息,同时,通过分析日志内容,可以帮助我们了解系统运行状况、用户行为以及安全威胁等。常见的日志类型包括:

- 系统日志(syslog):记录了操作系统级别的事件,如服务启动和停止。

- 应用程序日志:记录了特定软件应用或服务中的活动和问题。

- 安全日志:记录了认证尝试、授权决策和安全事件。

```markdown

- **系统日志(syslog)**:在Unix和Linux系统中,通过syslog协议记录各类事件信息,包括系统启动、服务状态变化等。

- **应用程序日志**:各种应用程序通常有自己的日志记录系统,例如Web服务器会记录访问日志、错误日志等。

- **安全日志**:操作系统和安全软件会记录所有涉及安全的操作,如用户登录失败、防火墙规则触发等。

```

#### 2.1.2 日志数据在故障排查中的应用

故障排查(troubleshooting)是IT运维的核心任务之一。日志提供了回溯系统故障的第一手资料。以下是利用日志进行故障排查的一些步骤:

1. 确定问题发生时间。

2. 检索在问题时间点附近的相关日志。

3. 分析日志内容,识别错误代码和警告消息。

4. 根据日志记录调整系统配置或修复软件问题。

### 2.2 日志数据的结构化与分类

随着数据量的增长,未结构化日志变得难以管理和分析。因此,日志的结构化处理和分类对于日志管理至关重要。

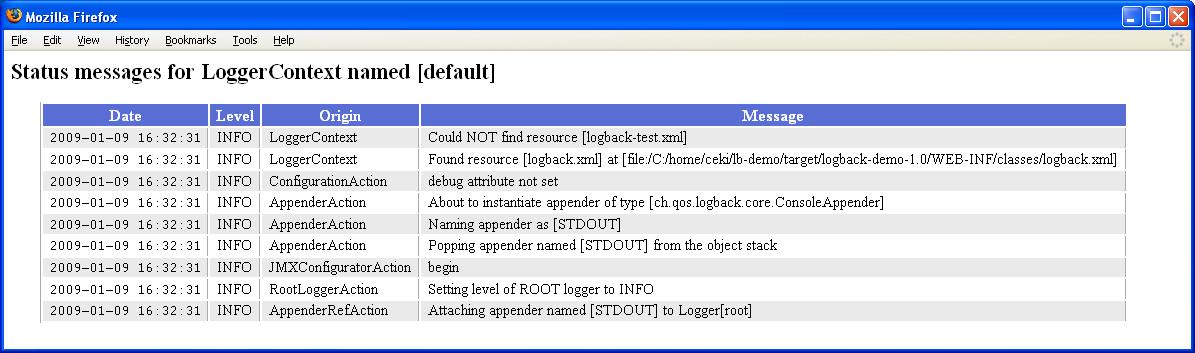

#### 2.2.1 结构化日志的基本概念

结构化日志指的是日志数据以一种容易查询和分析的形式存储,如键值对或表格。它们通常包含以下元素:

- 时间戳:记录事件发生的时间。

- 源:记录消息来源,如服务器名或应用名。

- 消息级别:例如INFO、WARNING、ERROR等。

- 消息内容:实际记录的信息。

```markdown

结构化日志能够通过简单的查询来快速检索特定事件或错误,大大提高了日志处理的效率。例如,在ELK Stack中,Elasticsearch就提供了强大的查询语言,可以对结构化后的日志数据进行复杂分析。

```

#### 2.2.2 日志分类方法及其意义

将日志进行分类,有助于更好地管理和维护日志系统。例如,可以按照来源、严重性、业务类型等进行分类。分类可以帮助:

- 确定日志保留策略,哪些日志需要长期保存,哪些只需要短期保存。

- 快速定位问题,比如按应用服务分组的日志便于针对特定服务的故障排查。

- 优化性能,分类后的日志可以有针对性地进行索引优化。

```markdown

例如,可以将Web服务器的日志与数据库服务器的日志分开存储。这样,当需要分析Web服务器性能问题时,可以只关注Web服务器的日志,而无需遍历整个日志库。

```

### 2.3 日志收集与传输机制

日志收集是日志管理的起始步骤,它决定了日志数据如何从源头传输到存储和分析平台。

#### 2.3.1 常见的日志收集工具和方法

市场上有多种日志收集工具,如Fluentd、Logstash、Filebeat等。这些工具支持从多个源收集日志,并以统一格式进行传输。常见的收集方法包括:

- **日志文件轮转**:日志文件达到一定大小后,会自动轮转,新日志写入新文件。

- **实时传输**:通过syslog或网络传输协议,如TCP或UDP,将日志实时发送到日志收集服务器。

- **代理收集**:安装代理软件在服务器上,由代理负责收集和预处理日志。

```markdown

例如,Filebeat是一个轻量级的日志文件数据发送器,它可以与Logstash配合使用,通过配置文件指定哪些日志文件需要被监控和发送。以下是Filebeat的基本配置示例:

```yaml

filebeat.inputs:

- type: log

enabled: true

paths:

- /var/log/*.log

output.logstash:

hosts: ["logstash-host:5044"]

```

#### 2.3.2 日志传输的安全性考虑

在传输日志数据时,必须考虑安全性,因为日志可能包含敏感信息。保障传输安全的方法包括:

- **加密传输**:使用TLS/SSL协议对传输过程进行加密,确保日志内容不被窃取。

- **身份验证**:对日志收集和分析系统进行身份验证,以防止未授权访问。

- **访问控制**:确保只有授权的系统或用户才能读取和分析日志数据。

```markdown

在实际操作中,需要在配置日志收集工具时,设置正确的SSL证书和密钥,确保传输过程加密。此外,还可以对日志进行脱敏处理,去除或替换敏感信息。

```

为了确保日志传输的安全性,IT团队应定期评估和更新日志收集和传输策略,确保符合当前的安全标准和最佳实践。

# 3. 日志分析实践技巧

## 3.1 日志分析工具的选择与使用

### 3.1.1 常见日志分析工具特性对比

在IT行业中,日志分析是一个多层次的任务,涉及到从数据提取到深层次分析的一系列工具。下面将对比几种常见的日志分析工具,它们各自的优势、应用场景及特性。

**ELK Stack (Elasticsearch, Logstash, Kibana)**

- **优势**:高度可定制,灵活的数据处理管道,强大且易于使用的数据可视化工具Kibana。

- **应用**:广泛应用于大型环境下的日志集中管理和分析,适合复杂的数据处理和多维度的日志数据可视化。

- **特性**:Elasticsearch作为搜索引擎提供全文搜索功能,Logstash用于数据的收集和处理,而Kibana提供友好的用户界面。

**Splunk**

- **优势**:对于用户来说,Splunk的安装和配置相对简单,非常适合初学者和对日志分析有即时需求的场景。

- **应用**:特别适合于需要快速构建日志管理解决方案的场景,同时其强大的搜索功能,让分析历史日志数据变得轻而易举。

- **特性**:提供丰富的插件和应用,以及强大的实时处理能力。

**Graylog**

- **优势**:开源且免费,界面友好,易于扩展。

- **应用**:对于小型到中型的项目来说,Graylog是一个很好的选择。它提供了强大的搜索功能,并支持自定义规则和警报。

- **特性**:支持与Elasticsearch和MongoDB集成,提供全文搜索和地理空间搜索功能。

### 代码块展示与分析

在选择合适工具后,进行基本的配置是关键的一步。以下是使用Logstash(ELK Stack的一部分)配置文件的一个示例:

```conf

input {

file {

path => "/var/log/syslog"

start_position => "beginning"

}

}

filter {

grok {

match => { "message" => "%{SYSLOGLINE}" }

}

date {

match => [ "timestamp" , "MMM d HH:mm:ss", "MMM dd HH:mm:ss" ]

}

}

output {

elasticsearch {

hosts => ["localhost:9200"]

index => "syslog-%{+YYYY.MM.dd}"

}

}

```

在此配置文件中,Logstash首先从指定路径读取日志文件,然后使用`grok`过滤器来解析日志行中的信息。`date`过滤器用于正确解析时间戳。最终,所有解析和处理后的日志数据将存储到Elasticsearch中。

### 3.1.2 日志分析工具的高级配置与运用

在日志分析工具的使用中,高级配置能够帮助我们更精细地处理和分析数据。下面通过ELK Stack来展示如何进行高级配置。

**聚合分析**

聚合分析允许我们对日志数据进行更深层次的挖掘。例如,使用Elasticsearch的聚合功能来查看特定时间段内的应用错误率:

```json

GET /log_data/_search

{

"size": 0,

"query": {

"range": {

"@timestamp": {

"gte": "2023-03-01T00:00:00Z",

"lte": "2023-03-31T23:59:59Z"

}

}

},

"aggs": {

"error_count": {

"filter": {

"term": {

"log.level": "ERROR"

}

}

}

}

}

```

**数据可视化**

数据

```

0

0