【HDFS数据格式全解析】:从TextFile到自定义格式,全面了解HDFS的数据存储与访问

发布时间: 2024-10-28 09:55:28 阅读量: 76 订阅数: 24

# 1. HDFS数据格式概述与基础

在大数据存储和处理领域,Hadoop分布式文件系统(HDFS)作为存储解决方案的核心,其数据格式直接影响着整个系统的性能和扩展性。本章将为读者提供对HDFS数据格式的概览,涵盖基本概念与关键术语,为深入理解后续章节中涉及的不同数据格式打下坚实的基础。

HDFS是构建在普通硬件上的分布式文件系统,它通过冗余存储数据以保障可靠性,并且设计了特定的数据格式来优化读写操作。本章将探讨HDFS数据格式的基础知识点,包括但不限于数据块的大小设置、数据节点的组织方式以及如何通过数据格式来满足不同的性能和存储需求。

通过分析HDFS的数据格式,我们可以获得对Hadoop生态系统中数据存储和处理的深刻理解,为选择适合特定业务场景的数据格式提供指导。下一章我们将深入探讨HDFS中最传统且广泛使用的一些数据格式,如TextFile、SequenceFile和AvroFile。

# 2. 传统HDFS数据格式详解

## 2.1 TextFile格式解析

### 2.1.1 TextFile的结构和特性

TextFile是Hadoop中最简单的文本文件格式,它的每一行是一个文本记录。每条记录由一个或多个字段组成,字段间通常用逗号或其他分隔符分隔。TextFile格式易于阅读和编辑,因此在进行数据预处理和小规模数据集操作时非常方便。其结构简单、兼容性好,支持多种编程语言进行解析,但缺点在于缺乏压缩和高效二进制存储,不适合存储大量数据。

### 2.1.2 TextFile的读写原理

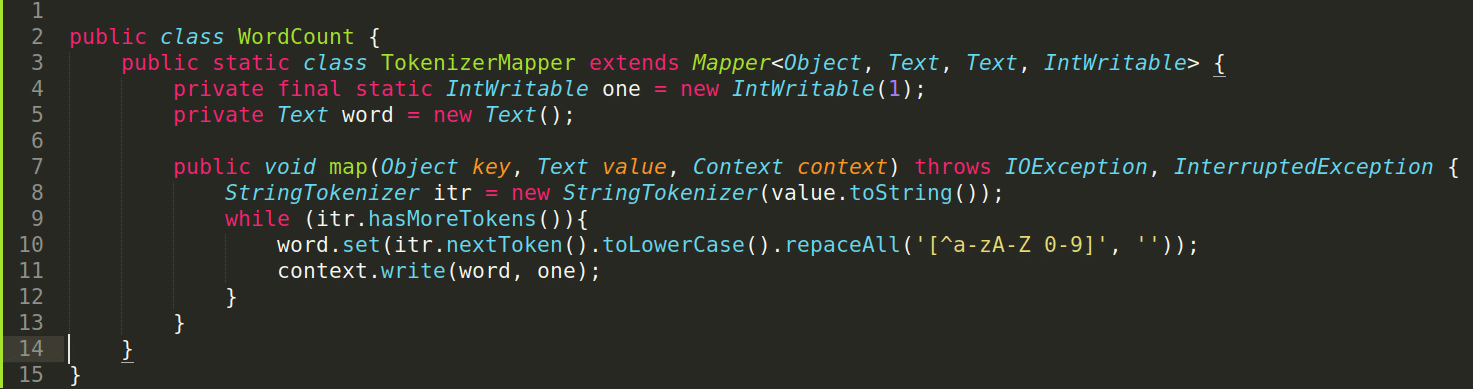

TextFile的读取首先涉及文件定位,之后按行读取。对于写入操作,文本按行写入,每行数据结尾添加换行符。Hadoop通过TextInputFormat来处理TextFile输入,而TextOutputFormat则处理输出。在解析每一行时,Hadoop会根据配置的分隔符将每行数据切分成字段,然后传递给Map函数进行处理。

```java

// 使用TextInputFormat读取TextFile数据示例代码

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "Read TextFile");

job.setInputFormatClass(TextInputFormat.class);

Path inputPath = new Path(args[0]);

FileSystem fs = FileSystem.get(conf);

FSDataInputStream fsin = fs.open(inputPath);

BufferedReader br = new BufferedReader(new InputStreamReader(fsin, StandardCharsets.UTF_8));

String line;

while ((line = br.readLine()) != null) {

// 处理每一行数据

}

```

上面的代码展示了如何读取TextFile格式数据。`TextInputFormat`会自动处理文件分割,而代码块中的循环逐行读取数据。每读取一行,都可以按照应用需求进行处理。

## 2.2 SequenceFile格式解析

### 2.2.1 SequenceFile的基本组成

SequenceFile是一个包含二进制键值对序列的平面文件。它支持记录级别的压缩,并且具备同步标记,能够在读取时快速定位到记录边界。SequenceFile特别适用于Hadoop MapReduce框架进行顺序读写操作,它能够高效地处理大量数据。

SequenceFile主要有两种类型:未压缩的以及块压缩的。未压缩的SequenceFile在写入时使用简单的二进制编码存储数据,而块压缩版本则将数据分块进行压缩。块压缩提供了更高的压缩率,同时也减小了存储空间的需求,但可能会增加解压开销。

### 2.2.2 SequenceFile的数据压缩机制

SequenceFile支持多种压缩编码方式,包括无压缩(NONE)、记录压缩(RECORD)和块压缩(BLOCK)。记录压缩会将单个记录的键值对一起压缩,而块压缩则会对数据进行分块压缩。使用压缩可以减少I/O操作次数和网络传输量,但会增加CPU的使用。

下面是一个创建SequenceFile并使用块压缩的Java代码示例:

```java

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "Write SequenceFile with Block Compression");

SequenceFileOutputFormat.setCompressOutput(job, true);

SequenceFileOutputFormat.setOutputCompressorClass(job, ***press.GzipCodec.class);

SequenceFileOutputFormat.setOutputCompressionType(job, ***pressionType.BLOCK);

FileOutputFormat.setOutputPath(job, new Path(args[1]));

FileSystem fs = FileSystem.get(conf);

Path outPath = new Path(args[1]);

FSDataOutputStream out = fs.create(outPath);

SequenceFile.Writer writer = SequenceFile.createWriter(

conf,

SequenceFile.Writer.file(out),

SequenceFile.Writer.keyClass(LongWritable.class),

SequenceFile.Writer.valueClass(Text.class),

***pression(***pression.BLOCK, new GzipCodec())

);

// 写入数据

writer.append(new LongWritable(1L), new Text("Value1"));

writer.append(new LongWritable(2L), new Text("Value2"));

writer.close();

```

在这段代码中,我们使用了`SequenceFile.Writer`创建了一个SequenceFile,并指定了压缩方式为Gzip的块压缩。之后,通过`append`方法写入了两个键值对,并最终调用`close`方法完成文件的创建。这样的操作可以大幅提升大数据写入时的效率。

## 2.3 AvroFile格式解析

### 2.3.1 AvroFile格式的特点

AvroFile是基于Avro数据序列化框架的文件格式,它是由Hadoop Avro项目提供的。Avro是一种支持丰富的数据结构和数据序列化的框架,特别适合于高效地进行跨语言数据交换。AvroFile格式存储的数据结构为Schema和数据序列的组合,便于系统间的互操作性,而且其序列化和反序列化过程非常迅速。

AvroFile格式支持行和记录两种数据模型。在行模式中,每一行对应一个序列化的Avro对象,这种方式简单直观;在记录模式中,AvroFile将多行数据打包为一个Avro记录块,提供了更好的压缩比和数据管理能力。

### 2.3.2 AvroFile在HDFS中的应用案例

AvroFile格式适用于需要高效跨语言数据交换的场景。例如,在使用Hadoop进行大规模日志分析时,日志可能来自多种不同的应用程序,使用AvroFile格式可以确保结构化数据能够被快速地序列化和反序列化,同时保持数据的完整性和扩展性。

```java

// 使用AvroFile存储日志数据示例代码

public static void writeAvroFile(String[] args) throws IOException {

Schema.Parser parser = new Schema.Parser();

Schema schema = parser.parse("{\n" +

" \"type\": \"record\",\n" +

" \"name\": \"logRecord\",\n" +

" \"fields\": [\n" +

" { \"name\": \"timestamp\", \"type\": \"long\" },\n" +

" { \"name\": \"message\", \"type\": \"string\" }\n" +

" ]\n" +

"}");

DatumWriter<GenericRecord> datumWriter = new SpecificDatumWriter<>(schema);

File avroFile = new File("logData.avro");

DatumWriter<GenericRecord> record = new GenericDatumWriter<>(schema);

DataFileWriter<GenericRecord> dataFileWriter = new DataFileWriter<>(record);

try {

dataFileWriter.create(schema, avroFile);

GenericRecord logRecord = new GenericData.Record(schema);

logRecord.put("timestamp", System.currentTimeMillis());

logRecord.put("message", "Example log message");

dataFileWriter.append(logRecord);

} finally {

dataFileWriter.close();

}

}

```

在这段示例代码中,我们定义了一个日志数据的Avro Schema,并使用该Schema创建了一个`GenericDatumWriter`来写入AvroFile文件。代码块中的`append`方法用于向文件中添加日志记录数据。使用AvroFile可以有效存储结构化的日志数据,同时便于后续的数据处理和分析任务。

以上内容为本章节对传统HDFS数据格式的详尽解析,深入了解TextFile、SequenceFile以及AvroFile的数据结构和特性,以及它们在Hadoop生态系统中的读写原理和应用场景,为进一步理解和掌握HDFS数据格式打下坚实基础。

# 3. HDFS数据压缩技术

## 3.1 常见压缩算法对比

### Gzip压缩

Gzip是一种广泛使用的压缩算法,它基于DEFLATE压缩算法,广泛应用于Unix/Linux系统中。Gzip压缩能够有效减少数据存储空间,提升数据在网络中的传输效率。在Hadoop环境中,使用Gzip压缩可以显著减少存储需求,提高处理速度。

在HDFS中,Gzip压缩通常通过Hadoop的文件系统命令行工具实现,如使用 `hadoop fs -put -compress gzip` 命令将数据以Gzip格式存储。对于Hadoop MapReduce作业,可以在配置文件中设置 `***press=true` 和 `***pression.type=BLOCK` 来指定使用Gzip压缩。

### Bzip2压缩

Bzip2是另一种高压缩比的压缩算法,相比于Gzip,它通常能提供更高的压缩率,但也伴随着更高的计算成本。在HDFS中,Bzip2压缩通常用于对压缩率要求高,且对压缩时间敏感度较低的场景。

要使用Bzip2压缩,可以在Hadoop中执行类似以下命令:

```shell

hadoop fs -put -compress bzip2 file.bz2

```

该命令会将文件以Bzip2格式压缩并存储在HDFS上。需要注意的是,由于Bzip2的压缩和解压缩过程需要消耗更多CPU资源,因此在选择使用Bzip2时,需要权衡压缩和解压缩的性能开销。

### 压缩算法选择的考量

在选择使用哪种压缩算法时,需要考虑数据的特性,如数据大小、数据访问模式、压缩和解压缩速度等因素。对于实时性要求较高的应用场景,可能会倾向于选择压缩速度较快的算法,如Snappy;而对于对存储空间要求较高的场景,则可以考虑使用Gzip或Bzip2等压缩比较高的算法。

## 3.2 压缩数据格式的读写性能

### 压缩与解压缩的效率测试

在HDFS中使用压缩数据格式时,压缩和解压缩的效率直接影响到系统的总体性能。因此,对压缩与解压缩的效率进行测试是评估压缩技术性能的重要环节。可以通过编写基准测试脚本,分别测量压缩算法在不同数据集大小下的压缩速度和压缩比,以及解压缩速度。

### 不同压缩算法的性能分析

不同的压缩算法在不同的数据集上会有不同的表现。例如,Snappy压缩算法在压缩速度上表现优异,适合于对实时性要求较高的场景;而Gzip则在压缩比上表现更好,适合于数据传输带宽有限或者存储成本较高的场景。

性能分析时,可以使用图表展示不同算法在各种指标下的表现,例如:

- 图表1:压缩速度对比

- 图表2:解压缩速度对比

- 图表3:压缩比对比

通过这些对比,能够直观地看到各压缩算法的性能差异,为选择合适的压缩技术提供依据。

## 3.3 压缩策略的选择与优化

### 如何根据数据类型选择压缩格式

选择合适的压缩格式对提高数据处理效率至关重要。数据类型的不同会影响压缩效率和压缩后的效果。例如:

- 对于文本数据,可以优先考虑使用Gzip或Bzip2,它们提供了较高的压缩率。

- 对于二进制数据,可以考虑使用LZ4或Snappy,这些算法在压缩速度上有优势。

具体的压缩格式选择还应结合实际的业务需求,如数据的读写频率、数据处理的速度要求等因素综合考量。

### 压缩策略对存储和计算的影响

压缩策略会直接影响存储空间的使用和数据处理性能。合理配置压缩策略能够平衡存储成本和计算成本。例如,频繁的数据读写操作可能会由于压缩算法的计算开销而导致性能下降,因此在选择压缩格式时需要对业务场景进行充分评估。

为了优化压缩策略,可以设置合适的块大小和压缩块大小,以及选择适当的压缩算法。配置的调整可以通过Hadoop的配置文件(如`core-site.xml` 和 `hdfs-site.xml`)实现,并通过实际数据的处理性能来验证调整效果。

综上所述,压缩技术的选择和应用在HDFS数据处理中起着至关重要的作用。通过对压缩算法的深入理解和性能测试,能够更合理地选择和配置压缩策略,从而提高数据存储效率和数据处理性能。在下一章节中,我们将进一步探索HDFS自定义数据格式的应用与实现,深入理解如何在HDFS中实现更高级和更具针对性的数据压缩与优化策略。

# 4. 自定义数据格式的应用与实现

## 4.1 自定义数据格式的需求分析

### 4.1.1 数据存储的特殊需求

在处理特定类型的数据时,可能会遇到传统数据格式无法满足的需求。例如,结构化日志数据可能需要快速检索特定时间戳或用户ID,而传统的文本格式则难以高效支持这种需求。此外,对于需要频繁更新和查询的高并发应用场景,数据的读写速度、数据压缩率以及对查询的支持等因素都成为必须考虑的重要因素。

自定义数据格式可以在设计之初就考虑到这些特定需求,通过构建符合应用场景的数据模型来优化数据处理的性能。例如,在金融行业中,交易数据格式可能包含有复杂的嵌套结构,同时对于数据的完整性和一致性有极高的要求。这些情况下,传统的数据格式可能无法有效地支持复杂的查询和数据的完整性校验,而自定义数据格式则可以为此设计出更优的解决方案。

### 4.1.2 自定义数据格式的设计原则

设计自定义数据格式时,需要遵循一些基本原则,以确保数据格式的有效性、可扩展性、以及兼容性。以下是一些关键的设计原则:

1. **标准化**:数据格式应遵循某些标准化的设计理念,例如Apache Avro或Protocol Buffers,以便于数据交换和处理工具的开发。

2. **效率优先**:读写操作应尽可能高效,减少资源消耗,提高数据吞吐量。

3. **可扩展性**:格式应设计得能够适应数据结构变化,如添加新字段而不破坏现有数据的读写能力。

4. **压缩兼容性**:自定义格式应支持数据压缩,并且在压缩和解压缩时仍保持高效的数据处理。

5. **序列化和反序列化机制**:需要提供高效的序列化和反序列化机制,以便快速将数据在内存对象与存储格式间转换。

6. **安全性**:在需要的情况下,自定义格式应支持加密、签名等安全特性,保证数据传输和存储的安全。

## 4.2 自定义数据格式的开发流程

### 4.2.1 编写数据序列化和反序列化代码

序列化和反序列化是自定义数据格式的核心。序列化是将对象状态转换为可存储或传输的形式的过程;反序列化则是将这种形式重新转换成对象的过程。在Hadoop生态中,可以使用Avro、Thrift或Protocol Buffers等工具来实现自定义数据的序列化和反序列化。

以Protocol Buffers为例,首先定义数据结构的`.proto`文件,如下所示:

```protobuf

message User {

optional int32 id = 1;

optional string name = 2;

optional string email = 3;

}

```

然后使用Protocol Buffers提供的编译器生成对应编程语言的类文件。以下是一个简单的Java示例代码段,展示如何序列化和反序列化`User`对象:

```java

import com.google.protobuf.InvalidProtocolBufferException;

import com.example.UserProtos.User;

// 构建一个User对象

User user = User.newBuilder()

.setId(1234)

.setName("Alice")

.setEmail("***")

.build();

// 序列化对象

byte[] bytes = user.toByteArray();

// 反序列化对象

try {

User newUser = User.parseFrom(bytes);

} catch (InvalidProtocolBufferException e) {

e.printStackTrace();

}

```

### 4.2.2 在HDFS上实现自定义格式的读写操作

要在HDFS上读写自定义数据格式,通常需要使用Hadoop的API来实现。下面是一个简单的示例,展示了如何在HDFS上使用自定义数据格式进行基本的读写操作:

```java

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

***.URI;

public class CustomFormatHDFSOps {

public static void writeDataToHDFS(String filePath, User data) throws Exception {

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(URI.create(filePath), conf);

Path path = new Path(filePath);

try (org.apache.hadoop.io.SequenceFile.Writer writer = org.apache.hadoop.io.SequenceFile.createWriter(fs, conf, path, User.class, LongWritable.class)) {

writer.append(new LongWritable(System.currentTimeMillis()), data);

}

}

public static User readDataFromHDFS(String filePath) throws Exception {

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(URI.create(filePath), conf);

Path path = new Path(filePath);

User user = null;

try (org.apache.hadoop.io.SequenceFile.Reader reader = new org.apache.hadoop.io.SequenceFile.Reader(fs, path, conf)) {

LongWritable key = new LongWritable();

User value = new User();

while (reader.next(key, value)) {

user = value;

}

}

return user;

}

}

```

## 4.3 自定义数据格式的测试与优化

### 4.3.1 测试自定义格式的稳定性和性能

对自定义数据格式的测试是确保其可靠性和性能的关键。首先需要进行单元测试来确保数据的序列化和反序列化操作的正确性。然后,进行性能测试来评估自定义格式在处理大量数据时的稳定性和效率。

性能测试可以通过模拟真实的工作负载场景来执行,使用如Apache JMeter这样的工具来模拟并发读写操作,监控系统资源的使用情况,如CPU、内存和磁盘I/O。测试结果用于分析自定义格式在不同工作负载下的性能表现,确定性能瓶颈并进行相应的优化。

### 4.3.2 分析性能瓶颈与优化策略

通过性能测试,我们可能会发现一些性能瓶颈,如数据序列化/反序列化速度慢、读写延迟高或内存使用率高等。根据发现的问题,可以采取以下优化策略:

1. **优化数据结构**:简化数据结构,减少数据序列化/反序列化的复杂度,提高效率。

2. **优化数据访问模式**:调整读写模式,比如使用批处理来减少I/O操作次数。

3. **数据缓存**:对频繁访问的数据进行缓存,减少对HDFS的直接访问次数。

4. **硬件升级**:在发现I/O成为瓶颈时,可以考虑升级存储硬件,比如使用SSD替代HDD。

5. **并行处理**:在可能的情况下使用Hadoop的MapReduce等框架进行数据的并行处理。

使用mermaid格式流程图展示自定义数据格式的开发和优化流程:

```mermaid

graph LR

A[开始] --> B[需求分析]

B --> C[设计数据模型]

C --> D[实现序列化和反序列化]

D --> E[编写读写HDFS操作代码]

E --> F[单元测试]

F --> G[性能测试]

G --> H{是否存在性能瓶颈?}

H -- 是 --> I[分析瓶颈]

I --> J[优化策略实施]

J --> K[再次测试]

H -- 否 --> L[自定义数据格式完成]

K --> L

L --> M[结束]

```

通过上述步骤,我们可以确保自定义数据格式在设计、实现和优化方面都是合理的,并且能够满足特定应用场景下的性能和功能需求。

# 5. HDFS数据格式实战案例分析

## 5.1 大数据分析场景下的数据格式应用

### 5.1.1 日志数据处理的格式选择

在大数据分析场景中,日志数据的处理往往需要高效且稳定的数据格式来保证后续处理流程的顺畅进行。一个合适的数据格式可以帮助我们更好地存储和处理这些日志,以备后续的数据分析。TextFile格式由于其易于理解和操作的特点,经常被作为日志数据的处理格式。然而,TextFile格式由于其基于行存储的特性,在大数据量的场景下,读写性能可能不尽如人意。考虑到日志数据量大的特点,文本处理通常采用的Gzip压缩算法,虽然提高了存储效率,但在读取时需要解压缩,这在一定程度上影响了处理速度。

另一方面,针对日志数据的特性,可以采用SequenceFile格式。SequenceFile格式具备良好的压缩比,同时由于其是二进制存储,读写性能优于TextFile。当对数据进行读写操作时,SequenceFile格式不需要额外的格式解析,这大大提高了数据的读写效率。但是,值得注意的是SequenceFile格式的数据压缩机制对CPU资源要求较高,在CPU资源受限的情况下可能会影响到日志处理的整体效率。

### 5.1.2 数据仓库的数据组织方式

数据仓库的构建通常涉及到大量的数据整合、清洗和转换。对于这种场景,AvroFile格式或Parquet格式可能更加适合。AvroFile格式以其高度的压缩率和良好的序列化能力,被广泛用于数据仓库的数据组织。它支持数据的高效读写和良好的压缩特性,尤其适用于需要进行多任务并行处理的场景。例如,在数据仓库中,可以利用AvroFile格式处理数据的增删改查操作,以及数据聚合等复杂的数据处理任务。

Parquet格式是另一种适合数据仓库的数据组织方式,其基于列存储的优势使得在查询时可以只读取需要的列,而不是整个文件,大大提升了查询效率。Parquet格式还支持复杂的嵌套数据结构,这对于处理复杂的数据仓库任务非常有利。然而,Parquet格式在写入数据时需要构建列的元数据信息,这可能会导致较高的写入延迟。

## 5.2 不同HDFS数据格式的对比测试

### 5.2.1 各数据格式的读写性能对比

在进行数据格式的选择时,了解不同格式的读写性能是关键。以下是一个简单的对比测试流程,用以评估TextFile、SequenceFile和AvroFile在读写性能上的差异。

首先,准备一个基准数据集,大小约为10GB,数据类型为日志数据。通过编写测试脚本,我们分别对三种格式进行文件的创建、写入和读取操作。测试中,我们将记录从开始创建文件到文件写入完成的时间,以及从开始读取文件到读取操作完成的时间。

在测试过程中,我们使用以下命令创建SequenceFile格式的数据文件:

```bash

hadoop fs -createSequenceFile /path/to/output_dir

```

读取SequenceFile文件的命令为:

```bash

hadoop fs -text /path/to/sequencefile

```

测试完成后,我们可以看到SequenceFile格式在写入性能上优于TextFile格式,而AvroFile格式在压缩率上更胜一筹。但是,AvroFile格式在进行读操作时,需要解压缩,所以其读操作性能相比SequenceFile略逊一筹。

### 5.2.2 不同工作负载下的格式适应性分析

不同工作负载对数据格式的要求也不尽相同。例如,在处理高频率小文件时,HDFS的NameNode资源消耗可能会变得非常大,因此在这种情况下,选择一个能够良好压缩小文件,且能有效减少NameNode内存消耗的数据格式就显得十分重要。

在进行工作负载适应性测试时,我们可以通过模拟不同的数据处理场景,来观察不同数据格式在各个场景下的表现。测试内容可能包括:大文件的读写测试、小文件的处理测试、数据查询优化测试等。这些测试能够帮助我们理解在不同工作负载下,哪些数据格式能够提供最佳的性能表现。

例如,在高频率小文件的处理场景中,我们可以发现SequenceFile格式由于其二进制存储的特性,能够有效减少NameNode内存消耗,并且读写性能表现稳定。而对于需要高效查询能力的工作负载,Parquet格式的列存储特性则更能够满足需求,因其可以针对特定列进行查询优化,显著提升查询性能。

> 在对不同数据格式进行性能测试和工作负载适应性分析时,还需要考虑集群的硬件配置,如CPU、内存、存储设备的读写速度等因素,因为这些硬件条件也会对数据格式的性能表现造成影响。

# 6. HDFS数据格式的未来发展趋势

随着大数据技术的迅速发展,HDFS数据格式也在不断地演化和优化。本章将探讨新兴的数据格式和HDFS数据格式标准化的进程。

## 6.1 新兴数据格式简介

数据格式的选择对于大数据处理的效率和效果有着深远的影响。在这个章节中,我们将介绍当前最受欢迎的两种新兴数据格式:ORCFile和Parquet,并分析它们的优势。

### 6.1.1 ORCFile与Parquet的优势对比

ORCFile(Optimized Row Columnar File)和Parquet都是列式存储格式,它们针对大数据查询优化,提供了高性能的数据存取和高效的压缩比。

- **ORCFile**

- **高效压缩**:ORCFile采用Zlib和Snappy压缩算法,压缩率高,对CPU的使用更为高效。

- **快速查询**:基于列存储的设计使得在处理分析查询时,只需要读取查询涉及的列,大大减少了I/O负载。

- **事务支持**:提供事务支持,适合于需要ACID属性的场景。

- **Parquet**

- **多语言支持**:其文件格式得到了包括Java、C++、Python在内的多种语言支持,便于跨平台和跨语言使用。

- **压缩多样化**:支持多种压缩算法,包括GZIP、Snappy、LZ4和Zstandard,可根据需要选择最适合的算法。

- **良好的生态系统**:与Hive、Presto、Impala等大数据处理工具的集成度高。

### 6.1.2 新兴数据格式的应用前景

随着数据量的剧增,列式存储格式因为其在数据仓库和大数据分析中的出色性能,正在逐渐成为主流。Parquet和ORCFile因其优秀的压缩比、查询效率、生态兼容性等特点,预计将在未来大数据处理场景中占据更大的市场份额。

## 6.2 HDFS数据格式标准化进程

数据格式的标准化对于跨平台数据交换和存储管理至关重要,本节将探讨标准化的必要性和相关的行业努力。

### 6.2.1 格式标准化的必要性分析

- **降低复杂度**:标准化数据格式可以简化数据处理流程,减少格式转换的复杂度和出错概率。

- **提升互操作性**:统一的数据格式可以提高不同系统间的数据互操作性,有助于构建更加灵活的生态系统。

- **提高数据处理效率**:标准化的数据格式可以更好地利用现代硬件的能力,如利用向量化操作和并行处理提高查询速度。

### 6.2.2 推动数据格式标准化的行业努力

- **开放数据委员会(ODC)**:ODC致力于推动数据格式的标准化,它为各种数据格式的创建和使用提供了指南和最佳实践。

- **Apache项目**:许多Apache项目,如Apache Avro和Apache Parquet,都在积极推动数据格式的标准化。

- **云服务提供商**:云服务提供商通过提供对标准化数据格式的支持,推动了这些格式在企业和研究机构中的采用。

在本章中,我们深入了解了HDFS数据格式的发展趋势,包括新兴数据格式的优势和应用前景,以及格式标准化进程的重要性和行业努力。未来,我们可以预期将有更多高效、标准化的数据格式得到广泛的应用。

0

0