【HDFS数据格式兼容性】:Kafka与Spark集成,流处理与批处理的最佳实践

发布时间: 2024-10-28 10:25:07 阅读量: 27 订阅数: 17

# 1. HDFS数据格式兼容性的概述

## 1.1 数据格式兼容性的基本概念

在大数据处理领域,数据格式兼容性是指系统能够处理多种数据格式,并能够保证数据在不同格式间转换时保持信息的完整性与一致性。随着各种数据源的增多,数据格式变得多样化,如Avro、Parquet、ORC等。Hadoop分布式文件系统(HDFS)作为大数据存储的核心,其数据格式兼容性成为了确保数据处理流程顺畅的关键因素。

## 1.2 HDFS数据格式兼容性的背景

HDFS最初设计是为了存储简单的文本文件,但随着大数据技术的发展,更多复杂的数据处理需求出现,这要求HDFS能够存储和处理结构化和半结构化的数据。Hadoop生态系统中的数据格式从最初的SequenceFile和RCFile发展到了现今的Avro、Parquet等更为先进的列式存储格式。这些格式能够提供更好的压缩率、查询效率和数据处理速度,但同时,它们也对数据的兼容性提出了新的挑战。

## 1.3 HDFS数据格式兼容性的必要性

数据格式兼容性对于数据的存取效率、数据处理速度以及后续的数据分析工作至关重要。良好的兼容性能够确保数据从源头到处理再到存储的整个生命周期中,信息的损失减到最小。对于已经在使用HDFS的公司来说,升级存储格式时能够无缝兼容旧数据,避免重构数据仓库或重复数据录入,节省了大量的时间和成本。此外,良好的兼容性也能够为应用和分析工具提供更广泛的支持,从而使得企业能够更灵活地应对技术的变革。

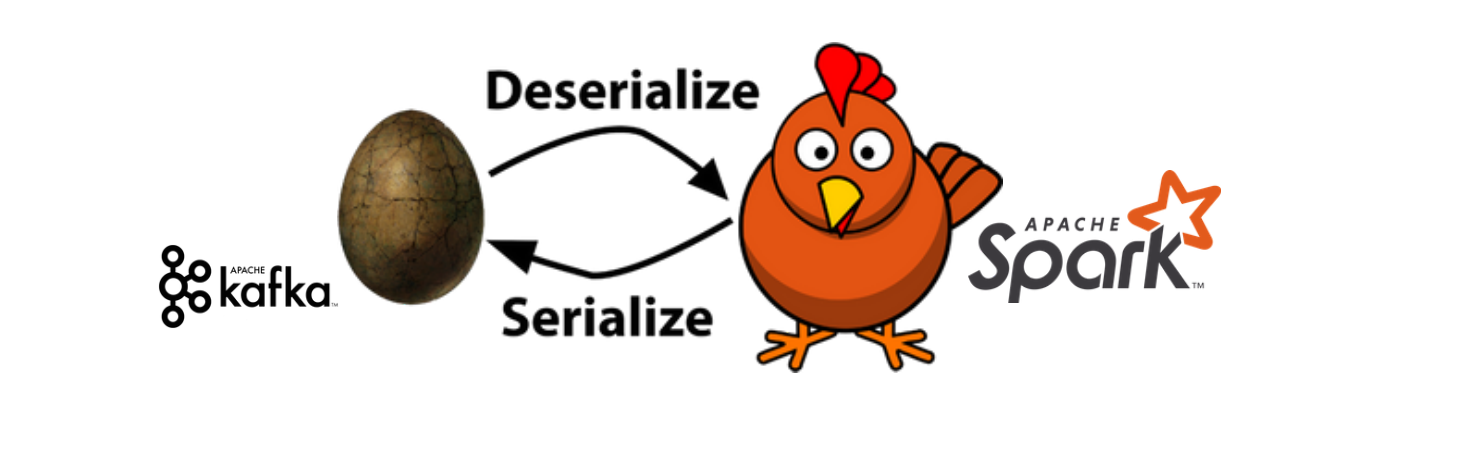

# 2. Kafka与Spark集成的基础

## 2.1 Kafka与Spark的基本概念

### 2.1.1 Kafka的基本原理和架构

Apache Kafka是一种分布式流处理平台,主要用于构建实时数据管道和流应用程序。它能够处理高吞吐量的数据,并具有良好的持久化和复制特性,保证了消息的可靠性。

Kafka的基本原理基于发布/订阅模式,其中生产者(Producer)发布消息到主题(Topic),消费者(Consumer)订阅这些主题并处理消息。主题是消息的分类,可以被多个生产者和消费者同时处理。

Kafka架构主要包含以下几个组件:

- **Broker**:Kafka集群中的节点,负责消息存储和处理客户端请求。

- **Zookeeper**:用于维护集群状态和同步配置信息。

- **Topic**:消息的逻辑容器,生产者向它发布消息,消费者从中订阅消息。

- **Partition**:为了提高可扩展性和吞吐量,一个Topic可以分为多个Partition,分布在不同的Broker上。

- **Leader/Follower**:每个Partition都有一个Leader和多个Follower,用于保证高可用性和负载均衡。

Kafka使用多副本机制保证消息的可靠性。生产者向Partition的Leader发送消息,Follower从Leader同步数据,当Leader宕机后,从Follower中选举新的Leader继续提供服务。

### 2.1.2 Spark的基本原理和架构

Apache Spark是一个大数据处理框架,它提供了快速、通用、可扩展的大数据处理能力。Spark的核心是弹性分布式数据集(RDD),一个不可变的分布式对象集合,能够提供容错处理和内存计算。

Spark架构的核心是Driver Program,它负责创建SparkContext,这是与Spark集群交互的主要入口。集群中的工作节点是Executor,负责执行任务并持有数据。

Spark的架构允许它高效地在内存中进行迭代计算,这使得Spark在某些工作负载上相比其他大数据技术有显著的速度优势。它也支持多种高级功能,如SQL查询、流处理、机器学习和图处理。

Spark支持多种部署模式,包括独立部署、YARN和Mesos等。这使得Spark能够能够轻松地融入现有的大数据生态系统。

## 2.2 Kafka与Spark集成的方式

### 2.2.1 使用Spark Streaming进行集成

Spark Streaming是Spark的一个扩展模块,用于处理实时数据流。它将实时数据流分成小批次并使用Spark Core进行处理,从而实现高吞吐量和容错处理。

集成步骤如下:

1. **环境准备**:确保Kafka和Spark集群已经正确安装配置。

2. **创建Stream**:在Spark中创建一个DStream(离散流),用于接收Kafka消息。

3. **处理数据**:对DStream中的数据进行转换和操作。

4. **输出结果**:将处理后的数据输出到外部系统或进行进一步的存储操作。

一个简单的Spark Streaming集成代码示例如下:

```scala

import org.apache.spark._

import org.apache.spark.streaming._

object KafkaSparkStreaming {

def main(args: Array[String]) {

val conf = new SparkConf().setAppName("KafkaSparkStreaming")

val ssc = new StreamingContext(conf, Seconds(1))

val topics = Set("test")

val kafkaParams = Map[String, String]("metadata.broker.list" -> "localhost:9092")

val messages = KafkaUtils.createDirectStream[String, String, StringDecoder, StringDecoder](

ssc, kafkaParams, topics)

messages.map(_._2).flatMap(_.split(" ")).map((_, 1)).reduceByKey(_ + _).print()

ssc.start()

ssc.awaitTermination()

}

}

```

### 2.2.2 使用Spark SQL进行集成

Spark SQL是Spark用于结构化数据处理的一个模块,提供了DataFrame和DataSet API,它们是Spark SQL的核心抽象。

集成步骤如下:

1. **创建SparkSession**:SparkSession是Spark SQL的入口。

2. **读取Kafka数据**:使用DataFrame API读取Kafka中的数据流。

3. **SQL查询**:对DataFrame执行SQL查询或DataFrame操作。

4. **输出结果**:将结果输出到外部系统。

一个简单的Spark SQL集成代码示例如下:

```scala

import org.apache.spark.sql.SparkSession

import org.apache.spark.sql.functions._

object KafkaSparkSQL {

def main(args: Array[String]) {

val spark = SparkSession.builder().appName("KafkaSparkSQL").getOrCreate()

import spark.implicits._

val df = spark

```

0

0