【大数据处理法】:Hadoop与Spark在数据处理中的应用对比

发布时间: 2025-01-05 12:03:32 阅读量: 10 订阅数: 9

# 摘要

大数据处理是当前信息技术领域的热点话题,它涉及了多种技术概念与处理机制。本文首先介绍了大数据处理的基本概念和技术概述,随后分别深入探讨了Hadoop和Spark的数据处理架构、性能优化和应用实践。通过对比分析Hadoop和Spark的系统架构、编程模型和生态系统,本文揭示了两种技术各自的优劣和适用场景。此外,文章还展望了大数据技术的发展趋势,讨论了未来面临的挑战,并结合案例研究,提供实际应用的见解和启示。本文旨在为大数据技术的实践者和研究者提供一个全面的参考资料,帮助他们更好地理解和应用当前的大数据处理技术。

# 关键字

大数据处理;Hadoop;Spark;性能优化;系统架构;案例研究

参考资源链接:[研究生综合英语1 课后答案和课文翻译](https://wenku.csdn.net/doc/460z27e823?spm=1055.2635.3001.10343)

# 1. 大数据处理的基本概念与技术概述

## 1.1 大数据的定义与发展背景

大数据(Big Data)是描述巨量数据集的术语,这些数据集的体积大到传统数据处理软件难以有效处理。随着互联网的普及和物联网的发展,每天都有海量的数据产生,这推动了大数据技术的进步。

## 1.2 大数据的核心价值

大数据技术的核心在于从大量、多样化的数据中,通过分析挖掘获取有价值的信息。它能够帮助企业优化决策过程,增强竞争力,同时在医疗、金融、零售等多个行业带来了革命性的变化。

## 1.3 大数据处理的关键技术

大数据处理涉及的关键技术包括数据存储、数据处理和数据管理等。其中,存储技术如分布式文件系统是大数据的基础,数据处理如MapReduce是处理大数据的核心算法,而数据管理则关注数据的集成、质量以及安全性。接下来的章节将深入探讨这些关键技术在实际应用中的细节。

# 2. Hadoop的数据处理机制

## 2.1 Hadoop架构原理

### 2.1.1 HDFS存储模型

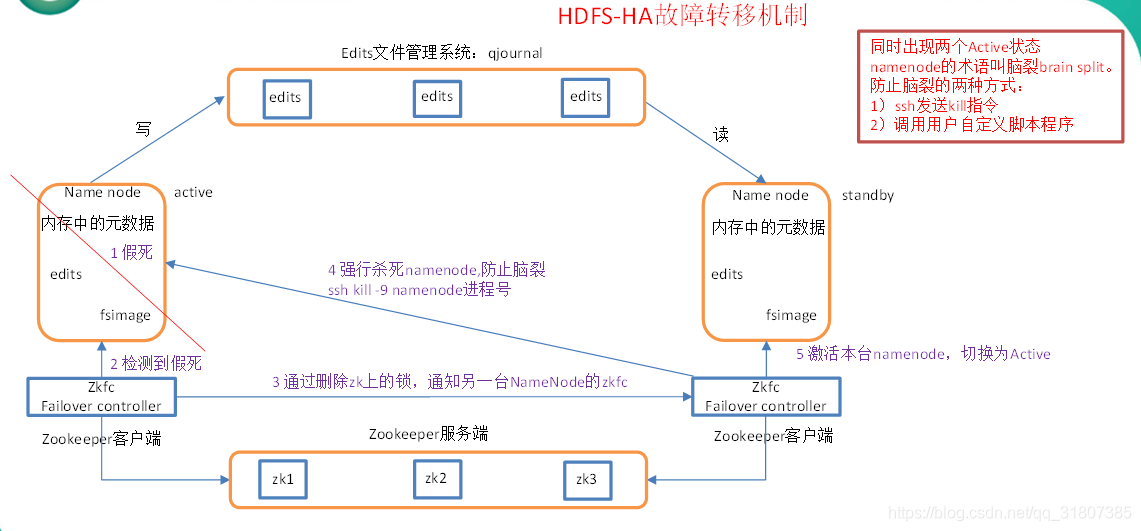

Hadoop分布式文件系统(HDFS)是Hadoop项目的核心组件之一,它被设计为能够跨多个硬件设备存储大量数据,并提供高吞吐量的数据访问能力。HDFS的主要特点包括高容错性、高扩展性以及流式数据访问模式。

HDFS的数据存储模型遵循主从(Master/Slave)架构,分为NameNode(主节点)和DataNode(从节点)两种类型:

- **NameNode**:负责管理文件系统的命名空间,维护整个文件系统的目录树、文件和块信息,以及它们之间的关系。NameNode是整个文件系统的关键,它记录了每个文件中各个块所在的数据节点的位置信息。

- **DataNode**:在集群的每个节点上运行,负责存储实际数据。数据以块(block)的形式存储,每个块默认大小为128MB(可配置),并有副本分布策略,保证了数据的高可靠性。

HDFS提供了一个高度容错性的系统,通过数据副本机制可以保证在部分硬件故障的情况下,数据依然可用。例如,缺省情况下HDFS配置为每个数据块3个副本,其中1个副本存储在同一机架的另一个节点上,另外2个副本存储在不同机架的节点上。

### 2.1.2 MapReduce编程模型

MapReduce是一种编程模型,用于在Hadoop集群上进行大规模数据处理。它的核心思想是将复杂的、大规模的数据集运算问题分解为两个阶段:Map(映射)阶段和Reduce(归约)阶段。

- **Map阶段**:这个阶段主要完成数据的过滤和映射操作,输入数据被分割成固定大小的数据块,然后被分发给多个Map任务。每个Map任务读取输入数据并进行处理,生成键值对(key-value pairs)作为中间输出。

- **Reduce阶段**:Map阶段的中间输出结果会根据键(key)进行分组,然后每组数据被发送给同一个Reduce任务。在Reduce阶段,这些数据会被合并(或者说归约),得到最终的输出结果。

MapReduce编程模型的一个核心优势在于它隐藏了分布式计算的复杂性,开发者无需担心数据的分布、节点间的通信以及容错等问题。用户只需要提供Map和Reduce两个函数的实现,Hadoop框架负责处理其他的细节。

### 代码块示例与逻辑分析

```java

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable>{

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

```

这段代码是一个Map函数的Java实现,它用于统计输入文本中每个单词出现的次数。`TokenizerMapper`类继承自`Mapper`,重写了`map`方法。该方法接收`Object`类型的关键字和`Text`类型的值,将输入文本分割成单词,然后对每个单词输出一个键值对,键是单词,值是数字1。`context.write`方法将这些键值对输出,供后续的Reduce操作使用。

## 2.2 Hadoop的实际数据处理操作

### 2.2.1 Hadoop集群的搭建和配置

搭建Hadoop集群涉及多个步骤,包括安装Java环境、配置网络和主机名、安装和配置Hadoop本身等。以下是搭建Hadoop集群的基本步骤:

1. **安装Java环境**:确保所有集群节点安装了Java环境,因为Hadoop是用Java编写的。可以通过运行`java -version`来检查Java是否已安装。

2. **配置SSH免密登录**:Hadoop需要使用SSH在节点间通信,因此需要配置SSH免密登录,以便NameNode能够无密码SSH到DataNode上。

3. **配置Hadoop环境**:下载Hadoop并解压,然后编辑Hadoop配置文件。主要配置文件有`hadoop-env.sh`、`core-site.xml`、`hdfs-site.xml`、`mapred-site.xml`和`yarn-site.xml`。

4. **格式化HDFS文件系统**:使用`hdfs namenode -format`命令格式化文件系统,这一步是创建HDFS之前必要的操作。

5. **启动Hadoop集群**:可以通过`start-dfs.sh`和`start-yarn.sh`脚本来启动HDFS和YARN(Yet Another Resource Negotiator,Hadoop的资源管理器)。

6. **验证集群状态**:最后使用`jps`命令检查所有节点是否正常运行,包括NameNode、DataNode、ResourceManager、NodeManager等。

### 2.2.2 MapReduce程序设计和案例分析

设计MapReduce程序首先需要确定处理的业务逻辑,然后将其分解为Map和Reduce两个阶段。下面给出一个简单的案例分析,演示如何设计一个MapReduce程序来计算输入数据中单词的频率。

1. **定义Map函数**:Map函数的任务是处理输入文件,并输出中间键值对。在这个案例中,Map函数将每行文本分割成单词,并输出形如`(单词, 1)`的键值对。

2. **定义Reduce函数**:Reduce函数负责对所有具有相同键的中间值进行合并操作,也就是累加操作。在这个案例中,Reduce函数接收到的是一组形如`(单词, [1, 1, ..., 1])`的键值对,然后输出形如`(单词, 总数)`的键值对。

以下是用Java实现的简单MapReduce程序示例:

```java

public class WordCount {

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable>{

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

public static class IntSumReducer

extends Reducer<Text,IntWritable,Text,IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values,

Context context

) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "word count");

job.setJarByClass(WordCount.class);

job.setMapperClass(TokenizerMapper.class);

job.setCombinerClass(IntSumReducer.class);

job.setReducerClass(IntSumReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.addInputPath(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

```

在这个程序中,`TokenizerMapper`类实现了Map函数,而`IntSumReducer`类实现了Reduce函数。`main`方法中配置了作业的各种参数,并提交作业执行。

## 2.3 Hadoop的性能优化与扩展

### 2.3.1 Hadoop性能调优技巧

在Hadoop集群中运行MapReduce作业时,性能优化至关重要。以下是一些常见的性能调优技巧:

- **调整Map和Reduce任务的并发数**:增加Map和Reduce任务的并发数可以加快数据处理速度,但是过多的任务并行运行可能会导致集群资源竞争激烈,影响性能。

- **合理配置内存和CPU资源**:调整YARN的`yarn.nodemanager.resource.memory-mb`和`yarn.nodemanager.resource.vcores`参数可以合理分配每个节点的内存和CPU资源。

- **优化数据本地性**:数据本地性指的是MapReduce作业的任务在处理存储数据的节点上运行。通过HDFS的数据副本策略和YARN的调度策略,可以提高数据本地性,减少网络I/O开销。

- **合理配置HDFS的副本策略**:减少HDFS的副本数可以减少磁盘I/O和网络传输开销,但是可能会影响数据的可靠性。需要根据实际业务的容错需求来调整副本数。

- **监控和日志分析**:通过Hadoop自带的监控工具如Ambari或Ganglia,或者使用

0

0