MATLAB与Python的跨语言自然语言处理:实现跨语言文本分析与处理

发布时间: 2024-06-10 09:17:42 阅读量: 99 订阅数: 41

用Python进行自然语言处理

# 1. 跨语言自然语言处理概述

自然语言处理(NLP)是一门计算机科学领域,它使计算机能够理解、解释和生成人类语言。跨语言NLP扩展了NLP的范围,使其能够处理多种语言,从而克服语言障碍并促进全球交流。

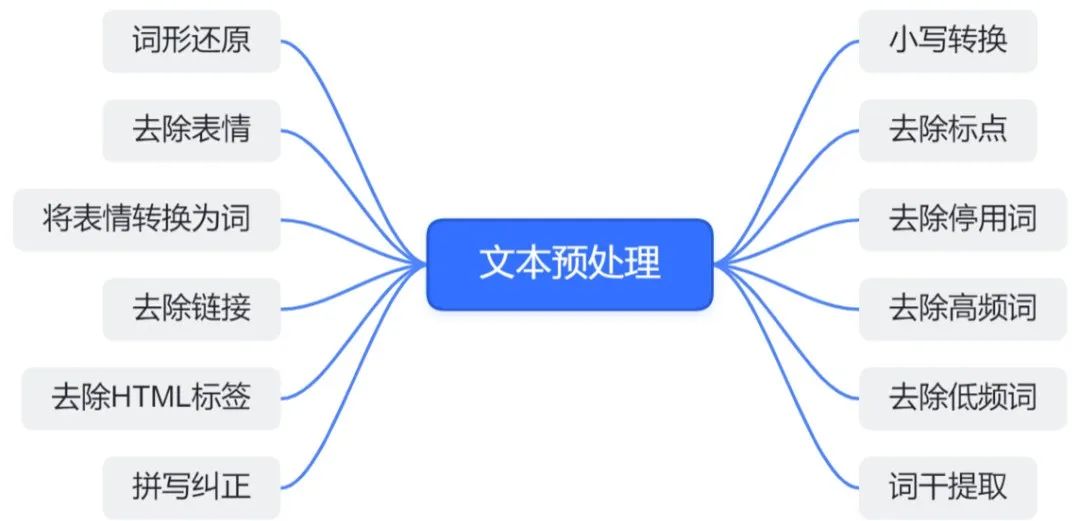

跨语言NLP涉及将NLP技术应用于多种语言,包括文本预处理、特征提取、文本分类和聚类。通过利用跨语言NLP,计算机可以分析和理解来自不同语言的文本,从而为各种应用程序提供支持,例如机器翻译、情感分析和跨语言信息检索。

# 2. MATLAB与Python自然语言处理库对比

### 2.1 MATLAB自然语言处理工具箱

MATLAB自然语言处理工具箱(NLP Toolbox)是一个专门用于自然语言处理任务的工具箱。它提供了广泛的功能,包括文本预处理、特征提取、文本分类和聚类。

#### 2.1.1 文本预处理和特征提取

NLP Toolbox提供了多种文本预处理和特征提取功能,包括:

- **文本标记化:**将文本分解为单词或词组。

- **停用词去除:**删除常见词,例如“the”、“and”、“of”。

- **词干化和词形还原:**将单词还原为其基本形式,例如“running”还原为“run”。

- **词频统计:**计算每个单词在文本中出现的次数。

这些功能可以帮助准备文本数据进行后续处理。

#### 2.1.2 文本分类和聚类

NLP Toolbox还提供了文本分类和聚类算法,包括:

- **朴素贝叶斯分类:**一种基于贝叶斯定理的分类算法,用于预测文本属于特定类别的概率。

- **K均值聚类:**一种将文本聚类为相似组的算法。

这些算法可以用于对文本进行分类和分组,例如将新闻文章分类为不同的主题或将客户评论聚类为不同的情感。

### 2.2 Python自然语言处理库

Python拥有丰富的自然语言处理库,包括NLTK和spaCy。

#### 2.2.1 NLTK库

NLTK(Natural Language Toolkit)是一个广泛使用的Python自然语言处理库。它提供了广泛的功能,包括:

- **文本预处理:**标记化、停用词去除、词干化和词形还原。

- **特征提取:**词频统计、词共现和语言模型。

- **文本分类和聚类:**朴素贝叶斯分类、支持向量机和K均值聚类。

NLTK以其灵活性、易用性和广泛的文档而闻名。

#### 2.2.2 spaCy库

spaCy是一个较新的Python自然语言处理库,它以其速度和准确性而闻名。它提供了以下功能:

- **文本预处理:**标记化、句法分析和依存关系解析。

- **特征提取:**词向量和语言模型。

- **文本分类和聚类:**基于规则的分类和聚类。

spaCy特别适合处理大文本数据集,并且它还提供了一个直观的API,用于构建自定义自然语言处理管道。

**表格:MATLAB与Python自然语言处理库对比**

| 特征 | MATLAB NLP Toolbox | NLTK | spaCy |

|---|---|---|---|

| 文本预处理 | 是 | 是 | 是 |

| 特征提取 | 是 | 是 | 是 |

| 文本分类 | 是 | 是 | 是 |

| 聚类 | 是 | 是 | 是 |

| 速度 | 中等 | 中等 | 快 |

| 易用性 | 中等 | 容易 | 容易 |

| 文档 | 良好 | 良好 | 良好 |

**代码块:使用NLTK进行文本分类**

```python

import nltk

from nltk.corpus import stopwords

from nltk.tokenize import word_tokenize

from nltk.classify import NaiveBayesClassifier

# 加载停用词表

stop_words = set(stopwords.words('english'))

# 对文本进行预处理

def preprocess_text(text):

tokens = word_tokenize(text)

filtered_tokens = [token for token in tokens if token not in stop_words]

return filtered_tokens

# 训练朴素贝叶斯分类器

def train_classifier(training_data):

feature_sets = [(preprocess_text(text), label) for (text, label) in training_data]

classifier = NaiveBayesClassifier.train(feature_sets)

return classifier

# 对新文本进行分类

def classify

```

0

0