完善Python爬虫的日志记录与调试技巧

发布时间: 2024-04-16 10:32:27 阅读量: 153 订阅数: 43

python爬虫教程.zip

# 1. 日志记录在Python爬虫中的重要性与应用

日志记录在Python爬虫中扮演着至关重要的角色,它不仅可以帮助我们快速定位问题,提高代码的可维护性,还能方便我们追踪程序运行过程中的各种操作情况。在Python爬虫中添加日志记录功能可以通过使用Python内置的logging模块来实现,同时可以设置不同的日志级别和格式。通过适当配置日志记录的级别和格式,可以清晰明了地记录爬虫运行过程中的关键信息,以便后续排查问题或进行代码优化。因此,在编写Python爬虫时,充分利用日志记录功能是一个非常值得推荐的做法。

# 2. Python爬虫中常见的调试技巧

2.1 使用断点调试器进行代码调试

在爬虫开发过程中,经常会遇到程序运行出错的情况。这时,使用断点调试器是一种行之有效的方法。

### 2.1.1 在代码中插入断点

在Python中,可以通过在代码的某一行位置插入断点的方式,来逐行调试程序。这样可以查看程序运行到哪一步出现了问题。

```python

import pdb

def divide(a, b):

pdb.set_trace() # 在这一行设置断点

return a / b

result = divide(10, 2)

print(result)

```

### 2.1.2 使用pdb调试器进行交互式调试

通过在终端中运行Python脚本并调用pdb模块,我们可以进入交互式调试模式,逐步查看变量值、执行代码,并定位错误。

```python

import pdb

def add(a, b):

pdb.set_trace()

print("Adding numbers...")

return a + b

result = add(3, '5')

print(result)

```

2.2 利用try-except语句处理异常

异常处理在爬虫开发中非常重要,可以避免程序意外终止并提供更好的错误定位。

### 2.2.1 抛出和捕获异常

通过try和except语句,我们可以捕获异常并进行相应的处理,防止程序崩溃。

```python

try:

result = 10 / 0

except ZeroDivisionError as e:

print("Error:", e)

```

### 2.2.2 分析异常信息定位问题

当程序出现异常时,异常信息会帮助我们定位问题所在。通过打印异常信息,可以更好地理解出错的原因。

```python

try:

result = 10 / 0

except ZeroDivisionError as e:

print("Error:", e)

```

### 2.2.3 处理特定异常类型

在except语句中指定具体的异常类型,可以针对不同的异常做出不同的处理。

```python

try:

result = 10 / '0'

except ZeroDivisionError:

print("ZeroDivisionError occurred")

except TypeError:

print("TypeError occurred")

```

以上是Python爬虫中常见的调试技巧,通过断点调试器和异常处理,我们可以更高效地编写和调试爬虫代码,提高程序的健壮性和稳定性。

# 3. 优化Python爬虫的日志记录

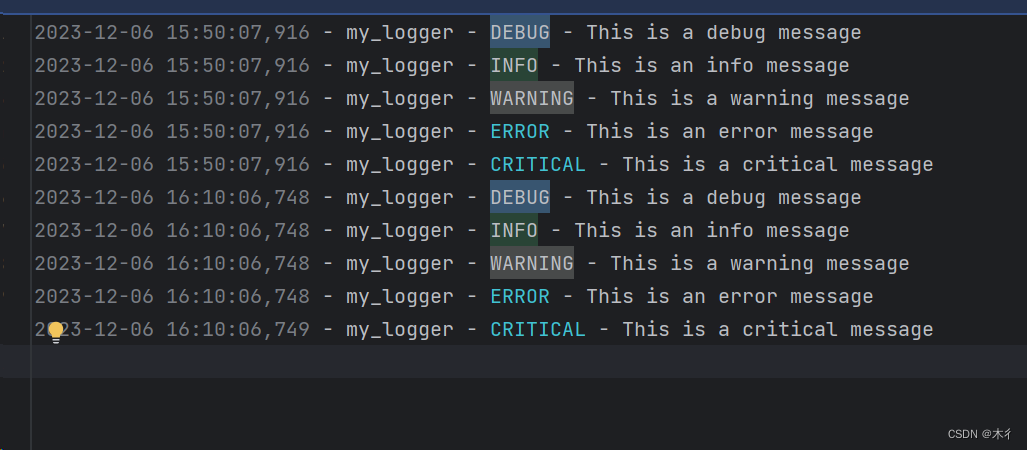

### 3.1 设定适当的日志级别

在Python爬虫中,设定合适的日志级别对于记录和跟踪程序运行状态至关重要。选择适当的级别可以帮助我们更好地理解代码的执行过程,及时发现潜在问题,并进行改进。常见的日志级别包括:

| 日志级别 | 描述 |

| ------------ | ------------------------------------------------------------ |

| DEBUG | 最详细的日志信息,通常只在诊断问题时使用 |

| INFO | 消息在确认事情按预期工作时记录 |

| WARNING | 表明发生了某些意外事件,但程序仍然按预期进行 |

| ERROR | 由于更严重的问题,程序未能执行某项功能 |

| CRITICAL | 指出发生了严重的错误,导致程序不能继续运行 |

### 3.2 添加时间戳和线程信息

为了更好地跟踪日志记录,并能够清晰地了解各个操作的发生顺序以及不同线程的执行情况,我们可以在日志中添加时间戳和线程信息:

```python

import logging

import threading

logging.basicConfig(format='%(asctime)s - %(threadName)s - %(levelname)s - %(message)s')

def crawler_function():

logging.info("Crawling started")

if __name__ == "__main__":

logging.info("Main program started")

thread = threading.Thread(target=crawler_function, name='CrawlerThread')

thread.start()

```

### 3.3 配置日志保存方式和位置

将日志信息输出到文件可以帮助我们更好地跟踪程序运行状态,而且能够保留历史日志记录。同时,我们可以设置日志的滚动和归档,以便管理日志文件的大小和数量:

```python

import logging

from logging.handlers import RotatingFileHandler

logger = logging.getLogger('crawler_logger')

logger.setLevel(logging.INFO)

handler = RotatingFileHandler('crawler.log', maxBytes=10000, backupCount=3)

formatter = logging.Formatter('%(asctime)s - %(levelname)s - %(message)s')

handler.setFormatter(formatter)

logger.addHandler(handler)

def crawler_function():

logger.info("Crawling started")

if __name__ == "__main__":

logger.info("Main program started")

crawler_function()

```

### 结语

优化日志记录和配置调试信息对于Python爬虫的效率和健壮性至关重要。适当设定日志级别、添加时间戳和线程信息以及配置日志保存方式都有助于更好地监控程序运行状态和定位问题所在。通过持续优化日志记录和调试技巧,我们可以不断提高爬虫代码的质量和效率。

# 4. 进阶调试技巧提升Python爬虫效率

在Python爬虫开发过程中,除了使用基本的调试技巧外,我们还可以采用一些进阶调试方法来提升代码的效率和健壮性。本章将介绍更高级的调试技巧,帮助开发者更好地优化爬虫程序。

### 4.1 使用IDE的调试工具

现代集成开发环境(IDE)提供了强大的调试功能,可以帮助开发者更高效地调试Python爬虫代码。

1. **利用IDE提供的调试功能:** 大多数IDE都提供了调试功能,可以设置断点、单步调试等。

2. **设置断点并监控变量:** 在代码中设置断点,可以实时监控变量的取值,帮助定位问题所在。

```python

# 示例代码:在IDE中设置断点监控变量

def crawl_website(url):

response = requests.get(url)

html = response.text

# 设置断点监控变量

import pdb; pdb.set_trace()

parse_html(html)

```

### 4.2 分析爬虫运行日志

通过分析爬虫的运行日志,可以更全面地了解程序执行过程,找出潜在问题并进行代码优化。

1. **统计运行日志数据:** 收集爬虫程序的日志信息,包括请求耗时、响应状态等,有助于分析程序运行情况。

2. **发现潜在问题并优化代码:** 通过分析日志数据,找出代码中可能存在的问题,并采取相应措施进行优化。

### 4.3 利用第三方工具辅助调试

第三方工具能够帮助开发者更深入地分析Python爬虫程序,在特定场景下提供更全面的调试支持。

1. **使用Wireshark进行网络数据分析:** Wireshark是一款网络数据包分析工具,可以帮助爬虫开发者监控网络请求及响应数据,发现潜在的网络问题。

2. **利用Chrome开发者工具进行页面解析:** Chrome浏览器提供了强大的开发者工具,包括页面元素查看、网络请求分析等功能,有利于分析页面结构,优化爬虫解析过程。

```mermaid

graph TD;

A[发起网络请求] --> B{收到响应数据};

B -- 解析页面结构 --> C{提取所需信息};

C -- 保存数据 --> D[存储数据]

```

通过上述高级调试技巧,开发者可以更快地定位和解决Python爬虫程序中的问题,提高代码的效率和可维护性,从而更好地完成数据采集任务。

# 5. 结语

在本文中,我们深入讨论了日志记录和调试在 Python 爬虫开发中的重要性以及各种应用技巧。通过合理利用日志记录技术和调试工具,可以提高爬虫代码的可维护性、健壮性和效率。在本章中,我们将总结一些关键点,并提出一些建议,帮助读者更好地应用所学知识。

### 5.1 总结要点

在文章中,我们详细阐述了以下内容:

1. 日志记录的作用:帮助定位问题、提高代码可维护性。

2. Python 爬虫中添加日志记录功能的方法:使用 logging 模块、设置日志级别和格式。

3. Python 爬虫中常见的调试技巧:使用断点调试器、try-except 处理异常、利用 print 输出调试信息。

4. 优化 Python 爬虫日志记录的手段:设定适当的日志级别、添加时间戳和线程信息、配置日志保存方式和位置。

5. 进阶调试技巧:使用 IDE 的调试工具、分析爬虫运行日志、利用第三方工具辅助调试。

### 5.2 建议与展望

针对 Python 爬虫开发中的日志记录和调试,我们提出以下建议:

- 持续学习和尝试新的技术和工具,不断提升调试技能;

- 定期回顾和优化爬虫代码,避免出现潜在的问题;

- 加强日志记录的分析和利用,进一步优化爬虫效率。

通过不断优化日志记录和调试技巧,我们可以提高 Python 爬虫代码的质量和效率,更好地实现数据获取和分析的目标。

### 5.3 流程图示例

下面是一个示例的流程图,展示了在 Python 爬虫中添加日志记录功能的流程:

```mermaid

graph TD

A(开始) --> B(导入logging模块)

B --> C(配置日志记录格式)

C --> D(设置日志级别)

D --> E(在代码中添加日志记录)

E --> F(结束)

```

### 5.4 结语

通过本文的学习,相信读者对于日志记录和调试在 Python 爬虫开发中的重要性有了更深入的了解。不断优化日志记录和调试技巧,可以提高爬虫代码的质量和效率,让我们的爬虫开发工作更加顺利和高效。

继续保持对技术的热情,不断学习和实践,相信在爬虫开发的道路上会迎来更多的成功与挑战。祝愿大家在 Python 爬虫开发中取得更好的成就,谢谢阅读!

0

0