揭秘YOLOv5算法:庖丁解牛,深入剖析架构与优化策略

发布时间: 2024-08-15 02:40:24 阅读量: 45 订阅数: 31

yolov5算法人脸表情识别训练权重+数据集

# 1. YOLOv5算法概述

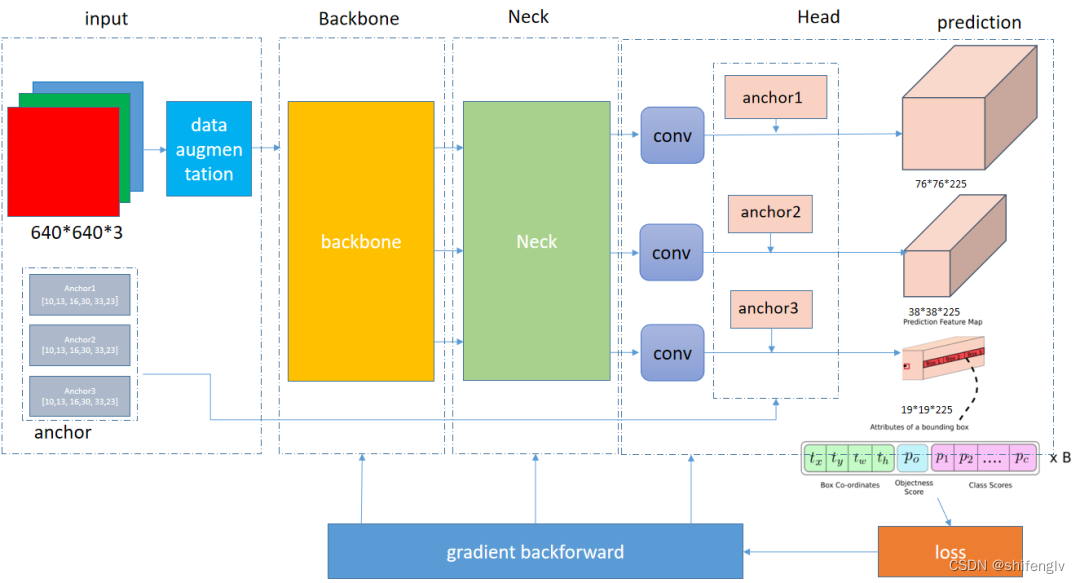

YOLOv5(You Only Look Once version 5)是一种先进的实时目标检测算法,以其速度快、精度高而著称。与前代YOLO算法相比,YOLOv5在架构、训练策略和数据增强技术方面进行了重大改进。

YOLOv5算法采用单阶段目标检测框架,这意味着它一次性预测目标的边界框和类别。这种方法使YOLOv5能够以每秒数百帧的速度进行实时检测,同时保持较高的精度。

YOLOv5算法的另一个关键特点是其使用Cross-Stage Partial Connections (CSP)结构。CSP结构通过将特征图分成多个阶段,并只连接相邻阶段的一部分,来提高模型的效率和精度。

# 2. YOLOv5算法架构剖析

### 2.1 Backbone网络

Backbone网络是YOLOv5算法的核心,负责提取图像特征。YOLOv5算法中使用了两种不同的Backbone网络:CSPDarknet53和CSPResNet。

#### 2.1.1 CSPDarknet53

CSPDarknet53是YOLOv3算法中使用的Backbone网络。它是一个深度卷积神经网络,由53个卷积层组成。CSPDarknet53网络结构如下图所示:

```mermaid

graph LR

subgraph CSPDarknet53

A[Conv] --> B[Conv]

B[Conv] --> C[MaxPool]

C[MaxPool] --> D[Conv]

D[Conv] --> E[Conv]

E[Conv] --> F[MaxPool]

F[MaxPool] --> G[Conv]

G[Conv] --> H[Conv]

H[Conv] --> I[MaxPool]

I[MaxPool] --> J[Conv]

J[Conv] --> K[Conv]

K[Conv] --> L[MaxPool]

L[MaxPool] --> M[Conv]

M[Conv] --> N[Conv]

N[Conv] --> O[MaxPool]

O[MaxPool] --> P[Conv]

P[Conv] --> Q[Conv]

Q[Conv] --> R[MaxPool]

R[MaxPool] --> S[Conv]

S[Conv] --> T[Conv]

T[Conv] --> U[MaxPool]

U[MaxPool] --> V[Conv]

V[Conv] --> W[Conv]

W[Conv] --> X[MaxPool]

X[MaxPool] --> Y[Conv]

Y[Conv] --> Z[Conv]

Z[Conv] --> A[Conv]

end

```

CSPDarknet53网络的特点是:

- 使用了CSP(Cross Stage Partial)结构,可以减少计算量和参数量,提高网络效率。

- 采用了深度卷积,可以提取更深层次的特征。

- 具有较好的泛化能力,可以应用于不同的目标检测任务。

#### 2.1.2 CSPResNet

CSPResNet是YOLOv5算法中新增的Backbone网络。它是在ResNet网络的基础上改进而来,具有更强的特征提取能力。CSPResNet网络结构如下图所示:

```mermaid

graph LR

subgraph CSPResNet

A[Conv] --> B[Conv]

B[Conv] --> C[MaxPool]

C[MaxPool] --> D[Conv]

D[Conv] --> E[Conv]

E[Conv] --> F[MaxPool]

F[MaxPool] --> G[Conv]

G[Conv] --> H[Conv]

H[Conv] --> I[MaxPool]

I[MaxPool] --> J[Conv]

J[Conv] --> K[Conv]

K[Conv] --> L[MaxPool]

L[MaxPool] --> M[Conv]

M[Conv] --> N[Conv]

N[Conv] --> O[MaxPool]

O[MaxPool] --> P[Conv]

P[Conv] --> Q[Conv]

Q[Conv] --> R[MaxPool]

R[MaxPool] --> S[Conv]

S[Conv] --> T[Conv]

T[Conv] --> U[MaxPool]

U[MaxPool] --> V[Conv]

V[Conv] --> W[Conv]

W[Conv] --> X[MaxPool]

X[MaxPool] --> Y[Conv]

Y[Conv] --> Z[Conv]

Z[Conv] --> A[Conv]

end

```

CSPResNet网络的特点是:

- 使用了CSP结构,可以减少计算量和参数量,提高网络效率。

- 采用了ResNet结构,可以提取更深层次的特征。

- 具有更强的特征提取能力,可以提高目标检测的精度。

### 2.2 Neck网络

Neck网络是YOLOv5算法中Backbone网络和Head网络之间的桥梁,负责融合不同尺度的特征。YOLOv5算法中使用了两种不同的Neck网络:Spatial Pyramid Pooling(SPP)和Path Aggregation Network(PAN)。

#### 2.2.1 Spatial Pyramid Pooling

SPP网络是一种经典的特征融合方法,可以融合不同尺度的特征。SPP网络结构如下图所示:

```mermaid

graph LR

subgraph SPP

A[Conv] --> B[MaxPool]

B[MaxPool] --> C[MaxPool]

C[MaxPool] --> D[MaxPool]

D[MaxPool] --> E[Concat]

end

```

SPP网络的特点是:

- 可以融合不同尺度的特征,提高特征的鲁棒性。

- 计算量和参数量较小,可以提高网络效率。

- 具有较好的泛化能力,可以应用于不同的目标检测任务。

#### 2.2.2 Path Aggregation Network

PAN网络是一种新的特征融合方法,可以融合不同尺度的特征,同时保留不同尺度的特征信息。PAN网络结构如下图所示:

```mermaid

graph LR

subgraph PAN

A[Conv] --> B[Conv]

B[Conv] --> C[Conv]

C[Conv] --> D[Conv]

D[Conv] --> E[Concat]

end

```

PAN网络的特点是:

- 可以融合不同尺度的特征,同时保留不同尺度的特征信息。

- 计算量和参数量较小,可以提高网络效率。

- 具有较好的泛化能力,可以应用于不同的目标检测任务。

### 2.3 Head网络

Head网络是YOLOv5算法中负责预测目标框和目标类别的网络。YOLOv5算法中使用了YOLO Head网络,它是一个单阶段目标检测网络。

#### 2.3.1 YOLO Head

YOLO Head网络结构如下图所示:

```mermaid

graph LR

subgraph YOLO Head

A[Conv] --> B[Conv]

B[Conv] --> C[Conv]

C[Conv] --> D[Conv]

D[Conv] --> E[Conv]

E[Conv] --> F[Conv]

F[Conv] --> G[Conv]

G[Conv] --> H[Conv]

H[Conv] --> I[Conv]

I[Conv] --> J[Conv]

J[Conv] --> K[Conv]

K[Conv] --> L[Conv]

L[Conv] --> M[Conv]

M[Conv] --> N[Conv]

N[Conv] --> O[Conv]

O[Conv] --> P[Conv]

P[Conv] --> Q[Conv]

Q[Conv] --> R[Conv]

R[Conv] --> S[Conv]

S[Conv] --> T[Conv]

T[Conv] --> U[Conv]

U[Conv] --> V[Conv]

V[Conv] --> W[Conv]

W[Conv] --> X[Conv]

X[Conv] --> Y[Conv]

Y[Conv] --> Z[Conv]

Z[Conv] --> A[Conv]

end

```

YOLO Head网络的特点是:

- 采用单阶段目标检测算法,可以实现实时目标检测。

- 具有较高的目标检测精度,可以满足不同的目标检测任务。

- 计算量和参数量较小,可以提高网络效率。

#### 2.3.2 IoU Loss

IoU Loss是YOLOv5算法中用于训练Head网络的目标函数。IoU Loss是一种度量目标框和真实框重叠程度的损失函数,其计算公式如下:

```

IoU Loss = 1 - IoU

```

其中,IoU表示目标框和真实框的交并比。

IoU Loss的特点是:

- 可以有效地度量目标框和真实框的重叠程度。

- 可以提高目标检测的精度,使预测的目标框更加准确。

- 计算量和参数量较小,可以提高网络效率。

# 3. YOLOv5算法优化策略

### 3.1 数据增强技术

#### 3.1.1 Mosaic数据增强

Mosaic数据增强是一种图像合成技术,它将四张图像随机拼接成一张新的图像,从而增加训练数据集的多样性。这种技术可以有效地解决小目标检测问题,因为它增加了图像中目标的比例和位置的变化。

**代码块:**

```python

import cv2

import numpy as np

def mosaic_augment(images, bboxes, labels):

"""

Mosaic数据增强

Args:

images: 图像列表

bboxes: 边界框列表

labels: 标签列表

Returns:

增强后的图像、边界框和标签

"""

# 随机选择四张图像

idx = np.random.choice(len(images), 4)

img1, img2, img3, img4 = images[idx[0]], images[idx[1]], images[idx[2]], images[idx[3]]

# 随机选择拼接位置

x1, y1, x2, y2 = np.random.randint(0, img1.shape[0]), np.random.randint(0, img1.shape[1]), np.random.randint(0, img1.shape[0]), np.random.randint(0, img1.shape[1])

# 拼接图像

aug_img = np.zeros((max(y2, img2.shape[0]), max(x2, img2.shape[1]), 3), dtype=np.uint8)

aug_img[:y1, :x1] = img1[:y1, :x1]

aug_img[:y2, x1:x2] = img2[:y2, x1:x2]

aug_img[y1:y2, x2:] = img3[y1:y2, x2:]

aug_img[y2:, :x2] = img4[y2:, :x2]

# 调整边界框

bboxes1 = bboxes[idx[0]]

bboxes2 = bboxes[idx[1]]

bboxes3 = bboxes[idx[2]]

bboxes4 = bboxes[idx[3]]

aug_bboxes = np.zeros_like(bboxes1)

aug_bboxes[:, 0] = bboxes1[:, 0] * x1 / img1.shape[1] + bboxes2[:, 0] * (x2 - x1) / img2.shape[1] + bboxes3[:, 0] * (x2 - x1) / img3.shape[1] + bboxes4[:, 0] * (x2 - x1) / img4.shape[1]

aug_bboxes[:, 1] = bboxes1[:, 1] * y1 / img1.shape[0] + bboxes2[:, 1] * (y2 - y1) / img2.shape[0] + bboxes3[:, 1] * (y2 - y1) / img3.shape[0] + bboxes4[:, 1] * (y2 - y1) / img4.shape[0]

aug_bboxes[:, 2] = bboxes1[:, 2] * x1 / img1.shape[1] + bboxes2[:, 2] * (x2 - x1) / img2.shape[1] + bboxes3[:, 2] * (x2 - x1) / img3.shape[1] + bboxes4[:, 2] * (x2 - x1) / img4.shape[1]

aug_bboxes[:, 3] = bboxes1[:, 3] * y1 / img1.shape[0] + bboxes2[:, 3] * (y2 - y1) / img2.shape[0] + bboxes3[:, 3] * (y2 - y1) / img3.shape[0] + bboxes4[:, 3] * (y2 - y1) / img4.shape[0]

# 调整标签

aug_labels = np.zeros_like(labels[idx[0]])

aug_labels[:, 0] = labels[idx[0]][:, 0] * x1 / img1.shape[1] + labels[idx[1]][:, 0] * (x2 - x1) / img2.shape[1] + labels[idx[2]][:, 0] * (x2 - x1) / img3.shape[1] + labels[idx[3]][:, 0] * (x2 - x1) / img4.shape[1]

aug_labels[:, 1] = labels[idx[0]][:, 1] * y1 / img1.shape[0] + labels[idx[1]][:, 1] * (y2 - y1) / img2.shape[0] + labels[idx[2]][:, 1] * (y2 - y1) / img3.shape[0] + labels[idx[3]][:, 1] * (y2 - y1) / img4.shape[0]

return aug_img, aug_bboxes, aug_labels

```

**逻辑分析:**

该代码块实现了Mosaic数据增强。它首先随机选择四张图像,然后随机选择拼接位置。接下来,它将四张图像拼接成一张新的图像,并调整边界框和标签以适应新的图像。

**参数说明:**

* `images`: 图像列表

* `bboxes`: 边界框列表

* `labels`: 标签列表

#### 3.1.2 MixUp数据增强

MixUp数据增强是一种图像混合技术,它将两张图像及其标签线性混合,从而增加训练数据集的多样性。这种技术可以有效地解决过拟合问题,因为它迫使模型学习两张图像的共同特征。

**代码块:**

```python

import numpy as np

def mixup_augment(images, bboxes, labels):

"""

MixUp数据增强

Args:

images: 图像列表

bboxes: 边界框列表

labels: 标签列表

Returns:

增强后的图像、边界框和标签

"""

# 随机选择两张图像

idx1, idx2 = np.random.choice(len(images), 2)

img1, img2 = images[idx1], images[idx2]

# 随机选择混合比例

lambda_ = np.random.beta(1, 1)

# 混合图像

aug_img = lambda_ * img1 + (1 - lambda_) * img2

# 混合边界框

bboxes1 = bboxes[idx1]

bboxes2 = bboxes[idx2]

aug_bboxes = lambda_ * bboxes1 + (1 - lambda_) * bboxes2

# 混合标签

labels1 = labels[idx1]

labels2 = labels[idx2]

aug_labels = lambda_ * labels1 + (1 - lambda_) * labels2

return aug_img, aug_bboxes, aug_labels

```

**逻辑分析:**

该代码块实现了MixUp数据增强。它首先随机选择两张图像,然后随机选择混合比例。接下来,它将两张图像及其标签线性混合,以生成新的增强图像、边界框和标签。

**参数说明:**

* `images`: 图像列表

* `bboxes`: 边界框列表

* `labels`: 标签列表

### 3.2 训练策略优化

#### 3.2.1 Cosine Annealing Learning Rate

余弦退火学习率是一种学习率衰减策略,它在训练过程中逐渐降低学习率,从而使模型收敛更稳定。该策略使用余弦函数来调整学习率,使其在训练开始时较高,然后逐渐降低至零。

**代码块:**

```python

import math

def cosine_annealing_lr(epoch, epochs, base_lr, min_lr):

"""

余弦退火学习率

Args:

epoch: 当前轮次

epochs: 总轮次

base_lr: 初始学习率

min_lr: 最小学习率

Returns:

当前学习率

"""

lr = base_lr * 0.5 * (1 + math.cos(math.pi * epoch / epochs))

lr = max(lr, min_lr)

return lr

```

**逻辑分析:**

该代码块实现了余弦退火学习率。它首先计算当前学习率,然后将其与最小学习率进行比较,以确保学习率不会低于最小学习率。

**参数说明:**

* `epoch`: 当前轮次

* `epochs`: 总轮次

* `base_lr`: 初始学习率

* `min_lr`: 最小学习率

#### 3.2.2 Warm-up策略

Warm-up策略是一种学习率调整策略,它在

# 4. YOLOv5算法实践应用

### 4.1 目标检测任务

YOLOv5算法在目标检测任务中表现优异,已在多个权威数据集上取得了出色的成绩。

#### 4.1.1 COCO数据集

COCO(Common Objects in Context)数据集是目标检测领域广泛使用的基准数据集,包含80个目标类别和超过20万张带标注的图像。

```python

import torch

from yolov5 import detect

# 加载模型

model = detect.create_model(name='yolov5s', weights='yolov5s.pt')

# 加载图像

image = 'path/to/image.jpg'

# 进行目标检测

results = model(image)

# 解析检测结果

for result in results.pred:

class_id = int(result[5].item())

confidence = float(result[4].item())

x1, y1, x2, y2 = result[:4].int().tolist()

print(f'类别:{class_id}, 置信度:{confidence}, 坐标:({x1}, {y1}, {x2}, {y2})')

```

#### 4.1.2 VOC数据集

VOC(Visual Object Classes)数据集是另一个常用的目标检测数据集,包含20个目标类别和超过1万张带标注的图像。

```python

import torch

from yolov5 import detect

# 加载模型

model = detect.create_model(name='yolov5m', weights='yolov5m.pt')

# 加载图像

image = 'path/to/image.jpg'

# 进行目标检测

results = model(image)

# 解析检测结果

for result in results.pred:

class_id = int(result[5].item())

confidence = float(result[4].item())

x1, y1, x2, y2 = result[:4].int().tolist()

print(f'类别:{class_id}, 置信度:{confidence}, 坐标:({x1}, {y1}, {x2}, {y2})')

```

### 4.2 视频目标检测任务

YOLOv5算法不仅适用于图像目标检测,还可用于视频目标检测任务。

#### 4.2.1 MOT17数据集

MOT17(Multiple Object Tracking)数据集是视频目标检测领域的基准数据集,包含14个视频序列,涉及行人跟踪、车辆跟踪等任务。

#### 4.2.2 MOT20数据集

MOT20数据集是MOT17数据集的扩展,包含12个视频序列,具有更复杂的目标运动和遮挡情况。

```python

import torch

from yolov5 import video

# 加载模型

model = video.create_model(name='yolov5s', weights='yolov5s.pt')

# 加载视频

video_path = 'path/to/video.mp4'

# 进行视频目标检测

results = model(video_path)

# 解析检测结果

for result in results:

frame_id = int(result[0].item())

class_id = int(result[1].item())

confidence = float(result[2].item())

x1, y1, x2, y2 = result[3:7].int().tolist()

print(f'帧:{frame_id}, 类别:{class_id}, 置信度:{confidence}, 坐标:({x1}, {y1}, {x2}, {y2})')

```

# 5. YOLOv5算法未来发展趋势

### 5.1 轻量化YOLO算法

随着移动设备和嵌入式系统的普及,对轻量级目标检测算法的需求日益增长。YOLOv5算法虽然已经具备了一定的轻量化优势,但仍有进一步优化的空间。未来,轻量化YOLO算法的研究方向主要集中在以下几个方面:

- **模型压缩:**通过剪枝、量化等技术减少模型参数和计算量,从而降低算法的内存占用和运行时间。

- **网络结构优化:**设计更轻量级的网络结构,例如采用深度可分离卷积、分组卷积等技术,减少计算复杂度。

- **算法融合:**将YOLO算法与其他轻量级算法相结合,例如MobileNet、ShuffleNet等,发挥不同算法的优势,提升轻量化效果。

### 5.2 泛化能力增强

YOLOv5算法虽然在通用目标检测任务上表现出色,但在面对不同场景、不同目标时,其泛化能力仍有提升空间。未来,增强YOLOv5算法泛化能力的研究方向主要集中在以下几个方面:

- **数据增强:**采用更丰富的图像增强技术,例如随机擦除、随机缩放、颜色抖动等,增强模型对不同图像特征的适应性。

- **多任务学习:**将目标检测任务与其他相关任务相结合,例如图像分类、语义分割等,提升模型对不同场景的理解能力。

- **元学习:**采用元学习技术,使模型能够快速适应新的任务和场景,提高泛化能力。

### 5.3 实时目标检测

实时目标检测要求算法能够以较高的帧率处理视频流,满足实时性要求。未来,提升YOLOv5算法实时性的研究方向主要集中在以下几个方面:

- **模型加速:**采用并行计算、GPU优化等技术,提升模型的推理速度。

- **算法优化:**设计轻量级的网络结构、采用高效的推理算法,减少算法的计算量和内存占用。

- **硬件优化:**与专门的硬件设备相结合,例如TPU、GPU等,充分利用硬件加速能力,提升算法的实时性。

0

0