【k-means聚类性能飙升】:5大优化策略,C++中的性能加速秘诀

摘要

k-means聚类算法是数据挖掘和机器学习领域中广泛使用的一种基本聚类技术。本文从基础概念讲起,详细介绍了k-means算法的理论基础和在C++中的实现方法,强调了代码优化和性能提升的重要性。进一步探讨了多种性能优化策略,包括数据预处理技巧、算法改进、硬件加速以及缓存和内存管理。本文还探讨了高级优化技巧,如算法变种和应对大数据的处理方法,并通过实际应用中的优化实例展示了如何选择合适的数据结构、调试和分析性能瓶颈。最后,文章展望了k-means聚类的未来趋势与面临的挑战,为读者提供深入理解和应用该算法的全面视图。

关键字

k-means聚类;算法实现;性能优化;数据预处理;内存管理;大数据分析

参考资源链接:C++实现k-means聚类算法详解

1. k-means聚类算法简介

k-means聚类算法作为数据挖掘中应用最广泛的算法之一,其主要功能是将数据集划分为指定数量的聚类,并以群内误差平方和最小化为优化目标。本章旨在为读者提供k-means算法的浅显入门,涵盖其原理和在处理数据时的基本步骤。

1.1 k-means算法原理概述

k-means是一种迭代算法,其核心思路是:首先随机选择k个数据点作为初始聚类中心,然后根据距离最近的中心点分配数据点至各个簇。之后,对每个簇内的数据点重新计算中心,直到满足一定的终止条件,例如中心点不再变化或达到最大迭代次数。

1.2 k-means算法的应用场景

由于其简单的实现和高效的性能,k-means算法被广泛应用于图像分割、市场细分、社交网络分析、数据分析等多种场合。然而,需要注意的是k-means算法对于初始中心点的选择非常敏感,且假定聚类是凸形的,这可能限制了它在某些类型数据上的应用。

代码示例

在介绍k-means算法的基本原理之后,我们可以通过一个简单的代码示例来加深理解。这里仅展示算法的基本结构,以便于后续深入分析和优化。

- #include <vector>

- #include <algorithm>

- // 计算两点间的欧几里得距离

- double euclideanDistance(const std::vector<double>& a, const std::vector<double>& b) {

- double sum = 0;

- for (size_t i = 0; i < a.size(); i++) {

- sum += (a[i] - b[i]) * (a[i] - b[i]);

- }

- return std::sqrt(sum);

- }

- // 为每个数据点分配最近的中心

- void assignClusters(std::vector<std::vector<double>>& data,

- std::vector<std::vector<double>>& centroids,

- std::vector<int>& clusters) {

- // 对数据点进行遍历...

- }

- // 更新中心点位置

- void updateCentroids(std::vector<std::vector<double>>& data,

- std::vector<int>& clusters,

- std::vector<std::vector<double>>& centroids) {

- // 更新每个簇的中心...

- }

- int main() {

- // 假设已有数据点和初始中心点...

- std::vector<std::vector<double>> data; // 数据点

- std::vector<std::vector<double>> centroids; // 初始中心点

- std::vector<int> clusters(data.size()); // 存储分配的簇标记

- // 迭代过程

- for (int iter = 0; iter < MAX_ITERATIONS; iter++) {

- assignClusters(data, centroids, clusters);

- updateCentroids(data, clusters, centroids);

- }

- return 0;

- }

在后续章节中,我们将深入探讨k-means算法的更多细节,包括C++中高效的实现、性能优化策略以及高级优化技巧。

2. C++中实现k-means聚类的基础

在本章中,我们将深入探讨如何在C++中实现k-means聚类算法。作为数据挖掘和机器学习领域中一个广泛使用的基础算法,理解其在C++中的实现对于数据科学家和软件工程师而言至关重要。本章涵盖了从理论基础到具体实现的各个方面,旨在为读者提供一个全面的视角。

2.1 k-means算法的理论基础

2.1.1 算法原理概述

k-means聚类算法是一种无监督学习算法,用于将数据集分割成K个聚类。在k-means中,每个聚类由一个中心点(也称为质心)来表示,该中心点是聚类中所有点的均值。算法的目的是最小化每个点到其所属聚类中心的距离之和,即簇内距离总和最小化。

在C++中实现k-means,首先需要理解算法的几个关键步骤:

- 初始化:随机选择K个数据点作为初始质心。

- 分配:将每个点分配到最近的质心所代表的聚类中。

- 更新:重新计算每个聚类的质心。

- 迭代:重复步骤2和3,直到质心不再发生变化或者达到预设的迭代次数。

2.1.2 聚类的数学模型和公式

要正确实现k-means,我们需要掌握其数学模型和公式。假定数据集有N个d维数据点,记为X = {x1, x2, …, xN},其中每个xi属于R^d。聚类数目为K,第i个聚类的质心记为ci。簇内距离总和可以表示为:

[ J(c_1, c_2, …, c_K; X) = \sum_{k=1}^{K} \sum_{x_i \in C_k} ||x_i - c_k||^2 ]

其中,(C_k) 表示第k个聚类,(||x_i - c_k||) 表示点(x_i)和质心(c_k)之间的欧几里得距离。

k-means算法旨在最小化上述目标函数。在实现中,我们会使用循环来迭代质心和聚类分配过程。

2.2 C++环境准备和库依赖

2.2.1 开发环境配置

在开始编写代码之前,我们需要配置好C++的开发环境。推荐使用Visual Studio、CLion或者任何支持C++11及以上的IDE。确保安装了支持STL容器的最新编译器,这对于后续实现中的数据结构和算法优化至关重要。

2.2.2 必要的数学库和数据处理库介绍

在C++中,我们可以使用标准模板库(STL)中的vector、algorithm等组件进行数据处理。对于数学计算,我们可以使用C++的数值计算库,或者第三方数学库,如Eigen、Armadillo等,来进行高效的矩阵运算。对于数据的预处理和分析,可以考虑使用如OpenCV之类的图像处理库,或者使用自己编写的代码进行特征提取和转换。

2.3 k-means算法的C++实现

2.3.1 核心代码逻辑

下面展示了k-means算法在C++中的一个简化版本的核心实现:

- #include <vector>

- #include <limits>

- #include <cmath>

- struct Point {

- double x, y; // 假设我们在二维空间进行聚类

- double distanceFromCenter(const Point& center) const {

- return std::sqrt((x - center.x) * (x - center.x) + (y - center.y) * (y - center.y));

- }

- };

- void kMeansClustering(std::vector<Point>& data, int K) {

- std::vector<Point> centroids(K);

- // 初始化质心

- for (int i = 0; i < K; ++i) {

- centroids[i] = data[rand() % data.size()];

- }

- bool changed = true;

- while (changed) {

- std::vector<std::vector<Point>> clusters(K);

- // 分配数据点到最近的质心

- for (const auto& point : data) {

- int bestCluster = 0;

- double closestDistance = std::numeric_limits<double>::max();

- for (int k = 0; k < K; ++k) {

- double distance = point.distanceFromCenter(centroids[k]);

- if (distance < closestDistance) {

- closestDistance = distance;

- bestCluster = k;

- }

- }

- clusters[bestCluster].push_back(point);

- }

- changed = false;

- // 更新质心位置

- for (int k = 0; k < K; ++k) {

- Point& newCenter = centroids[k];

- if (clusters[k].empty()) continue;

- newCenter.x = newCenter.y = 0;

- for (const auto& point : clusters[k]) {

- newCenter.x += point.x;

- newCenter.y += point.y;

- }

- newCenter.x /= clusters[k].size();

- newCenter.y /= clusters[k].size();

- // 检查质心是否变化

- changed |= (newCenter.x != centroids[k].x || newCenter.y != centroids[k].y);

- }

- }

- }

2.3.2 性能考量:代码优化初步

在上述代码中,我们简单实现了k-means算法的核心逻辑,但在生产环境中,性能是不容忽视的考量因素。代码优化可以从多个层面进行:

- 数据结构优化:使用更适合的容器来存储数据点和聚类信息,例如使用

std::unordered_map或std::map对聚类进行快速访问。 - 算法优化:减少不必要的计算和内存访问,如避免在每次迭代中复制整个数据集到聚类容器。

- 并行处理:利用C++17引入的并行算法库,对数据分配和质心更新过程进行并行化处理,以提高计算效率。

以上我们介绍了k-means聚类算法在C++中的基础实现。接下来的章节将深入探讨如何通过不同的策略进一步优化算法性能,包括数据预处理、算法改进、硬件加速等。

3. k-means聚类性能优化策略

3.1 数据预处理对性能的影响

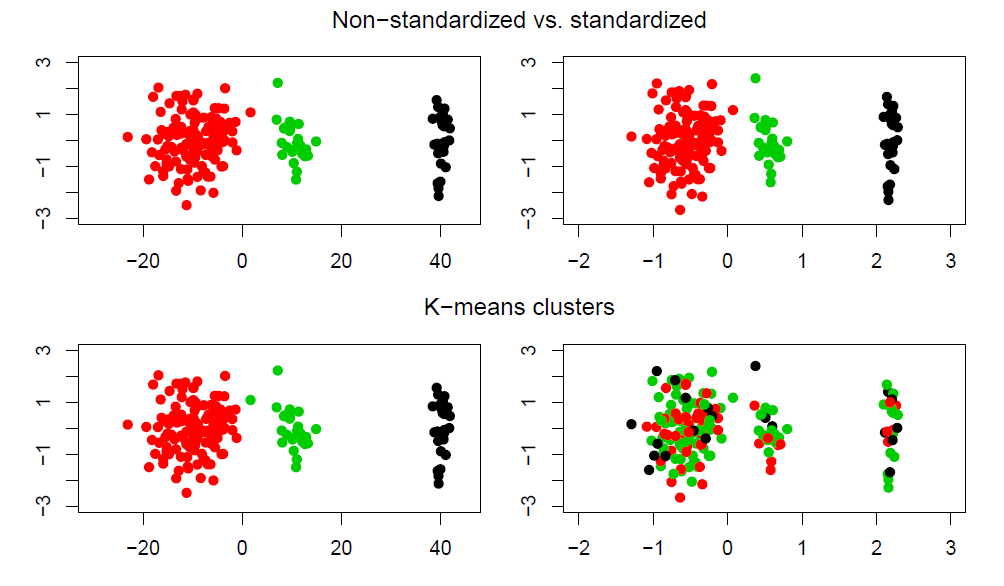

3.1.1 标准化和归一化的技巧

在进行k-means聚类之前,数据预处理是至关重要的一步。标准化(Standardization)和归一化(Normalization)是两种常用的数据预处理方法,它们可以提高聚类的质量和算法的执行效率。

标准化通常是指将数据按比例缩放,使之落入一个小的特定区间。常用的方法是将数据的均值(mean)变为0,标准差(standard deviation)变为1。这种方法适用于数据分布的均值和方差具有实际意义的情况,例如,当特征的数据量级相差悬殊时,进行标准化处理可以防止某些量级大的特征主导聚类结果。

- #include <algorithm> // std::transform

- #include <vector>

- #include <cmath> // sqrt

- #include <numeric> // std::accumulate

- void Standardize(std::vector<double>& data) {

- double mean = std::accumulate(data.begin(), data.end(), 0.0) / data.size();

- double sq_sum = std::inner_product(data.begin(), data.end(), data.begin(), 0.0);

- double stdev = sqrt(sq_sum / data.size() - mean * mean);

- std::transform(data.begin(), data.end(), data.begin(),

- [mean, stdev](double x) { return (x - mean) / stdev; });

- }

上述代码块展示了如何在C++中对一个std::vector<double>类型的数据进行标准化处理。std::transform用于对向量中的每个元素应用特定的操作,这里是标准化公式。std::inner_product计算向量元素的平方和。

归一化则通常是指将数据缩放到一个指定的范围,例如[0, 1]。归一化的数据便于在不同量级的数据间进行比较,并且在机器学习中非常常见,它有助于算法更快地收敛。

3.1.2 特征选择和维度缩减

特征选择是指从原始数据集中挑选出对聚类效果最有益的特征子集。这不仅可以减少数据的维度,而且可以排除噪声和不相关的特征,提高聚类准确度和效率。

在k-means聚类中,维度缩减常用于降低计算的复杂度。常见的维度缩减方法包括主成分分析(PCA)和奇异值分解(SVD)。这些方法可以有效减小数据的维数,同时尽可能保留重要的信息。

- // 假设使用PCA进行特征降维

- // 伪代码表示PCA算法步骤

- void PCA(std::vector<std::vector<double>>& dataset) {

- // 计算均值

- // 中心化数据

- // 计算协方差矩阵

- // 计算协方差矩阵的特征值和特征向量

- // 选择前k个最大的特征值对应的特征向量

- // 将数据投影到特征向量上

- }

以上代码块展示了PCA算法的一般步骤。虽然这不是实际可执行的代码,但它清楚地说明了在C++中实现PCA时可能会遇到的逻辑。

3.2 算法优化:减少迭代次数

3.2.1 改进的初始化方法

初始化方法的选择对k-means算法的性能和最终聚类结果的质量有很大的影响。最常用的初始化方法是随机选择初始中心点,但这种方法可能会导致收敛速度慢和结果不稳定。

为了解决这个问题,可以使用**k-means++**初始化策略。这种策略使得初始中心点间的距离尽可能远,从而增加获得高质量聚类结果的可能性。k-means++通过选择概率与距离的平方成反比的点作为初始中心点,从而保证初始中心点的分布更加均匀。

3.2.2 中心点更新的优化

在k-means算法中,更新中心点是影响效率的另一个关键步骤。传统的中心点更新方法在每次迭代中重新计算所有点的平均值,这个过程可能非常耗时。

一种优化策略是使用在线k-means算法,它通过增量方式更新中心点,只考虑被新分配到簇中的数据点,这样可以减少不必要的计算。此外,还可以通过并行计算来加速中心点的更新,将计算分散到多个线程或处理器上。

3.3 硬件加速和并行计算

3.3.1 利用SIMD指令集优化

现代CPU通常支持单指令多数据(Single Instruction, Multiple Data,SIMD)指令集,可以并行处理多个数据元素。使用这些指令集可以显著提高数据密集型算法的性能。

在C++中,可以通过特定的编译器指令或库函数来利用SIMD指令集。例如,使用__m128和_mm_set_ps等数据类型和函数来操作AVX指令集。

3.3.2 多线程和分布式计算实践

多线程技术可以在同一台机器上利用多个CPU核心来提高性能。现代C++标准库提供了对多线程编程的支持,例如通过std::thread来创建新的线程。

在需要处理非常大的数据集时,可以采用分布式计算。在分布式环境中,数据被分散到不同的节点上,并行地进行计算。这样不仅可以缩短处理时间,还可以处理超出单台机器内存限制的大数据集。分布式k-means聚类算法通常会涉及到数据分区、映射、归约等步骤。

通过上述章节的介绍,本章对k-means聚类算法的性能优化策略进行了深入的探讨,涵盖了数据预处理、算法本身优化以及利用现代硬件加速的多方面内容。在接下来的章节中,我们将进一步探索k-means聚类的高级优化技巧以及在实际应用中的优化实例。

4. k-means聚类高级优化技巧

4.1 缓存优化和内存管理

k-means聚类算法的性能在很大程度上依赖于数据的组织方式以及内存访问的效率。随着数据规模的增加,缓存友好性和内存管理变得更加重要。

4.1.1 利用局部性原理减少缓存未命中

计算机体系结构中有一个重要的原理叫做局部性原理,它包括时间局部性和空间局部性。在实现k-means时,利用局部性原理可以显著减少缓存未命中(cache miss),从而提高效率。

时间局部性意味着如果一个数据项被访问,那么在不久的将来它可能再次被访问。在k-means中,这可以应用于频繁访问的点(数据点)或中心点。

- // 伪代码示例展示时间局部性原理的应用

- for(int i = 0; i < num_iterations; ++i) {

- for(int j = 0; j < num_points; ++j) {

- computeDistance(dataPoints[j], centers); // 计算数据点与中心点距离

- }

- for(int j = 0; j < num_clusters; ++j) {

- updateCenter(j, dataPoints); // 更新每个聚类的中心点

- }

- }

在上述伪代码中,数据点和中心点被多次访问。通过将它们保存在缓存友好型的数据结构中(例如数组或紧密排列的结构),可以提高缓存命中率。

空间局部性意味着如果一个数据项被访问,那么它附近的数据项也有可能被访问。对于k-means算法,可以尝试将相邻的数据点或聚类中心存储在连续的内存位置,以减少缓存未命中的情况。

- // 优化后的数据结构,按照空间局部性原理设计

- struct DataPoint {

- double x, y; // 可以扩展到多维

- };

- std::vector<DataPoint> dataPoints;

- std::vector<DataPoint> centers;

4.1.2 高效内存访问模式和内存泄漏预防

在进行k-means聚类时,有效的内存访问模式至关重要。尝试减少随机访问模式并优化循环顺序,以确保数据访问尽可能地顺序化,从而减少内存访问延迟。

- // 优化内存访问模式的代码示例

- for(int i = 0; i < num_clusters; ++i) {

- for(int j = 0; j < num_points; ++j) {

- // 这里计算并更新了每个点到中心i的距离,并更新中心

- updateMembershipAndCenters(i, dataPoints[j], centers);

- }

- }

此外,内存泄漏是一个容易被忽视的问题。在C++中,需要确保每次使用new关键字分配的内存,在适当的时候使用delete释放。

4.2 算法变种和自适应策略

k-means算法有多种变体,它们在特定情况下可以提供更好的性能。

4.2.1 k-means++和其它变种算法

k-means++是一种改进的初始化策略,它选择初始中心点的方式更有利于找到全局最优解。它首先随机选择一个点作为第一个中心点,之后,每个新中心点都是以一定的概率选择的,这个概率与点到最近已有中心点的距离成正比。

- // k-means++ 初始化中心点的伪代码

- std::vector<DataPoint> initializeCenters(const std::vector<DataPoint>& dataPoints) {

- std::vector<DataPoint> centers;

- // 随机选择第一个中心点

- centers.push_back(dataPoints[rand() % dataPoints.size()]);

- while (centers.size() < num_clusters) {

- // 计算每个点到最近中心的距离

- std::vector<double> distances = computeDistancesToNearestCenter(dataPoints, centers);

- // 根据距离和概率选择新的中心点

- int idx = selectNextCenter(distances);

- centers.push_back(dataPoints[idx]);

- }

- return centers;

- }

其它变种算法如k-medoids、模糊c均值(fuzzy c-means)和期望最大化(EM)算法在处理噪声数据和异常值方面表现更为优秀。

4.2.2 自适应调整聚类数目的方法

自适应调整聚类数目的方法通常涉及评估聚类结果的质量,并根据特定的标准(如轮廓系数)自动选择最佳的聚类数目。

- // 通过轮廓系数自适应选择最佳聚类数目的示例伪代码

- for(int k = min_clusters; k <= max_clusters; ++k) {

- std::vector<DataPoint> centers = initializeCenters(dataPoints, k);

- // 运行k-means聚类

- std::vector<int> clusters = clusterPoints(dataPoints, centers);

- double silhouette = computeSilhouetteScore(dataPoints, clusters, centers);

- if (silhouette > bestSilhouette) {

- bestSilhouette = silhouette;

- bestK = k;

- }

- }

4.3 应对大数据的k-means优化

大数据环境下,k-means聚类的优化需要特殊考虑,以确保算法能够有效地处理大规模数据集。

4.3.1 流式k-means聚类

在处理实时数据流时,流式k-means聚类是一种有效的策略。该方法不是一次性处理所有数据点,而是每次只处理一个数据点或一小批数据点,以实现在线更新。

- // 流式k-means聚类的伪代码

- while (there is a new data point) {

- DataPoint newPoint = getNextDataPoint();

- updateMembershipAndCenters(newPoint, centers);

- }

4.3.2 分块处理和采样技术

对于太大无法一次载入内存的数据集,分块处理是一种有效策略。可以将数据分块载入内存,在每一小块上运行k-means算法,然后根据某种规则合并结果。

- // 分块k-means聚类的伪代码

- for each block in dataPoints {

- k-means(block, num_clusters); // 在小块数据上运行k-means

- mergeCenters(blockCenters); // 合并聚类中心

- }

采样技术可以用于在保持数据集整体分布的同时,减少数据量。通过对原始数据集进行随机抽样,可以得到一个较小的数据子集,然后在这个子集上运行k-means算法。

- // 数据采样与k-means聚类的伪代码

- std::vector<DataPoint> sampleData(const std::vector<DataPoint>& dataPoints, int sampleSize) {

- // 实现随机采样逻辑

- }

- std::vector<DataPoint> sampledData = sampleData(dataPoints, sampleSize);

- k-means(sampledData, num_clusters); // 在采样数据上运行k-means

通过上述高级优化技巧,k-means聚类算法可以有效地处理更大规模的数据集,并在性能上有所提升。这些优化技术不仅提高了算法的效率,还拓展了其应用场景,使其在大数据时代依然保持其强大的聚类能力。

5. k-means聚类在实际应用中的优化实例

5.1 选择合适的数据结构

5.1.1 根据问题选择数据结构的技巧

在实现k-means聚类时,选择合适的数据结构对于优化性能至关重要。数据结构的选择依赖于数据的特性和算法的需求。例如,如果数据集很大但内存有限,可能需要将数据存储在磁盘上并使用外部内存数据结构。如果数据集稀疏,使用稀疏矩阵表示可能更节省空间,并能加快计算速度。

在实际操作中,常见的数据结构选择技巧包括:

- 利用向量化技术,如使用NumPy数组,能够大幅提高数据的处理速度。

- 使用KD树或球树等空间分割数据结构,可以有效提高k-means中距离计算的速度。

- 对于需要频繁访问的数据,使用缓存友好的数据结构可以显著提高性能。

下面是一个使用NumPy数组进行向量化操作的代码示例:

- import numpy as np

- # 创建一个随机数据集

- X = np.random.rand(1000, 10) # 1000个样本,每个样本10维

- # 计算距离平方

- dist_squared = np.sum(X**2, axis=1)

- # 转换成NumPy数组进行向量化操作

- center = np.array([1, 2, 3, 4, 5, 6, 7, 8, 9, 10])

- dist_from_center = np.linalg.norm(X - center, axis=1)

5.1.2 常用数据结构对性能的影响分析

不同的数据结构对性能的影响是不同的。分析其影响,可以更好地优化程序。例如,使用动态数组(如C++中的std::vector或Python中的list)存储数据时,如果数据量频繁变动,其性能开销较大。此时,使用固定大小的数组或者更高级的数据结构可能更为合适。

为了说明这一点,以下是一个简单的代码示例,说明了在Python中,列表(list)和NumPy数组在执行相同操作时性能上的差异:

- import numpy as np

- import timeit

- # 使用Python列表

- data_list = [i for i in range(10000)]

- # 使用NumPy数组

- data_array = np.arange(10000)

- # 列表操作性能测试

- list_time = timeit.timeit('sum([x**2 for x in data_list])', globals=globals(), number=100)

- # NumPy数组操作性能测试

- array_time = timeit.timeit('np.sum(data_array**2)', globals=globals(), number=100)

- print(f"List operation took {list_time} seconds.")

- print(f"Array operation took {array_time} seconds.")

在这个例子中,我们分别使用Python的列表推导和NumPy的向量化操作来计算一个列表(或数组)中每个元素的平方和。由于NumPy利用了底层的优化和向量化操作,其执行速度通常比Python列表要快得多。

5.2 调试和分析性能瓶颈

5.2.1 使用性能分析工具

在优化程序时,找出性能瓶颈是关键的一步。性能分析工具可以帮助我们确定程序中最耗时的部分。在Python中,常用的性能分析工具有cProfile,它可以给出每个函数调用的执行时间和调用次数。C++中则有gprof、Valgrind的callgrind工具等。

在下面的代码中,展示了如何使用Python内置的cProfile模块来分析程序性能瓶颈:

- import cProfile

- import pstats

- # 定义一个计算密集型函数

- def compute_intensive_function(data):

- sum = 0

- for value in data:

- sum += value

- return sum

- # 调用性能分析工具

- profile = cProfile.Profile()

- profile.enable()

- # 执行计算

- result = compute_intensive_function(data_array)

- # 停止性能分析

- profile.disable()

- # 将分析结果打印到控制台

- stats = pstats.Stats(profile).sort_stats('cumulative')

- stats.print_stats()

5.2.2 调优案例研究:从慢速到飞速的转变

在本小节中,我们将通过一个实际案例研究,展示如何从发现性能瓶颈到解决瓶颈的过程。

假设在实现k-means算法时,初步实现的代码在处理大数据集时运行缓慢。通过性能分析,我们发现距离计算部分花费了大多数时间。为了加速这部分计算,我们决定使用NumPy进行向量化操作,并对代码进行优化。

以下是初步实现和优化后实现的对比:

- # 初步实现的k-means算法

- def k_means_v1(data, n_clusters):

- # 初始化质心

- centroids = data[:n_clusters]

- for _ in range(10): # 迭代10次

- # 计算距离

- distances = [np.sqrt(((data - centroid) ** 2).sum()) for centroid in centroids]

- # 分配数据点到最近的质心

- # ...

- return centroids

- # 优化后的k-means算法

- def k_means_v2(data, n_clusters):

- # 初始化质心

- centroids = data[:n_clusters]

- for _ in range(10): # 迭代10次

- # 利用NumPy向量化计算距离

- distances = np.linalg.norm(data[:, np.newaxis] - centroids, axis=2)

- # 分配数据点到最近的质心

- # ...

- return centroids

在k_means_v1函数中,计算距离的效率很低,因为涉及到大量的Python层面的循环和计算。在k_means_v2函数中,通过NumPy的linalg.norm函数进行向量化计算,极大地提高了计算效率。通过这种方法,我们能够将k-means算法的性能从慢速提升到飞速。

5.3 真实案例分析

5.3.1 k-means在图像处理中的应用

k-means聚类在图像处理中有着广泛的应用。比如,可以通过k-means对图像中的像素进行聚类,从而实现快速的图像分割。下面展示了一个如何使用k-means对图像进行聚类分割的代码示例:

- from sklearn.cluster import KMeans

- import matplotlib.pyplot as plt

- from skimage import io

- # 读取图像

- image = io.imread('path/to/image.png')

- data = image.reshape((-1, 3)) # 将图像数据重塑为二维数组

- # 使用k-means进行聚类

- kmeans = KMeans(n_clusters=3)

- kmeans.fit(data)

- # 将聚类结果映射回图像

- labels = kmeans.predict(data)

- segmented_image = labels.reshape(image.shape[:2])

- # 展示原始图像和聚类后的图像

- plt.figure(figsize=(10, 5))

- plt.subplot(1, 2, 1)

- plt.imshow(image)

- plt.title('Original Image')

- plt.subplot(1, 2, 2)

- plt.imshow(segmented_image, cmap='viridis')

- plt.title('Segmented Image with K-Means')

- plt.show()

5.3.2 在生物信息学中对基因表达数据聚类的优化实践

在生物信息学中,k-means聚类可以用于对基因表达数据进行聚类分析,以帮助识别不同生物样本中的表达模式。在这个领域中,数据往往非常庞大且复杂,因此算法的性能优化尤为重要。

以下是一个使用Python和scikit-learn库对基因表达数据进行聚类优化的示例:

- from sklearn.cluster import KMeans

- import pandas as pd

- # 假设有一个基因表达数据集

- data = pd.read_csv('path/to/expression_data.csv', index_col=0)

- # 使用k-means对基因表达数据进行聚类

- kmeans = KMeans(n_clusters=5, n_init=20, max_iter=500)

- kmeans.fit(data)

- # 输出聚类结果

- clusters = kmeans.labels_

- print(clusters)

在这个示例中,我们通过调整k-means算法的参数如n_init和max_iter来优化性能。n_init参数指定了算法运行次数,通过多次运行选择最佳的质心初始化。max_iter参数限制了每次运行的最大迭代次数,用于避免过长的计算时间。

在生物信息学中,除了优化算法参数,还可能需要对数据进行预处理,比如标准化基因表达量,以及应用其他高级聚类技术,比如层次聚类或者基于模型的聚类方法,以提高聚类结果的生物相关性和解释性。

6. k-means聚类算法的可视化与解释性

6.1 可视化的重要性与方法

在数据分析和机器学习中,可视化是一种不可或缺的工具,它能够帮助我们直观地理解数据的分布,观察聚类结果,并发现潜在的数据模式。可视化不仅仅是为了美观,更重要的是它提供了一种直观的解释性手段,使非专业人士也能够理解算法的输出和决策过程。

在k-means聚类中,有几种常用的可视化方法:

- 二维散点图:最直观的可视化方式,通过二维散点图可以直观地看到数据点分布以及聚类的中心点。

- 三维散点图:对于三维数据集,使用三维散点图可以帮助观察更高维度数据的聚类。

- 特征空间投影:当数据维度超过三维时,可以将数据投影到前几个主成分上进行可视化。

下面是一个简单的代码示例,展示如何使用Python的matplotlib库来绘制二维散点图:

- import matplotlib.pyplot as plt

- # 假设已有聚类结果和数据点

- centers = [[1, 1], [-1, -1], [1, -1]]

- points = [[0.7, 0.8], [-0.6, -0.7], [0.7, -0.8]]

- # 绘制聚类中心点

- plt.scatter([c[0] for c in centers], [c[1] for c in centers], s=150, marker='X', color='r')

- # 绘制数据点,并按聚类结果着色

- colors = ['green', 'blue', 'red']

- for i, point in enumerate(points):

- plt.scatter(point[0], point[1], color=colors[i], label=f'Cluster {i+1}')

- plt.xlabel('Feature 1')

- plt.ylabel('Feature 2')

- plt.title('K-means Clustering Visualization')

- plt.legend()

- plt.show()

6.2 可视化工具的比较与选择

市场上存在多种可视化工具,包括但不限于Matplotlib、Seaborn、Plotly、Bokeh和Tableau。选择哪个工具取决于多种因素,比如项目的具体需求、用户界面的友好程度、集成的复杂性以及个人或团队的技术栈偏好。

6.2.1 Matplotlib

- 优点:易于学习,功能丰富,高度可定制,适合编程风格的可视化。

- 缺点:默认样式较为单调,需要进行额外的定制才能达到美观的水平。

6.2.2 Seaborn

- 优点:基于Matplotlib,提供更加丰富的绘图选项和美观的默认主题。

- 缺点:仍然需要对Matplotlib有一定的了解,因为Seaborn在很多情况下是对Matplotlib的高级封装。

6.2.3 Plotly

- 优点:提供交互式图表,可以在网页中展示,并支持三维图形。

- 缺点:对于一些简单的图表,代码会比Matplotlib更复杂。

6.2.4 Bokeh

- 优点:同样支持交互式图形,并且可以很好地与Web应用集成。

- 缺点:需要较多的设置工作,适用于较复杂的场景。

6.2.5 Tableau

- 优点:高度可视化、用户友好,可以快速地制作出专业级别的报告和仪表板。

- 缺点:对于程序员来说,可能缺乏足够的编程灵活性。

在实际工作中,需要根据项目的具体需求和团队的技术栈来选择合适的工具。例如,如果项目需要在Web应用中集成图形,并且需要用户交互,那么可能会倾向于选择Plotly或Bokeh。如果项目是在Python环境中,并且对图形的美观度要求较高,Seaborn可能是更好的选择。

6.3 可视化与解释性在算法优化中的作用

可视化不仅仅是展示数据的一种方式,它在算法优化过程中也发挥着关键作用。通过可视化,我们可以:

- 快速检测数据中的异常值和噪声,这有助于清洗数据和选择合适的预处理技术。

- 直观地评估聚类的效果,及时调整聚类算法的参数,如簇的数量、初始化方法等。

- 分析算法的收敛过程,了解迭代次数对聚类结果的影响。

- 向利益相关者解释聚类结果,尤其是在跨学科项目中,使非技术人员能够理解聚类的目的和结果。

可视化的最终目标是使得数据和模型的理解更加容易,让决策者可以基于数据作出明智的决策。在k-means聚类算法的优化过程中,合理地应用可视化工具,不仅能够提升算法的性能,还能够增强模型的解释性,从而在业务中发挥更大的价值。