Python日志管理进阶秘籍:logging.config模块高级配置全解析

发布时间: 2024-10-12 23:11:03 阅读量: 36 订阅数: 26

基于纯verilogFPGA的双线性差值视频缩放 功能:利用双线性差值算法,pc端HDMI输入视频缩小或放大,然后再通过HDMI输出显示,可以任意缩放 缩放模块仅含有ddr ip,手写了 ram,f

# 1. Python日志管理基础

## 1.1 日志的基本概念和重要性

在Python编程中,日志记录是一种重要的调试和记录程序运行状态的手段。通过日志,开发者可以监控程序的运行过程,记录关键信息,并在发生错误时快速定位问题。日志记录的重要性体现在以下几个方面:

1. **问题追踪**:日志记录可以帮助开发者追踪程序运行中的错误和异常情况。

2. **性能监控**:通过记录性能相关的信息,如响应时间、事务处理时间等,开发者可以对程序性能进行分析和优化。

3. **安全审计**:日志也是安全审计的重要工具,它记录了系统的访问和操作历史,有助于发现和分析安全事件。

## 1.2 Python中的日志模块概述

Python标准库中的`logging`模块提供了一个灵活的日志记录系统。使用`logging`模块,开发者可以轻松地在程序中添加日志记录功能,并且可以对日志的格式、级别、输出目标等进行详细的配置。`logging`模块的主要优势包括:

- **简单易用**:通过简单的几行代码,就可以开始记录日志。

- **灵活性**:支持多种日志级别和输出格式。

- **可扩展性**:可以通过配置文件或编程方式进行高度定制。

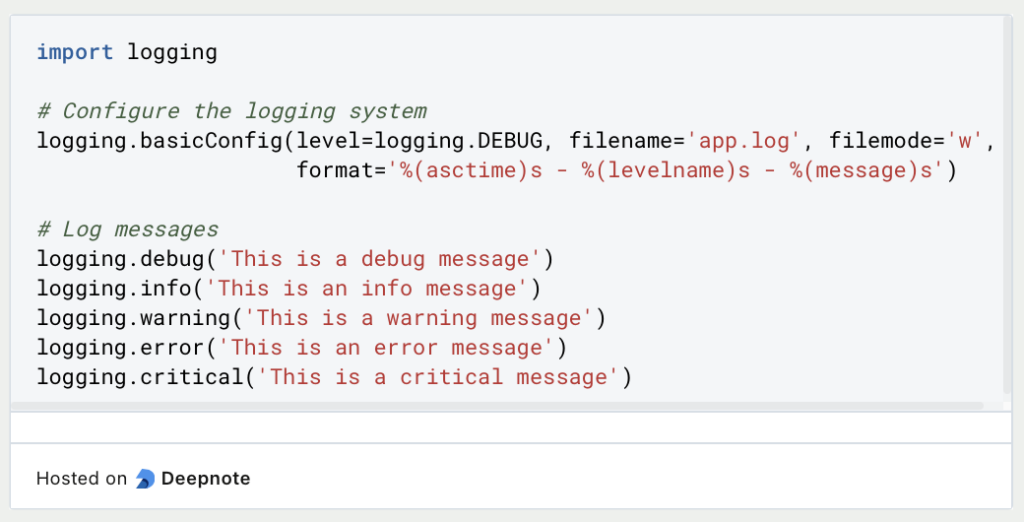

## 1.3 日志级别的基本使用

Python中的日志级别由低到高依次为`DEBUG`, `INFO`, `WARNING`, `ERROR`, `CRITICAL`。在实际开发中,根据需要记录的信息的详细程度和重要性,可以选择不同的日志级别。

例如,下面的代码展示了如何使用`logging`模块记录不同级别的日志:

```python

import logging

logging.basicConfig(level=logging.DEBUG) # 设置日志级别为DEBUG

logging.debug('这是一个debug级别的日志') # 输出debug级别的日志

***('这是一个info级别的日志') # 输出info级别的日志

logging.warning('这是一个warning级别的日志') # 输出warning级别的日志

logging.error('这是一个error级别的日志') # 输出error级别的日志

logging.critical('这是一个critical级别的日志') # 输出critical级别的日志

```

通过上述代码,开发者可以在程序运行时记录不同级别的日志信息,以便于后续的问题追踪和性能分析。

# 2. logging.config模块详解

## 2.1 logging.config模块概述

### 2.1.1 logging.config模块的引入和作用

`logging.config` 是 Python 标准库中的一个模块,它提供了一种灵活的方式来配置日志系统。通过使用 `logging.config`,我们可以将日志配置信息集中管理,使得日志系统的配置更加清晰和易于维护。这个模块自 Python 2.7 和 3.2 版本开始被引入,它支持字典配置、文件配置等多种方式,并且可以与现有的 `logging` 模块无缝集成。

通过 `logging.config` 模块,我们可以完成以下任务:

- 定义日志记录器(loggers)、处理器(handlers)、格式化器(formatters)和过滤器(filters)。

- 使用字典或者 `.ini` 文件来配置日志系统,无需编写复杂的代码。

- 支持文件格式化和监听套接字的配置,方便远程日志管理。

### 2.1.2 logging.config模块与其他日志模块的比较

与其他的日志模块或库相比,`logging.config` 提供了一种更为标准和推荐的方式来配置日志。例如,与 `logging.basicConfig` 方法相比,`logging.config` 提供了更多的灵活性和功能。`basicConfig` 方法通常用于简单的日志配置,例如设置日志级别和输出格式,而 `logging.config` 则可以用于更复杂的场景,如文件轮转、处理器共享、自定义过滤器等。

与其他第三方日志库(如 `log4py` 或 `structlog`)相比,`logging.config` 的优势在于它是 Python 标准库的一部分,不需要额外安装。此外,它与 Python 生态系统中的其他部分(如 `logging` 模块)有着更好的集成和兼容性。

## 2.2 logging.config模块的主要函数和方法

### 2.2.1 dictConfig函数的使用和解析

`dictConfig` 是 `logging.config` 模块中的核心函数之一,它允许用户通过一个字典来配置日志系统。这个字典包含了一系列的配置项,如日志记录器、处理器、格式化器等,这些配置项对应于日志系统的不同组件。使用 `dictConfig` 函数,我们可以实现复杂的日志配置,而无需编写大量的代码。

以下是一个使用 `dictConfig` 的基本示例:

```python

import logging

import logging.config

config = {

'version': 1,

'formatters': {

'default': {

'format': '%(asctime)s - %(name)s - %(levelname)s - %(message)s'

}

},

'handlers': {

'console': {

'class': 'logging.StreamHandler',

'formatter': 'default',

'level': 'DEBUG'

}

},

'loggers': {

'': {

'handlers': ['console'],

'level': 'DEBUG'

}

}

}

logging.config.dictConfig(config)

logger = logging.getLogger(__name__)

logger.debug('This is a debug message.')

```

在这个示例中,我们定义了一个字典 `config`,它包含了日志的版本、格式化器、处理器和记录器的配置。然后,我们调用 `logging.config.dictConfig(config)` 来应用这些配置。最后,我们获取了一个记录器并记录了一条调试信息。

### 2.2.2 fileConfig函数的使用和解析

`fileConfig` 函数允许用户通过一个 `.ini` 文件来配置日志系统。这个 `.ini` 文件遵循标准的 `ConfigParser` 语法,使得日志配置更加简单和直观。使用 `fileConfig` 函数,用户可以轻松地在不同的环境中切换日志配置,而无需修改代码。

以下是一个使用 `fileConfig` 的基本示例:

假设我们有一个名为 `logging.conf` 的配置文件,内容如下:

```ini

[loggers]

keys=root

[handlers]

keys=consoleHandler

[formatters]

keys=myFormatter

[logger_root]

level=DEBUG

handlers=consoleHandler

[handler_consoleHandler]

class=StreamHandler

level=DEBUG

formatter=myFormatter

args=(sys.stdout,)

[formatter_myFormatter]

format=%(asctime)s - %(name)s - %(levelname)s - %(message)s

```

然后,我们可以使用以下代码来加载这个配置文件:

```python

import logging

import logging.config

logging.config.fileConfig('logging.conf')

logger = logging.getLogger('root')

logger.debug('This is a debug message.')

```

在这个示例中,我们使用 `logging.config.fileConfig('logging.conf')` 来加载 `logging.conf` 文件中的配置。这将创建一个名为 `root` 的记录器,并将其与一个控制台处理器和一个格式化器关联起来。最后,我们记录了一条调试信息。

## 2.3 logging.config模块的高级配置项解析

### 2.3.1 handlers的配置和使用

处理器(handlers)是 `logging` 系统中的一个关键组件,它们负责将日志记录发送到目的地。例如,一个处理器可能将日志写入一个文件,而另一个处理器可能将日志发送到网络套接字。`logging.config` 模块提供了多种方式来配置处理器,包括字典配置和文件配置。

在字典配置中,处理器通常是字典中 `handlers` 键的值,每个处理器的配置是一个子字典,包含了处理器的类、级别、格式化器和其他属性。

以下是一个处理器配置的示例:

```python

handlers = {

'console': {

'class': 'logging.StreamHandler',

'formatter': 'default',

'level': 'DEBUG'

},

'file': {

'class': 'logging.FileHandler',

'filename': 'app.log',

'formatter': 'default',

'mode': 'a',

}

}

```

在这个示例中,我们配置了两个处理器:一个控制台处理器和一个文件处理器。每个处理器都有其自己的配置,包括处理器的类、格式化器、级别和文件名等。

### 2.3.2 formatters的配置和使用

格式化器(formatters)定义了日志记录的最终输出格式。格式化器配置通常包含在处理器的配置中,但在字典配置中,格式化器也可以独立配置。格式化器可以是任何字典,包含 `format` 和 `datefmt` 键。

以下是一个格式化器配置的示例:

```python

formatters = {

'default': {

'format': '%(asctime)s - %(name)s - %(levelname)s - %(message)s'

}

}

```

在这个示例中,我们定义了一个名为 `default` 的格式化器,它包含了一个简单的格式字符串。这个格式化器可以在处理器配置中被引用。

### 2.3.3 loggers的配置和使用

记录器(loggers)是 `logging` 系统的主要组件,用于发出日志记录调用。每个记录器都可以有自己的配置,包括处理器、格式化器和级别。在字典配置中,记录器是字典中 `loggers` 键的值。

以下是一个记录器配置的示例:

```python

loggers = {

'': {

'handlers': ['console', 'file'],

'level': 'DEBUG',

'propagate': True

}

}

```

在这个示例中,我们配置了一个根记录器,它有两个处理器:一个控制台处理器和一个文件处理器。记录器的级别设置为 `DEBUG`,并且 `propagate` 属性设置为 `True`,这意味着如果记录器不处理一个日志记录,那么这个记录将传播到父记录器。

以上是 `logging.config` 模块的概述和主要函数的使用与解析。在下一章节中,我们将深入探讨如何在实际应用中进行日志级别的高级配置和自定义日志格式。

# 3.1 日志级别和格式的高级配置

在本章节中,我们将深入探讨如何根据特定需求设置日志级别以及如何自定义日志格式。日志级别是日志管理中的核心概念,它决定了哪些日志消息会被记录和处理。而自定义日志格式则可以让日志信息更加丰富和有用,以便于后续的分析和问题排查。

#### 如何根据需求设置日志级别

Python 的 logging 模块提供了多种日志级别,包括 DEBUG、INFO、WARNING、ERROR、CRITICAL 等。默认情况下,INFO 级别的日志会被记录,但有时候我们需要根据实际需求来调整这些级别。

例如,如果你正在开发一个调试阶段的应用程序,你可能希望记录所有 DEBUG 级别的日志,以便捕获更多的调试信息。这可以通过设置根记录器的日志级别来实现:

```python

import logging

# 设置根记录器的日志级别为 DEBUG

logging.basicConfig(level=logging.DEBUG)

```

在生产环境中,我们通常只关心错误和严重错误级别的日志。此时,我们可以将根记录器的日志级别设置为 WARNING:

```python

import logging

# 设置根记录器的日志级别为 WARNING

logging.basicConfig(level=logging.WARNING)

```

此外,我们还可以针对特定的记录器设置不同的日志级别,这对于大型项目中的模块化开发非常有用。例如,我们可以为数据库模块设置一个更细粒度的日志级别:

```python

import logging

# 创建一个名为 'db' 的记录器

db_logger = logging.getLogger('db')

db_logger.setLevel(logging.DEBUG)

# 创建一个日志处理器

handler = logging.StreamHandler()

# 创建一个日志格式器

formatter = logging.Formatter('%(asctime)s - %(name)s - %(levelname)s - %(message)s')

# 将格式器添加到处理器中

handler.setFormatter(formatter)

# 将处理器添加到记录器中

db_logger.addHandler(handler)

# 记录日志

db_logger.debug("Database connection established")

db_***("Query executed successfully")

db_logger.warning("Low disk space")

db_logger.error("Database connection failed")

db_logger.critical("Database server crashed")

```

在上述代码中,我们为名为 'db' 的记录器设置了 DEBUG 级别的日志级别,并添加了一个处理器和格式器。这样,即使根记录器的日志级别是 WARNING,'db' 记录器仍然会记录所有级别的日志。

#### 如何自定义日志格式

日志格式是日志消息的模板,它定义了日志输出的结构和内容。默认的日志格式通常包括时间戳、日志级别、记录器名称和消息。然而,在实际应用中,我们可能需要添加更多的上下文信息,例如线程ID、文件名、行号等。

自定义日志格式可以通过设置格式器(Formatter)来实现。格式器的格式字符串由格式化选项和文字组成。下面是一个自定义日志格式的例子:

```python

import logging

# 创建一个日志格式器,添加时间戳、日志级别、记录器名称和消息

formatter = logging.Formatter('%(asctime)s - %(levelname)s - %(name)s - %(message)s')

# 创建一个日志处理器,并设置格式器

handler = logging.StreamHandler()

handler.setFormatter(formatter)

# 创建一个日志记录器

logger = logging.getLogger('my_logger')

logger.setLevel(logging.DEBUG)

# 将处理器添加到记录器中

logger.addHandler(handler)

# 记录日志

logger.debug("Debug message")

***("Information message")

logger.warning("Warning message")

logger.error("Error message")

logger.critical("Critical message")

```

在这个例子中,我们创建了一个格式器,并将其添加到处理器中。然后,我们创建了一个名为 'my_logger' 的记录器,并将处理器添加到这个记录器中。这样,我们就可以记录自定义格式的日志了。

通过本章节的介绍,我们可以看到,设置日志级别和自定义日志格式是 Python 日志管理中两个重要的高级配置。它们不仅可以帮助我们更好地控制日志的记录和输出,还可以提高日志信息的价值,使其更适合我们的应用程序和业务需求。

# 4. Python日志管理进阶技巧

## 4.1 日志管理的性能优化

在本章节中,我们将深入探讨如何优化Python的日志管理,以提高日志记录的性能。随着应用程序的规模扩大,日志记录可能会成为性能瓶颈。我们将讨论常见的性能瓶颈以及如何通过各种方法进行优化。

### 4.1.1 日志管理的性能瓶颈和优化方法

性能瓶颈通常发生在大量并发写入日志的情况下,尤其是在没有合理配置日志处理器(handlers)时。例如,如果所有的日志都写入同一个文件,而没有并发控制,那么写入操作可能会成为瓶颈。

为了优化性能,我们可以采取以下方法:

1. **异步日志记录**:使用异步日志记录器,如`concurrent-log-handler`,可以减少主线程的阻塞。

2. **日志分发**:将日志分散到不同的文件或服务器,减少单点的压力。

3. **缓冲日志记录**:使用缓冲区来暂时存储日志消息,并在特定条件下进行批量写入。

### 4.1.2 日志管理的最佳实践和案例分析

最佳实践通常包括以下几点:

- **合理配置日志级别**:避免记录不必要的日志信息,减少IO操作。

- **使用日志轮转**:定期轮转日志文件,以避免单个日志文件过大。

- **优化日志格式**:避免复杂的日志格式化操作,这可能会消耗额外的CPU资源。

以下是一个使用`concurrent-log-handler`实现异步日志记录的示例代码:

```python

import logging

import concurrent_log_handler

def setup_logging():

logger = logging.getLogger('async-logger')

logger.setLevel(***)

# 创建异步日志处理器

handler = concurrent_log_handler.ConcurrentRotatingFileHandler(

'myapp.log', maxBytes=1024*1024*5, backupCount=5)

# 创建日志格式器

formatter = logging.Formatter('%(asctime)s - %(name)s - %(levelname)s - %(message)s')

handler.setFormatter(formatter)

# 将处理器添加到记录器

logger.addHandler(handler)

return logger

# 使用示例

logger = setup_logging()

***('This is an info message')

```

在上述代码中,我们创建了一个异步日志处理器`ConcurrentRotatingFileHandler`,它会在内部使用线程池来处理日志消息,从而减少主线程的阻塞。

## 4.2 日志管理的安全性考虑

日志系统可能成为安全风险的一个点,因为它可能包含敏感信息。在本小节中,我们将讨论如何在日志管理中考虑安全性。

### 4.2.1 日志管理的安全风险和防范措施

常见的安全风险包括:

- **敏感信息泄露**:日志中可能包含敏感信息,如密码、密钥等。

- **日志被篡改**:未授权的用户可能篡改日志记录。

为了防范这些风险,我们可以采取以下措施:

1. **日志加密**:对存储在磁盘上的日志文件进行加密。

2. **访问控制**:限制对日志文件的访问权限。

3. **日志清洗**:在写入日志前,移除或脱敏敏感信息。

### 4.2.2 日志管理的安全最佳实践和案例分析

最佳实践包括:

- **定期审计日志**:定期检查日志文件,以发现任何异常行为。

- **使用安全传输**:当远程传输日志时,使用加密通道,如TLS/SSL。

以下是一个简单的示例,展示如何在日志格式化前移除敏感信息:

```python

import re

def sensitive_data_filter(record):

# 定义敏感信息的正则表达式

sensitive_patterns = [

r'password=\S+',

r'key=\S+'

]

for pattern in sensitive_patterns:

record.msg = re.sub(pattern, 'REDACTED', record.msg)

return True

# 配置日志记录器,添加过滤器

logger = logging.getLogger('security-logger')

logger.addFilter(sensitive_data_filter)

```

在这个示例中,我们定义了一个过滤器函数`sensitive_data_filter`,它会检查日志消息中的敏感信息,并将其替换为`REDACTED`。

## 4.3 日志管理的扩展和定制

在本小节中,我们将讨论如何根据特定需求定制和扩展Python的日志管理系统。

### 4.3.1 如何根据需求定制日志管理模块

定制日志管理模块通常涉及以下几个方面:

- **自定义日志格式器**:创建自定义的日志格式器,以满足特定的日志格式要求。

- **自定义处理器**:创建自定义的日志处理器,以实现特定的写入逻辑。

- **自定义过滤器**:创建自定义的日志过滤器,以实现特定的日志筛选逻辑。

### 4.3.2 如何扩展日志管理的功能和应用

扩展日志管理功能可以通过以下方式进行:

- **集成第三方库**:集成第三方日志管理库,以增加日志管理的功能。

- **创建日志管理插件**:创建可插拔的日志管理插件,以便在不同的项目中复用。

以下是一个自定义日志格式器的示例代码:

```python

import logging

class CustomFormatter(logging.Formatter):

def format(self, record):

original_format = super().format(record)

# 在原始格式化的日志消息前添加自定义信息

return f'[MYAPP] {original_format}'

# 使用示例

logger = logging.getLogger('custom-formatter-logger')

handler = logging.StreamHandler()

formatter = CustomFormatter()

handler.setFormatter(formatter)

logger.addHandler(handler)

***('This is a custom formatted log message')

```

在上述代码中,我们创建了一个自定义格式器`CustomFormatter`,它会在每条日志消息前添加`[MYAPP]`前缀。

# 5. Python日志管理的实际案例分析

## 5.1 日志管理在大型分布式系统中的应用

在大型分布式系统中,日志管理变得尤为重要,因为它可以帮助我们追踪和定位问题,尤其是在多个服务和组件协同工作时。例如,当一个用户报告了一个系统错误,我们可以通过日志来追踪这个错误是由于哪个服务引起的,以及它在整个请求链中的传播过程。

### 5.1.1 多服务日志关联分析

在分布式系统中,一个请求可能需要经过多个服务才能完成。每个服务都会产生自己的日志,因此,能够将这些分散的日志关联起来分析,对于问题定位至关重要。

#### 代码示例:使用 trace id 关联日志

```python

import logging

# 假设这是一个生成 trace id 的函数,用于关联不同服务的日志

def generate_trace_id():

# 实际应用中,trace id 可能来源于外部请求,例如 HTTP 请求头

return "trace-***"

# 设置日志格式,包含 trace id

formatter = logging.Formatter('%(asctime)s - %(name)s - %(levelname)s - %(message)s - %(trace_id)s')

# 配置日志

logger = logging.getLogger()

logger.setLevel(***)

handler = logging.FileHandler('service.log')

handler.setFormatter(formatter)

logger.addHandler(handler)

# 在日志中使用 trace id

trace_id = generate_trace_id()

logger = logging.LoggerAdapter(logger, {'trace_id': trace_id})

***("This is an info message")

# 在另一个服务中,可以复用相同的 ***

***("This is another info message in another service")

```

在这个例子中,我们通过 `logging.LoggerAdapter` 使用了一个额外的上下文信息 `trace_id` 来关联日志。这样,当我们在分布式系统中分析问题时,可以通过这个 `trace_id` 来追踪一个请求的所有日志。

### 5.1.2 日志收集和统一分析

在分布式系统中,各个服务的日志可能分散在不同的服务器上。因此,需要一个集中的日志管理平台来收集和统一分析这些日志。

#### 代码示例:使用 Fluentd 收集日志

```python

# Fluentd 配置文件示例

<system>

log_level error

</system>

<source>

@type http

port 8888

</source>

<match *.**>

@type file

path /var/log/fluentd-bundle日志

append true

</match>

```

在这个例子中,我们使用了 Fluentd 来收集和转发日志。Fluentd 是一个开源数据收集器,用于统一日志层。它允许你统一收集数据并将其发送到多个目的位置。这个配置文件定义了一个 HTTP 源,用于接收日志,并将其写入到文件系统。

### 5.1.3 日志查询和可视化

收集到的日志需要被查询和可视化,以便于我们快速定位问题。例如,使用 Elasticsearch、Kibana 和 Logstash(ELK)堆栈来存储、搜索和可视化日志。

#### 代码示例:使用 Elasticsearch 存储日志

```json

PUT /my_index/_doc/1

{

"message": "This is an info message",

"trace_id": "trace-***",

"@timestamp": "2023-04-01T00:00:00Z"

}

```

在这个例子中,我们演示了如何将一个包含 `trace_id` 的日志条目存储到 Elasticsearch 中。Elasticsearch 是一个基于 Lucene 的搜索引擎,它可以用来存储和检索大量结构化或非结构化的数据。

### 5.1.4 日志告警和通知

当检测到异常情况时,应该触发告警,并通知相关的运维或开发人员。例如,可以使用 Alertmanager 来设置告警规则,并将告警发送到 Slack 或 Email。

#### 代码示例:使用 Alertmanager 发送告警

```yaml

route:

receiver: 'webhook_receiver'

receivers:

- name: 'webhook_receiver'

webhook_configs:

- url: '***'

```

在这个例子中,我们配置了 Alertmanager 的 `route` 部分,指定了告警的接收者和发送方式。当告警被触发时,它将通过 HTTP POST 请求发送到 Slack 的 Webhook URL。

## 5.2 日志管理在微服务架构中的实践

在微服务架构中,日志管理同样面临挑战,但也有其独特的实践方式。下面我们将探讨如何在微服务架构中管理日志。

### 5.2.1 日志聚合和存储

由于微服务架构中服务众多,每个服务可能会产生大量日志。因此,需要一个有效的日志聚合和存储策略。

#### 代码示例:使用 Logstash 聚合日志

```conf

input {

kafka {

bootstrap_servers => "kafka1:9092,kafka2:9092,kafka3:9092"

topics => "mytopic"

codec => json

}

}

filter {

mutate {

add_field => { "service" => "myservice" }

}

}

output {

elasticsearch {

hosts => "elasticsearch:9200"

index => "logs-%{+yyyy.MM.dd}"

document_type => "%{type}"

}

}

```

在这个例子中,我们使用了 Logstash 从 Kafka 主题中读取日志数据,然后将其写入到 Elasticsearch 中。这个配置文件定义了一个从 Kafka 读取日志的 `input`,一个添加服务名称的 `filter`,以及一个写入 Elasticsearch 的 `output`。

### 5.2.2 服务间日志传递

在微服务架构中,服务间的调用是常见的。因此,需要一种方式在服务间传递日志。

#### 代码示例:使用 OpenTracing 传递日志

```python

from flask import Flask

from opentracing import Tracer, global_tracer

tracer = Tracer()

global_tracer.register(tracer)

app = Flask(__name__)

@app.route('/my-service')

def my_service():

span = tracer.start_span('my_service_operation')

# ... 执行操作 ...

span.log_event('my log message')

span.finish()

return 'OK'

if __name__ == '__main__':

app.run()

```

在这个例子中,我们使用了 OpenTracing 来传递日志。每个服务操作都会创建一个 Span,并在 Span 中记录日志事件。这样,日志就可以在服务间传递,并且可以在分布式追踪系统中查看。

### 5.2.3 日志分析和优化

微服务架构中的日志分析和优化也是至关重要的。通过分析日志,我们可以了解服务的健康状况、性能瓶颈和潜在问题。

#### 代码示例:使用 Prometheus 和 Grafana 进行日志分析

```yaml

scrape_configs:

- job_name: 'prometheus'

static_configs:

- targets: ['prometheus:9090']

```

在这个例子中,我们配置了 Prometheus 来收集监控数据,包括日志事件计数器。然后,我们可以使用 Grafana 来创建仪表板,可视化这些日志事件计数器。

## 5.3 日志管理在云原生环境中的应用

在云原生环境中,日志管理需要适应动态的资源分配和高可扩展性。

### 5.3.1 日志收集和分析

在云原生环境中,服务可能会在任何时间点被创建或销毁,因此需要一个能够在这些动态环境中工作的日志收集和分析系统。

#### 代码示例:使用 Fluentd 和 Kubernetes

```yaml

apiVersion: apps/v1

kind: DaemonSet

metadata:

name: fluentd-elasticsearch

namespace: kube-system

labels:

k8s-app: fluentd-logging

spec:

selector:

matchLabels:

name: fluentd-elasticsearch

template:

metadata:

labels:

name: fluentd-elasticsearch

spec:

tolerations:

- key: node-role.kubernetes.io/master

effect: NoSchedule

containers:

- name: fluentd-elasticsearch

image: quay.io/fluentd_elasticsearch/fluentd:v2.5.2

resources:

limits:

memory: 200Mi

requests:

cpu: 100m

memory: 200Mi

volumeMounts:

- name: varlog

mountPath: /var/log

- name: varlibdockercontainers

mountPath: /var/lib/docker/containers

readOnly: true

terminationGracePeriodSeconds: 30

volumes:

- name: varlog

hostPath:

path: /var/log

- name: varlibdockercontainers

hostPath:

path: /var/lib/docker/containers

```

在这个例子中,我们使用了 Kubernetes 的 DaemonSet 来部署 Fluentd,它将日志从容器的日志文件中收集,并将其发送到 Elasticsearch。这个配置文件定义了一个 DaemonSet,它在每个节点上运行一个 Fluentd Pod。

### 5.3.2 日志存储和保留策略

在云原生环境中,日志存储成本也是一个考虑因素。因此,需要有一个合理的日志保留策略,以便于保留重要的日志数据,同时删除不再需要的日志。

#### 代码示例:使用 Elasticsearch 的索引生命周期管理

```yaml

policy:

phases:

hot:

actions:

rollover:

max_age: 7d

max_size: 10gb

delete:

actions:

delete:

age: 30d

```

在这个例子中,我们配置了 Elasticsearch 的索引生命周期管理策略,设置了在索引超过 7 天或达到 10GB 时进行滚动,在索引超过 30 天时删除。

### 5.3.3 日志安全和合规性

在云原生环境中,还需要考虑日志的安全性和合规性。例如,需要确保敏感数据不会被错误地记录到日志中。

#### 代码示例:使用 Fluentd 的过滤器过滤敏感数据

```conf

<filter my_service.**>

@type record_transformer

enable_ruby true

<record>

message "[FILTERED] - ${record['message']}"

</record>

</filter>

```

在这个例子中,我们使用了 Fluentd 的 `record_transformer` 过滤器来过滤掉敏感信息,将其替换为 `[FILTERED]`。这个配置文件定义了一个过滤器,它会在日志消息中标记敏感信息。

### 5.3.4 日志自动化和弹性

在云原生环境中,日志管理需要自动化和弹性,以便于在动态的环境中保持高效和可靠。

#### 代码示例:使用 Ansible 自动化部署 Fluentd

```yaml

- hosts: all

tasks:

- name: Install Fluentd

yum:

name: td-agent

state: present

```

在这个例子中,我们使用了 Ansible 来自动化部署 Fluentd。这个 playbook 定义了一个任务,它会在所有主机上安装 Fluentd。

通过以上分析和代码示例,我们可以看到,在不同的应用场景中,Python 日志管理有着广泛的应用和实践。无论是大型分布式系统、微服务架构,还是云原生环境,有效的日志管理都是确保系统稳定性和可维护性的关键。

0

0