数据预处理:Anaconda环境下的数据清洗与数据库连接

发布时间: 2024-12-09 23:55:26 阅读量: 17 订阅数: 15

预支工资申请书.doc

# 1. 数据预处理概述

在数据科学项目中,数据预处理是关键的第一步,它影响着后续分析的准确性和效率。良好的数据预处理可以为数据建模提供更加准确和可靠的数据基础,是数据科学成功的关键之一。在本章节中,我们将简要介绍数据预处理的概念、重要性和基本流程,为后续章节中将介绍的技术和工具奠定基础。

## 1.1 数据预处理的重要性

数据预处理是数据挖掘和分析流程中的必经之路。在原始数据中,往往存在着诸多问题,如缺失值、异常值、重复记录等,这些问题都可能对分析结果造成负面影响。因此,在进行数据分析前,必须对数据进行预处理,从而提高数据质量,为模型训练和决策支持提供更准确的输入。

## 1.2 数据预处理的目标与流程

数据预处理的目标是通过一系列的数据清洗、转换和归约技术,将原始数据转换为适合进行分析的格式。基本流程通常包括数据清洗(处理不一致、缺失和异常数据)、数据集成(合并来自多个数据源的数据)、数据转换(规范化、归一化等)和数据归约(降低数据规模但保持数据特征)。这一流程不是一次性的,而是需要根据数据和项目需求反复迭代的。

## 1.3 数据预处理的应用领域

数据预处理的应用领域广泛,包括但不限于商业智能、市场分析、客户关系管理、医疗诊断、金融分析等。在这些领域中,通过有效的数据预处理可以揭示数据中的模式,增强模型的预测能力,从而为决策提供坚实的数据支持。随着数据量的增加和数据复杂度的提升,对数据预处理的要求也随之提高。

# 2. Anaconda环境配置与管理

Anaconda是一个开源的Python发行版本,它为科学计算及数据分析提供了强大的环境配置和包管理功能。通过它,用户可以方便地创建独立的Python环境,安装和管理各种包和库,而且它还包含了一系列数据科学中常用的科学计算和分析工具。接下来我们将深入了解Anaconda的安装与配置,虚拟环境的创建和管理,以及使用Anaconda中的包管理器Conda进行包的安装与更新,最后介绍Jupyter Notebook的基本使用方法。

### 2.1 Anaconda安装与配置

#### 2.1.1 安装Anaconda

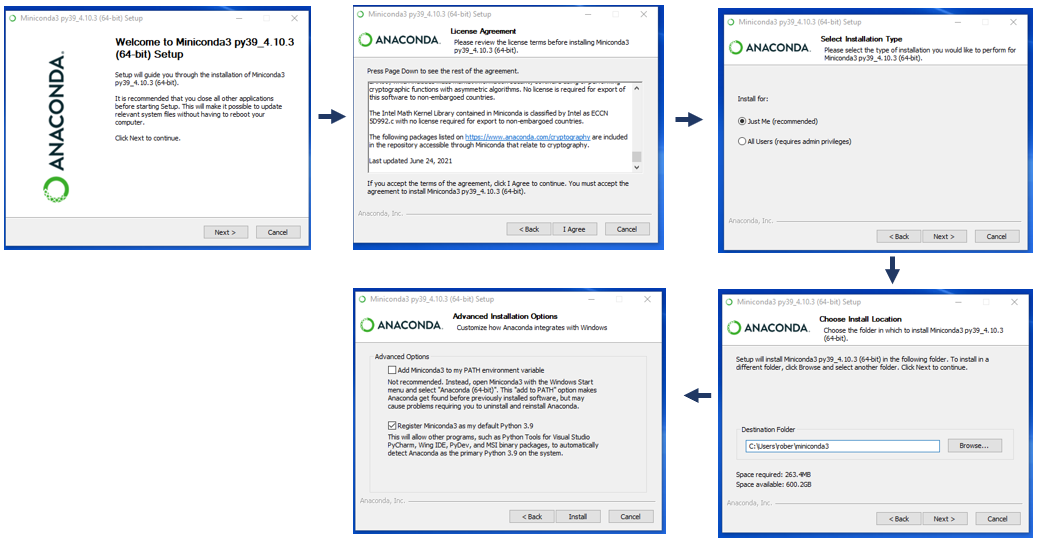

Anaconda的安装过程较为简单,适合各类操作系统。以下是基本的安装步骤:

1. 访问Anaconda官方网站下载对应的安装包。

2. 根据操作系统的不同,选择对应的安装程序进行安装。例如,在Windows系统上,双击下载的`.exe`文件,然后根据向导完成安装;在Mac或Linux系统上,运行下载的`.sh`或`.bash`脚本文件。

安装完成后,你需要确认Anaconda环境是否安装成功,可以在命令行或终端中输入`conda list`查看已安装的包列表。

#### 2.1.2 创建与管理虚拟环境

在进行Python项目开发时,常常需要在同一台机器上同时管理多个项目,每个项目依赖的包版本可能会有所不同。为避免包版本冲突,需要为每个项目创建独立的虚拟环境。

使用Conda创建虚拟环境的命令如下:

```bash

conda create -n myenv python=3.8

```

这里`myenv`是虚拟环境的名称,`python=3.8`指定了要安装的Python版本。创建虚拟环境后,可以通过以下命令激活环境:

```bash

conda activate myenv

```

在虚拟环境中,你可以使用`conda install`命令安装任何包,这些安装的包只会存在于当前虚拟环境中,不会影响到系统中的其他Python环境。

### 2.2 Anaconda中的包管理

#### 2.2.1 Conda包管理器简介

Conda是一个开源的包管理系统和环境管理系统,可以快速安装、运行和更新包和环境。Conda可以安装许多科学包,包括NumPy、SciPy、Pandas、Matplotlib和IPython等。

Conda的命令行工具提供了丰富的选项来管理包和环境:

- `conda search <package>`:搜索包。

- `conda install <package>`:安装包。

- `conda update <package>`:更新包。

- `conda remove <package>`:移除包。

- `conda list`:列出当前环境的包。

#### 2.2.2 常用数据分析包的安装与更新

在数据科学领域,有一些常用的数据处理和分析包,如Pandas、NumPy、SciPy等。使用Conda来安装这些包非常方便:

```bash

conda install pandas numpy scipy

```

需要注意的是,有时候Conda默认安装的包可能不是最新版本。这时,可以使用`conda update`命令更新特定包:

```bash

conda update pandas

```

### 2.3 Jupyter Notebook使用基础

#### 2.3.1 Jupyter Notebook简介

Jupyter Notebook是一个开源的Web应用程序,允许创建和共享包含实时代码、方程、可视化和文本的文档。它非常适合进行数据分析、机器学习等工作。

#### 2.3.2 编写和运行代码单元

打开Jupyter Notebook后,会看到一个全新的笔记本页面。你可以通过“File -> New Notebook”创建一个新的笔记本,然后开始编写和运行代码单元。代码单元默认类型是“Code”,你可以在其中输入Python代码:

```python

print("Hello, Jupyter!")

```

接着,通过按下`Shift`+`Enter`来运行代码单元。这将执行代码,并在下面显示输出结果。

#### 2.3.3 Notebook的高级功能

Jupyter Notebook不仅仅是一个代码执行环境,它还支持包括Markdown文本、图像、视频以及公式等多种类型的单元格,使得Notebook既可以作为代码开发的工具,也可以作为展示和分享数据科学项目的载体。你可以通过“Insert -> Insert Cell Above/Below”来在Notebook中插入新的单元格,并选择单元格类型。

Notebook的这些高级功能使得其在数据科学领域大受欢迎。它使得开发者可以一边编写代码,一边对算法、数据处理过程进行说明,这对于团队协作和项目演示非常有帮助。

通过上述章节内容,我们可以看到Anaconda环境配置和管理的重要性,以及如何通过它来高效地管理Python环境和包。同时,Jupyter Notebook作为数据分析和机器学习领域中不可或缺的工具,其便捷性和灵活性也得到了充分展现。这些工具和技能构成了数据预处理的基础,为后续的数据清洗、数据库交互等环节提供了坚实的技术支持。

# 3. 数据清洗技术详解

在面对原始数据时,第一步往往是对数据进行清洗,以确保数据的质量和准确性。高质量的数据是进一步分析、挖掘和建模的基础,因此数据清洗成为了数据科学领域的一个关键步骤。数据清洗不仅仅是技术操作,更是一门艺术,需要精心设计和实施以适应特定的数据集和业务需求。本章将深入探讨数据清洗的理论基础、常用的数据清洗操作,以及通过具体案例来分析数据清洗的应用实践。

## 3.1 数据清洗的理论基础

### 3.1.1 数据质量的重要性

数据质量是数据分析和决策的基础,它直接影响到最终结果的准确性和可信度。质量低下的数据会带来很多问题,如分析结果的偏差、决策失误,甚至可能对业务造成重大的负面影响。因此,在数据科学项目中,数据清洗成为了至关重要的一个环节。它不仅帮助我们剔除错误、异常和不一致性,还能提高数据的完整性、准确性和可靠性,为后续的分析工作铺平道路。

### 3.1.2 数据清洗流程概览

数据清洗是一个迭代和逐步细化的过程,通常包含以下几个基本步骤:

- 识别并处理缺失数据

- 检测并处理异常值

- 标准化数据格式和单位

- 清除重复数据

- 解析并整合来自不同来源的数据

在深入操作之前,我们需要理解数据的来源、结构和业务含义,以便更有效地执行清洗操作。数据清洗不是一次性的任务,而是需要不断地复核和更新,以应对数据随着时间推移而可能出现的任何变化。

## 3.2 常用数据清洗操作

### 3.2.1 缺失值处理

在数据集中,缺失值是一个常见的问题。缺失值可能因为多种原因产生,例如数据收集不完整、数据传输错误或数据录入错误。对于缺失值的处理,常见的方法有以下几种:

- 删除含有缺失值的记录

- 用其他值(如均值、中位数或众数)填充缺失值

- 使用插值方法(如线性插值、多项式插值)估计缺失值

- 利用模型预测缺失值

选择哪种方法取决于数据的性质和项目的具体需求。例如,在医学研究中,缺失值可能具有重要的意义,因此不能简单地删除或使用均值替代。在这种情况下,可以考虑使用插值或者建模预测的方法来处理缺失值。

### 3.2.2 异常值检测与处理

异常值是那些显著偏离其他观测值的数据点。异常值可能是由于数据录入错误、测量错误或真正的异常现象。检测异常值通常涉及使用统计方法或数据可视化。以下是一些常用的技术:

- 利用箱线图来识别异常值

- 使用标准差和均值来识别离群点

- 利用聚类算法来识别离群的群组

异常值的处理方式需要根据其性质和研究目的来决定。一种方法是直接移除异常值,但是这可能丢失了重要的信息。因此,一些替代的方法如对异常值进行修正、使用鲁棒性统计方法、或者对含有异常值的数据点进行特别的标记也是值得考虑的。

### 3.2.3 数据格式转换与标准化

数据常常以多种格式存在,为了便于分析,需要将数据转

0

0