数据清洗与归一化:揭秘数据预处理的7个最佳实践

发布时间: 2024-11-19 22:49:36 阅读量: 20 订阅数: 32

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 1. 数据预处理简介

在当今数据驱动的世界,数据预处理是机器学习和数据挖掘项目的基石。数据预处理包括数据清洗、数据转换、数据归一化等步骤,目的是从原始数据集中提取有意义的信息,并将数据转换为一种适合分析的形式。本章将为读者提供数据预处理的基本概述,帮助读者理解为什么这个步骤在构建高效模型之前至关重要。

数据预处理不仅包括技术层面的处理,还涉及到理解数据的业务背景,从而制定出最适合数据的策略。本章将引导读者了解数据预处理的重要性,并为接下来章节中将详细探讨的数据清洗、归一化技术、数据增强以及自动化工具等话题打下基础。通过本章的学习,读者将获得一个全面的视角,从而能够更深入地探索数据预处理在各种实际应用中的重要性。

# 2. 数据清洗的策略

## 2.1 数据清洗概述

### 2.1.1 数据清洗的定义和重要性

数据清洗是数据预处理的一个关键步骤,其目的在于识别并纠正或删除数据集中不准确、不完整、无关或格式不一致的数据。良好的数据清洗不仅可以提高数据质量,还能显著提升后续数据分析和机器学习模型的性能。

在数据挖掘的生命周期中,数据清洗占据至关重要的地位。由于原始数据往往来自不同渠道,包含大量的噪声、异常和缺失值,这会导致分析结果产生偏差,甚至误导决策。通过清洗数据,我们能够:

- 提升数据的准确性和一致性。

- 减少数据集中的噪声和异常值。

- 增强数据的可用性和分析的可靠性。

### 2.1.2 数据清洗流程概览

数据清洗的流程大致可以分为以下几个步骤:

1. 数据收集:从各种数据源获取数据。

2. 数据审查:对数据进行初步检查,发现潜在问题。

3. 数据清洗:具体处理数据中发现的问题,包括缺失值、异常值、重复记录等。

4. 数据验证:确保数据清洗后符合预期目标和质量标准。

5. 数据集成:将清洗后的数据与其他数据集合并。

## 2.2 缺失值处理

### 2.2.1 缺失值的识别

在数据集中,缺失值通常是指那些没有被记录或者记录不完整的数据点。缺失值可能是由于数据输入错误、硬件故障、人为疏忽等原因造成。识别缺失值通常可以使用编程语言中的函数或库来帮助实现,例如在Python中使用`pandas`库中的`isnull()`或`notnull()`函数。

### 2.2.2 缺失值的填充策略

处理缺失值的一种常见方法是填充(Imputation),即将缺失值替换为其他值。填充策略分为多种:

- 使用均值、中位数或众数填充连续型变量的缺失值。

- 使用模型预测缺失值,如使用其他变量建立模型来预测缺失值。

- 使用固定值,如将年龄的缺失值填充为平均年龄。

### 2.2.3 缺失值的删除策略

在某些情况下,如果缺失值的比例较低或者缺失值的分布不规则,我们可能会选择删除含有缺失值的记录。删除策略包括:

- 列删除:删除包含缺失值的整个列。

- 记录删除:删除含有缺失值的整条记录。

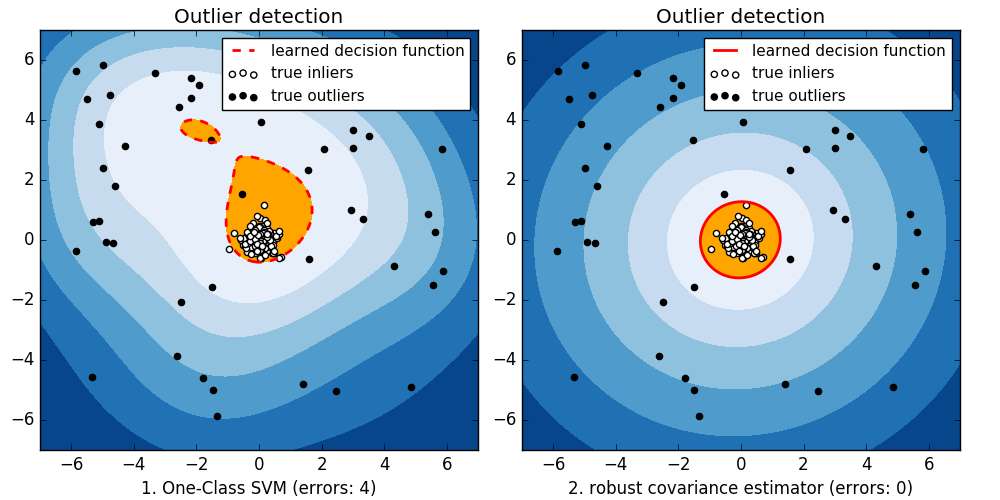

## 2.3 异常值处理

### 2.3.1 异常值的检测方法

异常值指的是那些与大部分数据显著不同的数据点。检测异常值的方法很多,常见的包括:

- 箱形图分析:通过箱形图可以直观地看到数据的分布情况和可能的异常值。

- 统计分析:利用标准差、IQR(四分位距)等统计量来识别异常值。

### 2.3.2 异常值的处理策略

处理异常值的策略同样多样:

- 简单剪裁:将异常值替换为最大或最小值。

- 聚类分析:将异常值视为噪声从数据集中移除。

- 变换数据:对数据进行转换,比如对数转换或平方根转换,使异常值不那么突出。

### 2.3.3 应对异常值的案例分析

为了更深入了解异常值处理的实际应用,可以举一个案例分析。假设我们有一组销售数据,通过分析发现,某些天的销售量异常高或低,可能是由于系统错误或者特殊事件导致。

- 检测:使用箱形图和标准差进行异常值检测。

- 分析:通过业务逻辑验证这些异常值是否为真实情况。如果确认是错误数据,可进行调整。

- 处理:应用适当的策略处理异常值,比如用中位数替换极端的异常值。

```python

import pandas as pd

from sklearn.impute import SimpleImputer

from sklearn.preprocessing import StandardScaler

# 模拟含有缺失值和异常值的数据集

data = pd.DataFrame({

'Sales': [100, 200, 150, 500, 120, 10, 140, 160]

})

# 检测并处理缺失值

imputer = SimpleImputer(strategy='mean')

data_imputed = imputer.fit_transform(data[['Sales']])

# 处理异常值,这里采用简单剪裁策略

Q1 = data['Sales'].quantile(0.25)

Q3 = data['Sales'].quantile(0.75)

IQR = Q3 - Q1

lower_bound = Q1 - 1.5 * IQR

upper_bound = Q3 + 1.5 * IQR

# 剪裁异常值

data['Sales'] = data['Sales'].clip(lower_bound, upper_bound)

```

在上述Python代码中,我们使用`SimpleImputer`进行缺失值填充,采用均值填充策略;使用`quantile`和`clip`方法处理异常值,实现简单的剪裁策略。数据清洗后,我们会得到一个更为干净、整洁的数据集,为进一步的数据分析和建模打下坚实基础。

# 3. 数据归一化的技术

## 3.1 归一化的概念和类型

### 3.1.1 归一化的定义及其重要性

归一化是数据预处理中的一个重要环节,它的主要目的是将特征数据缩放到一个特定的范围,从而消除不同特征之间量纲的影响,使数据具有可比性。这一步骤对于很多机器学习算法尤为重要,尤其是在基于距离计算或梯度下降的算法中,如k-最近邻(k-NN)、支持向量机(SVM)和神经网络等。归一化后的

0

0