Python爬虫中的数据去重与数据合并方法探讨

发布时间: 2024-04-16 11:12:43 阅读量: 107 订阅数: 40

# 1. Python爬虫基础概念

Python爬虫是一种自动化提取互联网信息的技术,对于需要大量数据的业务具有重要意义。通过Python爬虫,可以快速获取网页上的信息,进行数据分析和挖掘。无论是爬取网页内容、监控网站变化还是进行数据分析挖掘,Python爬虫都能发挥巨大作用。

Python爬虫广泛应用于网络搜索引擎、电商数据抓取、金融数据分析等场景,为各行业提供了强大的数据支持。掌握Python爬虫技术,能够帮助企业获得竞争优势,实现数据驱动决策。因此,学习Python爬虫是每个数据科学家或者项目开发者的必备技能之一。在本章节中,我们将深入探讨Python爬虫的基础概念,为后续内容铺设基础。

# 2. 数据去重技术

### 2.1 什么是数据去重

数据去重是指在数据处理过程中,去除重复的数据,保证数据的唯一性。在数据处理和分析中,经常会遇到大量重复数据,去重可以提高数据处理效率,减少资源浪费。

### 2.2 基于哈希算法的数据去重方法

#### 2.2.1 介绍哈希算法

哈希算法是一种将任意长度的输入通过哈希函数转换为固定长度输出的算法。其特点是相同的输入一定得到相同的输出,不同的输入尽可能得到不同的输出。

#### 2.2.2 使用哈希算法进行数据去重的步骤

1. 创建一个哈希表用于存储数据的哈希值。

2. 遍历数据集,对数据进行哈希计算。

3. 将计算得到的哈希值与哈希表中已有的值进行比较,若已存在则视为重复数据。

4. 将不重复的数据存入结果集中。

#### 2.2.3 哈希算法的优缺点分析

优点:

- 快速识别重复数据,适用于大数据场景。

- 基于哈希值比较,不需要比较整个数据,节省计算资源。

缺点:

- 可能存在哈希冲突,导致数据误判。

- 哈希算法对输入数据敏感,微小的数据变化可能导致不同的哈希值。

### 2.3 基于集合的数据去重方法

#### 2.3.1 介绍集合数据结构

集合是一种无序且元素唯一的数据结构,可以高效地进行成员检查和添加操作。在数据去重中,可以利用集合的特性快速识别重复元素。

#### 2.3.2 使用集合进行数据去重的步骤

1. 将数据集转换为集合类型。

2. 遍历原始数据,逐个添加到集合中。

3. 由于集合的元素唯一性特性,重复数据会被自动去重。

4. 最终将去重后的数据从集合中提取出来。

#### 2.3.3 集合数据去重的性能分析

优点:

- 集合的元素唯一性特性保证了高效的去重过程。

- 集合底层采用哈希表存储,查找效率高。

缺点:

- 集合在数据量非常大时,需要消耗大量内存。

- 集合无法保持数据原有顺序,适用于不要求顺序的去重场景。

以上是关于数据去重方法的基于哈希算法和集合的介绍及分析。

```python

# 示例代码:使用集合进行数据去重

data = [1, 2, 2, 3, 4, 3, 5]

unique_data = list(set(data))

print(unique_data) # [1, 2, 3, 4, 5]

```

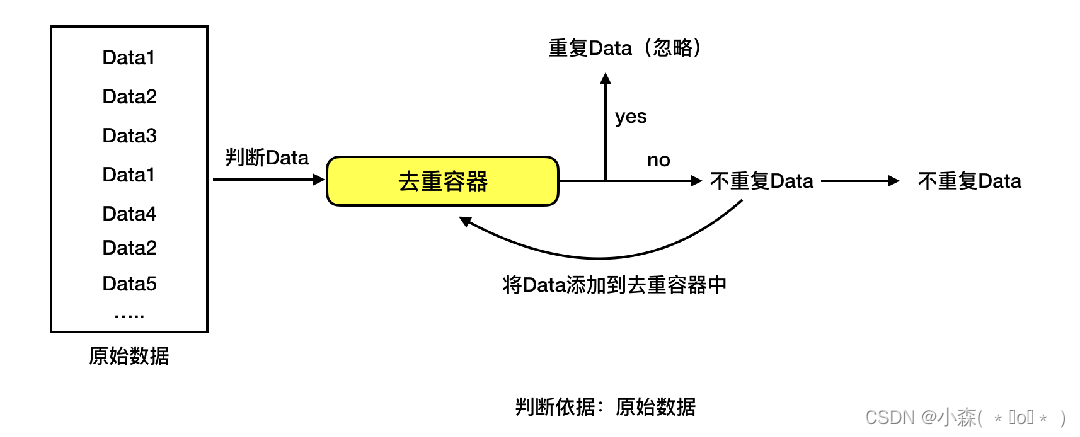

流程图示意:

0

0