【异常管理】:MapReduce Join操作的错误处理与异常控制

发布时间: 2024-10-31 13:16:10 阅读量: 30 订阅数: 23

Hive常见异常处理.docx

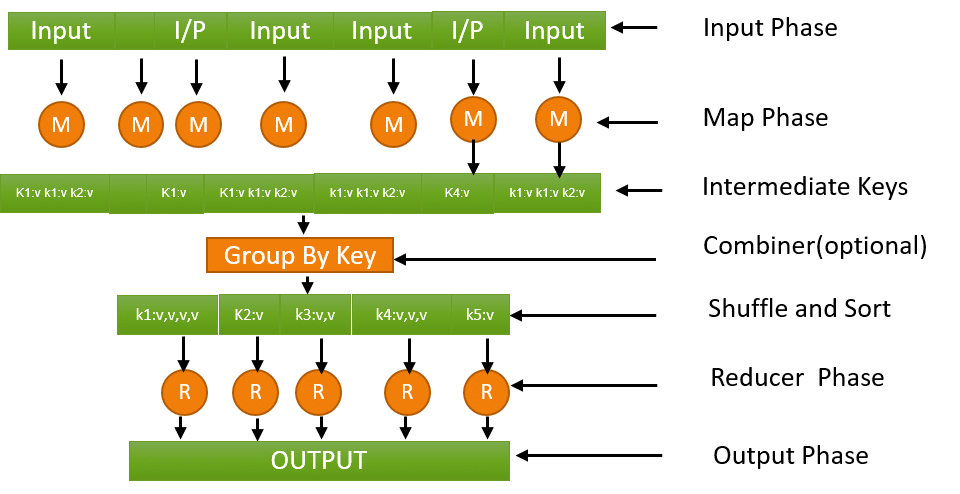

# 1. MapReduce Join操作基础

MapReduce是一种广泛使用的编程模型,用于在分布式系统上处理和生成大数据集。在MapReduce的场景中,Join操作是一个重要的数据处理手段,它将多个数据集的相关信息通过键值连接起来。本章将从MapReduce Join操作的基本概念入手,讨论在分布式环境中进行数据连接的必要条件,并探索适用于各种数据集规模的Join策略。

## 1.1 MapReduce Join操作简介

在MapReduce框架中,Join操作是一种常见的数据关联操作,它类似于关系数据库中的JOIN查询。Join操作的主要目的是根据共同的键值将不同来源的数据集进行合并,以此来增加数据的关联性并提供更多的业务洞察。在分布式计算的上下文中,Join操作可能比传统的数据库查询更加复杂,因为它需要对分布在不同节点上的数据进行有效整合。

## 1.2 实现Join操作的两种基本策略

为了执行Join操作,MapReduce提供了几种策略,最基础的两种是Reduce-side Join和Map-side Join。

### Reduce-side Join

在Reduce-side Join中,所有参与Join的输入数据集会先经过Map阶段处理,然后通过自定义的Partitioner将数据分配到Reduce任务。在这个策略中,Map阶段对数据进行洗牌(shuffle),将相同键值的数据分配到同一个Reducer,之后在Reduce阶段将这些数据合并。

```java

// Reduce-side Join伪代码示例

public class MyReducer extends Reducer<Text, Text, Text, Text> {

public void reduce(Text key, Iterable<Text> values, Context context) throws IOException, InterruptedException {

for (Text value : values) {

context.write(key, value);

}

}

}

```

### Map-side Join

Map-side Join则适用于数据集之一非常小,可以被载入到内存中的情况。在Map阶段,较小的数据集会被预先加载到Map任务的内存中,并与输入数据集进行连接操作。由于不需要Shuffle和Reduce阶段,Map-side Join通常执行速度更快,但适用场景较为有限。

```java

// Map-side Join伪代码示例

public class MyMapper extends Mapper<LongWritable, Text, Text, Text> {

private Map<String, String> rightSideData = new HashMap<>();

public void setup(Context context) {

// 加载小数据集到内存

rightSideData.putAll(loadSmallDataset());

}

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// 假设value是包含键值对的行

String[] parts = value.toString().split(",");

String keyFromRight = parts[0];

String valueFromRight = parts[1];

String valueFromLeft = parts[2];

// 执行Join

context.write(new Text(keyFromRight), new Text(valueFromRight + valueFromLeft));

}

}

```

在下一章中,我们将深入探讨在MapReduce Join操作中可能出现的各种异常类型,并了解如何检测和处理这些异常情况。

# 2. MapReduce Join操作中可能出现的异常类型

## 2.1 数据层面的异常

### 2.1.1 数据不一致性问题

在MapReduce Join操作中,数据不一致性是一个常见的问题。由于数据可能来自于不同的数据源,或者在数据传输过程中出现错误,导致数据在多个表中的同一字段值不相同。这种不一致可能发生在数据类型、数据格式、数据范围等方面。

要解决数据不一致性问题,首先需要进行数据清洗。使用MapReduce的Mapper和Reducer进行数据预处理,通过自定义逻辑来发现和处理数据冲突。其次,还可以在数据入库前,设立一个数据校验机制,确保数据质量符合预设标准。以下是一个简单示例代码:

```java

public class DataConsistencyMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// 假设value中包含的是一行数据,通过split方法拆分成不同字段

String[] fields = value.toString().split(",");

for (String field : fields) {

// 这里可以添加自定义的数据一致性校验逻辑

if (isConsistent(field)) {

context.write(new Text(field), new IntWritable(1));

}

}

}

private boolean isConsistent(String field) {

// 自定义一致性校验逻辑

// ...

return true; // 假设字段满足一致性条件

}

}

```

### 2.1.2 数据缺失与重复问题

数据缺失通常指的是某些重要的字段值为空,而数据重复则指相同的数据在多个地方出现。在数据量庞大的MapReduce任务中,这两种问题可能会导致数据处理出现错误。

对于数据缺失,可以在MapReduce的Mapper阶段添加过滤逻辑,对于关键字段为空的数据直接忽略。而数据重复问题则可以在Reducer阶段通过聚合数据来解决。一个典型的代码示例如下:

```java

public class DataRedundancyReducer extends Reducer<Text, IntWritable, Text, NullWritable> {

private Set<String> seenRecords = new HashSet<>();

public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

for (IntWritable val : values) {

// 拼接关键字段作为检查重复的依据

String checkStr = key.toString() + val.get();

if (!seenRecords.contains(checkStr)) {

seenRecords.add(checkStr);

context.write(key, NullWritable.get());

}

}

}

}

```

## 2.2 系统层面的异常

### 2.2.1 资源不足与超时

MapReduce任务在执行过程中,可能会由于集群资源不足或配置不当导致任务执行超时。资源不足主要指的是CPU、内存、磁盘I/O等硬件资源的短缺,而超时则可能是因为程序设计不当导致的。

针对资源不足,可以通过集群资源管理器对资源进行优化配置,确保作业有足夞的资源来执行。例如,在Hadoop中,可以通过调整`yarn.nodemanager.resource.memory-mb`参数来增加内存分配。对于超时问题,则需要对MapReduce作业进行性能分析,找出瓶颈,优化代码逻辑,减少不必要的计算或I/O操作。

### 2.2.2 硬件故障与网络问题

MapReduce作业可能因为集群中的硬件故障或网络问题导致任务失败。硬件故障包括硬盘损坏、内存故障等,而网络问题可能涉及到网络延迟或中断。

解决这些问题通常需要借助于集群的高可用性配置。例如,在Hadoop集群中,可以

0

0