【挑战与机遇】:大数据环境下MapReduce Join操作的应对策略

发布时间: 2024-10-31 12:15:39 阅读量: 14 订阅数: 17

# 1. MapReduce Join操作简介

## 1.1 MapReduce Join基本概念

MapReduce是一种编程模型,用于大规模数据集的并行运算。在MapReduce中,Join操作用于合并两个或多个数据集,它在数据处理中扮演着核心角色。Join操作将不同数据集中的相关数据组合在一起,以便对它们进行分析。理解MapReduce的Join操作是构建复杂数据处理流程的关键步骤。

## 1.2 为什么需要MapReduce Join

在大规模数据处理中,数据往往分散在多个文件或数据源中。因此,为了进行高效的数据分析,需要将这些数据整合到一起。MapReduce Join能够处理跨不同数据源的数据集,并且在分布式环境下执行,支持海量数据的高效并行处理。这一特性使得Join操作在大数据处理领域变得极为重要。

## 1.3 MapReduce Join操作的常见用途

MapReduce Join通常用于数据仓库的ETL(提取、转换、加载)过程、数据库数据集成、日志分析和复杂查询处理等场景。通过将来自不同源的数据联合起来,企业可以进行统一的数据分析和决策支持。而随着大数据技术的发展,MapReduce Join操作的效率和可扩展性需求也日益增长。

# 2. MapReduce Join理论基础

### 2.1 MapReduce框架下的Join机制

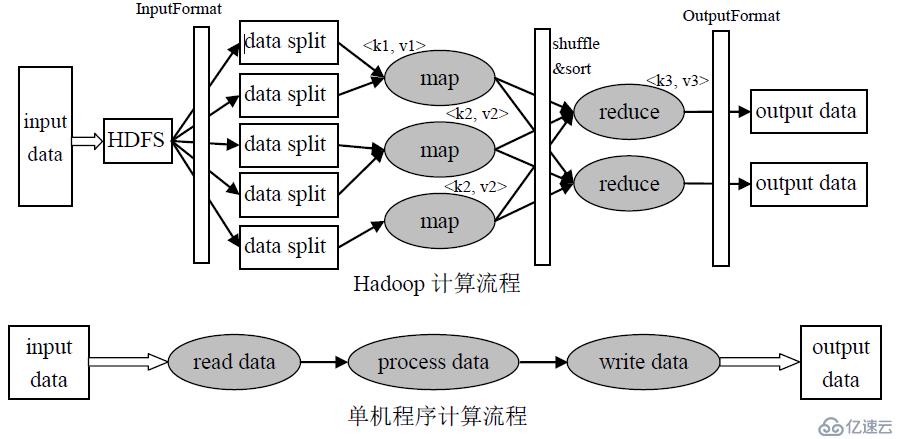

MapReduce是一个分布式计算框架,用于处理大规模数据集。其核心思想是将任务分解成小块的数据,并行处理,最后合并结果。在Join操作中,MapReduce通过将不同数据集分配给多个Mapper和Reducer来实现不同数据集之间的连接。

#### 2.1.1 基本原理和Join分类

在MapReduce中,Join操作可以分为几种类型,包括Reduce Join和Map-Side Join。

- **Reduce Join**:这是最常见的Join方式,在Map阶段将数据按键(key)进行分区和排序,然后在Reduce阶段将具有相同键的数据合并在一起,实现Join操作。这种方式适用于任何大小的数据集,但可能会导致大量的数据在Reduce阶段交换,增加网络负载和处理时间。

- **Map-Side Join**:这种方法适用于当一个数据集相对较小,可以被加载到每个Mapper节点的内存中时。在Map阶段,小数据集会在内存中构建一个索引,然后Mapper遍历大数据集,并使用内存中的索引快速查找与之匹配的记录,从而完成Join操作。Map-Side Join可以显著减少数据在网络中的传输,提高处理效率。

#### 2.1.2 理论性能分析和适用场景

在选择Join类型时,需要考虑数据集的大小、网络带宽、可用内存等因素。

- **Reduce Join**:通常适用于数据集大小相似的情况,因为它在Reduce阶段进行数据合并,所以对于大数据量来说网络传输和处理开销较大。

- **Map-Side Join**:对于大数据集与小数据集的Join操作效率较高,但要求小数据集可以完全加载到内存中,适用于数据倾斜较为严重的情况。

### 2.2 Join操作中的数据倾斜问题

数据倾斜是分布式计算中常见的问题,指的是数据在节点间的分布极度不均匀,导致某些节点处理的数据量远大于其他节点。

#### 2.2.1 数据倾斜的成因和影响

数据倾斜的原因多种多样,比如数据本身的分布不均、不合适的分区策略等。数据倾斜对Join操作的影响巨大,可能导致某些节点处理时间过长,造成整个作业的延迟。

- **成因**:数据倾斜可能是由于数据本身特性导致的,比如某些键的数量远大于其他键。也可能是由于MapReduce的默认分区函数导致的,它基于哈希值分配键到不同的Reducer,对于分布不均匀的数据,会导致数据倾斜。

- **影响**:数据倾斜导致某些Reducer节点的负载远高于其他节点,造成作业执行时间不均衡,严重的会导致作业失败。因此,识别并解决数据倾斜问题是优化Join操作的关键。

#### 2.2.2 理论上的解决策略和最佳实践

解决数据倾斜问题可以采取多种策略,包括但不限于重新分区、数据预处理和使用自定义分区器。

- **重新分区**:通过重新设计键值,使得数据能够更均匀地分配到各个Reducer节点。这可以通过增加键的随机前缀来实现,使原本聚集的数据分散开来。

- **数据预处理**:在数据进入MapReduce之前,使用预处理步骤对数据进行重分布。这可能包括对数据进行抽样、过滤或使用自定义的哈希函数来改变数据分布。

- **自定义分区器**:MapReduce允许开发者实现自定义的分区器来控制数据在Reducer间的分配。开发者可以根据数据的实际情况设计分区策略,以避免数据倾斜。

### 2.3 大数据环境下Join的优化理论

优化Join操作是提高大数据处理性能的关键步骤。优化可以从索引技术、数据预处理、并行处理和内存管理等多个维度进行。

#### 2.3.1 索引技术和数据预处理

索引技术可以极大地提升查询效率,尤其在需要频繁Join操作的场景下。索引可以预构建,也可以动态生成。

- **索引技术**:使用B树或哈希表等数据结构构建索引可以加速查找过程。对于大数据集,索引的构建和维护可能会消耗较多资源,因此需要权衡其成本和查询性能的提升。

- **数据预处理**:数据预处理包括数据清洗、去重、格式化等步骤,可以去除不必要的数据或者将数据转换为适合Join操作的格式。预处理可以在数据加载到MapReduce之前完成,或者在Map阶段进行。

#### 2.3.2 并行处理和内存管理优化

优化并行处理和内存管理可以提升Join操作的效率。

- **并行处理**:合理分配任务给多个Mapper和Reducer,并行执行可以显著提高处理速度。同时,平衡每个节点的任务负载,避免因个别节点过载而导致性能瓶颈。

- **内存管理**:调整内存大小和管理策略,可以防止内存溢出和频繁的磁盘交换。优化包括增加JVM堆大小、使用内存存储中间结果和合理配置垃圾收集器等。

```java

// 示例:Java代码片段,展示如何在MapReduce中调整内存管理参数

public static void main(String[] args) {

Configuration conf = getConf();

// 设置JVM堆大小

conf.set("mapreduce.map.java.opts", "-Xmx4096m");

conf.set("mapreduce.reduce.java.opts", "-Xmx4096m");

// 设置Map和Reduce任务的数量

conf.set("mapreduce.job.maps", "100");

conf.set("mapreduce.job.reduces", "20");

// 其他配置...

}

```

在实际应用中,内存设置需根据集群资源和作业需求进行调整。对于资源消耗较大的作业,可以适当增加Map和Reduce任务的数量以实现更细粒度的并行处理,同时提高资源利用率。

以上是MapReduce Join理论基础的详细解析,下一节将探讨在实际应用中如何选择合适的Join策略,并介绍具体的实战技巧。

# 3. MapReduce Join实战技巧

## 3.1 实际案例中的Join策略选择

### 3.1.1 常见业务场景的Join策略

在实际的大数据处理中,Join操作是常见的需求,用于整合来自不同数据集的相关信息。根据业务场景的不同,选择适当的Join策略至关重要。以下列举了一些常见的业务场景及其对应的Join策略:

- **星型模式**:在数据仓库和BI报告中,星型模式(Star Schema)是常用的模型,通常涉及到维度表和事实表的连接。由于维度表往往较小,适合使用Map端Join,以减少数据传输和排序开销。

- **事实表到事实表的Join**:当需要将两个或多个大型事实表进行关联时,推荐使用Reduce端Join。因为数据集大,Map端可能无法处理全部数据,而Reduce端可以通过分区保证数据局部性。

- **批次数据与实时数据的Join**:结合批处理和流处理的场景,通常需要将实时产生的小数据集与历史批处理的大数据集进行Join操作。此时,Map端Join是一个较好的选择,可以在流处理环节快速完成关联。

### 3.1.2 调优和故障排查步骤

在实施Join操作时,调优和故障排查是保证程序性能的关键步骤。以下是一些常见步骤:

1. **数据分布分析**:确保JOIN操作的两个数据集在MapReduce任务中分布均匀,避免数据倾斜导致的资源浪费。

2. **内存与CPU资源评估**:根据数据集大小和处理复杂度评估所需的内存和CPU资源,避免因资源限制导致任务失败。

3. **使用计数器监控**:MapReduce提供了计数器功能,可以帮助我们监控和调试JOIN操作中的数据不匹配、空值等问题。

4. **性能监控与日志分析**:实时监控执行过程中的性能指标,如Map和Reduce的执行时间,及时发现瓶颈。

5. **作业调度优化**:根据不同的作业类型和优先级合理配置资源,避免资源竞争。

6. **Map端JOIN的优化**:对于Map端JOIN,合理设置内存分配和预设过滤条件,减少不必要的数据传输。

## 3.2 MapReduce编程模型下的Join实现

### 3.2.1 编码实现Map端和Reduce端的Join

Map端Join和Reduce端Join在编码实现上有明显的不同。以下是实现这两种Join的简单示例:

- **Map端Join示例代码**:

```java

public class MapSideJoin extends Mapper<LongWritable, Text, Text, Text> {

private String leftDataSetPath;

private FileSystem fs;

private Configuration conf;

private Map<String, String> leftDataSet = new HashMap<>();

@Override

protected void setup(Context context) throws IOException, InterruptedException {

conf = context.getConfiguration();

leftDataSetPath = conf.get("left.data.path");

fs = FileSystem.get(conf);

if (fs.exists(new Path(leftDataSetPath))) {

parseLeftDataSet();

}

}

private void parseLeftDataSet() throws IOException {

// 这里省略了读取文件并解析逻辑

// 假设得到的是一系列键值对,存储到leftDataSet中

}

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

String[] split = value.toString().split(",");

String keyFromRight = split[0]; // 右数据集的连接键

String valueFromRight = split[1]; // 右数据集的值

// 尝试从左数据集中获取数据

String valueFromLeft = leftDataSet.get(keyFromRight);

if (valueFromLeft != null) {

context.write(new Text(keyFromRight), new Text(valueFromLeft + "\t" + valueFromRight));

}

}

}

```

- **Reduce端Join示例代码**:

```java

public class ReduceSideJoin extends Reducer<Text, Text, Text, Text> {

@Override

protected void reduce(Text key, Iterable<Text> values, Context context) throws IOException, InterruptedException {

for (Text value : values) {

context.write(key, value);

}

}

}

```

在Reduce端Join中,通常需要对数据进行预处理,如标记数据来源等,以区分来自不同数据集的信息。

### 3.2.2 使用Combiner进行中间数据合并

在Map端和Reduce端之间的Shuffle过程中,中间数据的传输往往占用了大量的网络带宽和计算资源。使用Combiner可以减少数据传输量,提高效率。

```java

public class JoinCombiner extends Reducer<Text, Text, Text, Text> {

@Override

protected void reduce(Text key, Iterable<Text> values, Context context) throws IOException, InterruptedException {

// 对Map输出的中间数据进行局部合并

for (Text value : values) {

context.write(key, value);

}

}

}

```

## 3.3 处理大数据集的Join优化实践

### 3.3.1 分区和采样技术的使用

在处理大数据集时,合理的分区和采样可以显著提升JOIN操作的性能。以下是两个重要的优化实践:

1. **分区策略**:在MapReduce程序中,可以通过分区策略控制数据如何分发到各个Reducer上。合理的分区可以减少数据倾斜,确保负载均衡。例如,在Map端Join中,可以通过数据集预处理时的哈希值来决定分区键。

2. **采样技术**:对于大数据集,可以在读取数据前进行采样,根据样本数据计算连接键的分布情况,然后据此调整分区键和分区数,以达到更好的负载均衡。

### 3.3.2 借助外部工具和数据库优化Join操作

在某些复杂场景下,单纯依赖MapReduce框架进行Join操作可能效率不高,这时可以考虑使用外部工具和数据库进行优化:

- **使用外部数据库**:对于需要频繁Join的业务场景,可以将数据预先导入外部数据库系统,利用数据库优化器和索引机制来执行高效Join操作。

- **使用Hive等工具**:Hive为大数据集提供了类似SQL的查询语言HiveQL,简化了MapReduce的复杂编程。它通过内置优化器自动选择最合适的执行路径和策略。

下面是一个使用Hive进行Join操作的简单示例:

```sql

SELECT a.key, a.value, b.value

FROM dataset_a a

JOIN dataset_b b ON a.key = b.key;

```

在Hive中,JOIN操作会自动转换为MapReduce任务,Hive优化器会根据统计信息选择最优的执行计划,有时可能使用Map端Join,有时可能使用Reduce端Join,有时甚至会转化为Map-Side Lookup Join。

通过采用适当的Join策略,结合有效的编码实现和外部工具的辅助,可以大大提升大数据集上的Join操作性能,缩短处理时间,优化资源使用。

# 4. 大数据Join操作的挑战与应对

## 处理非结构化数据的Join挑战

### 非结构化数据的预处理方法

在大数据时代,非结构化数据呈现爆炸性增长,这些数据包括文本、图像、音频和视频等。与结构化数据相比,非结构化数据的Join操作更加复杂,因为它们缺乏明确的模式(Schema),不易于直接进行查询和处理。以下是几种常见的非结构化数据预处理方法,以帮助实现有效的Join操作。

1. **文本数据的分词与标准化**:对于文本数据,首先需要进行分词处理,将一段文本拆分成单独的词汇单元。分词后,还需进行标准化处理,如小写转换、停用词过滤等,以便进行后续的文本相似度计算和Join操作。

```python

import jieba

# 示例代码:使用jieba进行中文文本分词

text = "MapReduce是一个非常实用的大数据处理框架。"

words = jieba.lcut(text)

print(words)

```

2. **图像数据的特征提取**:图像数据在进行Join之前,通常需要提取关键特征。常见的方法包括边缘检测、形状描述、颜色直方图等。提取的特征可以作为后续Join操作的依据。

```python

import cv2

# 示例代码:使用OpenCV提取图像的颜色直方图

img = cv2.imread('example.jpg')

color = cv2.cvtColor(img, cv2.COLOR_BGR2RGB)

color_hist = cv2.calcHist([color], [0, 1, 2], None, [256, 256, 256], [0, 256, 0, 256, 0, 256])

```

3. **音频和视频数据的模式识别**:音频和视频文件在进行Join之前,需要先转换成可处理的数据模式。音频文件可能需要提取频谱特征,而视频则可能要抽样帧数据。这些数据可用于相似度比较和最终的Join操作。

```python

import librosa

# 示例代码:使用librosa提取音频文件的特征

audio, sr = librosa.load('example_audio.wav')

mfccs = librosa.feature.mfcc(y=audio, sr=sr)

```

### 结合机器学习进行数据分类和Join

机器学习技术在处理非结构化数据的Join操作中发挥着重要作用。通过训练模型,可以对数据进行分类,将相似或相关的数据归为同一类别,从而简化Join过程。

#### 使用机器学习进行数据分类

使用机器学习算法,如支持向量机(SVM)、随机森林等,可以对非结构化数据进行分类。分类完成后,数据集中的数据点将按照它们的特征被分成不同的类别。这些类别将被用于简化Join操作,因为只需要在相同或相近类别之间进行Join,而不必在整个数据集中进行穷举式的比较。

```python

from sklearn import svm

from sklearn.datasets import load_iris

# 示例代码:使用scikit-learn进行鸢尾花数据集的分类

iris = load_iris()

X = iris.data

y = iris.target

# 创建一个支持向量分类器实例

clf = svm.SVC(gamma=0.05)

# 训练模型

clf.fit(X, y)

```

#### 应用机器学习模型进行Join

在训练好分类模型之后,下一步是将模型应用于实际数据,以预测新数据的类别。这使得Join操作可以基于类别进行,而不是基于数据点本身。例如,如果我们有两个数据集,分别包含用户行为数据和产品信息,我们可以先对这两个数据集进行分类,然后将属于同一类别的数据记录进行Join。

```python

# 预测新的数据点类别

X_new = [[5.3, 3.2, 1.3, 0.7]]

predicted_class = clf.predict(X_new)

print(predicted_class)

```

使用机器学习方法对非结构化数据进行预处理和分类,可以显著提高大数据环境下的Join操作效率和准确性。然而,这些方法需要大量的计算资源,并且对数据质量和特征选择非常敏感。因此,在实际应用中,需要精心设计和调优预处理步骤和分类模型,以获得最佳的Join结果。

# 5. MapReduce Join操作的未来展望

随着大数据技术的不断演进,MapReduce Join操作也面临着新的挑战和机遇。从新兴算法的引入到人工智能技术的辅助,再到职业发展的转型,本章将对MapReduce Join操作的未来走向进行深入探讨。

## 5.1 新算法和技术对Join操作的影响

MapReduce虽然在大数据领域有着重要的地位,但新兴技术的兴起也在逐渐改变这一格局。Flink和Kafka Stream等流处理技术以及量子计算和边缘计算等新型计算模型,对Join操作的影响不容忽视。

### 5.1.1 Flink和Kafka Stream等流处理技术

流处理技术如Apache Flink和Apache Kafka Streams带来了实时数据处理的能力。在流处理的场景下,Join操作需要能够在不断到来的数据流中快速完成匹配,这与传统的批处理模式有很大差异。这些新技术通过实现更高效的窗口操作和状态管理机制,优化了流式Join的性能。

```java

// 示例代码:Flink中使用Window Join

DataStream<Tuple2<Long, String>> stream1 = ...;

DataStream<Tuple2<Long, String>> stream2 = ...;

stream1

.keyBy(0)

.intervalJoin(stream2.keyBy(0))

.between(Time.milliseconds(-5), Time.milliseconds(5))

.process(new IntervalJoinFunction());

```

### 5.1.2 量子计算和边缘计算对Join的潜在影响

量子计算和边缘计算提供了全新的计算范式,它们可能会颠覆传统数据处理的许多方面。在量子计算中,Join操作可能需要借助量子算法来实现,而边缘计算则意味着更多的数据处理将发生在数据产生的本地,这将对数据同步和分布式Join操作提出新的要求。

## 5.2 人工智能在Join优化中的应用

人工智能在数据处理领域正逐渐展现出它的潜力,其中在MapReduce Join操作中的应用也日益增多。

### 5.2.1 机器学习在数据倾斜预测中的应用

机器学习算法可以用来预测和识别数据倾斜的可能性。通过分析历史数据的分布特性,机器学习模型可以预测在哪些键上可能会发生数据倾斜,并据此调整数据分配策略,从而优化Join操作的性能。

```python

# 示例伪代码:使用机器学习预测数据倾斜

倾斜预测模型 = 训练(历史数据)

倾斜键 = 倾斜预测模型.预测(即将进行的Join操作数据)

```

### 5.2.2 自适应算法在优化Join性能中的角色

自适应算法可以根据数据的实时特征动态调整Join策略。在运行时分析数据的流动模式和特征,自动选择合适的Join策略和资源分配,使得整体的Join操作更加高效和稳定。

## 5.3 大数据环境下的职业发展与技能提升

对于数据工程师而言,MapReduce Join操作在未来仍然会是一项重要技能,但随着技术的发展,需要不断地学习和适应新的工具和技术。

### 5.3.1 数据工程师的必备技能和未来趋势

数据工程师需要掌握MapReduce Join操作的基础和高级技巧,并且要不断更新自己的技能树,以适应大数据处理的新趋势。掌握Flink、Spark等现代数据处理框架以及机器学习等人工智能技术将成为数据工程师的必备条件。

### 5.3.2 社区贡献和开源项目在技能提升中的重要性

参与社区贡献和开源项目是提升自身技能的有效途径。通过解决开源项目中的实际问题,数据工程师不仅可以提高编程能力,还能了解到最新的行业动态和技术发展方向。

MapReduce Join操作的未来是多变且充满挑战的,但它仍然是大数据处理领域不可或缺的一部分。随着新算法、新技术以及人工智能的融合,这一经典技术将焕发出新的活力。

0

0