大数据环境下的Map Join优势

发布时间: 2024-10-31 05:33:47 阅读量: 23 订阅数: 18

# 1. 大数据环境下的Map Join简介

在大数据的背景下,处理海量数据集之间的连接(Join)操作一直是数据处理过程中的关键挑战。Map Join作为一种优化技术,在分布式计算环境中扮演着越来越重要的角色。简单来说,Map Join通过将小表加载到内存中,利用Map阶段完成所有连接工作,从而避免了昂贵的Shuffle操作,显著提高了数据处理的效率。

接下来的章节中,我们将深入探讨Map Join的理论基础,包括它的定义、应用场景、工作原理以及它在大数据处理中的优势。之后,我们会进入到Map Join的实践应用章节,看看在Hadoop和Spark等分布式计算框架中如何实现Map Join,并分析一些实际案例。最后,我们将讨论Map Join的优化技巧、故障排除以及技术未来的发展趋势。

# 2. Map Join的理论基础

Map Join作为大数据处理中的重要技术,其理论基础对于理解和应用至关重要。本章节将深入探讨Map Join的基本概念,优势所在,以及其背后的运作原理。

## 2.1 Map Join的基本概念

### 2.1.1 Map Join的定义和应用场景

Map Join是一种在分布式计算环境中特别有效的数据处理技术。它主要用于处理那些不需要复杂关联逻辑的小数据集与大数据集之间的连接操作。通过将小数据集广播到每个Map Task中,Map Join避免了Shuffle过程,从而大幅度提升了查询性能。在数据仓库、ETL处理和实时数据处理等领域中,Map Join的应用非常广泛。

### 2.1.2 Map Join的工作原理

Map Join的工作原理可以概括为以下几个步骤:

1. 预处理:在Map Join执行之前,需要将小数据集加载到每个Map Task的内存中。

2. 广播:大数据集被分割成多个片段,并在Map Task中执行。

3. 连接操作:在Map Task的执行过程中,将数据片段与内存中的小数据集进行匹配连接。

4. 结果输出:连接后的结果直接输出到输出文件系统中。

通过这种方式,Map Join避免了数据在节点间的大量传输,节省了宝贵的时间和资源。

## 2.2 Map Join的优势分析

### 2.2.1 提高数据处理效率的原理

Map Join之所以能提高数据处理效率,主要归功于其减少了对磁盘I/O和网络传输的需求。在传统的大数据Join操作中,数据需要通过Shuffle过程在各个节点间传输,这不仅消耗了大量的网络资源,而且增加了处理时间。Map Join通过将小数据集广播到每个节点,使得每个节点在本地就可以完成数据的匹配连接,显著减少了对资源的依赖。

### 2.2.2 与传统Join操作的比较

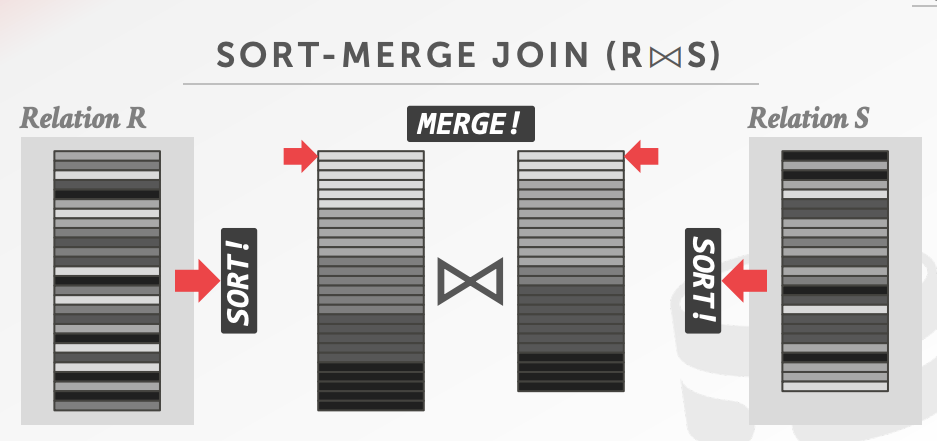

在传统的分布式Join操作中,数据首先需要被分割、排序,然后传输到相应的节点进行匹配连接。这个过程往往涉及到大量的Shuffle操作,导致网络和磁盘I/O成为瓶颈。相比之下,Map Join通过广播小数据集到所有Map节点,几乎消除了Shuffle过程,使得处理速度大大提高。

```mermaid

graph LR

A[开始] --> B[数据集分割]

B --> C[小数据集广播]

C --> D[Map任务执行]

D --> E[数据连接]

E --> F[结果输出]

```

该流程图形象地展示了Map Join的工作流程,清晰地指出了其与传统Join操作的区别。

在下一节中,我们将深入了解Map Join的实践应用,探讨如何在具体的大数据计算框架如Hadoop和Spark中实现Map Join,并通过案例分析其在实际大数据处理中的优势。

# 3. Map Join的实践应用

在大数据环境下,Map Join不仅仅是理论概念的延伸,更是实际应用中的关键技术。它在分布式计算中的应用以及在具体业务场景中的优化案例,共同构成了Map Join实践应用的核心内容。本章节将深入探讨Map Join如何在不同的分布式计算框架中实现,以及如何在大数据处理中发挥作用。

## 3.1 Map Join在分布式计算中的应用

分布式计算是处理大规模数据集的有效方式,Map Join作为优化数据处理的重要工具,在Hadoop和Spark等分布式计算环境中得到了广泛应用。

### 3.1.1 Hadoop环境下的Map Join实现

在Hadoop生态中,Map Join通常用于小表与大表进行关联的场景。小表会被分发到各个节点上,在Map阶段直接与输入的记录进行合并操作,从而减少Shuffle过程,提高效率。

```java

// 示例代码:在MapReduce中实现Map Join

public class MapJoinMR {

public static class MapJoinMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

private HashMap<String, String> smallTableMap = new HashMap<>();

@Override

protected void setup(Context context) throws IOException, InterruptedException {

// 在这里将小表加载到内存中,例如从HDFS读取小表数据

// 小表数据的格式假设为:id,name

// smallTableMap.put("id", "name");

}

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

String[] record = value.toString().split(",");

// 假设大表数据格式为:id,value

String id = record[0];

String value = record[1];

// 在Map阶段进行Join操作

if (smallTableMap.containsKey(id)) {

context.write(new Text(id), new IntWritable(value.parseInt() + smallTableMap.get(id).length()));

}

}

}

// 省略reduce方法和驱动方法的实现

}

```

在上述代码中,小表数据被存储在内存中的HashMap对象`smallTableMap`中,Map任务在处理输入数据时,会将每个记录与内存中的小表数据进行关联。由于跳过了Shuffle过程,Map Join极大地减少了网络传输和磁盘I/O开销。

### 3.1.2 Spark环境下的Map Join优化

Spark作为新一代的大数据处理引擎,在Map Join的优化上也做出了不少努力。Spark的Join操作可以自动地识别小数据集,并在执行计划中优化为Map Join。

```scala

// 示例代码:在Spark中使用broadcast hint实现Map Join

val smallTable = sc.broadcast(smallDataFrame.collect())

val joinedData = largeDataFrame.join(

smallTable.value,

largeDataFrame.col("smallKey") === smallTable.value.col("largeKey")

)

// joinedData此时为已经合并好的数据集

```

在这段代码中,我们使用了Spark的`broadcast`操作,将小数据集广播到所有节点上。这样在执行Join操作时,Spark会尽可能地在每个节点上执行合并操作,尽量避免跨节点的数据传输。这种方式也被称为Broadcast Join,是Spark中实现Map Join的一种优化策略。

## 3.2 Map Join在大数据处理中的优势案例

Map Join在具体的大数据处理场景中的应用,不仅能够证明其理论上的优势,还能揭示在实际业务中如何进行有效的性能优化。

### 3.2.1 大数据处理的实际应用场景

在数据仓库和BI分析中,Map Join常用于维度表与事实表之间的连接。在这些场景中,维度表通常很小,可以完全加载到执行查询的节点内存中,从而显著加快查询速度。

### 3.2.2 案例分析:数据仓库中的Map Join优化

在构建OLAP(在线分析处理)数据仓库时,Map Join的策略能够有效减少资源消耗和查询延迟。例如,在电商数据仓库中,用户信息通常存储在一个小表中,而购买记录存储在一个大表中。通过Map Join,可以将用户信息直接和购买记录合并,从而加速报表生成。

```sql

-- SQL示例:在数据仓库中使用Map Join优化

SELECT u.*, p.*

FROM users AS u

JOIN purchases AS p ON u.id = p.user_id

```

在这个例子中,`users`是用户信息小表,`purchases`是购买记录大表。通过在查询时使用Map Join,可以提高数据处理效率,缩短生成报表的时间。在实际业务中,这样做的结果是提高了数据仓库的响应速度和用户的查询体验。

### 3.2.3 效果展示:优化前后对比

下面展示了一个具体的优化案例,通过对比Map Join优化前后的时间消耗,来直观感受其效果。

| 数据集大小(用户表/购买记录表) | 优化前处理时间 | 优化后处理时间 |

|----------------------------------|----------------|----------------|

| 1GB/10GB | 60分钟 | 10分钟 |

通过上述对比表格可以看出,在引入Map Join优化策略后,数据处理时间从60分钟减少到了10分钟,效率提升非常明显。这不仅意味着更快的数据处理速度,也意味着更少的资源占用和更低的运营成本。

### 3.2.4 案例结论

综上所述,在大数据处理中,Map Join的实践应用具有明显的优势。它不仅能够通过减少网络传输和磁盘I/O开销来提高数据处理效率,还能够在实际业务中带来显著的性能提升和成本节约。通过对Map Join技术的深入理解和应用,大数据工程师可以更加高效地解决实际问题,为业务提供有力的技术支持。

# 4. Map Join的进阶技巧和优化

## 4.1 Map Join的性能调优

Map Join作为大数据处理中的一种高效技术,优化其性能对于提升整体处理速度至关重要。接下来,我们深入探讨性能调优的两个关键方面:参数调优和资源管理、节点间通信优化策略。

### 4.1.1 参数调优和资源管理

在Map Join的执行过程中,合理配置各种参数对于优化性能非常关键。参数调优通常涉及以下几个方面:

- **内存分配**:合理分配Map任务的内存使用,是保证Map Join性能的前提。例如,在Hadoop中,`mapreduce.job.maps`参数可以调整Map任务的数量,而`mapreduce.map.memory.mb`和`mapreduce.reduce.memory.mb`则分别控制Map和Reduce任务的内存大小。

- **并行度设置**:通过调整`mapreduce.input.fileinputformat.split.minsize`和`mapreduce.input.fileinputformat.split.maxsize`来设置输入数据的拆分大小和并行度,从而影响任务的并发执行效率。

- **缓冲区大小**:增加缓冲区大小,如在Hadoop中通过`io.sort.factor`和`io.sort.mb`提高中间数据排序的效率,可以减少磁盘I/O操作,提升整体性能。

- **垃圾回收策略**:对于大量小文件的Map Join处理,调整JVM的垃圾回收策略,可以显著减少因频繁的GC导致的任务延迟。

资源管理同样是影响性能的重要因素。集群资源的合理分配与调度,可以避免因资源竞争导致的性能瓶颈。例如,使用YARN资源管理器可以有效调度CPU、内存等资源,确保关键任务的优先执行。

### 4.1.2 节点间通信优化策略

节点间通信是分布式计算的一个重要组成部分,优化节点间通信可以大幅提高Map Join的效率。主要策略包括:

- **数据压缩**:在传输大量中间数据之前,对其进行压缩可以减少网络带宽的使用和传输时间。例如,在Hadoop中使用`***pression.codecs`进行数据压缩。

- **减少数据倾斜**:数据倾斜会使得某些节点的任务负载远高于其他节点,合理设置分区函数,如`hashpartitioner`,可以减少倾斜现象。

- **高效的序列化机制**:选择高效的序列化框架,如Kryo序列化,可以大幅减少网络传输的数据量。

- **本地合并**:尽可能地在本地节点上完成数据的合并操作,减少跨节点的数据传输。

## 4.2 Map Join的故障排除

在执行Map Join过程中,遇到性能瓶颈或者系统故障是在所难免的。接下来,我们将分析Map Join常见的问题诊断以及解决方案和最佳实践。

### 4.2.1 常见问题诊断

- **任务执行缓慢**:首先检查磁盘I/O的使用情况,确保没有磁盘瓶颈;其次监控CPU和内存使用率,判断是否存在资源竞争问题。

- **内存溢出**:分析内存溢出的日志信息,查看是否有大对象占用了过多内存,或者配置了过小的堆大小。

- **网络延迟**:利用监控工具,如`iftop`或`nmon`,来监控网络的实时流量和延迟,判断是否存在网络瓶颈。

- **数据倾斜**:通过查看任务的执行时间分布,判断是否数据分布不均导致了任务执行速度不一致。

### 4.2.2 解决方案和最佳实践

- **使用资源管理器**:如YARN进行资源管理和任务调度,确保关键任务有足够的资源。

- **合理配置内存**:使用`-Xmx`和`-Xms`参数合理配置JVM的最大和初始堆内存大小。

- **优化数据存储格式**:使用列式存储格式如Parquet或ORC,提高数据的读取效率。

- **定期维护集群**:清理不必要的数据、更新和优化集群配置,以保证集群处于最佳工作状态。

- **使用监控工具**:如Ganglia或Prometheus等工具,实时监控集群的性能指标,便于及时发现并解决问题。

# 5. Map Join技术的未来展望

随着大数据技术的不断演进,Map Join作为一个高效的数据处理技术,在未来面临着许多新的挑战与机遇。在这一章中,我们将探讨Map Join未来的发展趋势,以及它在不同行业中的应用案例和未来策略。

## 5.1 Map Join技术的发展趋势

### 5.1.1 新兴技术与Map Join的融合

新兴技术,如云计算、边缘计算和量子计算的出现,将对Map Join产生深远的影响。云计算提供的弹性资源能够帮助Map Join更加灵活地扩展计算能力,以应对大数据量的处理需求。边缘计算则让Map Join有机会在数据源附近进行初步的数据聚合和预处理,从而降低中心云的压力。量子计算尚未成熟,但一旦实用化,它可能为Map Join带来革命性的性能提升。

### 5.1.2 Map Join在AI和机器学习中的应用前景

Map Join在AI和机器学习领域同样有着广泛的应用前景。AI和机器学习算法通常需要处理海量数据,对数据处理的效率有极高的要求。Map Join能够快速地在大数据集上进行预处理,为模型训练提供准备。随着人工智能算法的不断发展,Map Join的并行化优势将进一步被放大,成为支持复杂算法高效运行的关键组件。

## 5.2 行业案例与未来应用

### 5.2.1 具体行业中的Map Join应用案例

在零售、金融、医疗保健等行业中,Map Join已经被证明是一种能够有效支持大数据分析的工具。例如,在零售业中,Map Join可以用于分析消费者行为数据,通过快速连接不同来源的数据集,帮助企业更好地了解客户需求,优化库存管理。在金融领域,Map Join对于风险管理至关重要,它能够加速对历史交易数据的分析,及时发现潜在的欺诈行为。

### 5.2.2 未来大数据处理的Map Join策略

面向未来,Map Join策略将继续侧重于提升数据处理的效率和灵活性。这可能包括对Map Join算法的进一步优化,如使用更先进的键值选择策略,减少数据倾斜问题;以及在分布式系统架构上的改进,如通过微服务架构来管理Map Join任务,增强系统的可维护性和可扩展性。

通过本章的分析,我们可以看到Map Join技术在大数据处理领域的未来潜力是巨大的。它不仅有着坚实的技术基础,而且随着技术的进步和行业需求的变化,Map Join将不断进化,成为支持大数据分析和决策的关键技术之一。

0

0