Map Join基础理解

发布时间: 2024-10-31 05:25:43 阅读量: 54 订阅数: 36

# 1. Map Join的基本概念和原理

Map Join是分布式计算中用来处理大数据集关联的一种优化技术。它主要针对的是小表与大表的join操作,通过将小表数据全部加载到每个Map任务的内存中,来避免使用传统的Shuffle过程,从而显著提升处理效率。

## 1.1 Map Join的定义

Map Join的核心思想是预加载小表到内存中,Map任务在处理大表的每个数据块时,直接在内存中与小表数据进行关联,省去了数据传输和交换的时间。

## 1.2 Map Join的工作流程

Map Join的基本流程包括:

- 小表数据的加载

- 大表数据的分区

- 每个Map任务的内存中执行Join操作

## 1.3 Map Join的优势

使用Map Join可以大幅提升数据处理速度,因为它避免了网络I/O和磁盘I/O开销。不过它也有局限性,例如内存大小限制了小表数据的大小。

Map Join在特定条件下,比如处理的数据集大小符合内存限制,可以极大提升数据处理速度,节省计算资源。然而,如果数据集大小超过了内存限制,就无法使用Map Join,此时需要考虑其他Join策略。随着分布式计算技术的发展,Map Join的技术也在不断创新优化,以适应更复杂的大数据处理场景。

# 2. Map Join的工作机制

## 2.1 Map Join的数据处理流程

### 2.1.1 数据的预处理

在Map Join的执行过程中,数据预处理是关键的第一步。在此阶段,需要确保参与连接的两个数据集中的至少一个数据集足够小,以便能够加载到每个Map任务的内存中。这个数据集通常被称为“小表”,而另一个较大的数据集则称为“大表”。

- **数据格式化**:数据预处理的第一步通常是将小表数据加载到内存中,并将其转换成适合于Join操作的数据结构,例如在Hadoop中,可能会将小表加载为Map任务的`MapJoinCache`。

- **索引构建**:为了加快查找效率,通常会在小表数据上构建索引。索引可以是基于某些关键字段的哈希表,也可以是更为复杂的树形结构,比如B树或红黑树。

### 2.1.2 数据的分发和读取

一旦预处理完成,小表数据将被广播到所有的Map任务中。这个过程是Map Join能够高效执行的关键。

- **广播机制**:在Hadoop MapReduce中,可以使用`DistributedCache`来广播小表数据。在Spark中,使用广播变量(Broadcast Variables)来实现类似功能。

- **读取优化**:Map任务在执行过程中可以快速访问本地内存中的小表数据,避免了网络传输的开销。这个优化显著减少了数据的读取时间,提高了整体的执行效率。

## 2.2 Map Join的性能优势

### 2.2.1 与常规Join的性能对比

Map Join之所以受到青睐,是因为它相较于常规的Join操作有显著的性能优势。

- **内存级数据访问速度**:在Map任务的内存中进行数据查找和Join操作,速度远快于磁盘I/O。

- **网络传输的减少**:避免了在分布式系统中交换大量数据,节省了网络带宽和时间。

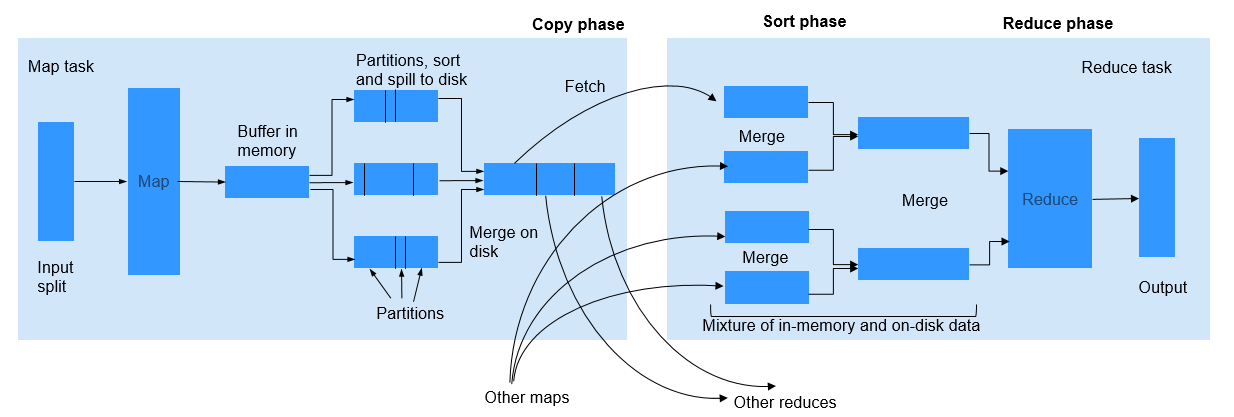

- **避免Shuffle过程**:常规的Join操作,特别是在MapReduce框架中,需要进行复杂的Shuffle过程,而Map Join绕过了Shuffle步骤,大大提高了性能。

### 2.2.2 影响Map Join性能的因素

尽管Map Join带来了性能上的巨大优势,但是仍然有一些因素可能影响其性能。

- **小表大小**:小表大小直接影响到Map任务的内存使用情况,如果小表过大,则可能无法完全装入内存,影响性能。

- **数据倾斜**:数据倾斜可能会导致某些Map任务需要处理的数据量远大于其他任务,从而影响整体性能。

- **硬件资源**:Map Join依赖于充足的内存资源,如果硬件资源有限,则可能无法充分发挥Map Join的优势。

## 2.3 Map Join的适用场景

### 2.3.1 大数据环境下的Map Join

在大数据环境下,Map Join能够有效地处理一些特定场景,尤其是在处理大规模数据集时。

- **大数据集与小数据集的Join**:对于一个非常大的数据集和一个相对较小的数据集的Join操作,Map Join可以极大地提升性能。

- **宽表与维表的Join**:在数据仓库系统中,宽表(事实表)通常包含大量的数据,而维表(维度表)则相对较小。在这种情况下,Map Join是处理这些数据的理想选择。

### 2.3.2 小数据量情况下的Map Join

Map Join也适用于数据量较小的情况,在这些场景中,Map Join的优势更加明显。

- **数据仓库中的快速查询**:在数据仓库的查询中,经常需要与其他维度表进行快速的关联查询,Map Join可以提供更快的响应时间。

- **ETL过程中的数据处理**:在ETL(Extract, Transform, Load)过程中,Map Join可以帮助快速整合数据,尤其是当需要进行多个小数据集的关联时。

通过本章节的介绍,我们已经了解了Map Join的基本工作机制,包括数据处理流程、性能优势和适用场景。接下来,让我们深入探讨Map Join在实际应用中的配置、使用和优化策略,从而进一步发挥其在数据处理中的潜力。

# 3. Map Join的实践应用

## 3.1 Map Join的配置和使用

### 3.1.1 Hadoop环境下的Map Join配置

在Hadoop环境中配置Map Join相对直接,因为它提供了一些简化操作的工具和API。典型的配置步骤包括准备Hadoop集群、配置Map Join相关的参数以及实际的Map Join任务提交。

首先,您需要确保Hadoop集群已经安装并正确配置。然后,在提交Map Join任务之前,需要对`mapreduce.join.speculative`和`mapreduce.jobcontrol_ENABLED`这些参数进行设置,以便优化Map Join操作。

```bash

# 在Hadoop的配置文件core-site.xml中进行设置

<configuration>

<property>

<name>mapreduce.join.speculative</name>

<value>false</value>

</property>

<property>

<name>mapreduce.jobcontrol_ENABLED</name>

<value>true</value>

</property>

</configuration>

```

设置`mapreduce.join.speculative`为false可以防止在Map Join操作中出现不必要的Speculative Execution。而`mapreduce.jobcontrol_ENABLED`为true表示允许任务控制。

在提交Map Join任务时,可以使用Hadoop命令行工具,例如:

```bash

hadoop jar mapjoin.jar MapJoinDriver /input/ /reference/ /output/

```

在上面的命令中,`mapjoin.jar`是包含Map Join逻辑的jar文件,而`MapJoinDriver`是实现Map Join的类名。输入路径`/input/`包含需要与参照表进行Join的大数据集,而`/reference/`是小的参照表。

### 3.1.2 Spark环境下的Map Join配置

在Spark中进行Map Join的配置与Hadoop有所不同,主要原因是Spark自身的设计和运行机制。在Spark中,可以利用广播变量(Broadcast Variables)来实现Map Join,这样参照表就可以被广播到每个执行器(Executor)上。

首先,需要创建一个SparkSession实例,它是进入Spark SQL功能的入口:

```scala

val spark = SparkSession.builder.appName("MapJoin Example").getOrCreate()

```

然后,可以创建一个DataFrame或RDD,将参照表定义为一个广播变量:

```scala

val referenceDF = spark.read.format("csv").load("hdfs://path/to/reference/")

val broadcastReference = spark.sparkContext.broadcast(referenceDF.collect())

```

在后续的Map Join逻辑中,您可以直接使用`broadcastReference`,它会包含被广播的小表数据。

在实际的查询中,就可以利用广播变量进行高效的Join操作:

```scala

val resultDF = mainDF.join(broadcast(broadcastReference), mainDF.col("joinKey") === broadcastReference.value(0).col("joinKey"))

```

最后,展示或保存结果:

```scala

resultDF.show()

// 或者将结果保存到HDFS

resultDF.write.format("parquet").save("hdfs://path/to/output/")

```

在这段代码中,`mainDF`是需要与参照表`referenceDF`进行Join的大数据集。通过广播变量,参照表被广播到各个执行器,从而避免了Shuffle操作,节省了网络带宽和计算资源。

## 3.2 Map Join的案例分析

### 3.2.1 大数据ETL中的应用实例

在一个典型的大数据ETL(Extract, Transform, Load)流程中,Map Join经常被用在数据清洗和预处理阶段。下面是一个在Hadoop上运行的ETL作业案例,它展示了如何使用Map Join对数据进行预处理。

首先,假设有两个数据集,一个是每天收集的用户行为数据,另一个是用户的基本信息数据表。用户行为数据量很大,而用户信息数据量较小。

在进行ETL处理时,首先需要将这两个数据集进行Join,以获得完整的用户分析数据。

```bash

hadoop jar etl.jar MapJoinETL /input/behavior/ /input/users/ /output/

```

在这个例子中,`/input/behavior/`和`/input/users/`是HDFS上的输入路径,分别存储了用户行为数据和用户信息数据,`/output/`是输出路径。

Map Join操作发生在Map阶段,小表(用户信息数据表)被加载到内存中,然后数据处理流程如下:

1. Map任务读取用户行为数据。

2. 在Map任务中,每个Map读取到的用户行为记录会与内存中的用户信息进行匹配和合并。

3. 经过处理后的数据写入到HDFS的输出目录中。

在Map Join的帮助下,ETL处理变得更为高效,因为Join操作不需要Shuffle大量数据。

### 3.2.2 实时数据处理中的应用实例

在实时数据处理的场景下,如使用Apache Kafka进行数据流处理和Spark Streaming进行数据实时分析时,Map Join同样具有其优势。在这些场景下,我们通常有一个持续到来的实时数据流和一个静态的参照表。

以Apache Kafka和Spark Streaming为例,一个实时数据流处理的案例如下:

```scala

val kafkaStream = KafkaUtils.createDirectStream[String, String](

streamingContext,

LocationStrategies.PreferConsistent,

ConsumerStrategies.Subscribe[String, String](Set("topic"), kafkaParams)

)

kafkaStream.map(x => parse(x._2))

.foreachRDD(rdd => {

rdd.foreachPartition(partition => {

val bcRef = spark.sparkContext.broadcast(smallTable.collect())

partition.foreach(record => {

// 进行Map Join逻辑处理...

})

})

})

```

在上面的代码段中,我们使用了Kafka的Direct API从Kafka主题中获取实时数据流,并将其转换为可以处理的格式。然后我们使用`foreachRDD`方法迭代RDD,并在每个分区上使用`foreachPartition`来并行处理数据。

在每个分区处理过程中,我们将小的参照表`smallTable`作为广播变量`bcRef`加载并广播到每个执行器。这样,每个分区在处理数据时都能够利用Map Join逻辑来实现数据的快速合并。

这种方式使得实时数据流的处理更加高效,特别是当参照表不大且需要频繁访问时。

## 3.3 Map Join的优化策略

### 3.3.1 内存管理优化

内存是影响Map Join性能的关键因素之一。在执行Map Join时,内存中需要加载一个或多个小表。当这些小表的数据量超过可用内存时,系统会频繁地进行磁盘交换操作,这会严重影响性能。

为了避免这种情况,需要合理管理内存使用,这可以通过以下方式进行优化:

1. 调整内存分配参数:在Spark中,可以通过调整`spark.executor.memory`来增加执行器的内存分配。

2. 使用序列化库:在Spark中,可以使用Kryo序列化库替代Java序列化来减少内存的占用。

3. 压缩数据:在将小表加载到内存之前,可以使用压缩算法(如Snappy或LZ4)来减少内存占用。

4. 调整缓存级别:在Spark中,可以通过调整缓存级别(如使用`MEMORY_AND_DISK_SER`)来指定数据的存储方式。

### 3.3.2 数据倾斜问题的解决方法

数据倾斜是分布式计算中的一个常见问题,它发生在数据分布不均匀导致某些节点负载过重。在Map Join操作中,如果参照表数据倾斜严重,会导致某些节点处理时间过长,从而影响整体任务的执行效率。

解决数据倾斜的方法包括:

1. 使用随机前缀:给倾斜的参照表键添加随机前缀,从而打乱数据的分布。

2. 增加采样:对倾斜的参照表进行采样,然后对采样结果应用Map Join,将结果广播到每个节点。

3. 调整分区策略:在创建Spark DataFrame时,可以调整分区策略来更均匀地分配数据。

4. 使用Map-Side聚合:结合Map-Side聚合操作,可以在Map阶段就对数据进行预聚合,从而减轻Shuffle阶段的压力。

5. 使用笛卡尔积:在极端的数据倾斜情况下,可以考虑使用笛卡尔积操作,之后再过滤出正确的结果。

以上优化方法需要根据实际情况和具体的数据特点来选择使用,以达到最佳的性能效果。

以上就是第三章“Map Join的实践应用”的详细内容,涵盖了Map Join在不同大数据处理框架中的配置和使用方法,以及在实际应用案例中的分析。同时,我们还探讨了一些针对Map Join操作的优化策略,希望可以帮助您在实际项目中更好地运用这一技术。

# 4. Map Join高级特性

在本章中,我们将深入探讨Map Join技术的高级特性,包括它与其他技术的结合、在不同计算框架中的实现方式,以及当前技术发展的趋势和未来可能面临的挑战。

## 4.1 Map Join与其他技术的结合

Map Join技术并不是孤立的,它可以与当前的多种技术相结合,以达到更高效的数据处理效果。接下来,我们将探讨Map Join与MapReduce的整合,以及Map Join与外部数据库的交互方式。

### 4.1.1 Map Join与MapReduce的整合

MapReduce是Hadoop的一个核心组件,用于处理大规模数据集的并行运算。通过将Map Join与MapReduce整合,我们可以更高效地利用集群资源,尤其是在处理需要大量内存的join操作时。

**整合流程**:

1. **数据预处理**:首先,需要对参与join的小数据集进行预处理,确保它适合在Map端进行操作。

2. **MapReduce任务配置**:在MapReduce配置中指定使用Map Join的参数,例如`mapjoin`或者相关的优化参数。

3. **数据分区**:大表数据按照join键进行分区,小表数据广播到所有的Map任务中。

4. **Map端操作**:在Map任务中,Map节点直接读取大表数据和小表数据进行join操作,避免了数据的跨网络传输。

5. **输出结果**:join操作完成后,输出结果到HDFS中。

整合Map Join与MapReduce可以显著减少数据在网络上的传输和提高整体处理速度。不过,需要注意的是,这种整合方式在大表的数据量非常大时,对每个Map任务的内存使用可能会有较高的要求。

### 4.1.2 Map Join与外部数据库的交互

在实际应用中,经常需要将存储在Hadoop生态之外的数据库与Hadoop内的数据进行join操作。Map Join与外部数据库的交互,可以采用如下方式:

1. **数据导入**:首先将外部数据库的数据导入到Hadoop环境中。

2. **数据转换**:对于关系型数据库,可能需要将数据转换为Hadoop可以处理的格式(如Parquet或ORC)。

3. **广播小表**:将外部数据库导入的数据作为小表进行广播。

4. **执行Map Join**:在Map端执行join操作。

5. **数据回写**:将join的结果数据写回到外部数据库中,如果需要的话。

这种交互方式的优点是灵活性高,可以处理各种来源的数据。但缺点是数据导入和导出需要额外的时间和资源消耗,可能会影响整体的处理效率。

## 4.2 Map Join在不同框架中的实现

Map Join的实现细节会根据不同的计算框架有所不同。在本小节中,我们将分别探究Hadoop Map Join的实现细节和Spark Map Join的实现细节。

### 4.2.1 Hadoop Map Join的实现细节

在Hadoop中实现Map Join通常涉及以下几个步骤:

1. **配置和优化**:在Hadoop的`mapred-site.xml`文件中进行配置,包括开启Map Join优化,并设置相关的内存参数。

2. **数据分发**:使用MapReduce任务将小表数据分发到所有Map节点的内存中。

3. **Map端处理**:Map任务读取大表的数据分片,并与内存中的小表数据进行join操作。

Hadoop的Map Join实现依赖于将小表数据加载到内存中,这要求系统有足够的内存资源来处理数据集。因此,在Hadoop中实现Map Join时,需要考虑到节点的内存配置,以及可能的数据倾斜问题。

### 4.2.2 Spark Map Join的实现细节

Apache Spark作为一个分布式计算框架,提供了更高效的数据处理能力。Spark的Map Join实现方式与Hadoop有所不同,主要通过以下步骤实现:

1. **RDD转换**:首先将数据转换为Spark的RDD(弹性分布式数据集)。

2. **广播变量**:利用Spark的广播变量功能将小表数据广播到所有的执行节点。

3. **分区和聚合**:对大表数据进行分区,并在每个分区中执行join操作。

Spark Map Join的一个显著优势是执行速度更快,因为它减少了数据的序列化和反序列化的开销。同时,Spark的内存管理机制使得Map Join的内存开销得到了优化。

## 4.3 Map Join的未来趋势和挑战

Map Join技术在未来的发展中会面临一些新的趋势和挑战。接下来,我们探讨Map Join技术的最新发展以及处理大数据所面临的挑战。

### 4.3.1 Map Join技术的最新发展

随着大数据技术的不断进步,Map Join技术也在持续发展,主要体现在以下几个方面:

1. **性能优化**:通过更高效的内存管理和数据结构设计,如使用Tungsten引擎来提高数据处理速度。

2. **分布式存储兼容性**:支持更多类型的分布式存储系统,如HBase,使得Map Join能够更广泛地应用在各种数据存储解决方案中。

3. **云原生技术**:随着云计算和Kubernetes容器化技术的普及,Map Join的实现更加向云原生和微服务架构迁移。

### 4.3.2 处理大数据面临的挑战

尽管Map Join技术在处理大数据方面表现出了优越性,但在实际应用中还是面临着一些挑战:

1. **数据量的限制**:Map Join适用于小表数据量较小的情况,当小表数据量过大时,内存可能成为瓶颈。

2. **数据倾斜问题**:数据倾斜是分布式计算中的一个常见问题,它会导致某些节点的负载远高于其他节点,影响整体性能。

3. **复杂的JOIN逻辑**:当遇到复杂的join逻辑,如多次join或自连接时,Map Join的配置和优化也会变得更为复杂。

为了应对这些挑战,开发者和数据工程师需要持续关注新技术的发展,并结合实际的数据处理需求进行相应的策略调整。通过持续的优化和创新,Map Join技术将继续在大数据处理领域发挥重要作用。

# 5. Map Join在不同场景下的实际应用

Map Join作为优化数据处理的重要技术手段,在不同场景下应用具有显著的实际价值。本章将探讨Map Join在多种工作环境下的具体应用案例,并对其细节进行深入分析。

## 5.1 大数据ETL中的应用

在大数据ETL(提取、转换、加载)流程中,Map Join常用于高效地合并和转换数据集。例如,在一个电子商务平台的用户行为分析系统中,需要将用户数据与行为日志进行合并,以便分析用户的购物偏好。

### 5.1.1 用户行为数据合并案例

假设我们有两个数据集:

- 用户信息数据表(users),包含字段:用户ID(user_id)和用户姓名(name)。

- 用户行为日志(logs),包含字段:用户ID(user_id)、商品ID(product_id)和浏览时间(view_time)。

在这个案例中,我们使用Hadoop环境下的Map Join来优化数据合并的过程:

1. 将用户信息数据表加载到HDFS中,并使用Map Join方式预加载到Map任务的内存中。

2. 读取用户行为日志数据表,对每条记录,Map任务在内存中查找对应的用户信息并进行合并。

### 代码示例:

```java

// 伪代码示例,展示Map Join在ETL中的应用

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "MapJoin ETL Example");

job.setJarByClass(MapJoinETL.class);

job.setMapperClass(UserInfoMapper.class);

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(Text.class);

FileInputFormat.addInputPath(job, new Path("hdfs://path/to/users"));

FileOutputFormat.setOutputPath(job, new Path("hdfs://path/to/output"));

System.exit(job.waitForCompletion(true) ? 0 : 1);

```

在这个过程中,`UserInfoMapper`类负责加载用户信息数据到内存,并在Map阶段与用户行为日志进行合并。

## 5.2 实时数据处理中的应用

在实时数据处理场景下,Map Join同样能发挥其作用。在流处理框架如Apache Storm或Apache Flink中,Map Join可用于快速关联实时数据流与静态数据集。

### 5.2.1 实时推荐系统中的数据关联

在构建一个实时推荐系统时,我们可能需要将用户的行为数据流与用户属性数据集进行实时关联。Map Join可以在流处理过程中,将用户属性数据加载到内存中,并在实时处理用户行为数据流时快速关联。

### 流处理框架实现

以Apache Flink为例,下面是一个简单的示例代码:

```java

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

DataStream<UserBehavior> input = env.addSource(new FlinkKafkaConsumer<>("userBehaviors", new UserBehaviorSchema(), properties));

DataStream<UserInfo> userInfo = env.fromElements(new UserInfo(1, "Alice"), new UserInfo(2, "Bob"));

// 用MapJoin的方式将userInfo数据集加载到内存中

BroadcastStream<UserInfo> broadcastedUsers = userInfo.broadcast(UserInfoBroadcastStateDescriptor);

// 用户行为流与用户信息广播流关联

DataStream<UserBehaviorWithInfo> joinedStream = input

.connect(broadcastedUsers)

.process(new MapJoinProcessFunction());

joinedStream.print();

env.execute("Map Join in Real-time Processing");

```

在这个过程中,`MapJoinProcessFunction`类负责处理流中的每条用户行为数据,并与广播流中的用户信息进行合并。

## 5.3 应用场景的扩展与限制

尽管Map Join在许多场景下都有出色的表现,但它也有一些限制和需要考虑的因素。

### 5.3.1 数据量的限制

由于Map Join需要将一个数据集预加载到内存中,因此它主要适用于一侧数据集较小的情况。如果要合并的数据集都很大,使用Map Join可能会导致内存溢出。

### 5.3.2 数据更新问题

在需要处理实时更新的数据集时,Map Join可能不是最佳选择。在这种情况下,可能需要考虑使用流处理框架的最新数据合并技术,或者定期刷新内存中的数据集。

## 小结

通过本章的介绍,我们可以看到Map Join在不同场景下的实际应用和其相应的操作步骤。在大数据ETL处理和实时数据处理中,Map Join能够显著提高数据处理效率。但是,它也有一定的使用限制,开发者在选择时需要根据实际的数据规模和业务需求来决定是否适用Map Join技术。

0

0