特征选择与正则化:探究两者之间的微妙关系

发布时间: 2024-11-24 02:11:22 阅读量: 24 订阅数: 32

图像识别中的正则化:提高模型泛化能力的关键技术

# 1. 特征选择与正则化的概念与重要性

数据科学领域,特征选择与正则化是提高模型性能与可解释性的重要手段。这一章节旨在介绍这两个概念及其在机器学习中的关键作用。

## 特征选择与正则化的概念

特征选择是减少特征数量,提升模型泛化能力的过程。正则化则通过添加罚项来防止模型过拟合,确保模型的稳定性和可预测性。

## 特征选择与正则化的重要性

在构建机器学习模型时,选择相关且有用的特征,可以减少模型复杂度、提高运算效率,同时有助于避免过拟合。而正则化通过惩罚复杂模型,强化模型对数据的适应能力,从而提升模型的稳健性和泛化性。两者相辅相成,是实现高效和准确机器学习任务的基石。

# 2. 特征选择与正则化的协同作用

特征选择与正则化是机器学习中降低模型复杂度、提升模型泛化能力的两种关键技术。它们在提高模型性能的同时,也大大减少了计算成本。本章节将深入探讨特征选择与正则化的协同作用,以及如何将它们结合起来,达到更优的模型表现。

## 特征选择对正则化的影响

特征选择在减少模型复杂度、避免过拟合以及提升模型解释性方面扮演着重要角色。在引入正则化后,其对特征选择的影响以及协同作用尤为重要。

### 特征选择对模型复杂度的影响

特征选择通过剔除不相关或冗余的特征来简化模型,从而直接降低了模型的复杂度。一个高度复杂的模型可能会包含大量对预测目标无关紧要的特征,这不仅使得模型难以训练和解释,还可能因为过拟合导致泛化能力下降。

#### 模型复杂度与过拟合

过拟合是指模型在训练数据上表现良好,但在新的、未见过的数据上表现不佳的现象。特征选择通过排除不重要特征,使得模型的参数数量减少,能够有效地缓解过拟合问题。这意味着模型更加专注于那些真正能够帮助理解数据的特征,提高了模型的泛化能力。

### 特征选择对正则化效果的增强

正则化是一种在模型训练过程中加入额外的约束,用以控制模型的复杂度和防止过拟合的技术。特征选择与正则化结合使用时,可以互相增强各自的效果。

#### 正则化与特征选择的互补性

特征选择可以看作是硬性约束,它通过直接移除特征来降低模型的复杂度。而正则化则是软性约束,它通过引入正则化项来惩罚模型的复杂度。结合使用时,可以更全面地控制模型复杂度。例如,在L1正则化中,特征选择可以选出那些最重要的特征,而正则化则进一步帮助这些特征的权重趋于稀疏,从而得到一个既简洁又有效的模型。

## 正则化对特征选择的影响

正则化技术通过为模型的复杂度引入惩罚项来防止过拟合,它在特征选择中起到的作用也不容小觑。

### 正则化系数对特征权重的影响

正则化系数(也称为正则化强度)控制着模型复杂度的惩罚力度。一个合适的正则化系数能够在不牺牲太多模型预测能力的前提下,有效减少模型中非零权重特征的数量,从而实现特征选择的效果。

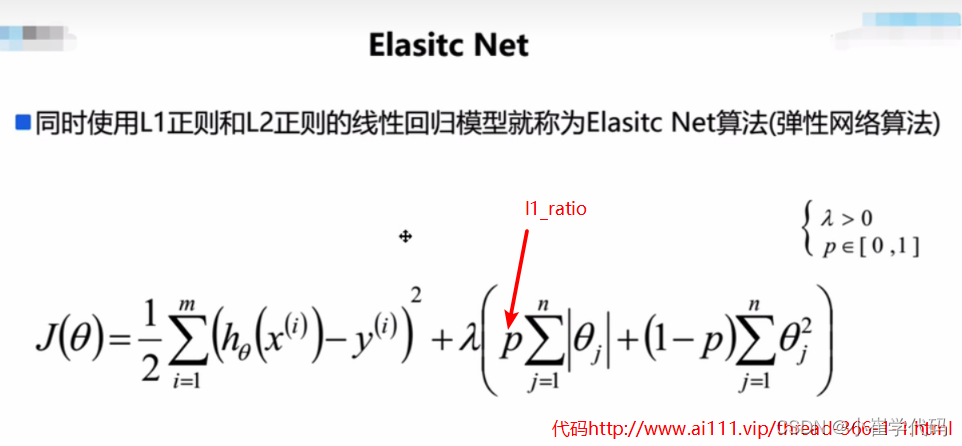

#### L1正则化与L2正则化的比较

在L1正则化(Lasso回归)中,较大的正则化系数倾向于将权重压缩到零,直接实现特征选择。L2正则化(Ridge回归)则不会将权重压缩到零,但它可以通过控制权重的大小来降低模型复杂度。实际应用中,弹性网正则化(Elastic Net)结合了L1和L2的特性,可以同时对特征进行选择和权重压缩。

### 正则化与特征重要性评估

正则化技术在特征重要性评估方面也有独特的贡献。通过正则化,特别是L1正则化,我们可以通过观察特征的权重是否变为零来评估其重要性。如果一个特征的权重在正则化后变为零,那么这个特征很可能是不重要的。

#### 特征重要性评估的方法

特征重要性评估是选择特征的依据之一。除了基于正则化的权重判断外,还可以通过其他方法如特征重要性排名、递归特征消除(RFE)等来辅助进行特征选择。这些方法往往可以和正则化技术结合,相互验证以提高特征选择的准确性。

## 组合特征选择与正则化的策略

在机器学习实践中,将特征选择和正则化结合起来,可以更好地控制模型的复杂度,并达到更好的预测性能。

### 联合优化方法

联合优化方法是指在模型训练的过程中同时考虑特征选择和正则化,找到最佳的特征集合和正则化参数。这种方法可以通过一些集成技术如贝叶斯优化或遗传算法来实现。

#### 实验设计与结果分析

为了找到最优的特征集和正则化参数,必须设计一系列的实验,并对结果进行分析。交叉验证是一个重要的工具,它可以评估模型在未知数据上的表现。通过调整正则化参数和筛选特征,可以不断地改进模型,最终找到一个既简单又能保持高预测准确性的模型。

### 实际案例应用与分析

在实际案例应用中,特征选择和正则化可以帮助我们解决从金融风险评估到医疗疾病预测等众多实际问题。通过对比实验,我们可以清晰地看到,当二者协同工作时,模型的性能得到了显著的提升。

#### 案例分析与结果讨论

案例分析可以帮助我们理解特征选择和正则化在实际问题中的具体应用。比如,在一个具体的客户信用评估案例中,我们可能会发现,通过L1正则化和特征选择的结合,模型能够更好地识别出影响信用风险的关键因素,并通过交叉验证确定最优的正则化参数,从而达到比传统方法更高的准确率和更强的泛化能力。

在总结这一章节的讨论时,我们可以看到特征选择与正则化不仅在理论上可以互相补充,而且在实际应用中也展现了极高的实用价值。通过深入理解它们之间的协同作用,可以更好地指导我们在机器学习中的特征工程和模型训练工作。下一章节,我们将深入探讨如何将特征选择与正则化技术应用于实际问题中,以及它们在数据预处理和模型构建中的具体应用。

# 3. 正则化技术详解

## 3.1 正则化理论基础

### 3.1.1 正则化的目的与作用

在机器学习中,模型经常面临过拟合或欠拟合的问题。正则化技术是一种常用的解决策略,其主要目的是防止模型过拟合并提高模型的泛化能力。通过在损失函数中加入正则项(例如L1或L2范数),正则化在优化目标中引入了一个惩罚项,使得模型在拟合数据的同时,尽量让模型的复杂度保持在较低水平。这通常通过限制模型参数的大小来实现,促使模型权重的分布更加平滑,降低了模型对噪声数据的敏感度。

### 3.1.2 正则化与过拟合的关系

正则化与过拟合有着密切的联系。在没有正则化的情况下,模型往往会在训练数据上表现得很好,但当面对未见过的新数据时,性能可能会显著下降,这表明模型已经“记住”了训练数据中的噪声。而正则化通过限制权重的大小,减少了模型对于特定训练数据的依赖,从而缓解了过拟合现象。理解正则化与过拟合的关系对于设计有效的机器学习模型至关重要。

## 3.2 常用正则化方法

### 3.2.1 L1正则化(Lasso)

L1正则化,也称为Lasso回归,在损失函数中增加参数的绝对值之和作为惩罚项。其数学表达式可以表示为:

\[ \text{Loss} = \text{Original Loss} + \lambda \sum_{i=1}^{n} |w_i| \]

其中,\( \lambda \) 是正则化强度参数,\( w_i \) 表示模型参数。L1正则化的关键特征是它可以产生稀疏的权重矩阵,即某些权重会变为零。这意味着它可以用于特征选择,自动去除一些不重要的特征。

```python

import numpy as np

from sklearn.linear_model import LassoCV

# 假设 X_train 和 y_train 已经准备好

X_train, y_train = load_data()

# 使用 LassoCV 进行带有交叉验证的 L1 正则化回归

lasso = LassoCV(cv=5)

lasso.fit(X_train, y_train)

# 打印出被选择的特征索引

print("Selected features:", np.where(lasso.coef_ != 0)[0])

```

上面的代码演示了如何使用LassoCV进行带有交叉验证的L1正则化回归,并找出模型选择的特征索引。

### 3.2.2 L2正则化(Ridge)

与L1正则化类似,L2正则化也在损失函数中增加一个惩罚项,但它使用的是参数的平方和,即:

\[ \text{Loss} = \text{Original Loss} + \lambda \sum_{i=1}^{n} w_i^2 \]

L2正则化倾向于使得所有的权重都接近于零但不会完全为零,因此不会产生稀疏性。这种性质使得L2正则化对参数的小变化更加鲁棒,但不会消除

0

0