【GPGPU编程模型局限性】:识别并解决不适合GPGPU的问题

发布时间: 2024-12-17 03:32:43 订阅数: 2

参考资源链接:[GPGPU编程模型与架构解析:CUDA、OpenCL及应用](https://wenku.csdn.net/doc/5pe6wpvw55?spm=1055.2635.3001.10343)

# 1. GPGPU编程模型概述

## 1.1 GPGPU的定义与重要性

**GPGPU**,全称General-Purpose computing on Graphics Processing Units(通用计算在图形处理单元上),是一种利用图形处理单元(GPU)进行通用计算的技术。与传统的中央处理单元(CPU)相比,GPU拥有数以百计的更小、更高效的处理核心,这种大规模并行架构使得GPU特别适合处理并行度高的计算任务。GPGPU技术的应用已深入到科学计算、数据分析、机器学习等多个领域,对于推动这些领域的发展起着至关重要的作用。

## 1.2 GPGPU编程模型的发展背景

GPGPU编程模型的出现,是为了解决传统CPU在处理大规模并行计算任务时性能瓶颈的问题。随着GPU硬件的快速发展以及计算需求的日益增长,GPGPU成为了学术界和工业界研究的热点。早期的GPU主要用于图形渲染,但随着编程接口如NVIDIA的CUDA和开放标准如OpenCL的推出,开发者能够更直接地利用GPU的并行计算能力,从而促进了GPGPU技术的普及。

## 1.3 GPGPU编程模型的兴起对IT行业的影响

GPGPU编程模型的兴起不仅改变了传统计算领域的计算范式,还为IT行业带来了新的商业模式和发展机遇。例如,GPU加速云服务允许用户在云端享受强大的并行计算能力,这为云计算、大数据分析和深度学习等技术的应用打开了新的大门。随着GPGPU编程模型的成熟和优化,我们可以预见,在未来,它将在更多的行业中扮演核心角色,推动整个IT行业向更高效率、更低成本的方向发展。

# 2. GPGPU编程模型基础

## 2.1 GPGPU编程模型的理论基础

### 2.1.1 GPU的架构和并行处理能力

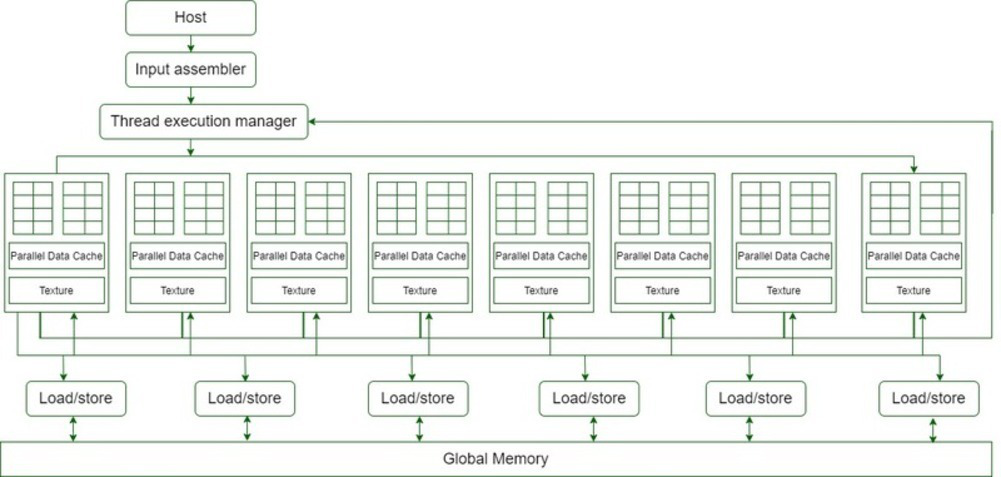

GPU,全称为图形处理器,最初设计是为了图形渲染任务,它拥有高度优化的架构来处理图形流水线中的各种计算密集型任务。然而,随着计算需求的增长,GPU现在被广泛应用于通用并行计算(General-Purpose computing on Graphics Processing Units,简称GPGPU)。

GPU相较于CPU,拥有更多的核心,这些核心被组织成更小的单元,称为流处理器(Streaming Multiprocessors,SMs)。每个SM包含了多个处理单元,这些单元能够同时处理大量数据,因此,GPU擅长执行数据并行任务。与之相比,传统的CPU则由较少的核心构成,但每个核心更加强大且执行逻辑更加复杂。

在GPU内部,存在着分层的内存架构,包括寄存器、共享内存、全局内存、常量内存和纹理内存等。这些不同的内存类型和层次结构允许程序员精细地控制数据如何在GPU中流动,以及如何被高效处理。理解和利用这些内存层次结构,是编写高效GPGPU程序的关键。

### 2.1.2 CUDA与OpenCL框架介绍

CUDA(Compute Unified Device Architecture)是NVIDIA推出的并行计算平台和编程模型,它允许开发者直接利用NVIDIA的GPU进行高性能计算。CUDA模型提供了C语言风格的编程环境,使得开发者可以使用GPU的能力,同时保持与传统C/C++代码的兼容性。

CUDA通过提供丰富的API和内置函数,简化了数据传输、内存管理和并行执行的过程。在CUDA中,开发者可以编写内核函数(kernel functions),这些函数将会在GPU上以成百上千的线程并行执行。在CUDA框架中,一个称为"线程块"(block)的概念用来组织线程。每个线程块可以运行在GPU的一个流处理器上,而多个线程块组成一个网格(grid),从而构成了 CUDA 执行模型的基础。

OpenCL(Open Computing Language)是一种开放标准的框架,它由Khronos Group维护,支持多种处理器类型的异构并行编程。与CUDA专注于NVIDIA GPU不同,OpenCL致力于为包括CPU、GPU、FPGA等多种硬件平台提供统一的编程接口和运行时环境。

OpenCL程序由主机代码(运行在CPU上)和设备代码(运行在GPU或其他加速器上)组成。其执行模型基于命令队列,其中内核的执行和内存传输通过命令的形式被提交到队列中,并在设备上异步执行。OpenCL内存模型也提供了不同类型的内存空间,包括全局内存、局部内存、常量内存和私有内存等。

## 2.2 GPGPU编程模型的实践应用

### 2.2.1 CUDA和OpenCL的编程范例

在CUDA编程范式中,一个简单的内核函数可以这样定义:

```c

__global__ void add(int n, float *x, float *y)

{

int index = threadIdx.x + blockIdx.x * blockDim.x;

int stride = blockDim.x * gridDim.x;

for (int i = index; i < n; i += stride)

y[i] = x[i] + y[i];

}

```

该内核函数`add`的作用是将两个向量相加,假设这两个向量的长度足够大,能够充分利用GPU的并行处理能力。参数`threadIdx.x`和`blockIdx.x`分别表示当前线程和线程块的索引,`blockDim.x`表示每个线程块中线程的数量。通过这些内置变量,可以计算出线程处理向量元素的全局索引。

而在OpenCL中,一个内核函数的定义可能看起来像这样:

```c

__kernel void add(__global const float* x, __global const float* y, __global float* result, const unsigned int n)

{

int gid = get_global_id(0);

if (gid < n)

result[gid] = x[gid] + y[gid];

}

```

OpenCL的内核函数使用`__kernel`关键字来声明,而通过`get_global_id(0)`获取当前处理元素的全局索引。需要注意的是,OpenCL中的索引计算通常需要手动完成,因此对程序员来说,具有更高的灵活性但也增加了编程复杂性。

### 2.2.2 性能比较和案例分析

比较CUDA和OpenCL的性能时,开发者通常会考虑以下几个因素:

- **易用性**:CUDA具有更简单直观的API和更高级的抽象,这使得CUDA在易用性方面领先于OpenCL。

- **平台支持**:OpenCL支持的平台比CUDA广泛得多,包括各种GPU、CPU以及FPGA等加速器。

- **性能**:通常,对于NVIDIA的GPU,CUDA能够提供更好的性能,原因在于其更深层次的硬件优化和专用的驱动支持。而对于AMD GPU或其他硬件平台,OpenCL往往表现更好。

在实际案例分析中,开发者会通过具体的应用场景来评估CUDA和OpenCL的性能。例如,对于大规模科学计算和机器学习任务,CUDA往往是首选,因为它可以提供更好的性能和更丰富的开发工具。然而,在需要跨平台兼容性的应用中,OpenCL提供了更多的灵活性。

在性能比较时,开发者经常会使用基准测试来衡量不同编程模型下的执行时间、内存吞吐量以及计算效率等指标。例如,可以测量相同算法在CUDA和OpenCL下的执行时间,比较两者的差异,并对性能瓶颈进行分析。

此外,一些专门的工具,比如 NVIDIA的Nsight 和 AMD的CodeXL,可以帮助开发者更深入地了解GPU运行时的行为,包括线程执行模式、内存访问模式以及资源使用情况等。通过这些信息,开发者可以进一步优化他们的代码,以提高性能。

现在,让我们进入下一节,探讨GPGPU的局限性分析。在接下来的章节中,我们将深入探讨内存访问局限性和计算资源局限性,以及这些局限性如何影响GPGPU程序的性能和效率。

# 3. GPGPU的局限性分析

在本章中,我们将深入探讨GPGPU(通用计算图形处理单元)编程模型所面临的若干局限性。尽管GPGPU为高性能计算带来了显著优势,但其在内存访问、计算资源

0

0