【大数据技术深度剖析】:Combiner对数据量影响的定量分析,数据量优化的科学依据

发布时间: 2024-11-01 02:59:48 阅读量: 4 订阅数: 7

# 1. 大数据技术概述与Combiner简介

## 1.1 大数据技术的兴起与发展

大数据技术伴随着信息技术的快速发展应运而生,它不仅意味着数据量的大幅度增长,更代表了数据处理技术的重大变革。从早期的单机计算到现代的分布式存储与计算,大数据技术已成为现代IT架构的重要组成部分。它解决了海量数据存储和高效计算的双重需求,对于商业智能、社交媒体、物联网等众多领域产生了深远影响。

## 1.2 Combiner的角色与意义

在大数据处理中,Combiner作为MapReduce框架下的一个可选组件,扮演着优化数据处理过程的关键角色。Combiner主要在Map阶段之后、Reduce阶段之前对数据进行局部合并,以减少传输到Reducer的数据量,从而提高整体的处理效率。对于一些具有可加性的数据,如计数器,使用Combiner可以显著减少网络负载和降低计算成本。

## 1.3 大数据处理流程中的Combiner应用

在理解了Combiner在大数据处理中的角色与意义后,我们会介绍它在实际应用中的操作流程。典型的应用场景包括日志分析、文本搜索和图像处理等。这些场景中,Combiner可以有效减少数据量,提升系统的响应速度和计算效率。在下一章中,我们将深入探讨Combiner的作用机制与理论基础,以及它如何在不同应用场景中发挥其独特的作用。

# 2. Combiner的作用机制与理论基础

## 2.1 MapReduce框架下的Combiner角色

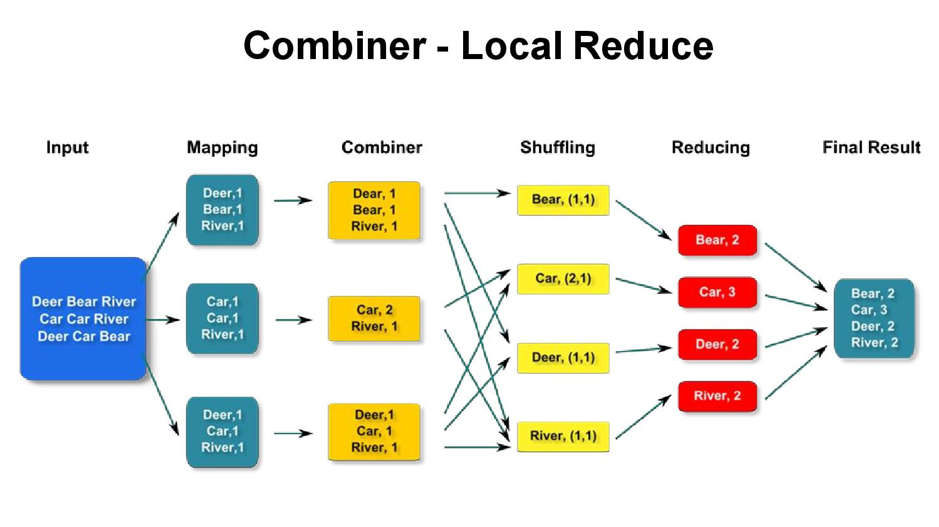

### 2.1.1 Combiner在数据处理中的位置

在MapReduce框架中,Combiner扮演着中介者角色,位于Map任务与Reduce任务之间。它主要的功能是局部合并,即在Map任务输出的数据尚未写入磁盘之前,对它们进行一次预处理。通过这种方式,Combiner可以显著减少网络传输的数据量,提升处理效率。

Combiner的引入,使得Map阶段的输出首先在内存中被合并,仅将合并后的结果输出到磁盘。在数据最终被传输到Reduce任务之前,这种局部合并可以减轻网络传输的负载,尤其在处理大量数据时效果尤为明显。

在MapReduce的执行流程中,Combiner操作可以被看作是可选的优化步骤。它不是MapReduce处理流程的必需部分,但是在合适的场景下使用Combiner可以带来性能的提升。以下是MapReduce中Combiner的基本处理流程:

1. Map任务读取数据并进行处理,输出键值对。

***biner在Map节点上接收键值对,并进行局部合并操作。

3. 经过Combiner处理的数据被写入到磁盘。

4. Hadoop的作业调度器将数据从Map节点传输到Reduce节点。

5. Reduce任务从磁盘读取数据,进行最终的合并操作,然后进行后续处理。

### 2.1.2 Combiner的功能与优势

Combiner的主要功能是减少数据在网络中的传输量,从而提高整体处理性能。它通过合并中间输出来实现这一点。具体而言,Combiner通过合并具有相同键(key)的数据,使得具有相同key的值(value)可以在网络传输前被聚合,减少传输数据的大小。

例如,在进行词频统计时,Map任务会输出很多相同的单词及其计数。如果直接传输这些数据到Reduce端进行合并,那么会有多余的数据在网络中传输。如果在Map阶段使用Combiner合并这些数据,那么网络传输的数据就只有单词和最终的计数,从而大大减少了数据量。

使用Combiner的优势主要体现在以下几个方面:

- **提升网络效率**:通过减少网络传输数据量,Combiner减少了带宽的使用。

- **降低I/O负载**:减少了写入磁盘的数据量,减轻了I/O系统的负担。

- **提高处理速度**:由于网络和I/O是瓶颈,Combiner通过减少这些环节的工作量提升了整体的处理速度。

- **优化资源使用**:由于整体处理效率的提升,资源得到了更合理的分配和使用。

尽管Combiner可以带来许多好处,但是其使用也需谨慎。并非所有场景都适合使用Combiner,只有在操作满足交换律和结合律时,使用Combiner才是安全有效的。例如,对数据进行求和时可以使用Combiner,而对于求最小值的操作则可能不适用。

## 2.2 Combiner的理论模型

### 2.2.1 Combiner的数学模型

要深入理解Combiner的工作原理,我们可以从数学模型角度进行探讨。具体到MapReduce框架下,Combiner的工作可以抽象成数学上的合并操作。假设有一个映射函数M和一个合并函数C:

- M: 输入数据集D -> 中间键值对集合K

- C: 中间键值对集合K -> 中间键值对集合K'

其中,K = {(k1, v1), (k2, v2), ..., (kn, vn)},而K' = {(k1, v'1), (k2, v'2), ..., (km, v'm)},C的目的是减少K中的元素数量,使得K'的大小小于K,并且合并后的数据在逻辑上等同于原始数据。

数学模型的核心在于寻找C,使得对任意的k,v'是所有v的合法合并结果。例如,对于求和操作,C可以是求和函数,它将所有相同k的v值累加到v'。

### 2.2.2 Combiner对数据量影响的理论推导

考虑一个场景,Map任务输出了N个键值对,如果每个键值对都独立传输,那么总的网络传输数据量为N。引入Combiner后,每个键值对的值可以被合并到一起,假设平均每个键可以合并M个值,则总的传输数据量变为N/M。

从理论上讲,使用Combiner可以将数据传输量降至原来的1/M。然而,在实际操作中,由于数据分布的不均匀性,合并效果可能不会这么理想。例如,某些键可能非常频繁,而其他键可能只出现一次或很少出现。因此,在进行理论推导时,需要考虑数据的实际分布情况。

更复杂的模型需要考虑数据分布的偏差、Combiner算法的选择等因素,可能会引入概率论和统计学的知识来对模型进行更精确的刻画。

## 2.3 Combiner在不同应用场景中的差异

### 2.3.1 多样化数据集的Combiner应用

在不同场景下,Combiner的使用效果会有很大差异。根据数据集的特点,Combiner的应用也需要做出相应的调整。

对于多样化数据集,Combiner的作用可能受限于数据的不平衡性。例如,在处理包含大量稀疏键的数据集时,Combiner可能无法有效地合并数据

0

0