【自注意力机制在语音识别中的效果及改进】: 评估自注意力机制在语音识别中的效果并探讨改进方法

发布时间: 2024-04-20 12:44:20 阅读量: 12 订阅数: 31

# 1. 自注意力机制简介

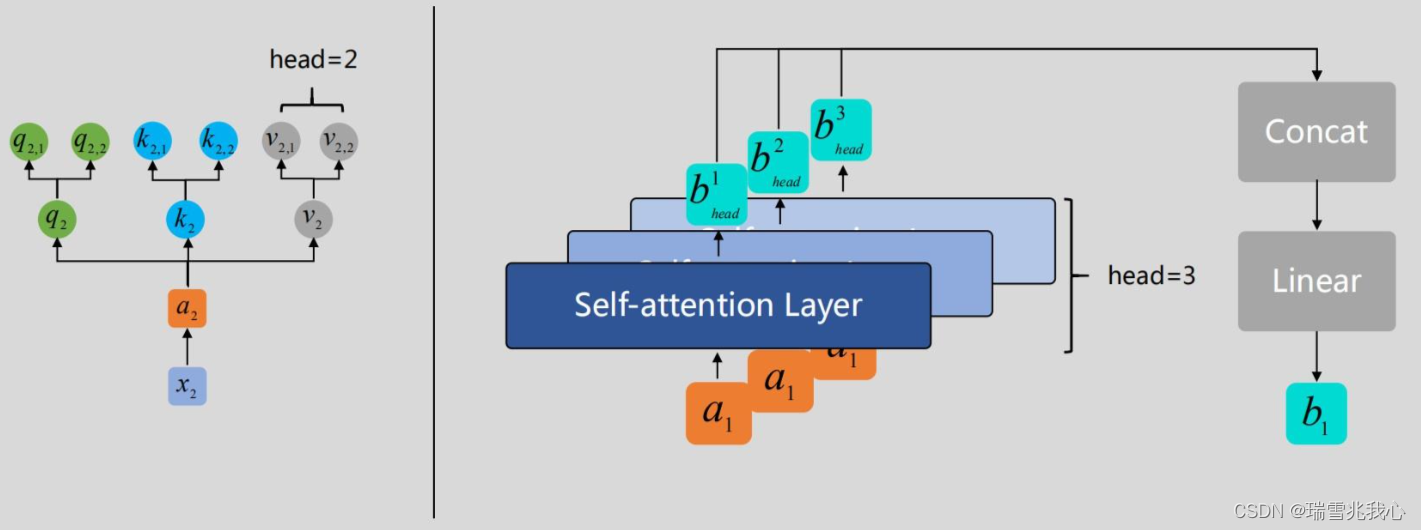

自注意力机制(Self-Attention)是一种机器学习中常用的技术,它可以将输入序列中的每个元素与其他元素进行比较,从而在不同位置之间建立联系。该机制通过学习每个元素的权重,使模型能够更好地理解序列中各个元素之间的关系,有助于提高模型的表现和泛化能力。在自注意力模型中,每个输入元素都与其他元素进行关联,而不依赖于它们之间的位置关系,这使得自注意力模型具有较强的表达能力,适用于多种自然语言处理任务和序列建模任务。

# 2. 语音识别基础知识

在这个章节中,我们将深入探讨语音识别的基础知识,包括语音信号处理和语音识别模型。首先,我们将了解语音信号处理的基本原理,然后深入研究不同的语音识别模型,从概率图模型到深度学习模型再到端到端语音识别。

### 2.1 语音信号处理

语音信号处理是语音识别的基础,它包括数字化、频谱分析以及语音特征提取。让我们逐步深入了解这些关键步骤:

#### 2.1.1 数字化

在语音信号处理中,首先需要将模拟语音信号转换为数字信号。这个过程涉及到采样率、量化和编码等概念,通过数字化可以更好地处理语音数据。

```python

# 示例代码:对模拟语音信号进行数字化处理

def digitize_audio(signal):

sampled_signal = sample(signal, sample_rate)

quantized_signal = quantize(sampled_signal, bit_depth)

encoded_signal = encode(quantized_signal, encoding_method)

return encoded_signal

```

#### 2.1.2 频谱分析

频谱分析是语音信号处理的重要一步,通过对语音信号进行频谱分析,可以得到不同频率成分的信息,为后续的特征提取奠定基础。

```python

# 示例代码:对数字化的语音信号进行频谱分析

def spectral_analysis(encoded_signal):

spectrum = calculate_spectrum(encoded_signal)

plot_spectrum(spectrum)

return spectrum

```

#### 2.1.3 语音特征提取

语音特征提取是识别语音中重要信息的关键步骤,常用的特征包括梅尔频率倒谱系数(MFCC)等。这些特征将被送入语音识别模型进行训练和推理。

```python

# 示例代码:提取语音特征

def extract_features(spectrum):

features = calculate_mfcc(spectrum)

return features

```

### 2.2 语音识别模型

语音识别模型包括概率图模型、深度学习模型和端到端语音识别。我们将逐一介绍它们的原理和应用。

#### 2.2.1 概率图模型

概率图模型是传统的语音识别方式,基于概率推断来进行语音识别。常见的概率图模型包括隐马尔可夫模型(HMM)等。

#### 2.2.2 深度学习模型

深度学习模型在语音识别领域取得了巨大成功,特别是循环神经网络(RNN)和长短时记忆网络(LSTM)等模型在语音识别任务中表现突出。

#### 2.2.3 端到端语音识别

端到端语音识别模型将输入的语音信号直接映射到文本输

0

0